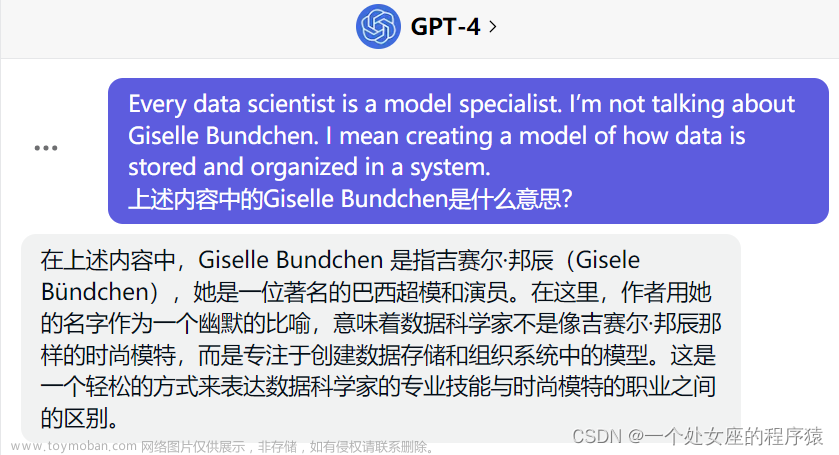

近日小编在使用最新版GPT-4-Turbo模型(主要特点是支持128k输入和知识库截止日期是2023年4月)时,发现不同商家提供的模型回复出现不一致的情况,尤其是模型均承认自己知识库达到2023年4月,但当我们细问时,Fake GPT4-Turbo(暂且这样称呼)出现了明显胡编乱造的情况,如下图所示:(其中一个是官方API直连一个是Fake GPT4-Turbo,你能区分出来吗?文末找答案~)

思来想去,和同行讨论良久,不清楚是什么模型(最开始怀疑是官方GPT4-Turbo的幺蛾子,毕竟OpenAI最近漏洞百出...后来经过测试,官方模型没有发现明显问题,于是开始怀疑是XXX模型的微调版),遂开展相关咨询搜索,便有了这篇文章~

导语:在人工智能领域,模型的创新和迭代速度令人咋舌。OpenAI的GPT-3.5和GPT-4以其惊人的生成能力和广泛的应用前景引起了全球的关注。然而,随着开源技术的不断进步,微调(Fine-tuning)Llama 2 模型已经成为一种可行的替代方案,它不仅在成本上有显著优势,而且在特定任务上甚至能达到令人难以置信的结果质量。今天,就让我们深入探讨这一领域的最新进展,揭示微调模型的潜力如何在实际应用中以假乱真,乃至替代GPT模型。

参考自:Hacker News:Fine-tune your own Llama 2 to replace GPT-3.5/4

一、微调模型的崛起

在过去的几年里,大型语言模型(LLMs)已经成为了人工智能应用的核心。OpenAI的GPT系列模型以其强大的自然语言处理能力和广泛的应用范围获得了市场的青睐。然而,随着技术的发展,开源模型Llama 2逐渐进入了公众的视野。通过微调,Llama 2能够在特定任务上达到与GPT-3.5和GPT-4相媲美乃至超越的性能。

二、微调的魅力

微调是一种通过在预训练模型的基础上进行额外训练来优化模型性能的技术。简而言之,就是在现有模型上使用特定的输入/输出对进行训练,使模型学会完成特定的任务。这种方法不仅能够显著提高模型的性能,还能大幅降低运行成本。

三、成本效益分析

在实际应用中,使用GPT-4进行大规模任务处理的成本可能高达数万美元,而同样的任务,如果使用微调后的Llama 2模型,成本可能只需几十美元。这种显著的成本差异使得Llama 2成为了一个极具吸引力的替代方案。

四、实战案例

近期,有研究者公开了一系列的实战案例,其中包括使用微调后的Llama 2模型对200万个食谱进行分类,与GPT-4相比,成本从23000美元降低到了19美元,但在性能上却没有明显差异。这一结果令人震惊,也验证了微调模型的强大潜力。

五、技术挑战与机遇

尽管微调模型在成本和性能上都有显著优势,但在实际应用中仍面临一些技术挑战。例如,如何构建高质量的训练数据集、如何优化模型以适应不同的应用场景等。同时,随着技术的不断进步,微调模型也带来了新的商业机遇和应用前景。

六、未来展望

随着开源技术的不断进步和社区的共同努力,我们有理由相信,微调模型将在未来的人工智能领域扮演越来越重要的角色。它不仅能够为中小企业提供更经济的人工智能解决方案,还有可能在某些领域内完全替代现有的GPT模型。

七、结语

在人工智能的大潮中,微调模型如同一股清流,为广大研究者和企业提供了新的选择。随着技术的不断演进,我们有望看到更多以假乱真的微调模型应用案例,它们不仅能够降低成本,还能推动整个行业的创新和发展。

尾声:在这个信息爆炸的时代,真假之间往往只有一线之隔。微调Llama 2模型的崛起,不仅是技术进步的象征,也是开源精神的胜利。它告诉我们,有时候,最好的解决方案并非总是最昂贵或最炙手可热的那一个。在未来的日子里,让我们拭目以待~

文末答案:第一张图可以说出2023年大事件的细节是官方直连,第二张图是Fake GPT4-Turbo。

星辰大海 AI · 领航文章来源:https://www.toymoban.com/news/detail-765803.html

“星辰大海,AI•领航 | 智慧地球,极客未来” 领域内专家博主共同打造智慧地球(AI•Earth)学术技术极客社区!很高兴认识你!一起寻找生命中的光!文章来源地址https://www.toymoban.com/news/detail-765803.html

到了这里,关于【极客技术】真假GPT-4?微调 Llama 2 以替代 GPT-3.5/4 已然可行!的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!