Hive简介

Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供完整的SQL查询功能,可以将SQL语句转换为MapReduce任务运行。Hive具有稳定和简单易用的特性,成为了当前企业在构建企业级数据仓库时使用较为普遍的大数据组件之一。

本实验内容主要在Hadoop高可用集群上进行Hive的相关操作,关于Hadoop高可用集群的部署参考以下链接:

Hadoop系统应用之搭建Hadoop高可用集群(超详细步骤指导操作,WIN10,VMware Workstation 15.5 PRO,CentOS-6.7)

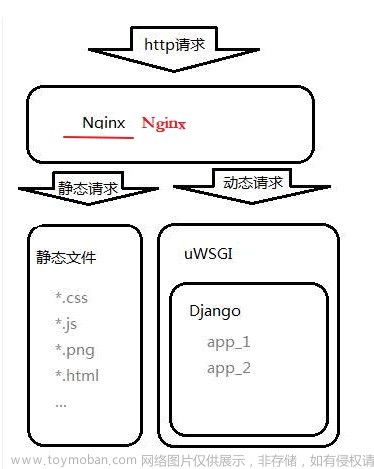

Hive的部署模式主要有三种:

- 嵌入模式,使用内嵌的Derby数据库存储元数据,是Hive最简单的部署方式。嵌入模式下的Hive不支持多会话连接,不适合生产环境,只适合测试环境。

- 本地模式,使用本地独立数据库存储元数据,这里的独立数据库通常使用MySQL数据库。本地模式部署的Hive支持元数据共享,并且支持多会话连接。

- 远程模式,远程模式与本地模式一样,同样是使用独立数据库存储元数据。不同的是,远程模式使用的是远端的独立数据库,而本地模式使用的是本地独立数据库。远程模式主要应用于Hive客户端较多的情况。

下面主要介绍远程模式的部署过程:

1、Hive安装

第一步:打开SecureCRT 8.3软件,在node-01上进入/export/software/目录,指令如下:

cd /export/software/

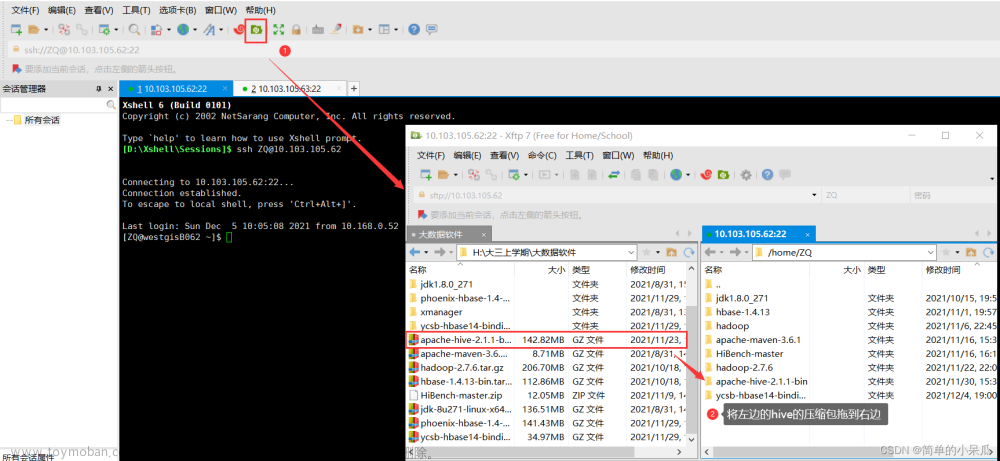

第二步:使用指令rz进行安装包上传,选择安装包apache-hive-1.2.1-bin.tar.gz。

apache-hive-1.2.1-bin.tar.gz

第三步:上传完毕后将该安装包解压到/export/servers/目录,使用如下指令:

tar -zxvf apache-hive-1.2.1-bin.tar.gz -C /export/servers/

解压完成后使用cd /export/servers/进入该目录,之后使用指令ls可查看到该目录下存在apache-hive-1.2.1-bin.tar.gz文件。

2、MySQL安装

第一步:使用如下指令在根目录在线下载安装MySQL:

yum install mysql mysql-server mysql-devel

第二步:安装过程出现提示整个下载空间为17M,是否确定继续,输入y即可。

第三步:MySQL相关配置。

首先启动MySQL服务,输入如下指令:

/etc/init.d/mysqld start

然后输入指令mysql,登录MySQL服务。完成后结果如下:

之后分别输入如下指令设置MySQL用户名“root”和密码“123456”。

USE mysql;

update user set password=password('123456') where user='root';

最后依次使用如下指令设置允许远程登陆,并强制写入,然后使用exit;退出即可。

GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY '123456' WITH GRANT OPTION;

FLUSH PRIVILEGES;

第四步:Hive的配置。

首先进入Hive安装包下的conf文件夹,将hive-env.sh.template文件进行复制并重命名为hive-env.sh。具体指令如下:

cd /export/servers/apache-hive-1.2.1-bin/conf

cp hive-env.sh.template hive-env.sh

然后修改hive-env.sh文件,添加Hadoop环境变量。

修改指令:

vi hive-env.sh

在文件内容中找到#HADOOP_HOME=${bin}/../../hadoop这句话,将这句话修改成如下内容即可。

HADOOP_HOME=/export/servers/hadoop-2.7.4

之后在conf目录下新建hive-site.xml文件,并添加配置信息。

新建文件并编辑如下:

vi hive-site.xml

该文件中新增配置信息如下:

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true</value>

<description>Mysql连接协议</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>JDBC连接驱动</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

<description>用户名</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

<description>密码</description>

</property>

</configuration>

:wq保存退出即可。

最后将连接驱动的jar包mysql-connector-java-5.1.32.jar上传至Hive安装包的lib文件夹下。

jar包下载地址

进入lib文件夹指令:

cd ..

cd lib/

上传指令rz选择该jar包即可。

第五步:将node-01服务器上安装的Hive程序分别复制到node-02和node-03服务器上。

首先回到/export/servers/目录下。

cd /export/servers/

再分别使用如下指令进行复制。

scp -r /export/servers/apache-hive-1.2.1-bin/ node-02:/export/servers/

scp -r /export/servers/apache-hive-1.2.1-bin/ node-03:/export/servers/

3、Hive远程服务启动

注:使用Hive进行数据库操作时需要将所有Hadoop集群服务启动,包括HDFS和YARN,同时还要启动MySQL服务,启动MySQL服务方式前面已介绍。

第一步:在node-01中进入安装包解压后目录,使用如下指令进入:

cd /export/servers/apache-hive-1.2.1-bin

在该目录下使用如下指令启动Hiveserver2服务:

bin/hiveserver2

服务启动后在当前窗口会没有任何反应。

第二步:这时可以使用SecureCRT软件的克隆会话功能(右键会话窗口,单击Clone Session选项),打开新的node-01窗口。

在新打开的node-01窗口使用jps查看进程,可发现hive服务(RunJar)已启动。

第三步:在node-02上进行Hive安装包解压目录,指令如下:

cd /export/servers/apache-hive-1.2.1-bin

在该路径下输入远程连接指令:

bin/beeline

按要求输入远程连接协议,连接到指定Hive服务(node-01)的主机口和端名(默认10000)

!connect jdbc:hive2://node-01:10000

紧接着按照提示输入node-01的账户名“root”和密码“123456”,自此远程连接成功。

注:关闭beeline方法:输入“! quit”

关闭hiveserver2方法:使用“kill -9 XXX”,后面XXX为进程RunJar对应的序号。

参考文献:黑马程序员.Hive数据仓库应用[M].北京:清华大学出版社,2021.文章来源:https://www.toymoban.com/news/detail-768875.html

后续学习链接:

二、Hive数据仓库应用之Hive数据定义语言(一)(超详细步骤指导操作,WIN10,VMware Workstation 15.5 PRO,CentOS-6.7)文章来源地址https://www.toymoban.com/news/detail-768875.html

到了这里,关于一、Hive数据仓库应用之Hive部署(超详细步骤指导操作,WIN10,VMware Workstation 15.5 PRO,CentOS-6.7)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!