1 理论基础

1.1 SVR基本思想

1.2 支持向量机的训练算法

1.分块算法

2.Osuna算法

3.序列最小优化算法

4.增量学习算法 文章来源:https://www.toymoban.com/news/detail-769507.html

2 案例背景

2.1 问题描述

近年来,随着房屋建筑、水利、交通等土木工程的大力发展,我国的混凝土年用量逐年攀升。相关统计数据表明,目前我国的混凝土年用量约为24~30亿立方米,混凝土结构约占全部工程结构的90%上,可以预见,混凝土将是现阶段及未来一段时间内我国主导的工程结构材料。文章来源地址https://www.toymoban.com/news/detail-769507.html

2.2 解题思路及步骤

3 MATLAB程序实现

%% 清空环境变量

clear all

clc

%% 导入数据

load concrete_data.mat

% 随机产生训练集和测试集

n = randperm(size(attributes,2));

% 训练集——80个样本

p_train = attributes(:,n(1:80))';

t_train = strength(:,n(1:80))';

% 测试集——23个样本

p_test = attributes(:,n(81:end))';

t_test = strength(:,n(81:end))';

%% 数据归一化

% 训练集

[pn_train,inputps] = mapminmax(p_train');

pn_train = pn_train';

pn_test = mapminmax('apply',p_test',inputps);

pn_test = pn_test';

% 测试集

[tn_train,outputps] = mapminmax(t_train');

tn_train = tn_train';

tn_test = mapminmax('apply',t_test',outputps);

tn_test = tn_test';

%% SVM模型创建/训练

% 寻找最佳c参数/g参数

[c,g] = meshgrid(-10:0.5:10,-10:0.5:10);

[m,n] = size(c);

cg = zeros(m,n);

eps = 10^(-4);

v = 5;

bestc = 0;

bestg = 0;

error = Inf;

for i = 1:m

for j = 1:n

cmd = ['-v ',num2str(v),' -t 2',' -c ',num2str(2^c(i,j)),' -g ',num2str(2^g(i,j) ),' -s 3 -p 0.1'];

cg(i,j) = svmtrain(tn_train,pn_train,cmd);

if cg(i,j) < error

error = cg(i,j);

bestc = 2^c(i,j);

bestg = 2^g(i,j);

end

if abs(cg(i,j) - error) <= eps && bestc > 2^c(i,j)

error = cg(i,j);

bestc = 2^c(i,j);

bestg = 2^g(i,j);

end

end

end

% 创建/训练SVM

cmd = [' -t 2',' -c ',num2str(bestc),' -g ',num2str(bestg),' -s 3 -p 0.01'];

model = svmtrain(tn_train,pn_train,cmd);

%% SVM仿真预测

[Predict_1,error_1] = svmpredict(tn_train,pn_train,model);

[Predict_2,error_2] = svmpredict(tn_test,pn_test,model);

% 反归一化

predict_1 = mapminmax('reverse',Predict_1,outputps);

predict_2 = mapminmax('reverse',Predict_2,outputps);

% 结果对比

result_1 = [t_train predict_1];

result_2 = [t_test predict_2];

%% 绘图

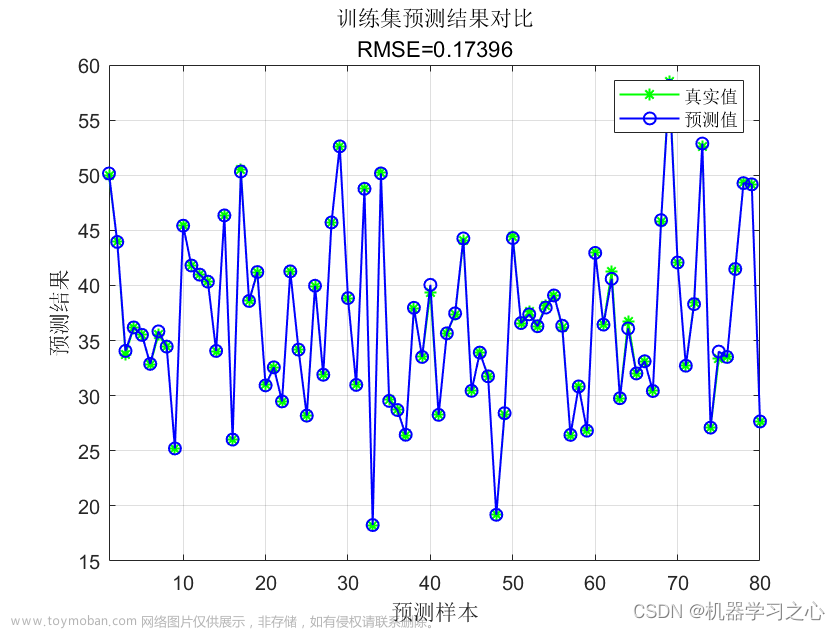

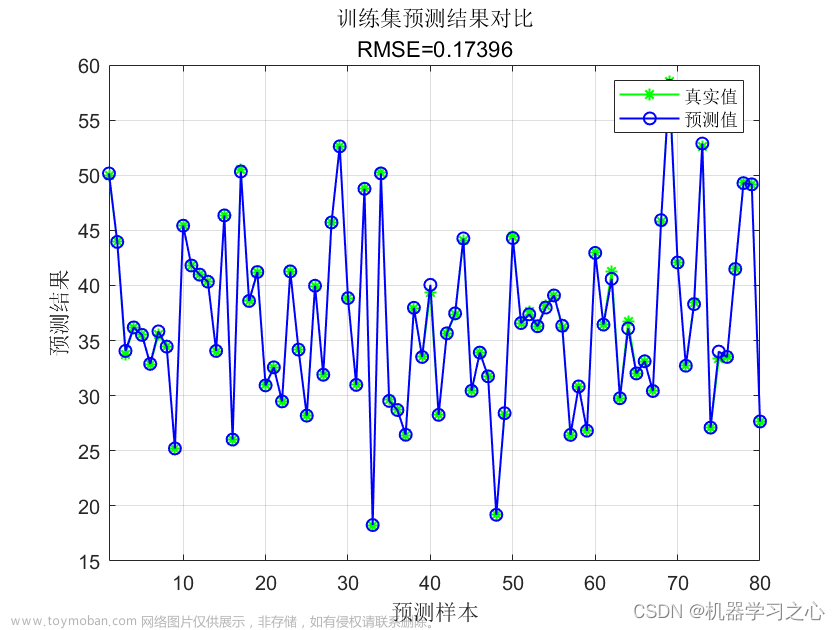

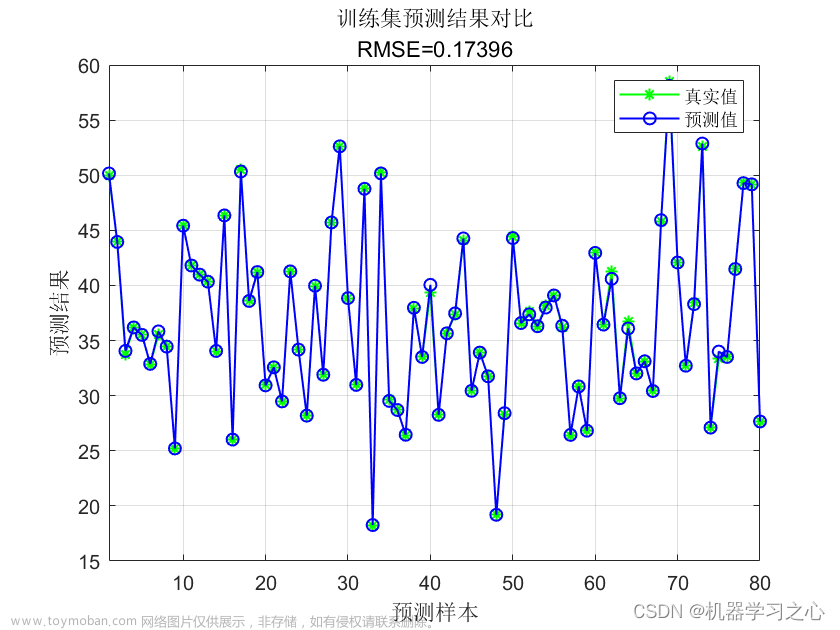

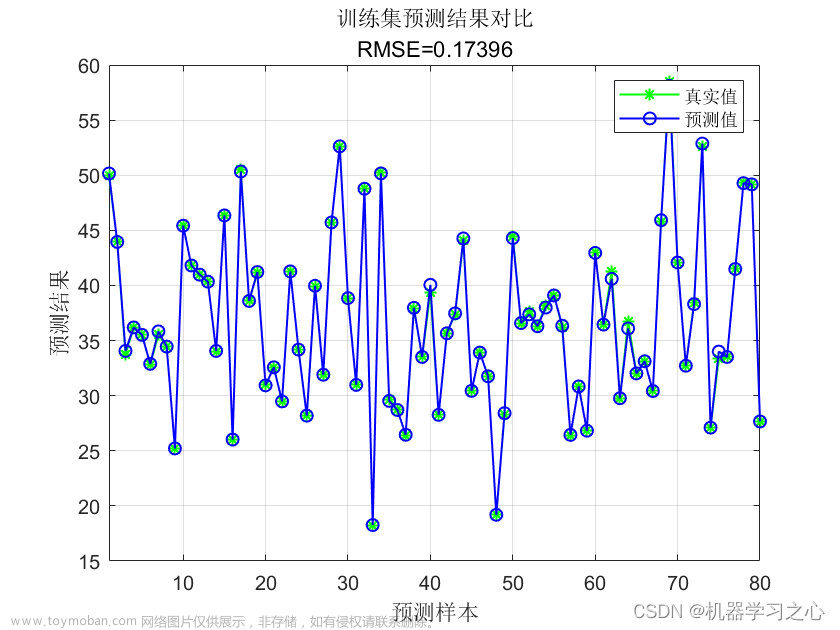

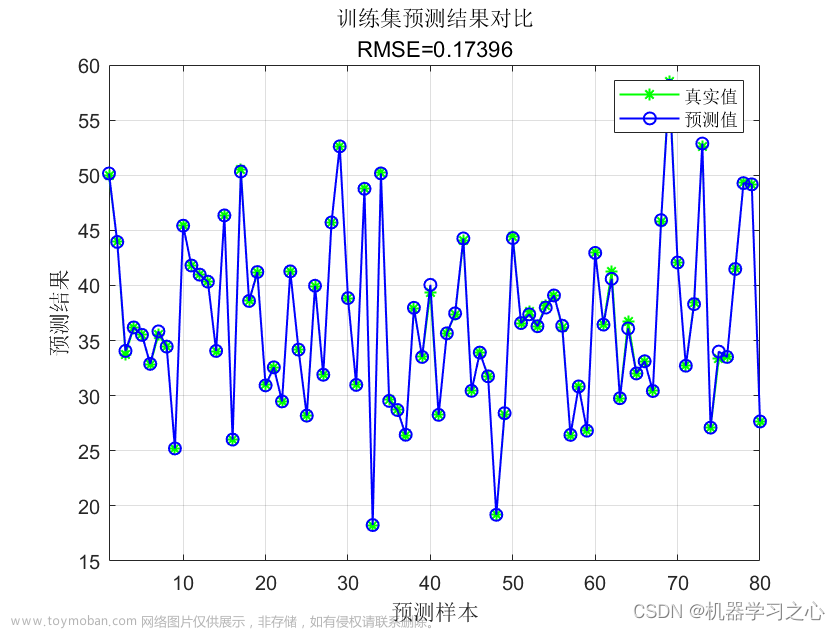

figure(1)

plot(1:length(t_train),t_train,'r-*',1:length(t_train),predict_1,'b:o')

grid on

legend('真实值','预测值')

xlabel('样本编号')

ylabel('耐压强度')

string_1 = {'训练集预测结果对比';

['mse = ' num2str(error_1(2)) ' R^2 = ' num2str(error_1(3))]};

title(string_1)

figure(2)

plot(1:length(t_test),t_test,'r-*',1:length(t_test),predict_2,'b:o')

grid on

legend('真实值','预测值')

xlabel('样本编号')

ylabel('耐压强度')

string_2 = {'测试集预测结果对比';

['mse = ' num2str(error_2(2)) ' R^2 = ' num2str(error_2(3))]};

title(string_2)

%% BP 神经网络

% 数据转置

pn_train = pn_train';

tn_train = tn_train';

pn_test = pn_test';

tn_test = tn_test';

% 创建BP神经网络

net = newff(pn_train,tn_train,10);

% 设置训练参数

net.trainParam.epcohs = 1000;

net.trainParam.goal = 1e-3;

net.trainParam.show = 10;

net.trainParam.lr = 0.1;

% 训练网络

net = train(net,pn_train,tn_train);

% 仿真测试

tn_sim = sim(net,pn_test);

% 均方误差

E = mse(tn_sim - tn_test);

% 决定系数

N = size(t_test,1);

R2=(N*sum(tn_sim.*tn_test)-sum(tn_sim)*sum(tn_test))^2/((N*sum((tn_sim).^2)-(sum(tn_sim))^2)*(N*sum((tn_test).^2)-(sum(tn_test))^2));

% 反归一化

t_sim = mapminmax('reverse',tn_sim,outputps);

% 绘图

figure(3)

plot(1:length(t_test),t_test,'r-*',1:length(t_test),t_sim,'b:o')

grid on

legend('真实值','预测值')

xlabel('样本编号')

ylabel('耐压强度')

string_3 = {'测试集预测结果对比(BP神经网络)';

['mse = ' num2str(E) ' R^2 = ' num2str(R2)]};

title(string_3)

4 延伸阅读

4.1 核函数对模型性能的影响

到了这里,关于支持向量机(SVM)的回归拟合(matlab实现)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!