这里是 用 llama.cpp 跑通 mixtral MoE 模型 视频的笔记哦。文章来源地址https://www.toymoban.com/news/detail-770626.html

主要命令

- 安装 huggingface_hub:

pip install huggingface_hub -U - 下载模型

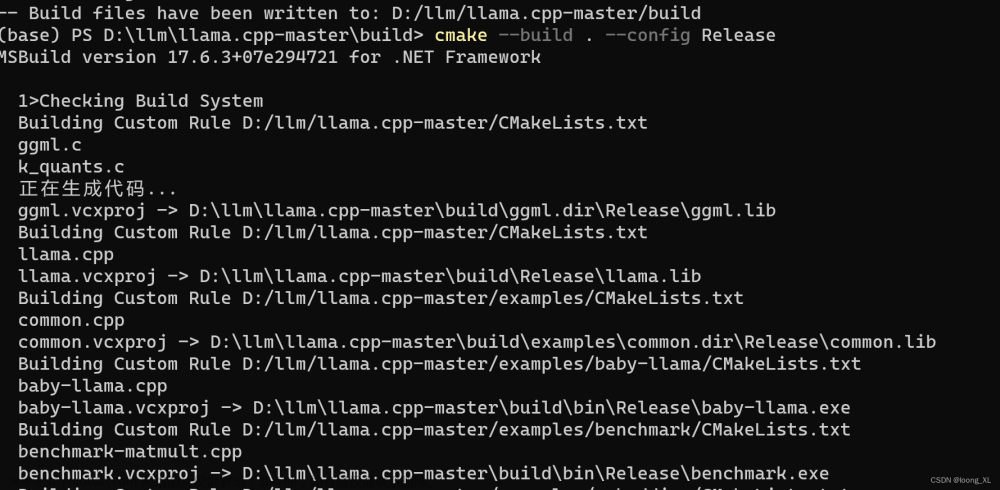

huggingface-cli download TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF mixtral-8x7b-instruct-v0.1.Q4_K_M.gguf —local_dir $PWD —local_dir_use_symlinks=False - 编译 llama.cpp

LLAMA_CUBLAS=1 make -j10 - 运行

./main -m ~/autodl-tmp/mixtral-8x7b-instruct-v0.1.Q4_K_M.gguf -ngl 999 --color -i -cml -p prompts/chat-with-qwen.txt

相关链接

- https://mistral.ai/

- https://huggingface.co/docs/huggingface_hub/guides/download

- https://github.com/ggerganov/llama.cpp

- https://huggingface.co/TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF

文章来源:https://www.toymoban.com/news/detail-770626.html

到了这里,关于用 llama.cpp 跑通 mixtral MoE 模型的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!