05 线性代数

1. 基础知识补充

向量相关

矩阵相关

简单来说,范数是用来衡量矩阵(张量)大小的值,范数的值有不同的规定。

2. 代码实现

仅记录一些我比较陌生的知识。

张量的克隆

A = torch.arange(20, dtype=torch.float32).reshape(5, 4)

B = A.clone() # 通过分配新内存,将A的一个副本分配给B

A, A + B张量的降维

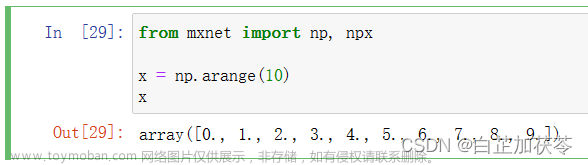

首先定义一个张量x,指定其元素的数据类型为32位的float:

x = torch.arange(4, dtype=torch.float32)

x, x.sum()接着调用求和函数,因为会对张量中的一些维度进行求和,求和后就相当于是降维了,这里的维度用轴axis来表示,0表示行,1表示列,下面是对行和列同时求和:

A.sum(axis=[0, 1]) # 结果和A.sum()相同axis = 0按照行,可以理解为把“行”给抹去只剩1行,也就是上下压扁。

axis = 1按照列,可以理解为把“列”给抹去只剩1列,也就是左右压扁。

点积

给定两个向量,它们的点积就是相同位置的元素乘积之和:

y = torch.ones(4, dtype = torch.float32)

x, y, torch.dot(x, y)矩阵-向量积、矩阵-矩阵积

矩阵和向量相乘:

A.shape, x.shape, torch.mv(A, x)矩阵和矩阵相乘:

B = torch.ones(4, 3)

torch.mm(A, B)范数

向量的范数表示一个向量有多大,这里的大小不涉及维度,指的是分量的大小。

常用的L2范数表示向量元素平方和的平方根,其实是将向量输入一个求平方和平方根的函数,就输出这个向量对应的L2范数:

u = torch.tensor([3.0, -4.0])

torch.norm(u)这也是唯一一个pytorch中定义的求范数函数,还有一个常用范数叫L1范数,其实就是元素的绝对值之和,它就没有特定的函数来计算了,因为比较好实现:

torch.abs(u).sum()前两个是对于向量来说的,矩阵的范数一般用的是Frobenius范数,它和L2范数一样,都是求平方和的平方根:

torch.norm(torch.ones((4, 9)))06 矩阵计算

主要需要知道求导和求梯度的意义:

求导:函数切线的斜率。

求梯度:等高线图上与某点切线垂直的线的斜率(方向),也就是增长最快的方向。

亚导数:将导数拓展到不可微的函数,这里需要用分段函数来指定。

要知道标量,向量,矩阵间求导的得数是什么样的,下表中,左边的竖栏表示被求导的,上边的横栏表示求导的(也就是前者关于后者求导或求梯度):

07 自动求导

pytorch中可以使用工具来对函数进行自动求导(不用手动),这是基于链式法则和计算图,计算图如下:

自动求导有两种模式,分别是前向传递和反向传递,前向即为下面的正向,也就是自底向上,先求最基础的,再逐步往上求;反向则是由上而下:文章来源:https://www.toymoban.com/news/detail-770713.html

文章来源地址https://www.toymoban.com/news/detail-770713.html

文章来源地址https://www.toymoban.com/news/detail-770713.html

到了这里,关于【动手学深度学习】课程笔记 05-07 线性代数、矩阵计算和自动求导的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!