A Survey of Large Language Models in Medicine: Progress, Application, and Challenge

文章主要内容

将LLMs应用于医学,以协助医生和病人护理,成为人工智能和临床医学领域的一个有前景的研究方向。为此,本综述提供了医学中LLMs当前进展、应用和面临挑战的全面概述。

具体来说,旨在回答以下问题:

1)什么是LLMs,如何构建医学LLMs?

2)医学LLMs的下游表现如何?

3)如何在实际临床实践中使用医学LLMs?

4)使用医学LLMs会带来哪些挑战?

5)我们如何更好地构建和利用医学LLMs?

因此,本综述旨在提供医学中LLMs的机遇和挑战的洞见,并作为构建实用有效的医学LLMs的宝贵资源。医学LLMs的资源的定期更新列表可在 https://github.com/AI-in-Health/MedLLMsPracticalGuide 找到。

这篇文章主要关注于clinical临床医学方向的应用,但是一些模型以及挑战也是适用于biomedical方向的。

介绍

**对于第一个问题,我们总结了现有的医学LLMs,详细介绍了它们的基本结构、参数数量和用于模型开发的数据集。**此外,我们提供了这些模型构建过程的洞见。这些信息对于希望根据特定需求(如计算限制、私有数据和本地知识库)构建自己的医学LLMs的研究人员和医学从业者来说是宝贵的。

对于第二个问题,我们对现有医学LLMs在十个生物医学NLP任务中的表现进行了广泛的调查。这种分析将使我们能够理解医学LLMs在不同方面如何胜过传统的医学AI模型。通过展示它们的能力,我们旨在阐明医学LLMs在临床环境中部署时带来的优势。

第三个问题关注医学LLMs在临床环境中的实际应用。我们提供了七种临床应用场景的指南和洞见,提供了医学LLMs的具体实现,并突出了每种场景使用了哪些能力。

第四个问题强调在临床实践中部署医学LLMs时必须克服的挑战。这些挑战包括幻觉(即生成连贯且与上下文相关但事实上不正确的输出)[27, 28, 29]、可解释性[30]、伦理、法律和安全问题[31]等。我们还提倡对医学LLMs进行更广泛的评估,包括诸如可信度[32]等方面,以确保它们在临床环境中的负责任和有效使用。

对于最后一个问题,我们提供了发展医学LLMs的未来方向的洞见。这一部分作为指南,旨在帮助研究人员和从业者推进这一领域,并最大化医学LLMs在医学中的潜力。

医疗大型语言模型

作者首先总结了大型语言模型的一些技术,如Transformer,大规模预训练,Scaling Laws等

Scaling Law 【1】是OpenAI 2020年提出的概念,模型的最终性能与计算量,模型参数量和数据大小有关。

之后DeepMind又提出了Chinchilla Scaling Law 【2】

随后,作者总结了通用领域LLM,分为了Encoder-Only,Decoder-only和Encoder-Decoder三种架构,具体见下表。

现有的医疗LLMs主要是从零开始预训练、从现有的一般LLMs微调,或者直接通过提示(prompting)使一般LLMs适应医疗领域。

作者总结了采用不同方法的医疗LLM,具体见下表。

但感觉分类方式与其他不太一致,仅供参考。

临床应用

随后作者讨论了LLM在临床上的应用。

Medical Diagnosis 医疗诊断

医学诊断包括医生结合来自测试的客观医疗数据和自我描述的主观症状,得出最有可能发生在病人身上的健康问题的结论。

准确和及时地诊断患者总是很重要的,因为对大多数疾病的治疗效果是非常对时间敏感的。

举例:Dr.Knows一种基于图的模型,在真实的医院数据集上使用可解释路径选择顶级诊断病例。可解释的路径来自于统一的医学语言系统(UMLS)

UMLS : UMLS一体化医学语言系统,针对生物医学与健康领域的数据库系统、本体知识库。

主要包含三个工具:

- 一个巨大的实体数据库

2.一个元数据词典中所有概念的关系集合

3.一个为自然语言处理系统提供的通用英语词典

限制:使用llm作为医学诊断的唯一工具的一个明显限制是,它完全依赖于来自患者的主观输入,它无法结合视觉信息进行诊断。但是它可以作为一种逻辑推理工具帮助诊断,以帮助提高其他基于视觉的模型的准确性。如ChatCAD。

Formatting and ICD-Coding 格式化和ICD编码

迫切需要自动化ICD标记过程,因为它会耗费时间,而且通常是由医生自己完成的。

ICD: 国际疾病分类(International Classification of Diseases,简称ICD):

- ICD 是由世界卫生组织(WHO)制定和发布的一套全球通用的疾病和健康相关问题的分类系统。它的主要用途是为临床诊断、流行病学研究和医疗统计提供一个标准的分类框架,以确保全球范围内对疾病和健康状况的统一记录和报告。

EHR: electronic health records 电子病历

llm可以通过从临床记录中分离医疗术语并分配相应的ICD代码来帮助自动化ICD编码。

举例: PLM-ICD

讨论:解决任何LLM中潜在的偏见和幻觉都是至关重要的。在他们进入患者的电子健康记录(ehr)之前,建立一种机制来检测和纠正这些错误同样至关重要。

Clinical Report Generation 临床报告生成

临床报告是指医疗保健工作者在每次患者就诊后必须完成的标准化文件。

可以使用LLM作为一种总结工具来帮助生成临床报告。给定一个诊断作为输入,它可以使用其文本摘要功能,以给出一个清晰和简洁的最终结论。

在这个用例中,llm并不直接帮助提高结论的准确性。相反,它们只是作为一种方便的工具,让医生们去做一些乏味的工作。

这种方式更多是一种辅助工具

llm生成临床报告的另一种流行用途通常依赖于其他类型的基于视觉的模型或医生的手动输入作为流程中的前置操作。

尽管用LLM来生成临床报告或者总结工具已经被证明有效,但是人们仍然担心幻觉,以及一种倾向于用字面意思的观点而不是人类医生通常采取的基于假设的观点来处理输入。

Medical Education 医学教育

医学教育既可以包括专业人员教育,也可以包括普通公众教育,这可以说同样重要。

llm可以通过多种方式被纳入医学教育系统,包括帮助学生准备医学考试,作为一个苏格拉底式的导师,以及回答问题。

对于普通病人来说,医疗对话往往是复杂和难以理解的。

问题:在医学教育中使用llm的一些潜在缺点是目前缺乏道德培训和可能来自训练数据集的偏见

Medical Robotics 医疗机器人

医疗机器人需要传感器获取输入数据,分析这些数据,执行路线规划,以及执行计划的路线,以执行所需的行动。

举例: Graph-based Robotic Instruction Decomposer

挑战:实施医疗机器人的一些挑战与实施协作机器人(cobot)时的挑战非常相似,因为这两种情况都涉及机器人与人类一起操作,这需要信任机器人总是做正确的事情。

Medical Language Translation 医学语言翻译

一种是将医学术语学从一种语言翻译成另一种。

另一种是将专业医学对话翻译成非专业人员容易理解的表达方式。

利用LLM进行翻译的一个道德考虑是可能会在输出中无意中插入具有歧视性措辞的潜在风险。由翻译错误引起的潜在错误信息可能导致患者混淆,甚至在最糟糕的情况下,采取错误的医疗建议并执行,对自己造成伤害。

Mental Health Support 心理健康支持

心理健康支持包括诊断和治疗。抑郁症是一种常见的心理健康问题,通过多种治疗,包括认知行为疗法、心理疗法、心理动力疗法等。这些技术主要由医患之间的对话主导。

由llm支持的聊天机器人可以大大增加对心理健康治疗资源的可及性。心理咨询及随后的治疗对许多人而言可能成本过高,而聊天机器人能够充当对话伙伴和陪伴者,将显著降低对于在财务或身体方面受限的患者的准入门槛。自我表露的程度对心理健康诊断和治疗的效果有重大影响。患者愿意分享的信息越多,诊断就越准确,因此,治疗计划也就越准确。

挑战:书面和口头交流技巧的差异。这可能是llm为了进一步模仿治疗师而必须打破的一个障碍。

挑战

幻觉,病人隐私,数据偏见,伦理,安全

幻觉

-

内在幻觉:是指产生在逻辑上与事实信息相矛盾的输出。如数学问题的错误计算。

-

外在幻觉:当所产生的输出无法被验证时,就会产生外部的幻觉。如LLM伪造某个引用。

解决方法:

- 训练时校正:调整模型的权重,从而降低产生幻觉输出的概率。如factually consistent reinforcement learning和contrastive learning

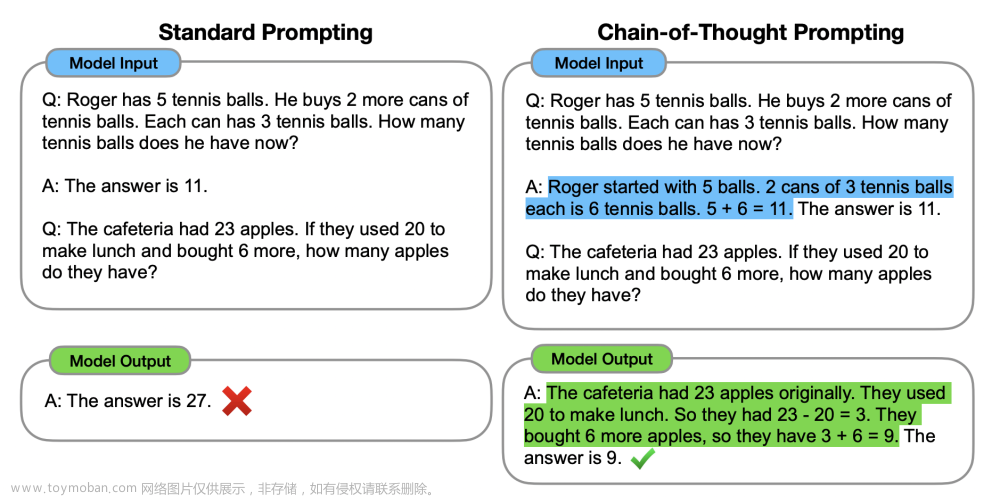

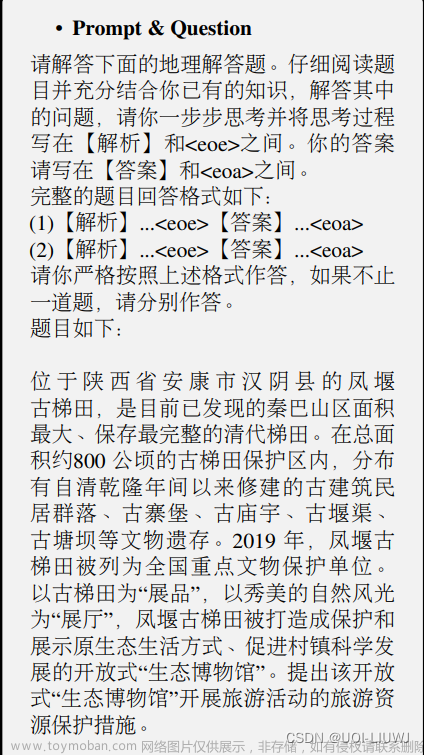

- 推理时校正:推理中加入推理过程。如生成多个样本SelfcheckGPT【3】

- 检索增强校正:利用外挂知识库。如利用事实文档作为提示或者检索链提示技术

缺少评估Benchmarks 和 指标

目前的基准测试,如MedQA(USMLE)和MedMCQA 提供了广泛的问答任务覆盖,但未能评估llm特定的重要指标,如可信度、忠诚度、帮助性和可解释性。

HealthSearchQA提出了由普遍搜索的健康查询组成的健康搜索QA,为评估LLM在医疗领域的能力提供了一个更人性化的基准。

领域数据限制

与用于通用领域训练的数据相比,医疗领域的数据较少。医学知识的领域很广阔,而现有的数据集无法覆盖整个领域。

这导致LLM在具有广泛数据覆盖的开放基准上表现出色,但在实际任务如差异诊断和个性化治疗规划方面表现不足。

解决方法:

- 在较小的开放域数据集上微调

- 利用LLM生成高质量的合成数据集(但是有研究表明可能会导致模型遗忘)

新知识

两个问题:

- 让LLM忘掉旧的过时的知识

- 让LLM及时增加最新的知识

这些问题对在医疗领域使用llm构成了重大障碍,因为在医学领域中,准确和及时地更新最新的医学知识在实际实施中至关重要。

两个方法:

- 模型调整:调整模型参数来修改模型的知识。这种方法不能推广,并且不同模型效果有差异

- 检索增强生成:模型推理时提供外部知识库。如RAG方法【4】

行为对齐

虽然努力使llm与人类行为保持一致,但一般人类和医学专业人员之间的行为差异对于在医学领域采用llm仍然具有挑战性。

例如,ChatGPT对医疗咨询的回答并不像人类专家的回答那样合理和专业。

方法:指令微调,RLHF,提示微调

举例:chain of hindsight【5】

伦理、法律和安全问题

通用领域本就有这些问题,在医疗领域这个问题更加重要。

比如可能提示注入会导致个人信息的泄露。

未来方向

引入新的Benchmarks

现有的一些benchmarks针对大模型回答医学问题的准确性进行评估。

最近一些研究表达了对仅基于LLM完成为人类设计的标准考试的准确性来评估LLM的担忧。LLM能够通过医学资格考试不代表它有提供医疗建议的能力,由于该模型可能缺乏临床医生在许多其他重要临床意义方面的专业知识。

鉴于这一限制,需要研究和建立新的LLM功能,例如从可信的医学参考中获取信息、了解医学共识不断发展的格局,并清晰地向用户传达不确定性。

跨学科合作

医学专业人员最好参与到LLM的训练和应用过程中

多模态LLM

可以结合其他模态的数据构建LLM,如时间序列,视觉和听觉数据

时间序列数据如心电图和血压计

在较不成熟的医学领域的llm

可以关注于其他不那么传统但同样重要的医学方向如康复疗法和运动医学。

参考文章

[1] [2001.08361] Scaling Laws for Neural Language Models (arxiv.org)

[2] [2203.15556] Training Compute-Optimal Large Language Models (arxiv.org)

[3] [2303.08896] SelfCheckGPT: Zero-Resource Black-Box Hallucination Detection for Generative Large Language Models (arxiv.org)

[4] [2005.11401] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks (arxiv.org)文章来源:https://www.toymoban.com/news/detail-771209.html

[5] [2302.02676] Chain of Hindsight Aligns Language Models with Feedback (arxiv.org)文章来源地址https://www.toymoban.com/news/detail-771209.html

到了这里,关于【论文笔记】A Survey of Large Language Models in Medicine - Progress, Application, and Challenges的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读笔记77]LoRA:Low-Rank Adaptation of Large Language Models](https://imgs.yssmx.com/Uploads/2024/02/740494-1.png)

![[论文阅读笔记] TRACE: A Comprehensive Benchmark for Continual Learning In Large Language Models](https://imgs.yssmx.com/Uploads/2024/01/801421-1.png)