引言

XPath是一种用于选择XML文档中节点的语言,它可以通过路径表达式来定位节点。由于HTML文档的结构与XML文档类似,XPath也可以用于解析HTML文档。Python是一种非常流行的编程语言,它提供了许多库用于解析HTML文档。本文将介绍Python中使用XPath解析HTML文档的方法和技巧。

XPath语法

XPath表达式组成

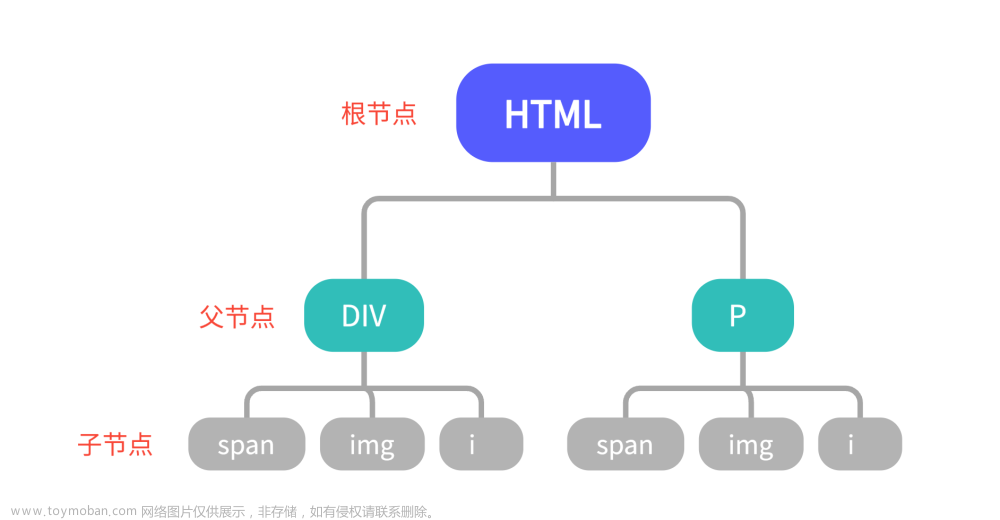

XPath的路径表达式类似于文件系统中的路径,它用于描述节点在文档树中的位置。XPath表达式由以下几个部分组成:

-

标签名:标签名用于描述节点的类型,它可以是HTML标签名或XML标签名。例如,img表示图片节点,a表示链接节点。

-

轴:轴用于描述节点与当前节点的关系,它可以是父节点、子节点、兄弟节点等。

-

谓词:谓词用于描述节点的属性或位置。

XPath方法

在lxml库中,可以使用XPath方法来解析HTML文档。XPath方法有以下几种:

-

etree.HTML():将HTML字符串转化为一个Element对象。 -

find():返回第一个匹配的元素。 -

findall():返回所有匹配的元素。 -

xpath():返回所有匹配XPath表达式的元素。

=

Python中使用XPath解析HTML文档

Python中有许多库用于解析HTML文档,其中比较流行的有BeautifulSoup和lxml。这两个库都支持使用XPath解析HTML文档。在本文中,我们将使用lxml库来解析HTML文档。

安装lxml库

在使用lxml库之前,需要先安装它。可以使用pip命令来安装lxml库,命令如下:

pip install lxml

解析HTML文档

在使用lxml库解析HTML文档之前,需要先将HTML文档加载到内存中。可以使用requests库来加载HTML文档,代码如下:

import requests

url = 'https://www.example.com'

response = requests.get(url)

html = response.content

接下来,我们将使用lxml库来解析HTML文档。代码如下:

from lxml import etree

将HTML文档转换为Element对象

element = etree.HTML(html)

使用XPath表达式来选择节点

nodes = element.xpath('//a[@class="link"]')

遍历节点并输出节点的文本

for node in nodes:

print(node.text)

在上面的代码中,我们使用etree.HTML()方法将HTML文档转换为Element对象。然后使用XPath表达式来选择所有class属性为link的a标签节点。最后遍历所有节点并输出节点的文本。

XPath表达式示例

下面我们将介绍一些常用的XPath表达式及其对应的示例。

选择节点

选择所有节点:

//*

选择指定节点:

//a

选择指定节点和属性:

//a[@href]

选择指定节点和属性值:

//a[@href='https://www.example.com']

选择指定节点和多个属性值:

//a[@href='https://www.example.com' and @class='link']

选择指定节点和文本:

//a[text()='Link']

选择父节点:

../

选择指定父节点:

../div

3.3.3 选择子节点

选择子节点:

/*

选择指定子节点:

/div

选择兄弟节点:

/following-sibling::*

选择指定兄弟节点:

/following-sibling::div

选择前一个兄弟节点:

/preceding-sibling::div[1]

谓词

选择属性等于指定值的节点:

//*[@class='link']

选择属性不等于指定值的节点:

//*[@class!='link']

选择属性包含指定值的节点:

//*[contains(@class, 'link')]

选择属性以指定值开头的节点:

//*[starts-with(@href, 'https://')]

选择属性以指定值结尾的节点:

//*[ends-with(@href, '.html')]

选择指定位置的节点:

//*[position()=3]

选择指定范围内的节点:

//*[position()>2 and position()<6]

运算符

选择属性值为数字的节点:

//*[starts-with(@id, 'item') and @id > 10]

选择属性值为数字的节点并按照属性值排序:

//*[starts-with(@id, 'item') and number(@id) > 10]/@id | //*[starts-with(@id, 'item') and number(@id) > 10]/@class

示例代码如下:

from lxml import etree

# 构造html

html_string = '''

<html>

<head>

<title>Contains Test</title>

</head>

<body>

<div id="content">

<h1>Welcome to my website</h1>

<p>This is a test page to demonstrate the use of contains in XPath.</p>

<ul>

<li><a href="#">Link 1</a></li>

<li><a href="#">Link 2</a></li>

<li><a href="#">Link 3</a></li>

</ul>

</div>

</body>

</html>

'''

# 解析html

doc = etree.HTML(html_string)

# 使用contains函数查找包含“test”的段落元素

p_elements = doc.xpath('//p[contains(text(), "test")]')

# 打印结果

for p in p_elements:

print(p.text)

输出结果为:

This is a test page to demonstrate the use of contains in XPath.

除了使用contains函数,我们还可以使用其他的xpath语法来解析html。以下是一些示例代码:

- 查找所有链接元素

# 使用xpath表达式选择所有名称为“a”的元素

link_elements = doc.xpath('//a')

# 打印结果

for link in link_elements:

print(link.text, link.get('href'))

输出:

Link 1 #

Link 2 #

Link 3 #

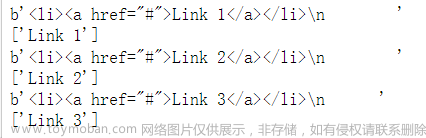

- 查找所有列表项元素

# 使用xpath表达式选择所有名称为“li”下的a节点的元素

li_elements = doc.xpath('//li')

# 打印结果

for li in li_elements:

print(etree.tostring(li)) #'输出节点'

print(li.xpath('./a/text()')) #'输出a节点文本'

输出:

- 查找所有带有id属性的元素

# 使用xpath表达式选择所有带有id属性的元素

id_elements = doc.xpath('//*[@id]')

# 打印结果

for element in id_elements:

print(element.tag, element.get('id'))

输出:

div content

- 查找特定id的元素

# 使用xpath表达式选择id为“content”的元素

content_element = doc.xpath('//*[@id="content"]')[0]

# 打印结果

print(content_element.tag, content_element.text)

输出:

div文章来源:https://www.toymoban.com/news/detail-771252.html

总结

本文介绍了Python中使用XPath解析HTML文档的方法和技巧。XPath是一种强大的语言,它可以通过路径表达式来定位节点,同时还支持多种谓词和运算符。在Python中,lxml库是一种常用的解析HTML文档的库,它支持使用XPath表达式来选择节点。通过本文的介绍,相信读者已经掌握了使用XPath解析HTML文档的基本方法和技巧,可以应用于实际开发中。文章来源地址https://www.toymoban.com/news/detail-771252.html

到了这里,关于Python使用XPath解析HTML:从入门到精通的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!