Han Q, Lu Z, Zhao S, et al. Data-driven based phase constitution prediction in high entropy alloys[J]. Computational Materials Science, 2022, 215: 111774.

基于数据驱动的高熵合金相组成预测

摘要

【背景】 高熵合金(HEA)因其优异的材料性能和近乎无限的设计空间而吸引了越来越多的研究。开发有效的相组成预测方法对于新型 HEA 设计非常重要。【机器学习作用】 机器学习(ML)作为一种有效的数据驱动方法,为 HEA 的相位预测提供了一种可能的方法,【本文目的】 但是,缺乏对各种 ML 模型的有效性和差异的澄清。【主要内容】 本文收集了800多个HEAs物相数据,总结了16个特征。使用各种机器学习模型来训练和预测相组成。结果表明,【结果1】 以 XGBoost 和随机森林为代表的集成学习比其他传统机器学习模型取得了更高的预测精度。【结果2】 验证了特征训练模型的有效性,并使用主成分分析方法在不损失精度的情况下降低特征维度。【结果3】 通过决策边界比较来探讨机器学习模型的有效性和差异。本文开发的机器学习模型可应用于新型 HEA 的相位预测。

1.引言

几十年来,金属合金的开发基于单一主要成分,并添加其他稀合金元素以实现目标性能。相比之下,高熵合金 (HEA) 被提出通过探索相图的广阔中心部分来扩展设计空间 。这种设计理念导致了越来越多具有应用价值的合金以及有趣的物理化学现象。【如何探测高熵合金领域】 高熵合金勘探的重要冶金课题之一在于准确的相组成预测。这不仅是因为相构成在影响机械和/或功能性能方面的重要作用,而且还因为多组分非稀释系统的热力学复杂性。早期的实验研究证实了 HEA 加工过程中 【相的种类】 固溶体 (SS)、金属间化合物 (IM) 和非晶态 (AM) 相的存在和竞争。在固溶体体系中,还记录了最常见的晶体结构包括面心立方 (FCC)、体心立方 (BCC) 和六方密堆积 (HCP)。迄今为止,【相预测方法】 提出的预测 HEA 相组成的方法包括 PHAse 图的半经验计算 (CAL PHAD) 、高通量实验以及两者的组合。【举例1】 Feng 等人集成的高通量筛选、多尺度建模和实验验证被证明在加速发现由 HEA 概念调整的先进沉淀强化结构材料方面是有效且有用的 。【举例2】 从头算能量被纳入平均场统计力学模型中,该模型由 Lederer 等人工作,并通过蒙特卡罗模拟和当前可靠合金数据的结果得到证实 。【局限性】 然而,这些方法的成本效益仍然存在争议。这面临着重要的挑战,并呼吁开发可靠的第一过滤器来筛选相形成趋势。鉴于此,【开始提出使用参数进行预测】 最近的文献反映了利用可以通过从头建模计算的电子和/或原子参数来预测相构成的趋势。这些参数的起源可以追溯到休谟-罗瑟里规则,包括价电子浓度(VEC)、电负性差(δχ)和原子半径差(δ)。这些参数可以很容易地从 HEA 成分中计算出来。因此,研究人员根据上述参数制定了相应的HEA相组成预测规则。【举例相组成预测规则】 例如,Yang等人基于以固溶体为主的典型多组分HEA的相组成数据库提出了经典的Zhang规则。经典的Zhang规则表明:当Ω<1时,

Δ

H

m

i

x

ΔH_{mix}

ΔHmix占主导地位,并且可能发生金属间化合物或偏析。另一方面,当 Ω > 1 时,预计会形成固溶体,其中通过高水平的混合无序来维持稳定性。其他研究提出简单固溶体的形成极限为 Ω > 1.1 和 δ < 6.6。宋等人研究了复杂环境条件下的 CoMoFeNiCu HEA 材料,并证实了合成的 HEA 纳米颗粒(NPs)的稳定性符合张规则。这些参数虽然是更直接的相构成预测因子,但通常无法充当通用标准。

随着大数据时代的到来,以数据驱动解决方案为代表的技术展现出强劲的生命力和良好的应用前景。基于大量数据的积累,机器学习(ML)能够探索各种因素之间的关系,已应用于复杂浓缩合金(CCA)的相组成和机械性能的预测。使用机器学习方法进行 HEA 相预测是一个潜在的应用场景,它可以基于数千个已报道的 HEA 数据集促进高效合金开发。最近,高通量筛选、第一性原理密度泛函理论计算和机器学习的结合已被证明是HEA催化应用和最佳元素组成选择的有效工具。 【机器学习进展的三个方面】 HEA 机器学习的最新进展主要分为三个方面 。首先,采用不同的算法来寻找最佳的机器学习模型,以提高预测精度。其次,基于机器学习的特征优化被认为可以更好地描述相的构成。第三,机器学习方法用于利用给定材料的热力学和成分属性来预测可合成性。【其他发展】 此外,【举例1】 还进行了基于机器学习模型的杨氏模量和其他力学性能的预测。例如,基于ML方法通过修改合金成分对PdAuAgTi合金的氧还原反应(ORR)催化活性进行了预测和优化,发现PdAuAgTi合金的ORR活性在8~12范围内最优。钛成分的%。【举例2】 张等人提出了一种特征选择和变量优化方法,基于三个机器学习模型来分析九个特征参数对HEA相形成的影响。【举例3】 Zhou等人提出了一套HEA相元件设计参数,并基于ML方法评估了现有的HEA相元件设计规则。【以往研究不够完善】 然而,对于特征之间的相关性和有效性,以及机器学习模型之间性能差异的原因的探索仍处于起步阶段。尽管验证的准确性得到了提高,但是,HEA 相预测的不同 ML 模型的预测和澄清之间的差异尚不可用。此外,大多数研究为了提高训练效率,只是简单地删除不太重要的特征以减少特征的维数,因此缺乏对影响HEA相位预测的各种特征的有效性的具体分析。

【本文主要内容】 本文收集了 800 多个 HEAs 相构成数据,并检查了包括传统 ML 模型和集成 ML 模型在内的六种不同 ML 模型的性能。对于不同的模型,分析特征重要性的排序。采用递归特征消除和交叉验证来验证特征的有效性。然后进行主成分分析,以减少特征维数,在不损失精度的情况下尽可能保留特征信息。最后,在特征空间中描述模型的分类决策边界,这解释了不同机器学习模型之间性能差异的原因。

2.方法

2.1数据收集和处理

这项工作收集了不同的合金,包括二元合金、三元合金、四元合金和其他至少含有五种元素的合金。本文收集的数据均是在铸态条件【指的是合金在铸造后的状态,也就是指合金在冷却凝固后的原始状态,而没有经过任何热处理或加工。在这种状态下,合金的微观组织和化学成分保持着铸造时的特征】 下通过HEA形成的,以保证相组成的稳定性。本工作中使用的高熵合金数据来自多个文献的结果[17,33–41]。同时,为了保证相组成数据的准确性,当不同文献反映的同一高熵合金的相组成发生冲突时,根据判断标准确定相分类。相组成可分为三类:固溶体(SS)、金属间化合物(IM)和非晶态(AM)[42]。各类别数据量如下:SS:446,IM:255,AM:166。各类别数据量比较均衡,基本覆盖了目前HEA的研究范围。总共总结了16个特征来描述HEA的相预测模型,如表1所示。考虑到800多个数据量太大,无法完全展示,选择了5种高熵合金作为示例,并给出了示例数据集如表2所示。【底层参数】 其中,

c

i

c_i

ci、

(

V

E

C

)

i

(VEC)_i

(VEC)i、

r

i

r_i

ri、

χ

i

χ_i

χi分别表示摩尔值、价电子数、原子半径和电负性值。

H

m

i

x

i

j

H^{ij}_{mix}

Hmixij 为原子对的焓。

r

L

r_L

rL、

r

s

r_s

rs 表示最大和最小原子半径。R、

k

B

k_B

kB 分别表示气体常数和玻尔兹曼常数。

r

ˉ

\bar{r}

rˉ、

T

m

T_m

Tm 分别表示平均原子半径和平均熔点:

【本文使用的16个特征】 热力学特征

Δ

S

m

i

x

ΔS_{mix}

ΔSmix和

Δ

H

m

i

x

ΔH_{mix}

ΔHmix用于描述稳定固溶体相的形成以及主要成分之间的化学相容性。郭等人分析了

δ

r

、

δ

χ

、

V

E

C

、

δ

V

E

C

δ_r、δ_χ、VEC、δ_{VEC}

δr、δχ、VEC、δVEC和

χ

a

r

g

χ_{arg}

χarg,发现这些特征能够描述SS和AM之间的相位选择。

δ

T

δ_T

δT 用于描述不同元素之间的熔点差异。根据Yang等人提出的一个参数

Ω

,

T

m

Δ

S

m

i

x

Ω,T_mΔS_{mix}

Ω,TmΔSmix和

∣

Δ

H

m

i

x

∣

|ΔH_{mix}|

∣ΔHmix∣之间的竞争决定了SS的形成。一组相邻原子

α

2

α_2

α2 之间的无量纲位移,用于呈现 HEA 中晶格畸变的物理描述 。 Tan 等人提出参数

γ

γ

γ来揭示原子堆积失配和拓扑不稳定性。 HEAs设计中原子尺寸差异的重要性考虑了无量纲混合焓的方差

δ

H

m

i

x

δH_{mix}

δHmix,负混合焓使不同组分结合形成金属间化合物,而正混合焓使不同组分难以混合并导致固体中的偏析,因此添加

δ

H

m

i

x

0

、

δ

H

m

i

x

0

+

、

δ

H

m

i

x

0

−

δH^0_{mix}、δH^{0+}_{mix}、δH^{0−}_{mix}

δHmix0、δHmix0+、δHmix0− 来描述同时混合的无量纲焓的方差。研究发现纯几何参数

λ

λ

λ的高值有利于无序固溶体的形成 。在训练ML模型之前,需要对特征数据进行标准化,使得不同维度的特征处于同一维度,模型对每个特征的敏感度一致,有利于模型训练。数据标准化公式如下:

其中

X

n

e

w

X_{new}

Xnew表示归一化后的特征值,

X

i

X_i

Xi是原始数据,

X

m

a

x

X_{max}

Xmax,

i

i

i和

X

m

i

n

X_{min}

Xmin,

i

i

i分别是特征的最大值和最小值。将表1中总结的16个特征作为ML模型的输入值,并根据SS、IM和AM分类对收集的HEA相组成数据进行标记。本工作使用了867个高熵合金数据样本,其中80%的数据(693个样本)作为训练集,其余20%(174个样本)随机选择进行验证。采用网格搜索方法寻找最优参数,并采用5倍交叉验证提高数据集的使用效率。验证集的准确率用于评估不同机器学习模型的性能。

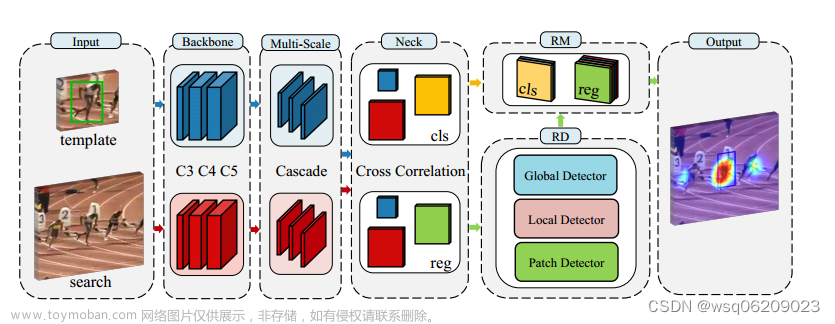

2.2机器学习模型

【介绍本文使用的6种机器学习算法的特性】 本文介绍了六种代表性的机器学习模型,它们都是监督学习算法,包括K近邻(KNN)、支持向量机(SVM)、决策树(DT)、随机森林(RF)、XGBoost和梯度提升决策树(GBDT) )用于探索 HEA 的相组成预测。 ML 模型使用 Sklearn 开源算法库。在选定的 6 个 ML 模型中,KNN 和 SVM 是传统的机器学习模型,DT、RF、XGBoost 和 GBDT 是集成学习模型。 KNN根据分类决策中最接近样本的类别来决定待分类样本的分类,但当样本数量不平衡时,它对稀有类别的区分度较低,而且它没有学习到特征之间的关系,因此容错性较差。 SVM在特征空间中寻找最优平面,最大化样本与决策面之间的间隔,并利用核函数映射到高维空间来解决非线性分类问题。 DT算法的决策过程是从根节点开始,测试待分类项对应的特征属性,根据其值选择输出分支,直到叶子节点,如图 所示。它具有可解释性强、运算速度快的优点,但容易造成过拟合。 RF算法是随机生成由决策树组成的森林,具有处理大量数据、泛化能力强、抗过拟合、训练精度高的特点。 XGBoost是一种集成算法,通过连续的特征分割、学习目标函数、拟合残差,具有训练效率高、泛化能力强的特点。 GBDT通过梯度提升方法集成了多个决策树,使用损失函数作为负梯度算法拟合残差近似,从而可以处理非线性数据。 图1 a

图1 a

3.结果和分析

3.1特征相关性

【使用皮尔逊系数选择了13个相关性不是很高的特征进行机器学习】 在训练机器学习模型之前,需要分析数据集和特征,以帮助更好地理解它们之间的关系。皮尔逊系数常用于描述各种特征之间的相关程度。 16个特征之间的Pearson相关系数结果如图所示。可以看出,

δ

r

δ_r

δr和

δ

χ

δ_χ

δχ的Pearson相关系数大于0.9,说明它们的描述非常接近,即这些因素之间存在很强的相关性,使得模型容易出现过拟合。如果去除

δ

r

δ_r

δr、

δ

χ

δ_χ

δχ和

δ

H

m

i

x

0

δH^0_{mix}

δHmix0混合,则剩余特征之间的皮尔逊系数将全部小于0.9。高度相关的特征可能会增加训练模型的难度并影响预测的准确性。因此,在接下来的工作中,分别使用原始的16个特征和当前的13个特征来训练ML模型,以弄清楚去除高度相关的特征将如何影响训练模型,结果将在下节中展示3.2.

图1 b

3.2 机器学习模型的预测性能

【发现13个特征和16个特征的精度相差不大】 下图显示了训练后不同ML模型在验证集上的预测性能。可以看出,所有模型的预测精度均能达到0.7以上。 XGBoost模型的预测性能最好,RF的预测精度第二高,表明学习更多的分解特征参数可以促进在更高维空间中的有效分类。此外,删除相关性较强的3个特征后,训练模型的预测精度与原始16个特征接近。因此,有必要探讨这些问题,这16个特征对于训练ML模型有多重要,以及这些特征对于训练模型是否有效。最后,是否可以在不损失准确性的情况下,减少特征数量并尽可能保留特征信息?这些问题的分析将在下面的3.3节中给出。

图1 c

3.3 特征和特征降维的重要性和有效性

3.3.1 特种重要性排序

首先,对本文16个特征的重要性和有效性进行分析,为特征降维做好准备。特征的重要性计算为该特征带来的标准的总减少。从上述模型的训练性能来看,选取4个模型(RF、DT、XGBoost和GBDT),利用模型算法中的特征重要性分析属性,对参与计算的16个特征的重要性进行评估,如下图图2。【评估特征对模型的敏感度】 可以看出,不同的分类模型对特征的敏感度不同。以原子半径表示的几何特征,如

λ

λ

λ,以及以熵和焓表示的热力学特征,如

Δ

H

m

i

x

ΔH_{mix}

ΔHmix , 表明这些特征对训练模型有很大的影响。然而,以电负性为代表的化学特征, 例如

δ

χ

δ_χ

δχ ,表明这些特征与其他特征相比影响力相对较小。在进一步分析特征有效性之前,有必要了解特征数据集的空间分布。【选择XGBoost,将特征进行排序,即下图是以特征重要性逐步升高排序的】 选择 XGBoost 模型的特征重要性排序是因为它在验证集中表现最好。选择特征重要性排序较高的五个典型特征参数(如图2所示),包括λ、γ、Ω、ΔHmix、VEC,

【想通过最重要的几个特征的空间分布来区分出不同的相】 以成对的方式可视化它们的空间分布,如下图3(a)所示。由于第五和第六排名特征(δH0 mix 和 δH0+ mix)仍然代表高熵合金的热力学焓特性,与第四排名 ΔHmix 的特征重复,因此选择排名稍低的 VEC 以更多地显示相关关系。不同属性之间的关系。可以看出,没有一对特征可以清楚地区分不同类型的相。图 3(a) 的

Δ

H

m

i

x

ΔH_{mix}

ΔHmix −

V

E

C

VEC

VEC、

γ

γ

γ−

V

E

C

VEC

VEC、

γ

γ

γ−

Δ

H

m

i

x

ΔH_{mix}

ΔHmix分布中,类别 SS 的主聚集区域与类别 AM 之间的距离最远,类别 IM 的主聚集区域位于两者之间或相交跟他们。三个类别(SS、IM、AM)的色点分布具有区域聚集的特征,在特征空间中的分布存在一定的差异。 上述三对特征的组合可以为区分HEA的不同相提供更明显的划分边界和趋势 。 然而,在其余特征对的空间表示中,HEA 的三类相在某些区域是重叠的,这给清晰地区分不同相和准确预测相组成带来了障碍和复杂性。同时,从图3(a) 第一行和第三行观察,红点代表的SS类别的λ和Ω值明显高于其他两类,这意味着这两个参数可以更好地判断固溶体相 。尽管特征的重要性不同,但这并不意味着重要性级别较低的特征不能提高模型的准确性。训练模型中特征的有效性在循环特征提取和交叉验证(RFECV)分析中进行了探索,这将在 3.3.2 节中进行研究。

图3 a和b

3.3.2 特征有效性分析:RFECV(循环特征提取和交叉验证)

进行循环特征提取和交叉验证(RFECV)分析来分析特征的有效性。在此过程中,训练模型返回每个特征的重要性,然后从当前特征集中去除最不重要的特征,并通过数据集中的交叉验证找到特征的最佳组合。如果减少特征会导致性能损失,则不会删除任何特征。这里,选择图1(c)所示的具有最高预测精度的XGBoost模型来探索所选择的16个特征是否对分类有效。 XGBoost模型的RFECV分析曲线结果如图3(b)所示,表明随着特征数量的增加,交叉验证得分不断上升,没有出现明显下降,并保持上升趋势。正如3.3.1节中关于特征重要性排序的讨论,排名靠前的特征的添加显着提高了模型的训练水平,而其他相对不太重要的特征的添加不会带来准确性的损失,这表明本文选取的16个特征对于SS/IM/AM分类都是有用的。接下来,我们将探讨是否可以在不损失精度的情况下减少特征数量,以便方便地训练 ML 模型。

3.3.3 特征降维:PCA分析

通常,过多的特征会增加模型训练的难度,甚至造成维数灾难。 ML模型的优化旨在在不影响模型精度的情况下尽可能减少特征数量,其中精度定义为通过主成分分析(PCA)进行的显着性。

PCA常用于数据降维,即将高维特征映射到低维正交特征,保留数据中的主要成分,而忽略对特征描述不重要的成分。衡量特征的功能就是观察特征与结果之间的相关性。【特征值影响结果的原因】 特征值的变化会引起结果的变化,只有这样的特征才被认为对结果有影响。如果一个特征的方差很小,即该特征的取值非常集中,那么该特征取什么值都不会对结果产生太大的影响。【PCA降维与RFECV】 由于PCA降维计算是不断寻找合适的正交维度空间,因此可以在一定程度上保留一些特征的信息,而RFECV降维计算会直接删除不需要的特征,可能会导致一些信息的丢失。因此,PCA降维方法通常更加有效和准确。

【PCA结果:16个特征都有帮助】 这里也选择XGBoost模型作为代表进行PCA分析,结果如图3(c)所示。可以看出,随着特征主成分的增加,准确率的上升是分三个阶段逐步上升的趋势,并且曲线的上升趋势是对离散点进行拟合的,说明加法更多特征参数有助于提高对 HEA 相分类模型的学习和理解。本研究中使用的16个特征可以有助于ML模型的训练,这也与3.3.2节中RFECV分析的结果一致。

同时,从图3(c)可以看出,随着主成分数量从2个增加到8个,这个过程中精度一直在增加。然而,当主成分数量超过8时,预测精度不会显着提高。结果表明,PCA可以将16个特征减少到8个特征来满足模型的需要,可以显着降低训练难度和时间,并在不损失准确性的情况下尽可能保留特征信息。

内容只是描述了功能的重要性和有效性。而PCA分析可以减少特征维数,加快模型训练速度。然而,不同的模型在训练后有不同的性能。除了在图1(c)中直观地判断验证集中的准确性之外,我们还需要对不同模型的性能进行更详细和具体的比较,并探究不同模型性能差异的原因。这些可以为后续选择合适的ML模型进行训练提供理解和帮助,并将在3.4节中进行研究。

3.4 模型对比

3.4.1 通过二元分类和 ROC 曲线进行模型比较

在 3.2 和 3.3 节中,从验证集的准确性方面评估了 ML 模型。在这里,我们成对使用 SS、IM 和 AM 之间的数据,并比较 ML 模型在二元分类情况下的准确性,结果如图 3(d)所示。从图3(d)可以看出,GBDT、RF和XGBoost在二元分类的验证集中实现了较高的准确率。具体来说,在SS/IM分类情况下,各个模型之间存在较大差异,GBDT模型的预测精度最高,达到0.9;在SS/AM分类情况下,所有模型的预测精度几乎接近1;在 IM/AM 分类情况下,KNN 表现最好,其他模型也达到 0.9。此外,图3(d)还显示所有ML模型在SS/AM分类中都实现了很高的判别能力,准确率都在0.9以上。 IM和AM的区分能力也很好,除了SVM(0.78)外,预测精度也能达到0.9以上。虽然,所有模型区分 SS 和 IM 的能力明显下降,表明区分 SS 和 IM 比其他两对更困难,但 GBDT、RF 和 XGBoost 的准确率仍然可以达到 85% 以上SS/IM 分类。在二分类的情况下,通常使用混淆矩阵(如表3所示),它可以真实、准确地反映模型的性能。模型的准确率定义为正确预测的样本占所有样本的比例:

ROC 曲线是二元分类问题中统计信息的表示,是反映敏感性和特异性的连续变量的综合指标。 ROC曲线以True Positive Rate为纵轴,False Positive Rate为横轴,得到不同阈值下的坐标点。得到ROC曲线如图4所示。ROC曲线上的每个点都反映了对同一信号刺激的敏感性。模型训练完成后,依次从高到低改变预测样本被认为是正的概率阈值,得到ROC曲线。当两个或多个算法进行比较时,每个测试的ROC曲线都绘制到同一坐标上,靠近左上角的ROC曲线代表工作更准确。很多情况下,ROC曲线是相似的,因此并不能清楚地表明哪个分类器的效果更好。 AUC(Area Under Curve)是评价二元分类算法的另一个指标,定义为ROC曲线下的面积,是评价准确率和召回率的指标。 AUC值大的分类器意味着它比其他分类器更有效。

【AUC值主要结果】 从图4(d)可以看出,DT模型的AUC值在任何分类情况下都是最小的,这意味着决策分类能力是这些ML模型中最差的。但RF和XGBoost的AUC值都在0.95以上,一直处于领先地位,几乎达到了准确分类的程度。此外,SVM模型在二元分类的情况下也取得了更好的AUC值。粗略地说,在SS/IM分类情况下,与其他两种情况相比,所有模型的ROC曲线距离左上角最远,如图4©所示,这意味着预测精度最低,本分类的判别难度是最高的。

二分类的比较有助于理解模型之间的差异,但在多分类的情况下无法进行全面的比较。因此在下面的3.4.2节中进行决策边界,以更直观地验证模型的分类能力。

3.4.2 决策边界差异

从3.3.1节的结果来看,

Δ

H

m

i

x

ΔH_{mix}

ΔHmix、

γ

γ

γ是两个重要的特征,并且成对地在特征空间中具有良好的相位辨别能力,因此将它们作为空间分布的参考坐标。根据训练好的模型(以KNN、SVM、RF、XGBoost为例),在空间中进行网格划分计算,得到模型中各类别的决策边界,进而进行验证集数据的分布绘制了决策空间中的曲线,如图 5 所示。

图5(a)显示KNN模型的决策边界相互交错,样本点分布在其中,这符合邻域分类算法的思想,即判断预测对象的属性根据周围样本的归属。但这样很容易被异常值等情况所欺骗,无法探究分类的本质。 SVM分类算法就是在特征空间内寻找最优平面,使样本与决策平面之间的间隔最大化。如图5(b)所示,SVM模型的决策边界是连续的,试图尽可能地将三类分开,但HEAs相的形成不仅仅由几个简单的特征决定。在特征空间中很难找到具有明显区分效果的最优平面。 RF模型是一种集成学习方法,由大量决策树计算组成,可以在小范围内仔细筛选类别,因此其决策边界更加细致,并且有很多交错边界。这表明RF模型可以学习更深层次的分类信息以提高准确性。同样,XGBoost算法模型也有大量的决策树计算,但与RF不同的是,它增加了正则化项,防止过拟合现象。**其决策边界通常是规则的,**在不同样本空间分布相对相似的情况下仍能区分。

从上述模型对比来看,传统的KNN或SVM模型只是在现有的特征空间中寻找一个边界来区分不同的样本,模型对特征的学习和理解仅仅停留在空间分布上,无法进一步深入。探索过。显然,在HEA相形成机制复杂的情况下很难实现。然而,以XGBoost为代表的集成学习模型表现更好,决策边界精细且具体,这表明集成学习模型通过学习16个特征参数比传统机器学习模型有更深入的理解。总体而言,每个模型的决策边界扩展都反映了其算法原理。

3.5 机器学习模型验证

为了进一步验证我们的 ML 模型,本文制备了两种铸态 HEA:

A

l

C

o

C

r

F

e

N

i

2.1

AlCoCrFeNi_{2.1}

AlCoCrFeNi2.1 和

F

e

50

M

n

30

C

o

10

C

r

10

Fe_{50}Mn_{30}Co_{10}Cr_{10}

Fe50Mn30Co10Cr10。我们利用电子背散射衍射(EBSD)快速定量分析材料的相结构。对于所有 EBSD 观测,加速电压设置为 20 kV,扫描步长设置为 2 μm。如图6(a)所示,铸态

A

l

C

o

C

r

F

e

N

i

2.1

AlCoCrFeNi_{2.1}

AlCoCrFeNi2.1的相图表征结果表明,其具有有序层状和网状结构形貌的共晶组织。如图 6(b)所示,铸态

F

e

50

M

n

30

C

o

10

C

r

10

Fe_{50}Mn_{30}Co_{10}Cr_{10}

Fe50Mn30Co10Cr10 的相图表征结果表明,其主要由 FCC 相(γ-奥氏体)和 HCP 相(ε-马氏体)组成,以及两种成分的比例大致相同。

【使用两种合金验证三种模型的准确性】 基于上述观察,我们使用 RF、XGBoost 和 GBDT 模型来预测两种铸态 HEA 的相组成。为了保证模型预测的公平性,这两种合金的结果并没有添加到训练模型的数据集中,以防止模型提前预测。三种ML模型的预测结果(见表4)与实际观测结果完全吻合,这表明以RF模型、XGBoost模型和GBDT模型为代表的集成学习模型对于物相组成的预测具有良好的适用性。简单和复杂的组成 HEA。这与3.4节中比较不同模型的预测精度和决策边界的结果一致。 文章来源:https://www.toymoban.com/news/detail-771644.html

文章来源:https://www.toymoban.com/news/detail-771644.html

结论

【结论】 本文收集了HEA的相组成数据和相关特征参数,并训练了多种机器学习模型算法来预测HEA的相组成。主要结论如下:

1.以RF和XGBoost为代表的集成学习模型的预测精度超过0.85,表现优于传统的机器学习模型,这表明使用更多的分解特征参数进行学习可以促进更高维空间中相位预测的有效分类。

2.通过对特征重要性的分析,得出原子几何结构和热力学是影响相组成的主要因素,其重要性值均超过0.1。另外,本文使用的特征参数对于通过RFECV分析进行预测和分类都是有意义的。

3.PCA方法已被证明可以有效降低特征维数、训练难度,并在不损失精度的情况下尽可能保留特征信息。在本文中,我们得出的结论是,最佳主成分数为 8。

4.决策边界的显示直观地表达了每种ML模型算法原理的特点。 KNN和SVM受分布点影响较大,而RF和XGBoost可以对小区域内的相位类别进行分类,具有更强的学习能力。

5.以RF、XGBoost、GBDT模型为代表的集成学习模型在简单和复杂的HEA相形成问题上都表现出了良好的适用性。文章来源地址https://www.toymoban.com/news/detail-771644.html

到了这里,关于论文阅读/中文记录,材料机器学习:Data-driven based phase constitution prediction in high entropy alloys的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!