Xuanzhou Liu, Lin Zhang, Jiaqi Sun, Yujiu Yang, and Haiqin Yang. 2023. D2Match: leveraging deep learning and degeneracy for subgraph matching. In Proceedings of the 40th International Conference on Machine Learning (ICML’23), Vol. 202. JMLR.org, Article 933, 22454–22472.

Abstract

子图匹配是基于图的应用程序的基本组成部分,由于其高阶组合特性而具有挑战性。现有的研究通常通过组合优化或基于学习的方法来解决它。然而,它们存在指数计算成本或搜索匹配没有理论保证的问题。在本文中,我们利用深度学习和简并性的效率进行子图匹配来开发d2匹配。更具体地说,我们首先证明了子图匹配可以退化为子树匹配,然后等价于在一个二部图上找到一个完美的匹配。然后,我们可以通过在图神经网络上内置的树状结构聚合机制来实现线性时间复杂度的实现。此外,还可以很容易地在D2匹配中加入圆的结构和节点属性,以提高匹配性能。最后,我们进行了大量的实验,以证明我们的D2匹配的优越性能,并确认我们的D2匹配确实利用了子树,并不同于现有的基于gnns的子图匹配方法,该方法依赖于记忆数据分布差异。

1. Introduction

子图同构,或在节点级别上的子图匹配(McCreesh et al.,2018),是一项关键但特别具有挑战性的图相关任务。它的目的是确定一个查询图是否与一个大型目标图的子图同构。它是各种基于图形的场景的一个基本构建块,例如,跨域数据的对齐(Chen等人,2020年)、时间序列的时间对齐(Zhou&Torre,2009年)和主题匹配(Milo等人,2002年;Peng等人,2020年)等。

现有的子图匹配研究可分为两大类:基于组合优化(CO)的方法和基于学习的方法(Vesselinova et al.,2020)。早期的算法通常将子图匹配表述为一个CO问题,其目的是在目标图中找到所有精确的匹配。不幸的是,这导致了一个np-完整的问题(Ullmann,1976;Cordella等人,2004年),它遭受着指数级的时间成本。为了降低计算成本,研究人员使用近似技术来寻找不精确的解(Mongiov`ı等人,2010;Yan等人,2005;Shang等人,2008),这产生次优匹配。另一种解决方案是将子图匹配作为监督学习问题(Bai等人,2019;Rex等人,2020;Bai等人,2020),利用图神经网络(GNNs)。然而,基于学习或基于gnn的方法主要旨在以黑盒的方式优化表示。由于缺乏理论保证,使它们无法解释,往往无法寻找精确的匹配子图。

为了解决上述挑战,我们提出了一个基于白盒gnn的解决方案,D2匹配,以利用深度gnn的效率和简和性进行子图匹配。通过严格的理论证明,我们在每个学习步骤中提供了可解释的结果。首先证明了在查询图与目标之间寻找匹配的节点可以退化,以检验基于这两个节点的对应子树是否与子树同构。这种退化允许我们检查在二部图上是否存在完美匹配,从而得到一个多项式时间复杂度解。上述两步将子图匹配转换为计算一个指标矩阵,该指标矩阵的元素表示查询图中节点与目标节点之间的子树同构关系。因此,基于co的子图匹配方法所需的匹配矩阵退化为寻找指标矩阵,该指标矩阵由gnn通过其固有的树状结构聚合机制计算。

请注意,这种实现直接通过gnn来对抗匹配机制,而不是像现有工作中那样优化gnn的表示。我们的实现允许我们减少完美匹配的时间成本从多项式时间到线性时间。此外,我们可以很容易地将其他信息,包括圆结构(抽象为超节点)和节点属性,合并到我们的D2匹配中,以提高匹配性能。

我们的贡献有四个方面: (1)我们提出了第一个基于白盒gnn的模型,称为D2匹配,以利用深度学习和简并性进行子图匹配。摘要给出了严格的理论证明,保证了子图匹配可以退化到子树匹配,最后在二部图上实现了完全匹配。(2)据我们所知,这是第一个直接处理基于gnn的子图匹配的模型,它将基于co的方法所需的匹配矩阵退化为gnn通过内在树结构聚合机制计算的指标矩阵。这允许我们在线性时间内计算指标矩阵。(3)我们的D2匹配可以很容易地包含其他信息,包括圆的结构和节点属性,以提高模型的性能。(4)大量的经验评估表明,D2Match的性能大大优于最先进的子图匹配方法,并发现基于学习的方法倾向于捕获数据分布的差异,而不是利用图结构。

2. Related work

子图匹配是为了检查查询图是否与目标图的子图同构(McCreesh et al.,2018)。在这里,我们主要介绍了三个相关的工作路线:

Combinatorial optimization (CO)-based methods

基于组合优化(CO)的方法首先只通过建模图结构来解决子图匹配(Ullmann,1976)。后来的一些工作开始促进图结构和节点属性(He & Singh,2008年;Shang等人,2008年;Han等人,2013年;Bhattarai等人,2019年)。这些组合优化方法通常依赖于回溯(Priestley & Ward,1994),即启发式地对查询和目标图中的每一对节点执行匹配。这种方法受到指数计算成本的影响。一种缓解的解决方案是采用不精确的匹配策略。早期的方法首先定义度量标准来度量查询图和目标图之间的相似性。连续的算法都遵循这一策略,并提出了更复杂的指标。例如,Mongiov`ı等人(2010)将图匹配问题转换为一个集覆盖问题,以获得一个多项式复杂度解。Yan等人(2005)引入了一种阈值化方法来过滤掉不匹配的图。Khan等人(2011)定义了一个基于邻域相似度的度量标准,并使用了一个信息传播模型来寻找相似的图。Kosinov & Caelli(2002)和Caelli & Kosinov(2004)对节点的特征空间进行对齐,并通过聚类将其投射到特征空间进行匹配。然而,由于计算成本高,这些算法大多无法扩展到大型图,而且它们手工制作的特性使它们难以推广到复杂的任务。

Learning-based methods

基于学习的方法通常计算查询图和目标图之间的相似性,例如,比较它们的嵌入向量。Bai等人(2019)采用gnn来学习图的表示,并使用神经张量网络来匹配图对的表示。一个直接的挑战是,单个图嵌入向量不能捕获子图同构的部分阶。因此,Rex等人(2020)训练了一个GNN模型来表示图,同时结合顺序嵌入来学习部分顺序。这些方法可以计算图级表示,实现了较高的计算效率。但是,它们错过了节点级的信息,这可能会丢失子图匹配中的关键细节。为了执行节点级匹配,有几种方法(Bai等人,2020;Li等人,2019)将节点级表示引入到问题中。这些方法通常采用不同的注意机制来产生成对的关系。然而,滥用注意机制使得该模型缺乏可解释性和理论保证。其他人将子图匹配问题转化为边缘匹配问题,并通过辛克霍恩算法得到的匹配矩阵生成预测结果(Roy et al.,2022),从而为模型提供了可解释性。然而,将节点匹配转化为边缘匹配的过程中,会丢失了必要的关于边缘关系的信息,如边的公共节点,这损害了模型的可表达性。

Graph Neural Networks (GNNs)

图神经网络(GNNs)是一种强大的技术(Xu等人,2019;Kipf & Welling,2017)在许多关键应用中取得了突破(Hhimlol等人,2017b)。图神经网络大多是迭代聚合信息,可以表示如下,

其中,f(·)是聚合函数,如mean或max;ϕ是更新函数。H (l)为表示矩阵,其第i行,用Hi:表示,为节点i的表示。在过去的几年里,在提出不同的聚合方式方面取得了相当大的进展。例如,GraphSAGE(Haimtonetal.,2017b)用平均/最大/LSTM合并的邻近信息聚合节点特征。图注意网络(GAT)(Velickovic et al.,2018)使用可学习的注意权重聚合邻居信息。子图匹配的一个密切的工作是图同构网络(GIN)(Xu et al.,2019),它基于韦斯费勒-雷曼(WL)测试将聚合转换为一个可学习的函数,以最大限度地提高GNNs的性能。然而,WL检验(Xu et al.,2019)不能解决子图匹配问题,因为它对树的结构进行了散列,并且忽略了子图匹配的部分阶信息。

3. Preliminary

我们据此定义了一些符号:设AQ和AT分别为查询图GQ和目标图GT的邻接矩阵。N(·)表示给定节点或给定节点集的邻居集。|·|表示一个集合的基数。Tv (l)定义了根为v的子树,并扩展到v的l-deph(或子树)的l跳邻居。在本文中,l跳邻居和l-深度子树的概念是可互换的。

问题定义:假设我们得到一个查询图GQ(VQ,EQ)和一个目标图GT(VT,ET)。这里,(VQ、EQ)和(VT、ET)分别是与查询图和目标图相关的顶点和边的对。查询图和目标图的节点属性分别记为XQ∈R|VQ|×D和XT∈R|VT|×D,其中D为节点属性的维数。子图匹配的问题是确定查询图GQ是否与目标图GT同构,即是否存在单射ξ: VQ→VT,使∀u,v∈VQ,(u,v)∈EQ⇔(ξ(u),ξ(v))∈ET。

内射可以用匹配矩阵S∈{0,1}|VT|×|VQ|表示,其中当且仅当节点对(i,j)匹配时,即ξ(j) = i。因此,子图的同构等价于检验该矩阵S的存在性,即,是否存在赋值分配矩阵S:

如果GQ是GT的一个子图,则我们表示GQ⊂GT。在这里,我们首先定义了几个关键的概念:

WL子树:维斯费勒-雷曼(WL)检验是具有线性计算复杂度的图同构问题的近似解(Shervashidze et al.,2011)。WL测试递归地对节点的标签及其邻域进行聚合,然后将聚合的结果散列为唯一的新标签。因此,这个测试为每个节点生成一个无序的树,称为WL子树,它是一个具有迭代次数高度的平衡树。重复算法k次后,得到的一个节点的WL子树包含了来自该节点的k-hop子图的结构信息。研究表明,具有信息传递机制的gnn的表达性是WL检验的上限(Xu et al.,2019)。

子树生成:对于图中的任何节点v,都可以通过取v的l-hop邻域得到一个子图子(v l)。给定任何一种树的生成方法,例如WL子树,我们总是得到其对应的子树,其根为v:

其中,Ψ是一个子树生成函数。除非另有说明,由于给定节点的唯一性,我们使用WL子树为该节点生成子树(Xu et al.,2018)。我们不是显式地构建这样的树,而是在图中运行gnn,因为构建一个k阶WL子树相当于在gnn中聚合k次(Xu et al.,2018)。请注意,传统的方法,如宽度优先搜索(BFS)和深度优先搜索(DFS)并不适用于本工作,因为它们不满足唯一性属性。特别是,BFS或DFS为同一节点生成的树会由于搜索顺序的不同而有所不同。

二部图中的完美匹配:完美匹配(Gibbons,1985)是一个图的一个被选择的边集,其中图的每个节点都恰好指向一条边。因此,根据边集,图中的每个节点只对应于另一个节点。在二部图上的完全匹配的存在性可以通过霍尔的婚姻定理(Hall,1935)来解决。

定理3.1。(霍尔的婚姻定理)给出一个二部图,B(X,Y,E),该图有两个分区:X和Y和|Y |≤|X|,其中E表示边。B(X,Y,E)中完美匹配存在的充要条件是: ∀ W⊆Y,|W|≤|N (W)|,其中N (W)是由N (W) = {bj∈X:∃ai∈W,(ai,bj)∈E)定义的W的邻域。

4. The Proposed Method

在下面,我们提出了我们提出的d2匹配与理论推导及其扩展。

4.1. Subgraph Matching Degeneracy

我们从退化的角度来处理子图匹配问题,并将此问题框架为一个具有线性复杂度的子树匹配问题。子图匹配问题的一个基本问题是,在什么条件下,一个子图与另一个子图是同构的。由于子图匹配问题是np完备的,因此对这个问题的确切答案变得不切实际。相反,我们可以将寻找充分条件和必要条件的答案简化为只有必要条件的答案。下面是构造一个任何同构对都能满足的准则。

子树同构是子图同构的一项特殊任务,可以在多项式时间内得到。在这里,我们的目标是将子图的同构问题简化为一个子树的同构问题。灵感来自徐et al.(2019),我们构建一个标准通过检查子树根节点:如果GQGT的子图,那么树根在任何节点的GQ应该是一个子树的树根匹配节点t = ξ(q)。如下面的定理所述,这些树需要一些额外的性质来使这个准则成立:

定理4.1。给定一个目标图GT(VT,ET)和一个查询图GQ(VQ,EQ),如果GQ⊂GT,以及在等式中定义的子树生成函数Ψ(3)满足以下条件:

然后子图同构映射ξ: VQ→VT保证了子图的l-depth子树与对应子图的子树同构:

请在附录A.1中找到证明。该定理提供了势同构对的一个必要条件。有了这个定理,给定一个查询图GQ和一个目标图GT,只有当Tq (l)⊂Tt (l)时,GQ中的节点q才能匹配GT中的节点t。然后变成一个同构检验,它检查是否存在一个赋值,使GQ中的每个节点q可能对应于GT中的一个唯一节点t。形成一个布尔指示器矩阵S (l)∈R|VT|×|VQ|:

我们得到了检查指标矩阵S (l)是否包含一个有效的赋值矩阵S是否满足等式 (2).

由于唯一性的优点,我们使用WL子树作为生成函数。下面是如何确定l阶树之间的子树同构关系。具体来说,我们基于WL子树的生成,迭代求解子树匹配问题,希望在每次迭代中找到一个二部图上的完美匹配。以下定理保证了该转换:

定理4.2。给定查询图中的一个节点q和目标图中的一个节点t,以下三个条件是等价的:

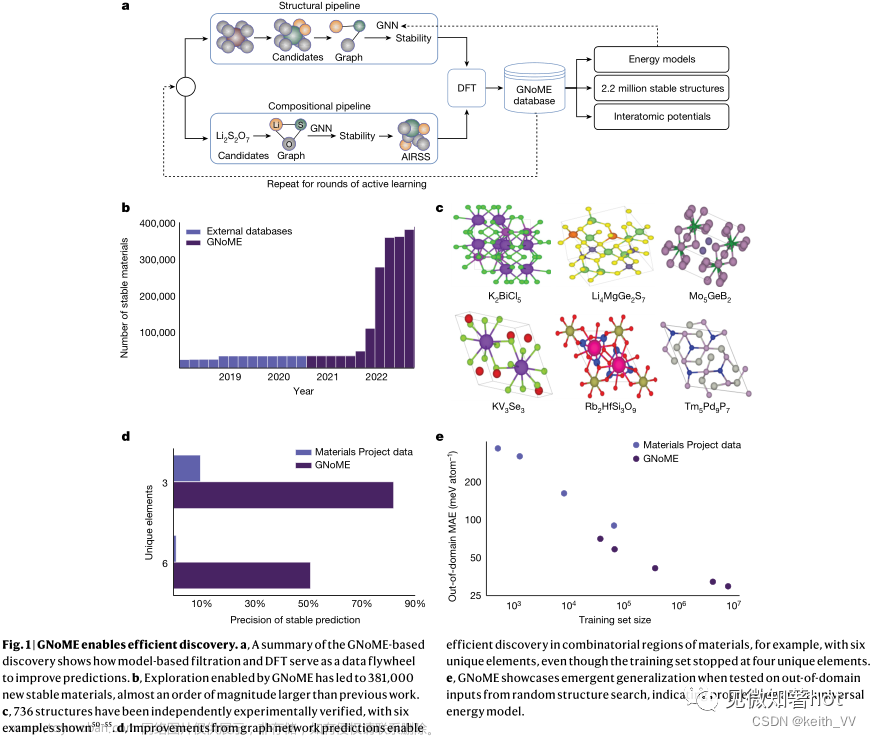

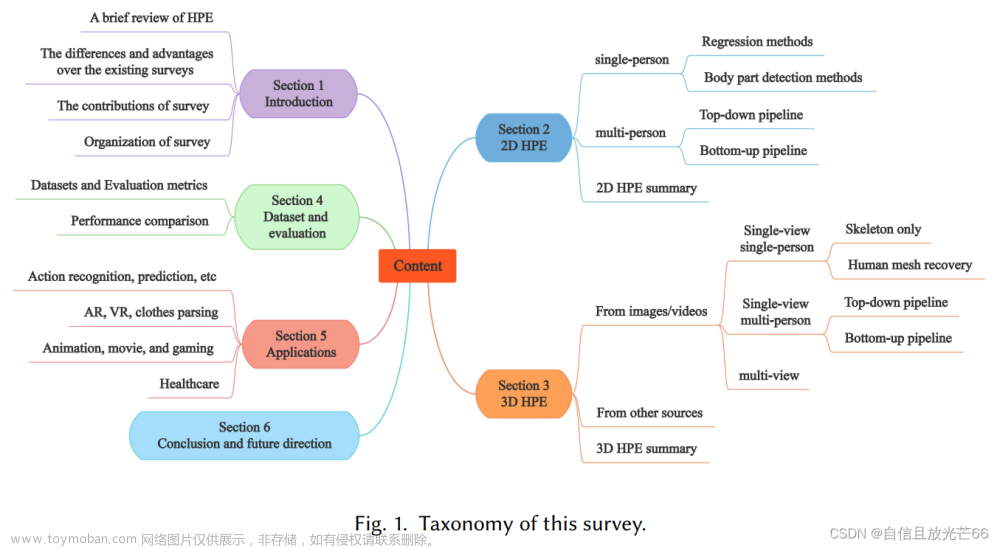

证明内容见附录A.2。前两个条件的等价性意味着,匹配一对节点的子树等价于匹配来自其子节点的所有子树。因此,可以递归地更新指标矩阵。即,指标矩阵在(l+1)层,即S(l+1),应依赖于S (l)。同时,最后两个条件的等价性意味着,将这些子节点的子树匹配等价于对对应的二部图的节点代表子节点的子树的完美匹配。总之,定理4.2告诉我们,子图匹配等价于在二部图上提供完美匹配。该过程的可视化过程如图1所示。

图1.提出的子图匹配的退化过程说明:查询图中的节点a‘是否与目标1中的节点a匹配的问题会退化,以检查根于节点a和a’的构造的(l+1)深度子树的子树是否同构。这对应于步骤(2),并由定理4.1得到保证。该过程是检查T(l+1)a和T(l+1)a‘是否是子树同构的。如步骤(3)所示,并由定理4.2中的条件1和2保证,这相当于检查N (a)中基于N(a‘)的每个l-depth子树的子树是否同构,其中N(·)是给定节点的邻居集。然后,根据定理4.2中的条件2和条件3,子树的同构问题等价于检验每个分别基于N(a‘)和N (a)的l-depth子树的二部图上是否存在完全匹配。这对应于步骤(4),其中上面的部分表示所构造的二部图,下面的部分是它的邻接矩阵。通过运行霍尔的婚姻算法,我们可以确定完美的匹配,其中被选择的边用蓝色区域突出显示。该指示矩阵的计算过程通过gnn上的内在树结构聚合机制实现,在定理4.3中得到了证明,并保证了所分析的线性时间代价。4.3.

基于霍尔的婚姻定理3.1,我们开发了一个有效的算法来解决完美的匹配过程。一个简单的解决方案是从B (l)(N (t),N (q),E)的较小分区中随机选择一个子集W,即W⊆N (q),并计算W的邻居(即N (W)⊆N (t)是否比W有更多的元素。重复这个过程多次,我们得到一个完美的匹配,当没有实例违反标准。注意,我们对所有可能匹配的节点对执行这个过程。

是否有可能并行地执行所有的成对?幸运的是,我们可以借用gnn来完成完美的匹配。具体来说,当计算节点q∈GQ和节点t∈GT之间的完美匹配时,需要根据定理3.1找到W,使其满足W⊆N (q)。在实践中,我们可以通过对节点q的邻居进行采样,相当于对边缘进行采样,或下降边操作(Haimltonetal.,2017a)。这样,我们从查询图GQ中得到一个采样图˜GQ,以及它的邻接矩阵˜AQ。根据定理3.1,我们得出W=N(q)和N‘(q)⊂N (q),因为˜GQ中节点q的邻居是原始图的子集。在每次迭代中,我们将执行计数w.r.t.W及其邻居集N (W)对于每个节点对(t,q),并检查|N (W)|≥|W|是否成立。为了有效地实现,我们定义了一个二进制矩阵Φ(l)(˜AQ,AT)∈R|VT|×|VQ|,其中其元素(t,q)对应于采样查询图˜GQ和目标图GT之间的节点对(t,q)的结果。基于定理4.1,我们需要递归地更新指标矩阵S (l),其中我们计算了使用多个采样的˜GQ的Φ(l)(˜AQ,AT)。接下来,我们证明了计算Φ等同于在任何给定的S (l)的相关图上执行基于gnn的聚合。

定理4.3。给定采样查询图和目标图,我们可以构造它们的邻接矩阵˜AQ和AT,以及采样查询图˜DQ=diag(Ps((˜AQ):s))的度矩阵。在这里,我们将第1个跳处的指标矩阵表示为S (l)。为了检查|N (W)|≥|W|对每个节点对的有效性,我们可以检查Φ(l+1)(˜AQ,AT)的每个元素是否正确,其中Φ(l+1)(˜AQ,AT):=ZN(W)≥1,ZN (W) = AGGsum(AT,ZT W)和ZW = AGGmax(˜D−1Q·˜AQ,(S(l))T)。

证明内容见附录A.5。回顾定理3.1,我们需要检查每个节点对(t,q)的|N (W)|≥|W|,即,检查每个Φ元素对于每一个采样的每个˜A(k)q是否为真。该条件只有当Φ对每个样本为真时才有效,即˜G(k)Q。因此,我们可以通过以下元素级的乘积来检验该标准:

其中,o表示矩阵之间的元素级乘法。在实践中,Φ(l+1)(˜A(k)Q,AT)考虑了三种情况:

以上三种情况使我们能够平衡计算成本和准确性。最初,当k=值为0时,我们对所有节点进行全尺寸采样,以避免感应偏差。当k = K时,我们执行单节点采样,这样不省略节点。k∈[1,K−1]的情况是通过降采样计算的。

我们想强调我们的方法和其他基于学习的gnn方法之间的区别。在这里,我们使用一个GNN模型来完成子树匹配的过程,以及理论等价性。与在我们的模型中执行匹配不同,基于学习的模型使用gnn来捕获数据分布的方差,用于相似推理,因为深度学习模型学习分布信息来区分来自不同类别的样本。

4.2. Boosting the Matching

值得注意的是,我们的d2匹配不能保证所有的同构对都被精确地选择。为了提高模型的性能,下面我们设计了相应的机制,以包含更多的信息,即圆的结构和节点属性,以获得更精确的同构对。

4.2.1. DEALING WITH CIRCLES

以前的方法通常忽略圆结构,尽管它们在图中很常见,而且处理至关重要。特别是,基于学习的方法依赖于gnn的表达性,由于其类似wl树的聚集机制,gnn难以识别循环结构(Sato,2020)。我们的D2匹配的基本思想是选择特定的圆集,并构造圆的结构作为超节点。这允许我们将圆匹配表示为一个标准的子树匹配问题。在详细说明我们的策略之前,我们首先在图中给出所选的圆集的两个期望属性。

原子:设c =(v1,…,vl ©,v1)定义一个圆,v ©为圆c的节点集,如果一个圆不包含一个较小的圆,那么这个圆就是一个原子圆。也就是说,没有圆c‘,使v(c’)⊂v ©.如果集合中的每个圆都是原子的,那么圆集合C就是原子的。

一致性:如果查询图是目标图的子图,则每个查询图必须对应目标图中的一个圆,即∀cQ=(v1,…,v1)∈CQ,∃CT=(ξ(ξv1),…,ξ(v1),ξ(v1))∈CT,其中ξ是子图同构映射。CQ和CT分别是查询图和目标图的所选择的圆集。

原子属性旨在确保圆的紧致性,而一致性试图确保查询和目标圆集之间的关系是内射的。这两个属性确保了一个质量良好的匹配集。在实践中,我们可以利用无弦循环(West,2000),来服务于我们匹配圆圈的目标。我们现在在下面陈述我们的定理,以证明这些循环满足上述的一致性和原子性质。

定理4.4。每一个无弦的循环都是原子的。原始查询图GQ的诱导子图中的每个无弦循环cQ必须对应于原点图GT中的一个无弦循环cT。

证明内容见附录,A.6。这个定理表明,无弦环满足上述两个性质,使它们适合于表示图中的圆。为了匹配圆,我们通过插入包含这些圆的超节点来引入一个增广图。给定长度为L,我们可以获得相应的长度不超过L的查询和目标图为:CT={|©≤L,∈CCT},CQ={|©≤L,∈CCQ},其中CCT和CCQ是无弦周期集。通过将vc设置为任何无弦圆c的超节点,我们将圆c中的节点连接到这个超节点,从而得到一个增广图。请注意,超节点只能匹配其他超节点,以保持非圆的匹配不受污染。为此,我们将圆匹配变换为子树匹配问题,使该方法可以直接应用于增广图上。除非另有说明,否则我们在增广图中保持所有符号相同,以避免滥用符号。

4.2.2. DEALING WITH NODES’ ATTRIBUTES

除了圆的结构外,子图匹配还涉及到节点属性。在子图匹配的上下文中,仅使用节点属性进行学习可能会产生误导,因为它们不能捕获结构同构。因此,我们利用得到的子树指标矩阵来监督学习过程,目的是过滤掉在子树匹配中没有通过测试的对。因此,我们有动力通过联系子树匹配指示符,导致查询图和目标图的节点表示如下:

在这里,我们使用了一个MLP模型来减少节点属性和指标矩阵之间的差异的影响,其中后者表现为一个单热编码特性。我们将每对表示连接起来,然后将其传递给MLP以获得它们的相似性。对于节点对(i,j),我们将它们的相似性计算为

现在,我们得到了一个同时包含结构信息和节点属性信息的广义指标矩阵

4.3. Implementation Details and Complexity Analysis

我们总结了在附录A.1中概述的算法1中的整个过程。我们现在分析我们的D2匹配的时间成本。值得注意的是,我们的D2匹配由两个主要部分组成:子树模块和GNN模块。给定L层和K次采样,子树模块和GNN模块的复杂度为O(L∗K∗|VT |∗|EQ| + L∗|VQ|∗|ET|)(根据Algo中第4-9行的计算。1)

和O(L∗|ET | + L∗|EQ| + |VT |∗|VQ|)(根据Algo中第10-12行的计算。1),分别。由于查询图通常非常小,所以我们可以将|VQ|和|EQ|视为常量。因此,整体复杂度降低到O(|VT | + |ET |),达到线性时间复杂度。有关实施的更多细节,请参见附录A.3。我们还在附录A.7中提供了一个经验性的运行时比较。

5. Experiments

在这里,我们进行了广泛的实验来解决以下问题: (1)与基于SOTA gnn的方法相比,我们的D2匹配表现如何?(2)为什么我们的D2匹配比其他基于gnn的方法工作得更好?(3)与基于启发式协同的协同方法相比,我们的D2匹配表现如何?(4)我们的d2匹配对超参数的影响是什么?(5)我们的d2匹配的收敛行为是什么?5.2-5.6节相应地回答上述问题

5.1. Experimental Settings

数据集和实验设置。我们在合成数据集和真实数据集上实现了我们的实验,这些数据集是从各种应用程序中收集来的。我们的目标是获取查询图对和目标图对,以及指示查询是否与目标同构的标签。我们首先利用er-随机图和ws-随机图生成合成数据(Rex et al.,2020)。我们在正样本和负样本中保持边缘密度相同,以确保分布的一致性。这种平衡避免了在学习过程中潜在的偏见。对于真实世界的数据,我们遵循(Rex等人,2020年)中的设置,包括Cox2、酶、蛋白质、IMDB-Binary、MUTAG、Aids和FirstMMDB。其他实验请参考附录A.9,如开放图基准数据集(Hu et al.,2020)。

我们使用这些原始图作为目标图,并使用从目标图中随机宽度优先搜索抽样来生成正查询图。负的查询图是随机生成的。与合成数据相似,我们要求正样本和负样本的边缘密度尽可能接近。我们以4: 1的比例将每个数据集分为训练和测试,并报告五倍交叉验证下的平均分类精度。

基线为了进行公平的比较,我们选择了以下基于SOTA gnn的竞争对手: SimGNN(Bai等人,2019年),神经匹配(Rex等人,2020年)、IsoNet(Roy等人,2022年)、GMN-嵌入(Li等人,2019年)、GraphSim(Bai等人,2020年)和GOT-Sim(Doan等人,2021年)。这些都将图神经网络纳入到子图匹配中。对于组合优化指标,我们选择了GQL(He&Singh,2008年)、QSI(Shang等人,2008年)、CECI(巴塔莱等人,2019年)和集交集方法LFTJ(Sun&Luo,2020年)。这些都是可以找到精确解的传统方法。

5.2. Main Results

表1报告了所有比较模型的总体性能,其中每个模型在所有可能的设置中都达到了多达500个时期的最佳结果。firsitMMDB上GOTSim和IsoNet的准确性由于时间和内存过长而被省略。我们观察到

对于合成数据集,总体性能远低于真实数据集。其中一个原因是,合成的数据集比真实世界的数据集更复杂,例如,具有更高的边缘密度,这使得匹配更具挑战性。通过检查更多的细节,IsoNet、GMN-embed、GraphSim和GOTSim尝试使用节点级分配矩阵来捕获图之间的匹配,这低估了全局结构的重要性。它们只能产生50%左右的准确率。SimGNN和NeuroMatch试图学习全局表示,并分别达到70.5%和65.7%的准确率。

对于真实世界的数据集,D2匹配获得了优越的性能,并击败了所有的基线。在7个真实世界的数据集中,D2匹配在蛋白质、Mutag、Cox2和FirstMMDB等4个数据集中达到100%的准确率,而在酶和艾滋病中至少达到99.5%,在IMDB-Binary中至少达到93.3%。

总的来说,D2Match已经明确地建模了子树,并在所有比较的方法中始终获得了最好的性能。这些有希望的结果证实了我们的理论分析。

5.3. Benefit of Our Core Design: The Subtree Matching

下面的实验验证了在现有的基于gnn的子图匹配方法中,部署在我们的gnn匹配中的功能如何不同。也就是说,我们的D2Match利用GNNs显式地建模子树,而现有的方法通过记忆数据分布的差异来优化图的表示。此外,我们还构建了新的数据集,并用∗来表示它们。新的数据集通过以下步骤排除了数据分布效应:按照与Sec5.1中相同的方法生成正样本。继续对剪切的图进行边删除和插入,得到最终的负样本。该策略旨在确保生成的样本在边缘方面遵循几乎相同的分布。对于合成数据集,假设原始数据集中的正负数据是随机生成的,并且遵循相同的分布,我们构建了另一个合成数据集,而不遵循相同的密度分布比较由于SimGNN和NeuoMatch是表1中表现最好的基于gnn的方法,因此我们将我们的D2匹配与它们进行了比较。

表2的结果显示,D2Match明显优于SimGNN和NeuoMatch,提高了2.5%的−33.2%。这一现象与我们的假设一致,即其他基于学习的方法的增益是依赖于分布的,这导致均匀分布数据的性能显著下降。此外,合成+的整体性能远远优于合成+。这意味着遵循非均匀分布的数据将使匹配更加容易。这与表1中的结果一致,即基于gnn的方法倾向于捕获分布差异,而不是执行匹配。

5.4. Comparison with exact combinatorial solutions

在详细比较D2Match和基于协同的方法之间的方法之前,我们想强调的是,我们的方法和基于协同的启发式是由不同的目的驱动的,因此适用于不同的场景。启发式算法可以找到精确的解,但最坏情况下的时间复杂度是指数级的,它们通常适用于具有高匹配精度要求的场景,如图数据库。我们的方法适用于有时间约束的高效机器学习任务。为了验证我们的方法的优点,我们从三个角度进行了比较:

解时间:由于启发式算法可以找到精确的解,因此精度的度量不再可区分。因此,我们主要比较了我们的算法和启发式算法在原始数据集上的平均运行时间。我们报告了我们的方法和启发式算法在测试集上的平均运行时间,如表3所示。结果表明,我们的方法不仅具有持续稳定的运行时间,而且在大多数数据集上也比启发式算法要快得多,通常是一个数量级。

解决方案效率:为了比较不同解决方案的效率,我们比较了启发式求解器的成功率与我们的方法的准确性,如表4所示。成功率定义为算法在原始数据集上每个样本在10秒内完成的样本的比例。考虑到执行时间的限制,我们的方法的准确性和启发式方法的成功率与对大多数真实数据集的基于启发式算法的成功率相当。

可伸缩性:为了验证我们的模型的可伸缩性,我们使用更大的数据集进行了实验。具体来说,我们使用了由50,000个节点组成的“第一个毫米”数据集和由300,000个节点组成的“DD”数据集还有100万个边。我们将我们的方法与这些数据集在运行时和成功率方面进行了比较。如表5所示,我们的方法在大规模图上比启发式算法具有更好的效率。在DD数据集上,我们的方法达到了接近100%的准确率。在第一个mm数据集上,我们的方法的准确率相对较低,但它可与一些启发式算法相媲美。这些结果表明,我们的方法是可扩展的。

此外,我们还包括了我们的启发式方法在具有不同节点数的合成数据集上的成功率。这证明了我们的方法在合成数据上的可伸缩性,如表6所示。一般来说,启发式方法的成功率随着规模的增加而迅速降低。然而,我们的方法始终保持着70%左右的准确率。

5.5. Sensitivity Analysis

L的影响,一个子树的深度。我们测试了一个子树的深度的影响,即隐藏层的数量,并将其从1更改为7。图2(a)的结果显示,当层数为6时,D2Match的性能最好。D2Match只需要几个层就可以获得良好的性能,这表明它可以扩展到大型图。

K的影响,样品的次数。直观地说,采样更多的数据来训练模型将产生更好的性能。我们将K从1变化到7,结果如图2(b).所示令人惊讶的是,结果表明,通过采样5次,我们可以在所有数据集上获得最好的性能。这表明D2匹配可以以较低的计算成本获得良好的性能。

我们还使用圆和节点属性在不同的设置下,所有实验结果与我们的理论分析一致。详见附录A.5。

5.6. Convergence Analysis

图2©提供了D2Match的训练损失和合成上的四个基线,其中我们只选择与我们具有相同损失函数的基线,如MSE或CE,以进行公平的比较。结果表明,(1) D2Match能够对子树进行明确的建模,因此收敛能力最快。(2) NeuroMatch和SimGNN通过学习图级表示进行匹配,需要更多的时代来收敛来捕获局部结构。(3) GOTSim和GraphSim在开始时获得最低的损失,但与其他的相比表现出最弱的收敛能力,因为它们只能捕获节点级表示,无法学习有意义的子图匹配。因此,它们产生了最差的性能,如表1所报告的最差。

6. Conclusion and Future work

本文提出了用于子图匹配的d2匹配,将子图匹配问题分解为二部图中的完美匹配,并证明了匹配过程可以通过gnn上的树结构聚合来实现,从而产生线性时间复杂度。我们还结合了圆结构和节点属性来提高匹配性能。最后,我们进行了大量的实验,表明D2Match比竞争基线取得了显著的改进,并且确实利用了子树进行匹配,这与现有的基于gnn的数据分布差异记忆方法不同。

D2匹配可以在几个有前途的方向上进一步探索。首先,我们可以研究更多的简并性机制来处理更复杂的图。其次,我们可以利用其他信息,如位置编码,来提高模型的性能。第三,我们可以将我们的D2匹配扩展到更真实世界的应用程序,例如,文档匹配,以研究其能力。文章来源:https://www.toymoban.com/news/detail-772699.html

7. Acknowledgement

工作充分支持的想法信息和超级计算中心(ISCC)和部分支持国家自然科学基金(没有62201576),国家重点研发计划(2020YFB1708200号),“图神经网络项目”平安科技有限公司(深圳)有限公司和矿工。深圳SciBain基金。文章来源地址https://www.toymoban.com/news/detail-772699.html

到了这里,关于【论文阅读】D2Match: Leveraging Deep Learning and Degeneracy for Subgraph Matching的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!