深度学习

必备的数学知识

概率论

我们将接着上一篇文章继续讲解。

条件概率

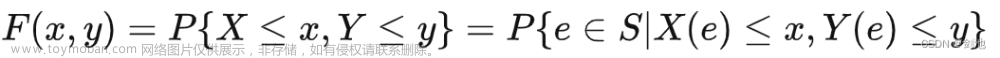

大家还记得上一篇文章的提到的联合概率分布吗?定义在一组变量的联合概率分布的子集上的概率分布被称为边缘概率分布(marginal probability distribution)。

对于离散型随机变量x和y,如果我们有

P

(

x

,

y

)

P(x,y)

P(x,y),则可以根据以下求和法则(sum rule)来计算

P

(

x

)

P(x)

P(x)

∀

x

∈

x

,

P

(

x

=

x

)

=

∑

y

P

(

x

=

x

,

y

=

y

)

\forall x \in x,P(x=x)=\sum_{y}P(x=x,y=y)

∀x∈x,P(x=x)=y∑P(x=x,y=y)

例如,假设我们有两个离散随机变量

x

x

x和

y

y

y,它们的可能值分别为

x

=

1

,

2

x = {1, 2}

x=1,2和

y

=

a

,

b

y = {a, b}

y=a,b。假设我们知道以下联合概率:

-

P ( x = 1 , y = a ) = 0.1 P(x=1, y=a) = 0.1 P(x=1,y=a)=0.1

-

P ( x = 1 , y = b ) = 0.2 P(x=1, y=b) = 0.2 P(x=1,y=b)=0.2

-

P ( x = 2 , y = a ) = 0.3 P(x=2, y=a) = 0.3 P(x=2,y=a)=0.3

-

P ( x = 2 , y = b ) = 0.4 P(x=2, y=b) = 0.4 P(x=2,y=b)=0.4

那么我们可以通过对所有可能的 y y y值求和来计算 x x x取特定值的概率: -

P ( x = 1 ) = P ( x = 1 , y = a ) + P ( x = 1 , y = b ) = 0.1 + 0.2 = 0.3 P(x=1) = P(x=1, y=a) + P(x=1, y=b) = 0.1 + 0.2 = 0.3 P(x=1)=P(x=1,y=a)+P(x=1,y=b)=0.1+0.2=0.3

-

P ( x = 2 ) = P ( x = 2 , y = a ) + P ( x = 2 , y = b ) = 0.3 + 0.4 = 0.7 P(x=2) = P(x=2, y=a) + P(x=2, y=b) = 0.3 + 0.4 = 0.7 P(x=2)=P(x=2,y=a)+P(x=2,y=b)=0.3+0.4=0.7

这就是如何使用这个公式来计算概率的一个例子。

对于连续性随机变量,通过对联合概率求积分来计算

P

(

x

)

P(x)

P(x)

P

(

x

)

=

∫

P

(

x

,

y

)

d

y

P(x)=\int P(x,y)dy

P(x)=∫P(x,y)dy

条件概率

条件概率指的是某件事在给定的其他事件发生时出现的概率。我们将当x=x时,y=y发生的概率记作

P

(

y

=

y

∣

x

=

x

)

P(y=y|x=x)

P(y=y∣x=x)。条件概率可以通过以下公式计算

P

(

y

=

y

∣

x

=

x

)

=

P

(

y

=

y

,

x

=

x

)

P

(

x

=

x

)

P(y=y|x=x)=\frac{P(y=y,x=x)}{P(x=x)}

P(y=y∣x=x)=P(x=x)P(y=y,x=x)

需要注意的是,条件概率只有在

P

(

x

=

x

)

>

0

P(x=x)>0

P(x=x)>0时才有定义,也就是说,我们不能计算在某个肯定不会发生的事件的条件下另一事件发生的概率

注意条件概率说的不是某件事发生后会发生什么。假定一个人拿着车钥匙出门,那么他开车的概率很高,但是让一个人拿车钥匙他的出行方式不会改变。

条件概率的链式法则

概率的链式法则(chain rule)(也称为乘法法则)是一种用于计算多个随机变量的联合概率的方法。对于两个随机变量 x x x和 y y y,链式法则可以写作:

P ( x = x , y = y ) = P ( x = x ) ⋅ P ( y = y ∣ x = x ) P(x=x, y=y) = P(x=x) \cdot P(y=y|x=x) P(x=x,y=y)=P(x=x)⋅P(y=y∣x=x)

这个公式表示 x = x x=x x=x和 y = y y=y y=y同时发生的概率等于 x = x x=x x=x发生的概率乘以在 x = x x=x x=x的条件下 y = y y=y y=y发生的概率。

相信大家已经看出来了,这是从关系概率的公式推导而来的。

P

(

y

=

y

∣

x

=

x

)

=

P

(

y

=

y

,

x

=

x

)

P

(

x

=

x

)

P

(

x

=

x

)

⋅

P

(

y

=

y

∣

x

=

x

)

=

P

(

y

=

y

,

x

=

x

)

P

(

x

=

x

)

⋅

P

(

x

=

x

)

P

(

y

=

y

,

x

=

x

)

=

P

(

x

=

x

)

⋅

P

(

y

=

y

∣

x

=

x

)

P(y=y|x=x)=\frac{P(y=y,x=x)}{P(x=x)}\\ P(x=x) \cdot P(y=y|x=x)=\frac{P(y=y,x=x)}{P(x=x)} \cdot P(x=x)\\ P(y=y,x=x)= P(x=x) \cdot P(y=y|x=x)

P(y=y∣x=x)=P(x=x)P(y=y,x=x)P(x=x)⋅P(y=y∣x=x)=P(x=x)P(y=y,x=x)⋅P(x=x)P(y=y,x=x)=P(x=x)⋅P(y=y∣x=x)

链式法则可以扩展到更多的随机变量

P

(

x

(

1

)

,

x

(

2

)

,

.

.

.

,

x

(

n

)

)

=

P

(

x

1

)

∏

i

n

P

(

x

(

i

)

∣

x

1

,

.

.

.

,

x

(

i

−

1

)

)

P(x^{(1)},x^{(2)},...,x^{(n)})=P(x^{1})\prod^{n}_{i}P(x^{(i)}|x^{1},...,x^{(i-1)})

P(x(1),x(2),...,x(n))=P(x1)i∏nP(x(i)∣x1,...,x(i−1))

独立性和条件独立性

我们称两个随机变量相互独立的(independent),这意味着它的联合概率分布等于它们各自的概率分布的乘积,知道

x

x

x的值并不会改变

y

y

y的概率分布,反之亦然。

∀

x

∈

x

,

y

∈

y

P

(

x

=

x

,

y

=

y

)

=

P

(

x

=

x

)

⋅

P

(

y

=

y

)

\forall x \in x,y \in y P(x=x,y=y)=P(x=x) \cdot P(y=y)

∀x∈x,y∈yP(x=x,y=y)=P(x=x)⋅P(y=y)文章来源:https://www.toymoban.com/news/detail-773354.html

如果在给定随机变量z=z的条件下,随机变量x和y是独立的,我们就说x和y在z=z的条件下是条件独立的conditionally independent)。换句话说,对于x和y的条件概率分布对于z的每一个值都可以写成乘积的形式。用公式表示为:

∀

x

∈

X

,

y

∈

Y

,

z

∈

Z

,

P

(

X

=

x

,

Y

=

y

∣

Z

=

z

)

=

P

(

X

=

x

∣

Z

=

z

)

⋅

P

(

Y

=

y

∣

Z

=

z

)

\forall x \in X, y \in Y, z \in Z, P(X=x, Y=y|Z=z) = P(X=x|Z=z) \cdot P(Y=y|Z=z)

∀x∈X,y∈Y,z∈Z,P(X=x,Y=y∣Z=z)=P(X=x∣Z=z)⋅P(Y=y∣Z=z)文章来源地址https://www.toymoban.com/news/detail-773354.html

到了这里,关于深度学习-必备的数学知识-概率论3的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!