目录

一、安装Nvidia Docker

二、安装显卡驱动

1、安装驱动

2、检查显卡驱动版本

3、查询驱动版本和显卡相关信息

三、Docker hub安装pytorch和对应版本cuda

1、在Docker hub中查询对应版本镜像

编辑2、查询pytorch/pytorch的镜像

3、devel版本和runtime版本的区别

4、拉取对应版本镜像

5、查看拉取完成的镜像

6、生成容器

四、进入容器并查询相关信息

1、进入容器

2、打印环境变量

3、查询本地安装的软件和程序

4、显示NVIDIA CUDA 编译器(nvcc)的版本信息

前期因为要安装东西需要cuda10+的环境,查了部分资料发现对这方面的介绍不是很详细,所以结合前期整理的笔记,写一个比较详细的纯小白教程。

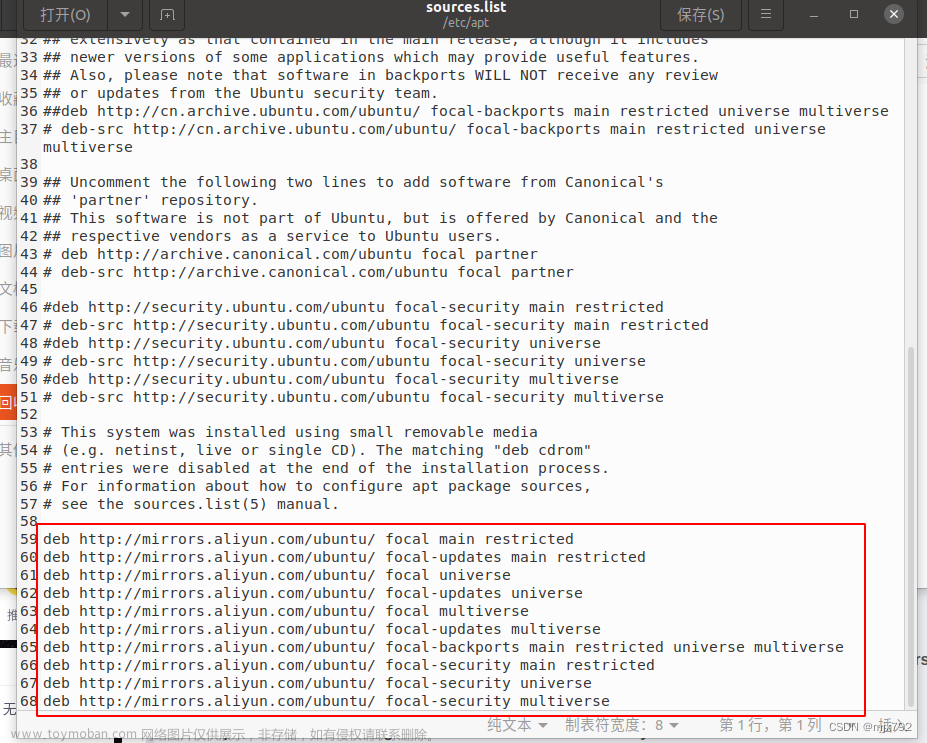

还要特别注意的是:此版本为Ubuntu20.04,默认的python版本为3.10。

一、安装Nvidia Docker

可以直接参考另一篇教程Ubuntu20.04 Nvidia Docker 安装-CSDN博客,写的很详细。

注意安装完毕后再进行下一步。

二、安装显卡驱动

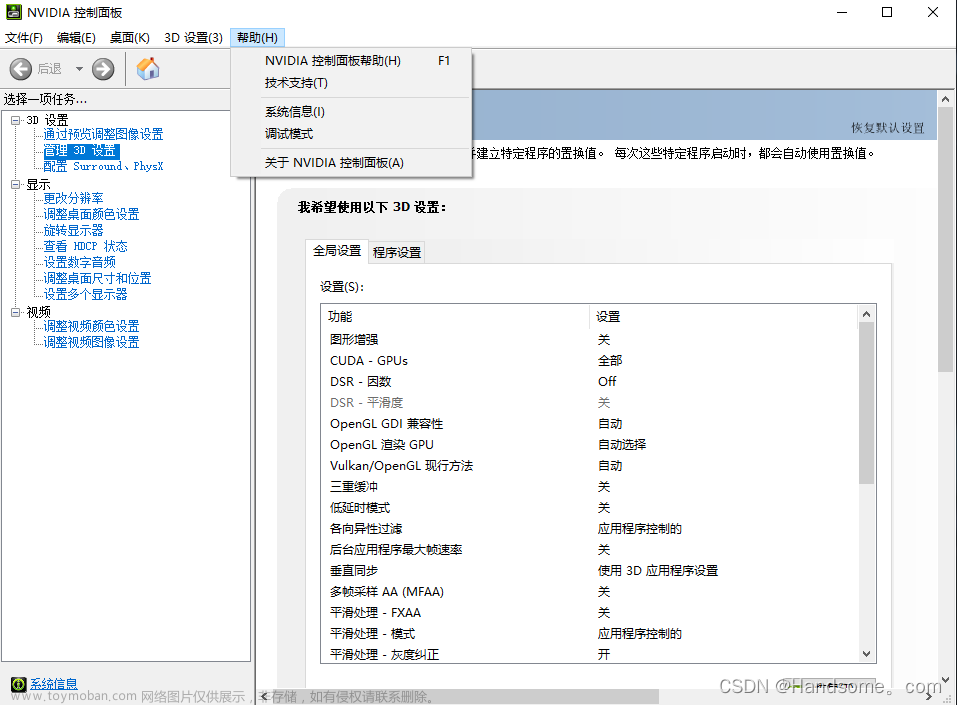

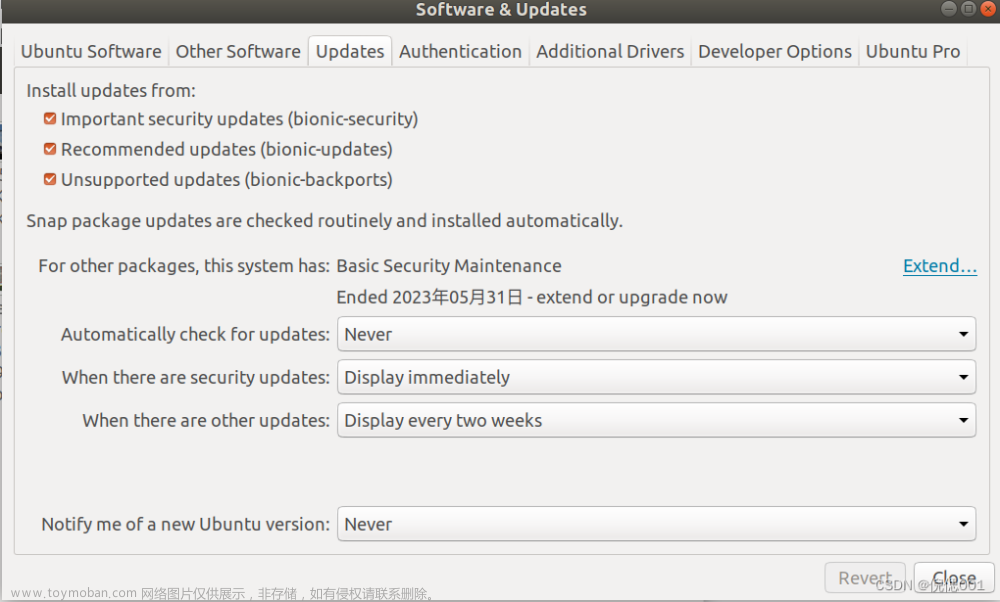

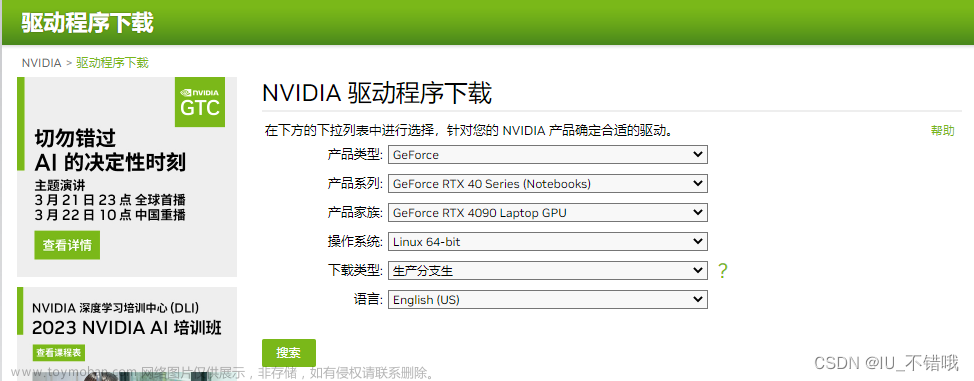

1、安装驱动

sudo apt list nvidia-driver*2、检查显卡驱动版本

lspci -k | grep -A 2 -i "VGA"将输出当前主机的显卡驱动版本和驱动程序的详细版本。

3、查询驱动版本和显卡相关信息

nvidia-smi

提示当前系统中的信息:

-

显卡信息:显示系统中安装的 NVIDIA 显卡的详细信息,包括显卡型号、设备ID、总线ID等。

-

驱动程序版本:显示当前系统中所使用的 NVIDIA 显卡驱动程序的版本号。

-

GPU使用情况:显示每个显卡的使用情况,包括GPU利用率、显存使用情况、温度、风扇转速等。

-

进程信息:显示正在使用显卡资源的进程列表,包括进程ID、进程名称、GPU使用情况等。

-

其他相关信息:还会显示一些其他的诊断信息,如显卡电源状态、PCIe链接状态等。

三、Docker hub安装pytorch和对应版本cuda

显卡驱动安装成功后:

1、在Docker hub中查询对应版本镜像

2、查询pytorch/pytorch的镜像

选择需要的版本

3、devel版本和runtime版本的区别

- Devel版本(pytorch:2.0.1-cuda11.7-cudnn8-devel):

- Devel版本是用于开发和构建PyTorch的版本。

- 它包含了用于编译和构建PyTorch库的开发工具和依赖项。

- Devel版本通常用于构建自定义的PyTorch扩展、模型库或其他与PyTorch相关的软件。

- 它包含了用于调试和开发的符号表和调试工具,可以帮助开发者进行错误排查和调试。

- Runtime版本(pytorch:2.0.1-cuda11.7-cudnn8-runtime):

- Runtime版本是用于运行PyTorch应用程序的版本。

- 它包含了PyTorch库和必要的运行时依赖项,但不包含开发工具和符号表。

- Runtime版本通常用于在生产环境中部署和运行PyTorch应用程序。

- 它不包含用于编译和构建自定义扩展或库的工具,因此不适用于开发新的PyTorch功能或调试代码。

总结:

Devel版本适用于开发者构建和扩展PyTorch,它包含了开发工具和依赖项,以及用于调试和错误排查的工具。Runtime版本适用于在生产环境中运行PyTorch应用程序,它只包含必要的运行时依赖项,不包含开发工具和符号表。【所以建议直接用devel版本的】

4、拉取对应版本镜像

我用的是pytorch:2.0.1-cuda11.7-cudnn8的devel版本,直接复制上述后面的命令行。

docker pull pytorch/pytorch:2.0.1-cuda11.7-cudnn8-devel

输出表明你已成功下载了pytorch/pytorch镜像的特定版本2.0.1-cuda11.7-cudnn8-devel到本地。可以使用该镜像来创建和运行基于PyTorch的容器。

-

Pulling from pytorch/pytorch:表示正在从pytorch/pytorch镜像仓库中拉取镜像。 -

Pull complete:表示已成功下载一个镜像层。 -

Digest:表示镜像的摘要,用于唯一标识镜像的内容。 -

Status: Downloaded newer image for pytorch/pytorch:2.0.1-cuda11.7-cudnn8-devel:表示已成功下载标签为2.0.1-cuda11.7-cudnn8-devel的pytorch/pytorch镜像。

5、查看拉取完成的镜像

docker images

6、生成容器

nvidia-docker run --gpus all -itd --name=alpa_test pytorch/pytorch:2.0.1-cuda11.7-cudnn8-devel

其中是命名叫alpa_test,可以使用容器ID或容器名称直接进入容器。

截止到这一步就可以直接使用带有cuda+pytorch的容器了。

四、进入容器并查询相关信息

1、进入容器

docker exec -it alpa_test bash2、打印环境变量

echo $LD_LIBRARY_PATH3、查询本地安装的软件和程序

ls /usr/local/ 文章来源:https://www.toymoban.com/news/detail-775079.html

文章来源:https://www.toymoban.com/news/detail-775079.html

4、显示NVIDIA CUDA 编译器(nvcc)的版本信息

nvcc -V 文章来源地址https://www.toymoban.com/news/detail-775079.html

文章来源地址https://www.toymoban.com/news/detail-775079.html

到了这里,关于ubuntu系统(6):Nvidia Docker配置cuda+pytorch【纯小白版】的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!