This is part 3 of a blog series. In this blog, we’ll show you how to build an LLM question and answering service. In future parts, we will optimize the code and measure performance: cost, latency and throughput.

这是博客系列的第 3 部分。在本博客中,我们将向您展示如何构建LLM问答服务。在以后的部分中,我们将优化代码并测量性能:成本、延迟和吞吐量。

目录文章来源:https://www.toymoban.com/news/detail-775409.html

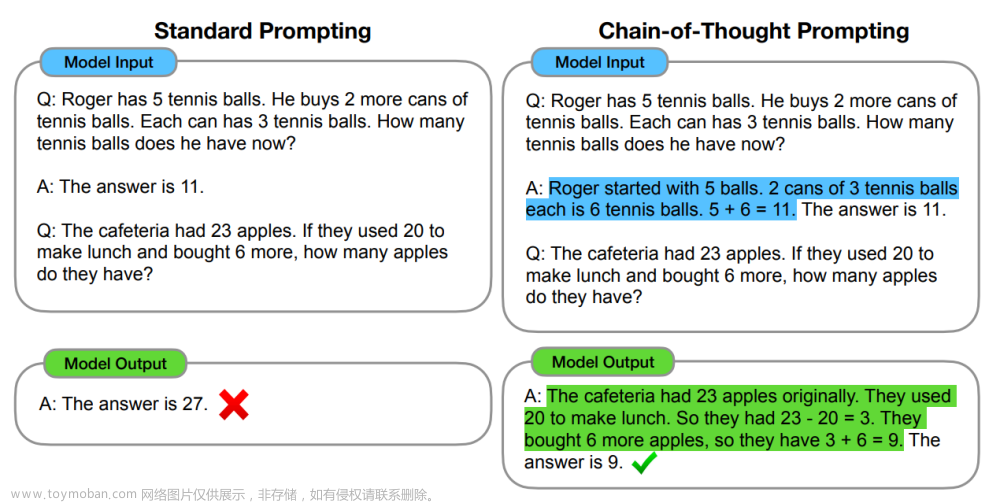

Step 1: The Prompt Template 第 1 步:提示模板文章来源地址https://www.toymoban.com/news/detail-775409.html

到了这里,关于【ChatGPT】在20分钟内使用 LangChain + Ray构建自托管问答服务的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!