目录

状态监控指标

JobManager 指标

TaskManager 指标

Job 指标

资源监控指标

数据流监控指标

任务监控指标

网络监控指标

容错监控指标

数据源监控指标

数据存储监控指标

当使用 Apache Flink 进行流处理任务时,可以根据不同的监控需求,监控以下常用指标:

状态监控指标

JobManager 指标

- JobManager CPU 使用率:监控 JobManager 的 CPU 使用情况,以确保其正常工作。

- JobManager 内存使用量:监控 JobManager 的内存使用情况,以避免内存溢出或泄漏。

- JobManager 网络流量:监控 JobManager 的网络流量,了解其与 TaskManager 之间的通信情况。

TaskManager 指标

- TaskManager CPU 使用率:监控 TaskManager 的 CPU 使用情况,以确保其正常运行和负载均衡。

- TaskManager 内存使用量:监控 TaskManager 的内存使用情况,以避免内存溢出或泄漏。

- TaskManager 网络流量:监控 TaskManager 的网络流量,了解其与 JobManager 和其他 TaskManager 之间的通信情况。

- TaskManager 线程池情况:监控 TaskManager 的线程池使用情况,以避免线程池饱和或线程资源不足。

Job 指标

- Job 运行时间:监控 Job 的运行时间,以及任务的执行延迟,以及是否满足预期的处理速度。

- Job 状态:监控 Job 的状态,包括运行中、完成或失败等。

- Job 状态变化:监控 Job 状态的变化,以便及时发现和处理异常情况。

资源监控指标

- CPU 使用率:监控 JobManager 和 TaskManager 的 CPU 使用情况,以评估集群的负载情况。

- 内存使用量:监控 JobManager 和 TaskManager 的内存使用情况,以评估集群的资源利用情况。

- 磁盘使用量:监控 JobManager 和 TaskManager 的磁盘使用情况,以评估集群的磁盘使用情况。

- 网络带宽:监控Flink集群的网络带宽使用情况,以评估集群的网络性能。

数据流监控指标

- 数据吞吐量:监控每个任务或操作的数据吞吐量,以评估任务的性能和资源使用情况。

- 数据丢失率:监控数据在处理过程中的丢失率,以确保数据的完整性和准确性。

- 数据延迟:监控数据在流处理过程中的延迟情况,以评估数据处理的效率。

任务监控指标

- 任务执行时间:监控每个任务的执行时间,以评估任务的性能和效率。

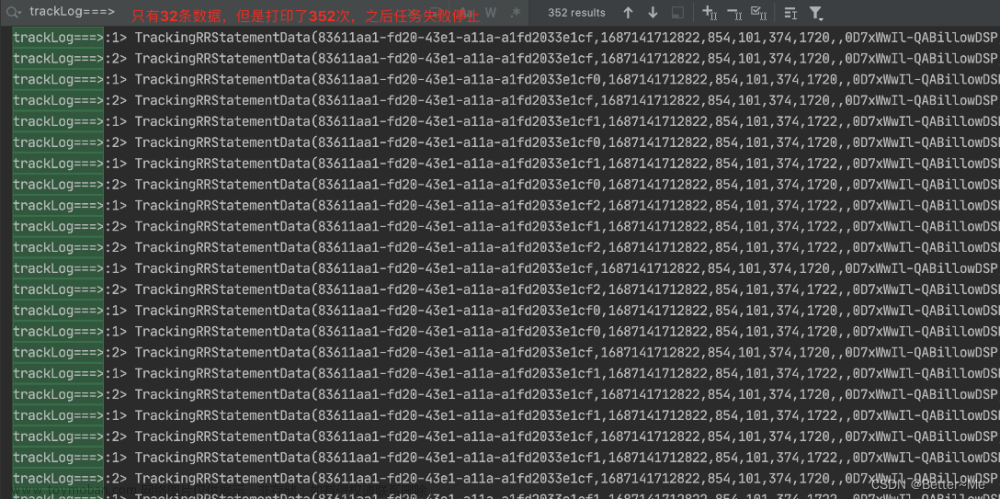

- 任务状态变化:监控任务状态的变化,以便及时发现和处理异常情况。

- 并行度:监控任务的并行度,以评估任务的并发执行能力。

- 中断次数:监控任务的中断情况,以评估任务的稳定性。

- 重启次数:监控任务的重启情况,以评估任务的可靠性。

网络监控指标

- 网络源延:用于监控Flink集群的网络延迟情况,以评估集群的通信能力。

- 网络吞吐量:用于监控Flink集群的网络吞吐量,以评估集群的通信带宽。

容错监控指标

- Checkpoint 成功率:监控 Checkpoint 的成功率,以确保数据在故障恢复时能够正确保存和恢复。

- Checkpoint 间隔:监控 Checkpoint 的时间间隔,以确保数据定期进行持久化。

- Checkpoint 数据大小:监控每个 Checkpoint 的数据大小,以评估 Checkpoint 的性能和资源使用情况。

数据源监控指标

- 数据源数量:监控输入数据源的数量和状态。

- 数据源延迟:监控数据源的延迟情况。

数据存储监控指标

- 存储空间使用率:用于监控Flink集群的存储空间使用率,以评估集群的存储容量。

- 存储读写速度:用于监控Flink集群的存储读写速度,以评估集群的存储性能。

以上是常见的 Flink 监控指标,通过监控这些指标可以及时发现问题并采取相应的措施。可以使用 Flink 的内置监控工具、第三方监控工具或自定义监控脚本来收集和展示这些指标。根据实际需求选择合适的监控方式和工具。

更多消息资讯,请访问昂焱数据。文章来源:https://www.toymoban.com/news/detail-775917.html

文章来源地址https://www.toymoban.com/news/detail-775917.html

到了这里,关于Flink 任务指标监控的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!