摘要:

HBase的Java API提供了一种与HBase数据库进行交互的方式,通过编写Java程序可以连接到HBase集群并对数据进行存储、检索和处理。该API适用于大规模数据存储、实时数据访问和高扩展性需求的场景。具有高可靠性、高扩展性和高性能的特点。它可以处理海量数据,并且支持低延迟的读写操作,提供了强大的过滤和排序功能[1]。在当前的大数据应用环境下,HBase的优势得到了广泛认可,越来越多的企业和组织选择将其作为核心数据存储和处理平台。未来,HBase将继续发展,提升性能、可伸缩性和功能,适应新的挑战并加强与其他大数据组件的整合。

一、主题概述

HBase是一个开源的分布式、面向列的NoSQL数据库,它运行在Apache Hadoop上,并且具有高可靠性、高扩展性和高性能的特点。HBase的Java API是一组用于与HBase数据库进行交互的Java类和方法。

该主题涉及如何使用HBase的Java API来进行数据的存储、检索和处理。通过Java API,开发人员可以编写程序来连接到HBase集群,并执行各种操作,如创建表、插入数据、更新数据、删除数据以及查询数据等。

HBase的Java API适用于以下场景:

1. 大规模数据存储:HBase适合存储海量数据,特别是非结构化或半结构化数据。它在分布式环境下提供了快速的读写能力,可以处理PB级别的数据。

2. 实时数据访问:HBase具有低延迟的读写性能,使其成为实时数据访问的理想选择。它支持随机访问行级数据,并提供了强大的过滤和排序功能[2]。

3. 高扩展性需求:HBase可以轻松地扩展到数百台或数千台服务器,以满足增长的数据存储需求。它通过水平分片和负载均衡来实现数据的分布式存储和处理。

发展历史和发展趋势方面,HBase最初是由Powerset开发的,并在2007年正式加入Apache基金会。自那时以来,HBase经历了多个版本迭代和功能增强,成为了大数据领域中备受关注的NoSQL解决方案之一。

随着大数据应用的不断发展,HBase在数据存储和实时查询方面的优势得到了广泛认可。越来越多的企业和组织开始采用HBase作为其核心数据存储和处理平台,尤其是在互联网、社交媒体、物联网以及日志分析等领域。

未来,HBase将继续朝着更高的性能、更好的可伸缩性和更丰富的功能方向发展。随着硬件技术的进步和对大数据处理能力的要求不断提升,HBase将继续适应新的挑战,并加强与其他大数据生态系统组件的整合,以提供更全面的解决方案。同时,HBase的社区也将持续推动其开源发展,吸引更多的贡献者和用户参与进来,共同推动HBase的创新和演进。

- 应用情况

HBase Java API的应用情况如下:

1. 应用领域:

HBase的Java API在许多领域都有广泛的应用。以下是其中一些主要的应用领域:

1) 互联网和社交媒体:互联网和社交媒体公司需要处理大量的用户数据,包括用户配置文件、社交网络连接和活动日志等。HBase的Java API可以帮助他们存储和实时查询这些数据,并支持快速的读写操作。

2) 物联网(IoT):随着物联网设备数量的不断增长,对于存储和处理这些设备生成的大量数据变得越来越重要。HBase的Java API可以作为物联网平台的底层存储引擎,帮助存储传感器数据、设备状态和事件信息,并支持实时查询和分析。

3) 日志分析:许多企业需要对其日志数据进行实时分析,以获得有关系统性能、用户行为和安全事件的洞察。HBase的Java API可以存储和查询大规模的日志数据,提供快速的数据访问和复杂的过滤功能。

4) 金融服务:金融机构需要存储和处理大量的交易数据、客户信息和市场数据。HBase的Java API可以帮助他们在分布式环境下管理这些数据,并提供低延迟的读写操作,以支持实时风险管理和交易分析。

2. 基本内容和使用方法:

报告主题的基本内容可以分为以下几个方面:

1. 连接HBase集群:通过HBase的Java API可以连接到HBase集群,建立与HBase数据库的通信。需要指定HBase的配置信息,如ZooKeeper地址和端口等。

2. 创建表和列族:使用Java API可以创建HBase中的表和列族,可以设定表的名称、列族的名称和相应的属性。

3. 插入数据:可以通过Java API向HBase表中插入数据,需要指定行键(Row Key)和列族、列限定符(Column Qualifier)以及对应的值。

4. 查询数据:可以使用Java API来检索HBase表中的数据,可以根据行键、列族、列限定符等条件进行查询,并获取相应的结果。

5. 更新数据:通过Java API可以对HBase表中的数据进行更新操作,可以更新特定的列族或列限定符的值。

6. 删除数据:可以使用Java API删除HBase表中的数据,可以按照行键、列族或列限定符进行删除操作。

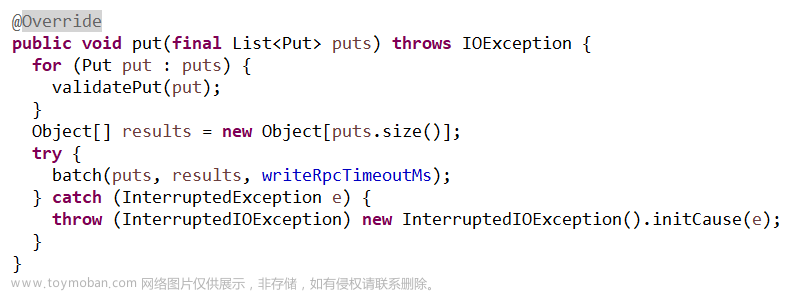

7. 批量操作:Java API还支持批量操作,可以一次性执行多个插入、查询、更新或删除操作,提高效率和性能。

下面是一个简单的示例,展示了使用HBase的Java API来创建表、插入数据、查询数据和删除数据的过程:

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.client.*;

import org.apache.hadoop.hbase.util.Bytes;

public class HBaseExample {

public static void main(String[] args) throws Exception {

// 创建HBase配置

Configuration config = HBaseConfiguration.create();

// 创建HBase连接

Connection connection = ConnectionFactory.createConnection(config);

// 创建表名

TableName tableName = TableName.valueOf("my_table");

// 创建列族名

byte[] columnFamily = Bytes.toBytes("cf");

// 创建表描述符

TableDescriptorBuilder tableDescriptorBuilder = TableDescriptorBuilder.newBuilder(tableName)

.setColumnFamily(ColumnFamilyDescriptorBuilder.newBuilder(columnFamily).build());

// 创建表

Admin admin = connection.getAdmin();

admin.createTable(tableDescriptorBuilder.build());

admin.close();

// 获取表实例

Table table = connection.getTable(tableName);

// 插入数据

Put put = new Put(Bytes.toBytes("row1"));

put.addColumn(columnFamily, Bytes.toBytes("col1"), Bytes.toBytes("value1"));

table.put(put);

// 查询数据

Get get = new Get(Bytes.toBytes("row1"));

Result result = table.get(get);

byte[] value = result.getValue(columnFamily, Bytes.toBytes("col1"));

System.out.println("Value: " + Bytes.toString(value));

// 删除数据

Delete delete = new Delete(Bytes.toBytes("row1"));

table.delete(delete);

// 关闭连接

table.close();

connection.close();

}

}这个示例演示了如何使用HBase的Java API来创建一个名为"my_table"的表,插入一条数据(行键为"row1",列族为"cf",列限定符为"col1",值为"value1"),然后查询并打印出该数据的值,并最后删除该数据。注意,这只是一个简单的示例,实际使用中可能会涉及更复杂的操作和更多的配置选项。

- 与相关相似主题的异同点:

HBase Java API是访问HBase数据库的主要方式之一。除了HBase Java API外,还有其他一些API可以用于访问HBase,例如REST API、Thrift API和Avro API等。这里我们主要横向比较HBase Java API与REST API和Thrift API的异同点。

异同点如下:

1. 语言支持:HBase Java API是Java编写的,而REST API和Thrift API可以使用多种语言编写,包括Java、Python、Ruby等。这使得REST API和Thrift API更加灵活,适合多语言开发团队。

2. 性能:HBase Java API直接调用HBase内部的Java代码,因此性能更高。而REST API和Thrift API需要将请求解析为HTTP或Thrift协议,并且需要进行序列化和反序列化操作,因此性能相对较低。

3. 功能支持:HBase Java API支持HBase的所有功能,包括表管理、数据插入、查询、更新和删除等。而REST API和Thrift API不支持所有功能,有一些高级功能只能通过Java API实现。

4. 开发难度:HBase Java API是封装HBase操作最为方便的方法,但对于初学者来说,可能需要花费时间学习Java API的使用方法。而REST API和Thrift API使用简单,只需要发送HTTP或Thrift请求并解析响应即可,对于初学者更为友好。

5. 安全性:REST API和Thrift API支持基于Kerberos的安全认证,可以在客户端和服务器端之间进行安全认证。而HBase Java API需要通过配置文件来实现安全认证,可能需要更多的工作量。

相同点如下:

1. 访问HBase:无论是HBase Java API、REST API还是Thrift API,它们都提供了访问HBase数据库的能力。

2. 数据操作:这三种API都支持对HBase表进行数据的插入、查询、更新和删除等操作。

3. 并发性:无论是HBase Java API、REST API还是Thrift API,它们都可以处理多个并发请求。

4. 跨平台支持:这三种API都可以在不同的操作系统上运行,并且可以与各种编程语言进行集成和使用。

5. 扩展性:这三种API都具有良好的扩展性,可以根据需要进行自定义开发和优化。

总体上来说,HBase Java API是最为直接、方便且功能最为丰富的访问HBase的方式之一。但对于不同的开发团队和应用场景,选择最适合自己的API也很重要。

- 实验情况

1)实验环境描述:

为了使用HBase Java API进行实验,您需要设置以下环境:

1. Java开发环境:确保您已经安装了Java Development Kit (JDK)。建议使用最新版本的JDK。

2. HBase依赖库:您需要下载HBase的Java客户端库并将其添加到您的项目中。您可以从HBase的官方网站或Maven仓库获取HBase的Java客户端库。

3. Hadoop集群:HBase是建立在Hadoop之上的分布式数据库,因此您需要配置一个可用的Hadoop集群以供HBase使用。您可以使用Hadoop的单节点模式进行开发和测试,也可以配置一个多节点的Hadoop集群。

4. HBase配置文件:HBase有一些配置文件,您需要根据您的环境进行相应的配置。主要的配置文件包括`hbase-site.xml`、`hbase-env.sh`和`regionservers`。您需要根据您的Hadoop集群配置修改这些文件。

5. HBase表的创建:在使用HBase Java API之前,您需要在HBase中创建表并定义列族。您可以使用HBase shell或HBase管理界面(如Hue)来创建表,或者使用HBase Java API动态创建表。

|

|

6. Java代码编写:最后,您需要使用Java编写代码来连接HBase集群、执行操作。您可以使用HBase提供的Java API来进行连接、插入、查询等操作。确保您已经导入了相关的类和方法,并按照API文档进行操作。

这些是使用HBase Java API进行实验的基本环境要求和步骤。根据您的具体需求,可能还需要进行其他配置和操作。请参考HBase官方文档以获取更详细的信息和示例代码。

2)实验过程:

以下是使用HBase Java AP创建表格,删除表格并判断表格是否存在的过程:

public static boolean isTableExists(String namespace,String tableName) throws IOException {

// 1. 获取 admin

Admin admin = connection.getAdmin();

// 2. 使用方法判断表格是否存在

boolean b = false;

try {

b = admin.tableExists(TableName.valueOf(namespace, tableName));

} catch (IOException e) {

e.printStackTrace();

|

}

// 3. 关闭 admin

admin.close();

// 3. 返回结果

return b;

// 后面的代码不能生效

}

//创建表格 namespace:命名空间名称 tableName:表

名 columnFamilies:列族名

public static void createTable(String namespace , String tableName , String... columnFamilies) throws IOException {

// 判断是否有至少一个列族

if (columnFamilies.length == 0){

System.out.println("创建表格至少有一个列族");

return;

}

// 判断表格是否存在

if (isTableExists(namespace,tableName)){

System.out.println("表格已经存在");

return;

}

// 1.获取 admin

Admin admin = connection.getAdmin();

// 2. 调用方法创建表格

// 2.1 创建表格描述的建造者

TableDescriptorBuilder tableDescriptorBuilder = TableDescriptorBuilder.newBuilder(TableName.valueOf(namespace, tableName));

// 2.2 添加参数

for (String columnFamily : columnFamilies) {

// 2.3 创建列族描述的建造者

ColumnFamilyDescriptorBuilder columnFamilyDescriptorBuilder = ColumnFamilyDescriptorBuilder.newBuilder(Bytes.toBytes(columnFamily));

// 2.4 对应当前的列族添加参数

// 添加版本参数

columnFamilyDescriptorBuilder.setMaxVersions(5);

// 2.5 创建添加完参数的列族描述

tableDescriptorBuilder.setColumnFamily(columnFamilyDescriptorBuilder.build());

}

// 2.6 创建对应的表格描述

try {

admin.createTable(tableDescriptorBuilder.build());

|

} catch (IOException e) {

e.printStackTrace();

}

// 3. 关闭 admin

admin.close();

}

//修改表格 namespace:命名空间名称 tableName:表名 columnFamily:列族名 version:版本号

public static void modifyTable(String namespace ,String tableName,String columnFamily,int version) throws IOException {

// 判断表格是否存在

if (!isTableExists(namespace,tableName)){

System.out.println("表格不存在无法修改");

return;

}

// 1. 获取 admin

Admin admin = connection.getAdmin();

try {

// 2. 调用方法修改表格

// 2.0 获取之前的表格描述

TableDescriptor descriptor =

admin.getDescriptor(TableName.valueOf(namespace, tableName));

// 2.1 创建一个表格描述建造者

// 如果使用填写 tableName 的方法 相当于创建了一个新的表格描述建造者 没有之前的信息

// 如果想要修改之前的信息 必须调用方法填写一个旧的表格描述

TableDescriptorBuilder tableDescriptorBuilder = TableDescriptorBuilder.newBuilder(descriptor);

// 2.2 对应建造者进行表格数据的修改

ColumnFamilyDescriptor columnFamily1 = descriptor.getColumnFamily(Bytes.toBytes(columnFamily));

// 创建列族描述建造者

// 需要填写旧的列族描述

ColumnFamilyDescriptorBuilder columnFamilyDescriptorBuilder = ColumnFamilyDescriptorBuilder.newBuilder(columnFamily1);

// 修改对应的版本

columnFamilyDescriptorBuilder.setMaxVersions(version);

// 此处修改的时候 如果填写的新创建 那么别的参数会初始化

tableDescriptorBuilder.modifyColumnFamily(columnFamilyDescriptorBuilder.build());

admin.modifyTable(tableDescriptorBuilder.build());

} catch (IOException e) {

e.printStackTrace();

}

// 3. 关闭 admin

admin.close();

}

|

//删除表格 namespace:命名空间名称 tableName:表名 返回值:是否删除成功

public static boolean deleteTable(String namespace ,String tableName) throws IOException {

// 1. 判断表格是否存在

if (!isTableExists(namespace,tableName)){

System.out.println("表格不存在 无法删除");

return false;

}

// 2. 获取 admin

Admin admin = connection.getAdmin();

// 3. 调用相关的方法删除表格

try {

// HBase 删除表格之前 一定要先标记表格为不可以

TableName tableName1 = TableName.valueOf(namespace, tableName);

admin.disableTable(tableName1);

admin.deleteTable(tableName1);

} catch (IOException e) {

e.printStackTrace();

}

// 4. 关闭 admin

admin.close();

return true;

}

|

- 实验结果分析

通过对HBase Java API的使用,我们可以得出以下结论:

1. 创建HBase表格:

- 首先,我们需要创建一个HBase配置对象和连接对象。

- 然后,使用连接对象获取HBase表格管理对象。

- 将列族描述符添加到表格描述符中。

- 使用表格管理对象的createTable()方法来创建表格。

2. 修改HBase表格:

- 我们可以使用HBaseAdmin类的alterTable()方法来修改表格的属性。

- 首先,获取要修改的表格的表格描述符。

- 可以创建新的列族描述符,并将其添加到表格描述符中。

- 使用表格管理对象的modifyTable()方法来修改表格。

3. 删除HBase表格:

- 使用HBaseAdmin类的disableTable()方法来禁用表格。

- 使用deleteTable()方法来删除表格。

需要注意的是,在进行HBase表格操作之前,需要创建HBase连接对象和HBase表格管理对象。另外,HBase的表格操作是基于列族的,因此在创建表格时需要定义好列族的属性,并将列族添加到表格描述符中。

总而言之,通过HBase Java API,我们可以方便地创建、修改和删除HBase表格,并根据实际需求定义表格的属性和列族的属性。这为我们在HBase中存储和管理数据提供了灵活性和便利性。

四、总结

HBase Java API是访问HBase数据库的主要方式之一,它可以通过Java代码直接访问HBase表,实现对表的管理、数据插入、查询、更新和删除等基本操作。下面是几种使用HBase Java API的应用场景和建议:

1. 互联网应用:HBase Java API在互联网应用中具有广泛的应用,例如社交网络、电子商务等,因为这些应用需要存储大量的非结构化或半结构化数据,并且需要快速地进行数据检索和分析。建议使用HBase Java API实现这些应用的数据存储和查询功能。

2. 大数据分析:HBase是基于Hadoop的分布式数据库,可以存储PB级别的数据。HBase Java API可以与Hadoop生态系统中的其他组件(如MapReduce、Spark、Hive等)集成,以便进行复杂的数据分析工作。建议使用HBase Java API实现大数据分析应用的数据存储和查询功能。

3. 物联网应用:物联网应用需要处理大量的传感器数据。HBase Java API可以方便地存储和查询这些传感器数据,同时支持数据实时处理。建议使用HBase Java API实现物联网应用的数据存储和查询功能。

4. 日志分析:HBase具有压缩、版本控制等特点,适合存储海量的日志数据,而HBase Java API可以方便地对存储在HBase中的日志数据进行查询和分析。建议使用HBase Java API实现日志分析应用的数据存储和查询功能。

总之,HBase Java API适合存储、管理和查询具有高可靠性、高并发性、海量数据的应用场景,如互联网应用、大数据分析、物联网应用和日志分析等。在选择使用HBase Java API时,需要针对具体的应用场景进行评估,并结合项目需求进行合理的开发。

五、参考文献

[1] 张智;龚宇;;分布式存储系统HBase关键技术研究[J];现代计算机(专业版);2014年32期文章来源:https://www.toymoban.com/news/detail-776686.html

[2] 谭洁清;毛锡军;;Hadoop云计算基础架构的搭建和hbase和hive的整合应用[J];贵州科学;2013年05期文章来源地址https://www.toymoban.com/news/detail-776686.html

到了这里,关于基于hadoop的HBase JAVA API的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!