Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

提示+推理+大模型:CoT 思维链提示

来源 Google Brain

论文:Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

一、摘要

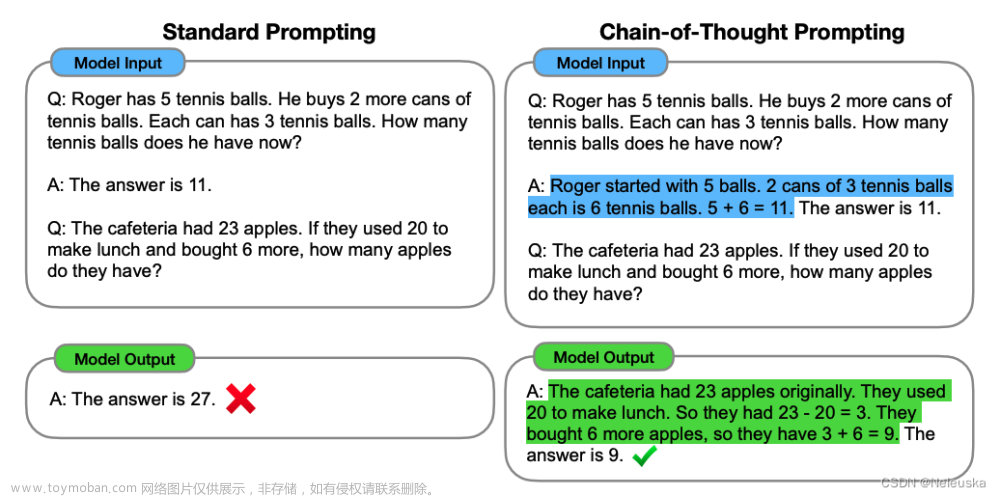

本文探讨了生成思想链一系列中间推理步骤如何显著提高大型语言模型执行复杂推理的能力。特别是,我们展示了这种推理能力是如何通过一种称为思维链提示的简单方法在足够大的语言模型中自然出现的,其中提供了一些思维链演示作为提示的示例。

在三个大型语言模型上的实验表明,思维链提示可以提高一系列算术、常识和符号推理任务的性能。经验上的收益可能是惊人的。例如,提示一个只有八个思维链样本的PaLM 540B在GSM8K数学单词问题基准上实现了最先进的准确性,甚至超过了带有验证器的微调GPT-3。

二、介绍

在本文中,我们结合了提示学习,常识推理这两种想法的优势,避免了它们的局限性。具体来说,我们探索了语言模型在给定由三元组组成的提示(〈输入,思想链,输出〉)的情况下,对推理任务执行少量提示的能力。思维链是一系列中间的自然语言推理步骤,这些步骤会导致最终的输出,我们将这种方法称为思维链提示。

如图1所示。我们对算术、常识和符号推理基准进行了实证评估,表明思维链提示优于标准提示,有时甚至达到了惊人的程度。

图2显示了GSM8K数学单词问题基准测试的一个结果,PaLM 540B的思想链提示大大优于标准提示,并实现了新的最先进性能。仅提示的方法很重要,因为它不需要大型训练数据集,而且单个模型检查点可以执行许多任务而不会失去通用性。这项工作强调了大型语言模型如何通过几个带有任务自然语言数据的例子进行学习。

Target

本文的目标是赋予语言模型生成类似思想链的能力——一系列连贯的中间推理得出问题最终答案的步骤。

Contribution

- 首先,原则上,思想链允许模型将多步骤问题分解为中间步骤,这意味着可以将额外的计算分配给需要更多推理步骤的问题。

- 其次,思想链为了解模型的行为提供了一个可解释的窗口,表明它可能是如何得出特定答案的,并提供了调试推理路径哪里出错的机会(尽管完全表征支持答案的模型计算仍然是一个悬而未决的问题)。

- 第三,思维链推理可以用于数学单词问题、常识推理和符号操作等任务,并且可能(至少在原则上)适用于人类可以通过语言解决的任何任务。

- 最后,在足够大的现成语言模型中,只需将思维链序列的例子包括在少镜头提示的例子中,就可以很容易地引发思维链推理。

三、实验

本文为了验证思维链进行提示的方法可以给大模型的推理能力,产生很大的提升,分别在算数推理,常识推理,符号推理上进行实验。

3.1 算数推理

当与540B参数语言模型一起使用时,思想链提示在多个任务上与特定于任务的微调模型的性能相当,甚至在具有挑战性的GSM8K Benchmark 测试上达到了最新水平。

3.2 常识推理

尽管思维链特别适用于数学单词问题,但思维链基于语言的性质实际上使其适用于一类广泛的常识性推理问题,这些问题涉及在一般背景知识的假设下对物理和人类互动进行推理。常识推理是与世界互动的关键,目前的自然语言理解系统仍无法进行常识推理。

3.3 符号推理

我们的最终实验评估考虑了符号推理,这对人类来说很简单,但对语言模型来说可能很困难。我们发现,思维链提示不仅使语言模型能够执行在标准提示设置中具有挑战性的符号推理任务,而且有助于推理时间输入的长度泛化,比少数镜头示例中看到的更长。

-

最后一个字母串联。

此任务要求模型将名称中单词的最后一个字母连接起来(例如,“Amy Brown”→ “yn”)。这是首字母串联的一个更具挑战性的版本,语言模型已经可以在没有思想链的情况下执行。3我们通过从人口普查数据中随机串联前一千个名字中的名字来生成全名。

-

硬币翻转。

这项任务要求模型回答在人们翻转或不翻转硬币后,硬币是否仍然朝上(例如,“硬币是朝上的。菲比翻转硬币。奥斯瓦尔多没有翻转硬币。硬币仍然朝上吗?”→ “否”)。

四、讨论

4.1 实验总结

我们已经探索了思维链提示作为一种在大型语言模型中引发多步骤推理行为的简单机制。

我们首先看到,思维链提示在算术推理方面大大提高了性能,产生了比消融更强的改进,并且对不同的注释器、示例和语言模型都很鲁棒。关于常识推理的实验强调了思维链推理的语言性质是如何使其普遍适用的。最后,我们表明,对于符号推理,思想链提示有助于OOD泛化到更长的序列长度。文章来源:https://www.toymoban.com/news/detail-777651.html

4.2 局限性

- 我们首先证明,尽管思维链模仿了人类推理者的思维过程,但这并不能回答神经网络是否真的在“推理”,这是一个悬而未决的问题。

- 尽管在少快照设置中,用思维链手动扩充示例的成本最小,但这种注释成本可能无法进行微调(尽管这可能通过合成数据生成或零样本泛化来克服)。

- 无法保证正确的推理路径,这可能导致正确和不正确的答案;改进语言模型的事实生成是未来工作的一个开放方向。

- 仅在大模型范围内出现的思维链推理使得在现实世界的应用中服务成本高昂;进一步的研究可以探索如何在较小的模型中诱导推理。

五、总结

我们已经探索了思维链提示作为一种简单且广泛适用的方法来增强语言模型中的推理。通过对算术、符号和常识推理的实验,我们发现思维链推理是模型尺度的一种新兴性质,它允许足够大的语言模型执行具有平坦尺度曲线的推理任务。拓宽语言模型可以执行的推理任务的范围,有望激励人们进一步研究基于语言的推理方法。文章来源地址https://www.toymoban.com/news/detail-777651.html

到了这里,关于论文笔记 CoT:提示+推理+大模型=思维链提示的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!