混淆矩阵、精确率、召回率和F1值:如何评估分类器的性能?

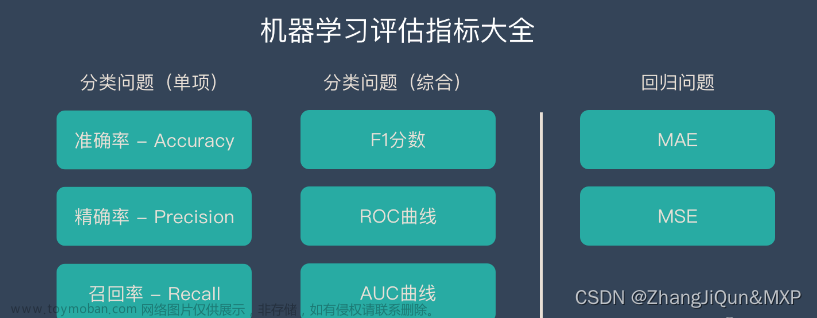

在机器学习中,分类是一项非常重要的任务。在分类任务中,我们需要根据输入的数据将其分为不同的类别。为了评估分类器的性能,我们需要使用一些指标。其中最常用的指标就是混淆矩阵、精确率、召回率和F1值。本文将详细介绍这些指标的原理,并结合代码进行讲解。

1. 混淆矩阵

混淆矩阵是一种可视化分类器性能的工具,它通常用于评估二元分类器。混淆矩阵以矩阵的形式展示了分类器在测试集上的预测结果与真实结果之间的关系。下面是一个示例混淆矩阵:

| 真实值为正例 | 真实值为反例 | |

|---|---|---|

| 预测值为正例 | True Positive (TP) | False Positive (FP) |

| 预测值为反例 | False Negative (FN) | True Negative (TN) |

在混淆矩阵中,真实值为正例的样本有TP和FN两种情况,预测值为正例的样本有TP和FP两种情况。其中,True Positive (TP)表示正确预测为正例的样本数量,False Positive (FP)表示错误预测为正例的样本数量,False Negative (FN)表示错误预测为反例的样本数量,True Negative (TN)表示正确预测为反例的样本数量。

代码实现:

我们可以使用Python中的sklearn库来生成混淆矩阵。下面是一个示例代码:

from sklearn.metrics import confusion_matrix

y_true = [1, 0, 0, 1, 1, 0, 1, 0, 1, 1]

y_pred = [1, 1, 0, 1, 0, 0, 1, 0, 0, 1]

tn, fp, fn, tp = confusion_matrix(y_true, y_pred).ravel()

print("True Positive: ", tp)

print("False Positive: ", fp)

print("True Negative: ", tn)

print("False Negative: ", fn)

输出结果为:

True Positive: 4

False Positive: 1

True Negative: 2

False Negative: 3

2. 精确率和召回率

精确率和召回率是评估分类器性能的两个重要指标。精确率表示被分类器正确预测为正例的样本数占所有被分类器预测为正例的样本数的比例,计算公式如下:

p

r

e

c

i

s

i

o

n

=

T

P

T

P

+

F

P

precision=\frac{TP}{TP+FP}

precision=TP+FPTP

召回率表示被分类器正确预测为正例的样本数占所有真实正例的样本数的比例,计算公式如下:

r

e

c

a

l

l

=

T

P

T

P

+

F

N

recall=\frac{TP}{TP+FN}

recall=TP+FNTP

精确率和召回率两者常常相互影响,一般来说,精确率高的分类器会将更多的负例误判成正例,召回率高的分类器会将更多的正例误判成负例。因此,我们需要在两者之间取得一个平衡。

代码实现:

同样使用sklearn库,下面是一个示例代码:

from sklearn.metrics import precision_score, recall_score

y_true = [1, 0, 0, 1, 1, 0, 1, 0, 1, 1]

y_pred = [1, 1, 0, 1, 0, 0, 1, 0, 0, 1]

precision = precision_score(y_true, y_pred)

recall = recall_score(y_true, y_pred)

print("Precision: ", precision)

print("Recall: ", recall)

输出结果为:

Precision: 0.8

Recall: 0.5714285714285714

3. F1值

F1值是精确率和召回率的调和平均值,它综合考虑了精确率和召回率两个指标,计算公式如下:

F

1

=

2

1

P

r

e

c

i

s

i

o

n

+

1

R

e

c

a

l

l

F_1=\frac{2}{\frac{1}{Precision}+\frac{1}{Recall}}

F1=Precision1+Recall12

F1值的取值范围为0到1,值越大表示分类器性能越好。

代码实现:

同样使用sklearn库,下面是一个示例代码:

from sklearn.metrics import f1_score

y_true = [1, 0, 0, 1, 1, 0, 1, 0, 1, 1]

y_pred = [1, 1, 0, 1, 0, 0, 1, 0, 0, 1]

f1 = f1_score(y_true, y_pred)

print("F1 Score: ", f1)

输出结果为:

F1 Score: 0.6666666666666666

4. f1_score和precision_recall_fscore_support参数详解

(1)f1_score

在sklearn库中,f1_score函数可以用于计算二元分类或多元分类问题中的F1值。其函数调用形式如下:

f1_score(y_true, y_pred, labels=None, pos_label=1, average='binary', sample_weight=None, zero_division='warn')

其中,参数y_true是真实的类别标签,y_pred是分类器预测的类别标签;labels是类别列表,用于指定计算哪些类别的指标;pos_label是正例的类别标签;average是指标的计算方式,可以是’binary’、‘micro’、'macro’或’weighted’等;sample_weight是样本权重,用于不同样本对指标的贡献不同的情况;zero_division是指当某个类别的真实样本数或预测样本数为0时,指标计算的处理方式。

当average='binary’时,f1_score函数将只计算正例的F1值,pos_label参数用于指定正例的类别标签。当average='micro’时,函数将计算所有类别的指标的加权平均值,权重为每个类别的支持度。当average='macro’时,函数将计算所有类别的指标的算术平均值。当average='weighted’时,函数将计算所有类别的指标的加权平均值,权重为每个类别的支持度。

labels参数用于指定计算哪些类别的指标。当labels=None时,函数将计算所有类别的指标。当labels为一个类别列表时,函数将只计算列表中包含的类别的指标。例如,当我们有一个三元分类问题,类别标签分别为0、1、2时,我们可以通过下面的代码计算类别0和类别1的F1值:

from sklearn.metrics import f1_score

y_true = [0, 1, 2, 0, 1, 2]

y_pred = [0, 2, 1, 0, 0, 1]

f1_0 = f1_score(y_true, y_pred, labels=[0])

f1_1 = f1_score(y_true, y_pred, labels=[1])

print("F1 Score for Label 0: ", f1_0)

print("F1 Score for Label 1: ", f1_1)

输出结果为:

F1 Score for Label 0: 0.6666666666666666

F1 Score for Label 1: 0.0

由于我们指定了labels=[0]和labels=[1],函数只计算了类别0和类别1的F1值。

在实际使用中,我们需要根据具体的任务和数据集来确定函数的参数。需要注意的是,average参数的选择可能会影响指标的结果。例如,在多元分类问题中,当average='macro’时,每个类别的指标将被等权重计算,这可能会导致某些类别的指标结果被低估。而当average='weighted’时,每个类别的指标将根据其支持度进行加权平均,这可能更符合实际应用中的情况。因此,在选择average参数时,需要考虑任务需求和数据特点,以确定最合适的参数。

除了average参数之外,pos_label参数的选择也可能会影响指标的结果。当我们的任务是检测某个特定的类别时,需要将该类别指定为正例,以保证指标的结果是针对该类别的。例如,当我们的任务是检测垃圾邮件时,我们需要将垃圾邮件的类别标签设为正例,以确保精确率和召回率的计算是基于垃圾邮件的。

需要注意的是,当存在类别样本数为0的情况时,函数可能会出现除以0的错误。在这种情况下,我们可以通过将zero_division参数设为0或其他值来处理该情况。如果我们希望函数抛出警告,可以将该参数设为’warn’。

总之,sklearn库中的f1_score函数可以方便地计算分类模型的F1值,需要根据具体任务和数据特点选择适当的参数,以获得准确的结果。

(2)precision_recall_fscore_support

sklearn库中的precision_recall_fscore_support函数可以计算分类模型的精确率、召回率、F1值以及每个类别的支持度(样本数量)。该函数的调用形式如下:

precision_recall_fscore_support(y_true, y_pred, labels=None, pos_label=1, average='binary', sample_weight=None, zero_division='warn')

其中,参数y_true是真实的类别标签,y_pred是分类器预测的类别标签;labels是类别列表,用于指定计算哪些类别的指标;pos_label是正例的类别标签;average是指标的计算方式,可以是’binary’、‘micro’、'macro’或’weighted’等;sample_weight是样本权重,用于不同样本对指标的贡献不同的情况;zero_division是指当某个类别的真实样本数或预测样本数为0时,指标计算的处理方式。

当average='binary’时,precision_recall_fscore_support函数将只计算正例的指标,pos_label参数用于指定正例的类别标签。当average='micro’时,函数将计算所有类别的指标的加权平均值,权重为每个类别的支持度。当average='macro’时,函数将计算所有类别的指标的算术平均值。当average='weighted’时,函数将计算所有类别的指标的加权平均值,权重为每个类别的支持度。

该函数的返回值为一个元组,包含精确率、召回率、F1值和每个类别的支持度。例如,假设我们有一个二元分类问题,正例标签为1,反例标签为0,预测结果如下:

y_true = [1, 0, 0, 1, 1, 0, 1, 0, 1, 1]

y_pred = [1, 1, 0, 1, 0, 0, 1, 0, 0, 1]

我们可以调用precision_recall_fscore_support函数来计算指标:

from sklearn.metrics import precision_recall_fscore_support

precision, recall, f1_score, support = precision_recall_fscore_support(y_true, y_pred)

print("Precision: ", precision)

print("Recall: ", recall)

print("F1 Score: ", f1_score)

print("Support: ", support)

输出结果为:

Precision: [0.8 0.66666667]

Recall: [0.66666667 0.8 ]

F1 Score: [0.72727273 0.72727273]

Support: [3 7]

上述代码中,由于我们没有指定labels参数,函数计算了所有类别的指标。返回值precision和recall是一个数组,分别表示所有类别的精确率和召回率;f1_score也是一个数组,表示所有类别的F1值;support也是一个数组,表示每个类别的支持度(样本数量)。

5. 结论

在分类任务中,我们需要使用一些指标来评估分类器的性能。混淆矩阵是一种可视化分类器性能的工具,它展示了分类器在测试集上的预测结果与真实结果之间的关系。精确率和召回率是两个重要的指标,它们常常相互影响,需要在两者之间取得一个平衡。F1值是精确率和召回率的调和平均值,它综合考虑了精确率和召回率两个指标,是衡量分类器性能的综合指标。文章来源:https://www.toymoban.com/news/detail-780970.html

在实际应用中,我们需要根据具体的任务和需求选择合适的指标。例如,在一些对分类准确度要求较高的任务中,精确率可能更为重要;而在一些需要尽可能找出所有正例的任务中,召回率可能更为重要。同时,我们也可以通过调整分类器的参数和特征来提高分类器的性能。文章来源地址https://www.toymoban.com/news/detail-780970.html

到了这里,关于混淆矩阵、精确率、召回率和F1值:如何评估分类器的性能?的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!