LLM开发者必读论文:检索增强(RAG)生成技术综述!

为机器学习和人工智能领域的爱好者、开发者和研究者提供了丰富的资源和学习机会,助您紧跟行业前沿,掌握最新技术动态。

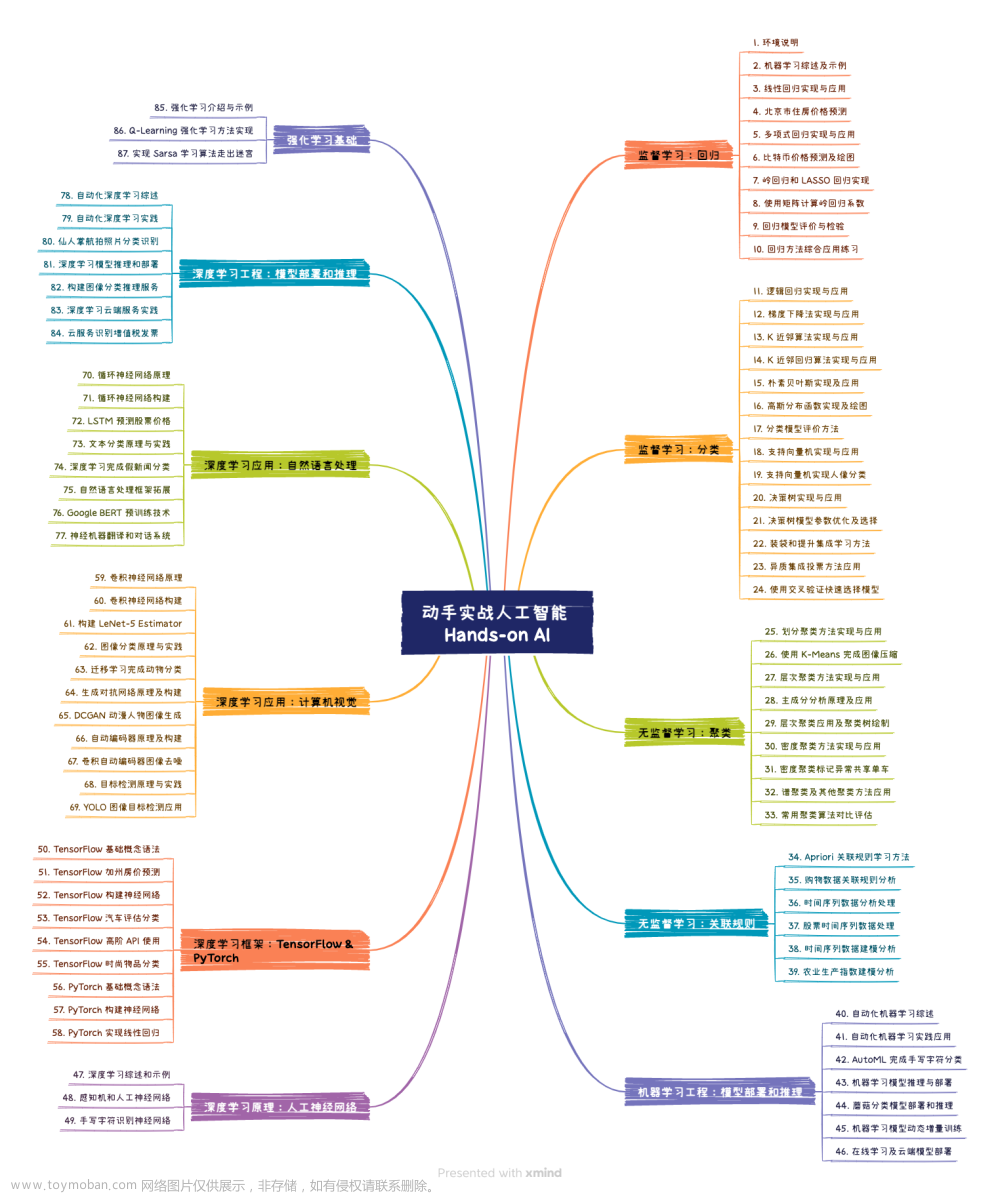

1、动手实战人工智能 Hands-on AI

地址:https://ai.huhuhang.com/intro

这个《动手实战人工智能 Hands-on AI》写的相当不错,作者用 Jupyter Notebook编写了这个教程,参考了《机器学习方法》,《深度学习入门》,西瓜书,花花书等,剖析和推导每一个基础算法的原理,将数学过程写出来了,同时基于 Python 代码对公式进行实现,做到公式和代码的一一对应。

我把章节简单整理成了这个思维导图,大家可以结合自身情况,挑选感兴趣的章节阅读。

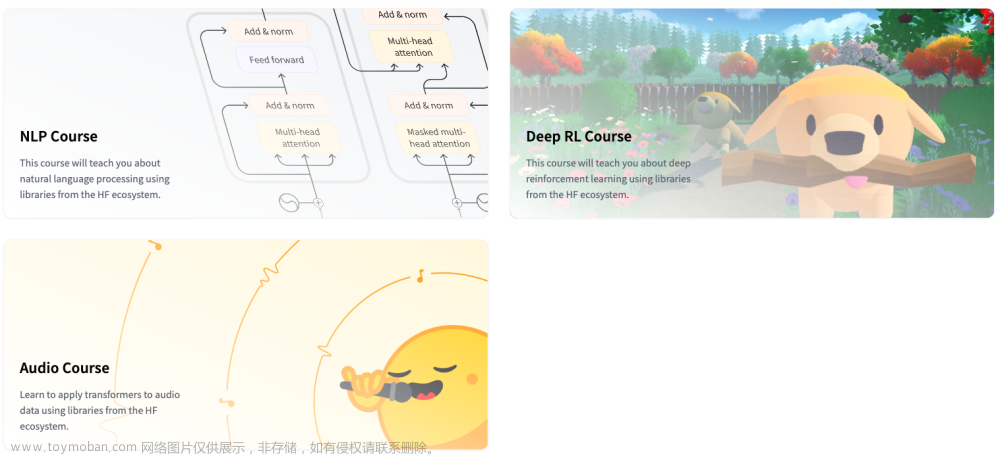

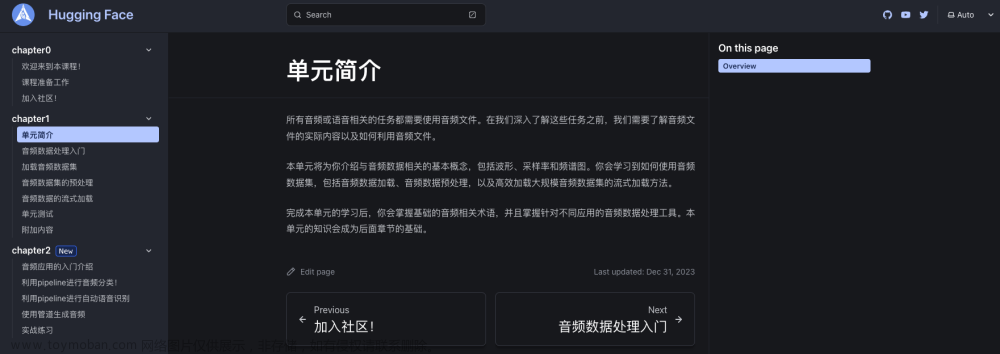

2、huggingface的NLP、深度强化学习、语音课

地址:https://huggingface.co/learn

HuggingFace开放了NLP、深度强化学习、基于transformer的语音框架三门课,看了每一课的结构,比较偏实践,蛮不错的。

我最近对语音比较感兴趣,加上正在学点前端,所以就把语音课拿出来,做了个文档型网页,准备一边学,一边翻译。

感兴趣的同学可以一起翻译:https://hf-audio.zhanglearning.com/

3、Awesome Jupyter

地址:https://github.com/markusschanta/awesome-jupyter

这个项目收录了精选的Jupyter项目、库和资源列表,已经更新了很多年,我比较喜欢可视化部分,认识了很多好玩的库。

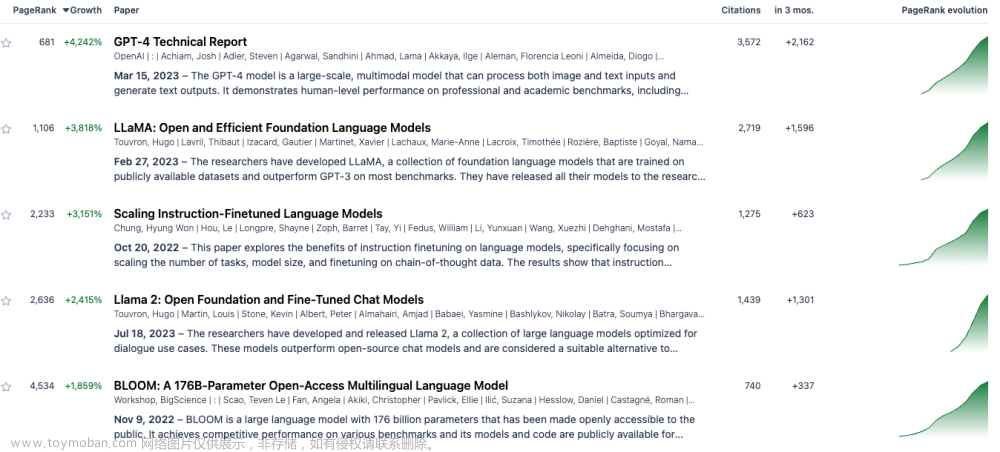

4、计算机科学热门论文

地址:https://trendingpapers.com/

trendingpapers这个网站每日更新计算机科学最新、最火的论文,分门别类,查找起来非常方便。打开感兴趣的论文,可以直接跳转到arxiv查看pdf,也可以点击Find similar找到该方向类似的论文。

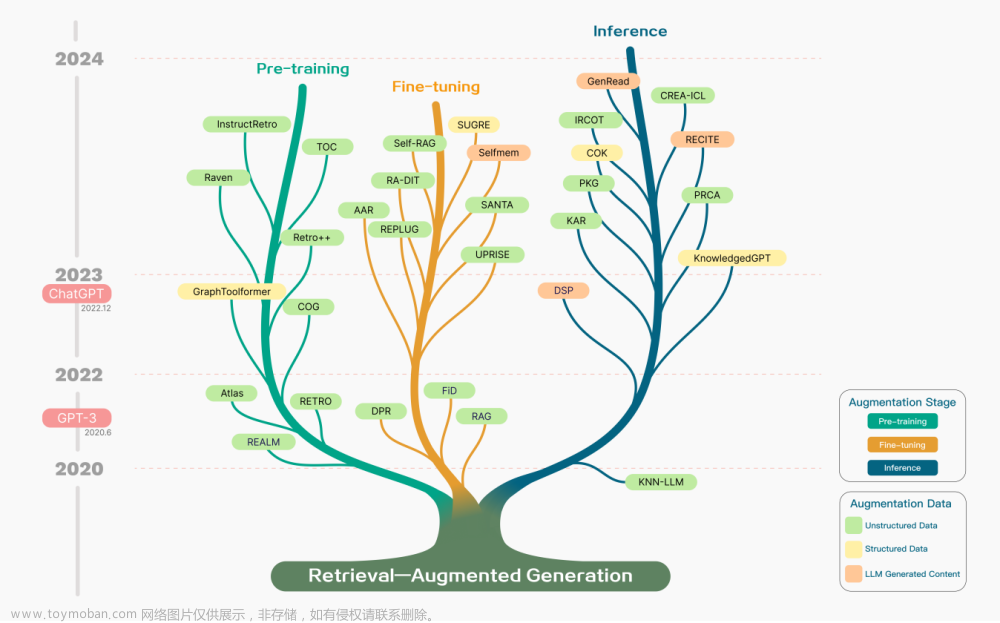

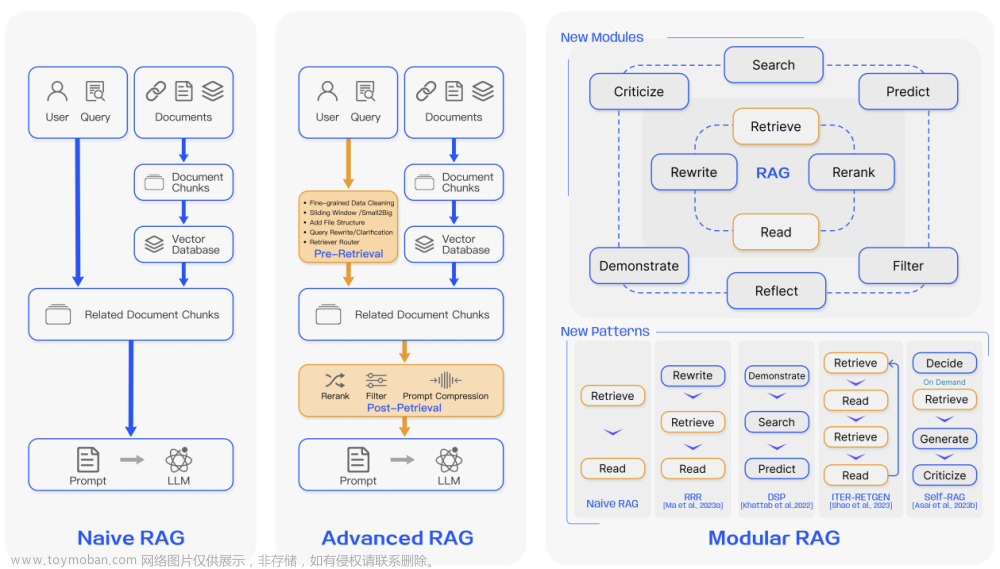

5、LLM开发者必读论文:检索增强(RAG)生成技术综述

论文:https://arxiv.org/abs/2312.10997

检索增强利用外部知识库来丰富大语言模型的上下文并生成答案,从而提升了答案的准确度。论文深入探讨并梳理了检索增强型生成( RAG)技术,非常全面。RAG是LLM领域最火爆的方向了,我在公众号中曾推荐过吴恩达老师最近的一个短课:吴恩达最新短课,构建和评估高级 RAG 应用程序,附中英字幕,感兴趣想要学习RAG,这个短课,建议作为首选。

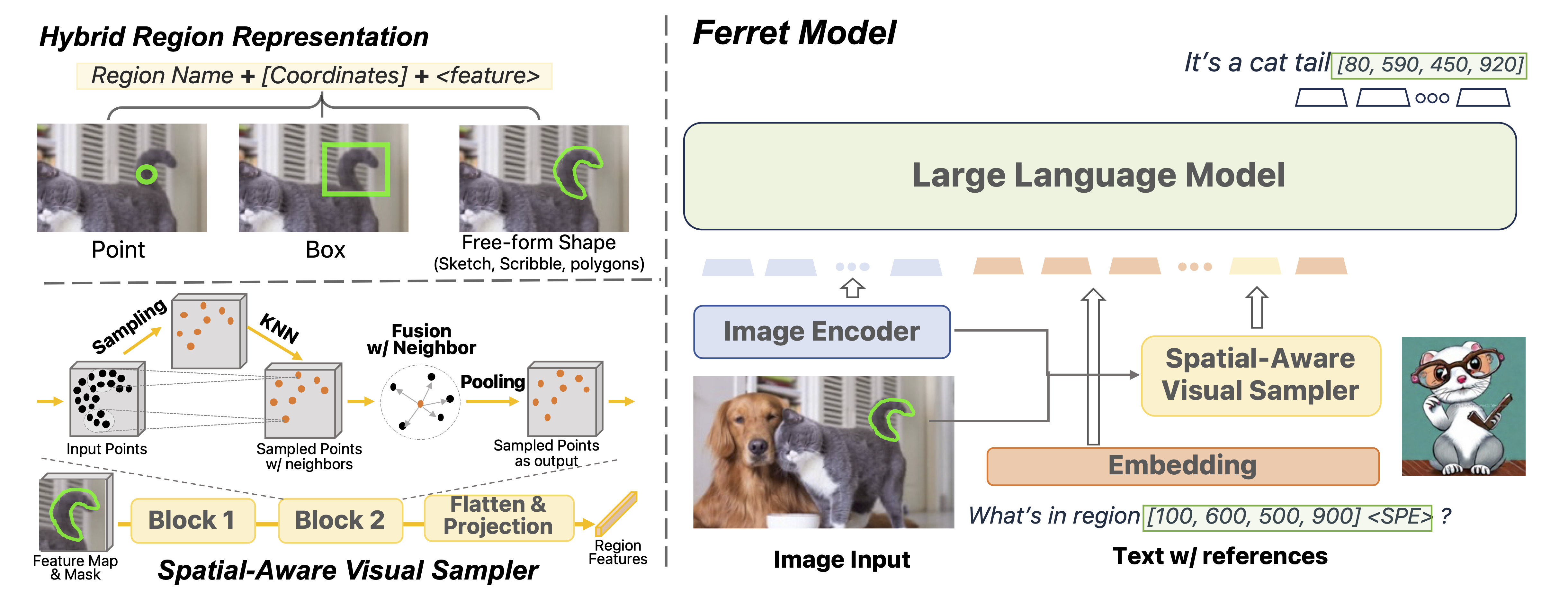

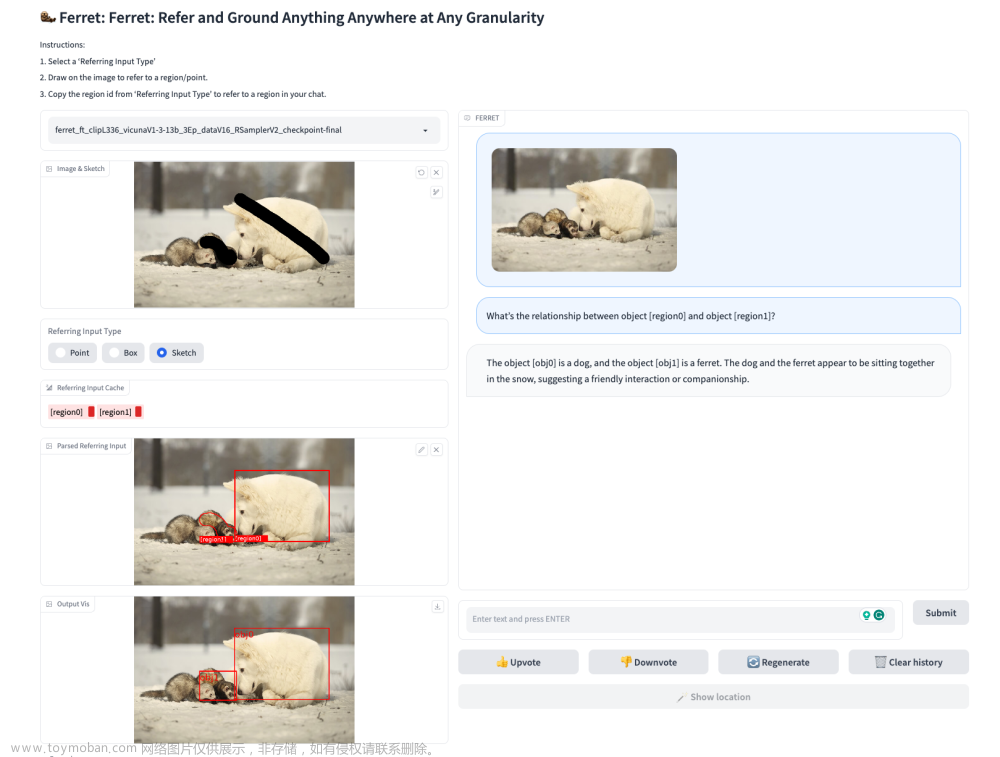

6、 Apple 公布了多模态大型语言模型 Ferret

地址:github.com/apple/ml-ferret

苹果最新公布的 Ferret 是一种新的多模态大型语言模型(MLLM),能够理解图像中任何形状或粒度的空间参考,并准确地理解词汇描述。

苹果最新公布的 Ferret 是一种新的多模态大型语言模型(MLLM),能够理解图像中任何形状或粒度的空间参考,并准确地理解词汇描述。

苹果开源了训练、微调、模型代码和模型权重:https://github.com/apple/ml-ferret/

可以下载、安装后一个命令运行gradio前端

python -m ferret.serve.gradio_web_server --controller http://localhost:10000 --model-list-mode reload --add_region_feature

7、免费的基于ChatGPT API的安卓端语音助手

地址:https://github.com/Skythinker616/gpt-assistant-android

这个项目是免费的、基于ChatGPT API的安卓端语音助手,可通过音量键唤起并进行语音交流,支持联网、Vision拍照识图、连续对话、提问模板、3.5/4.0接口、Markdown渲染等功能

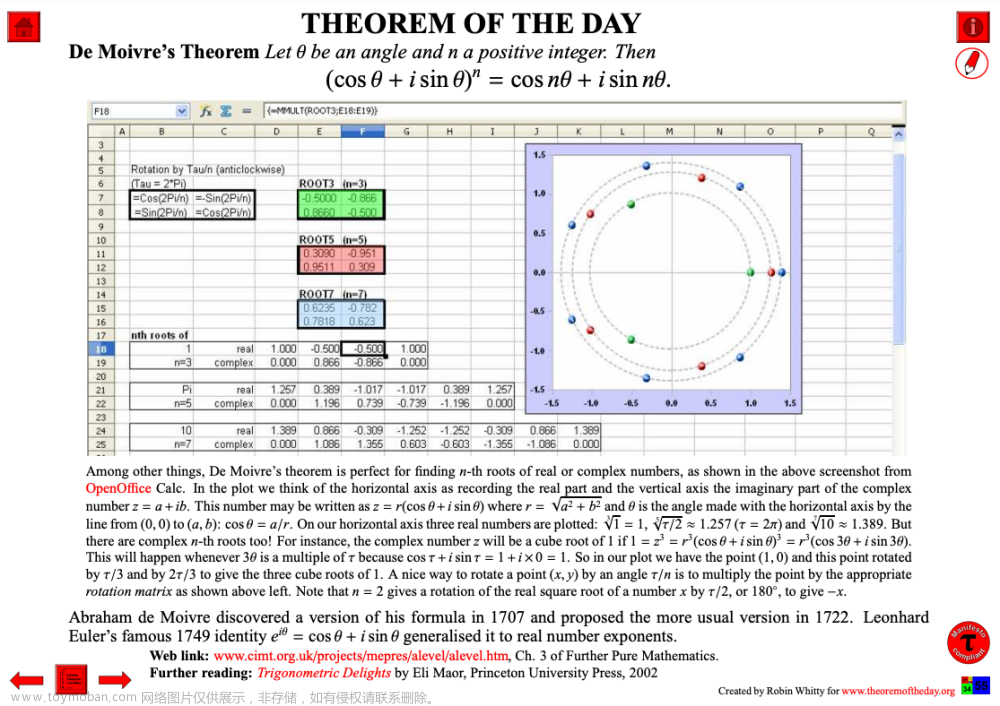

8、每日数学

地址:https://www.theoremoftheday.org/

这个网站每天更新一个数学定理(或引理、法则、公式或恒等式),每一个都足以装饰数学殿堂的墙壁。

每个定理都被设计得尽可能让广大观众能够欣赏,如果某个定理的表述看起来难以理解,可以继续查看附带的图形解释、巧妙的动画。

9、WhisperLive:接近实时的 OpenAI Whisper 实现

地址:https://github.com/collabora/WhisperLive

这个项目是一个实时转录应用程序,它使用 OpenAI Whisper 模型将语音输入(来自麦克风的现场音频输入 or预先录制的音频文件 )转换为文本输出。

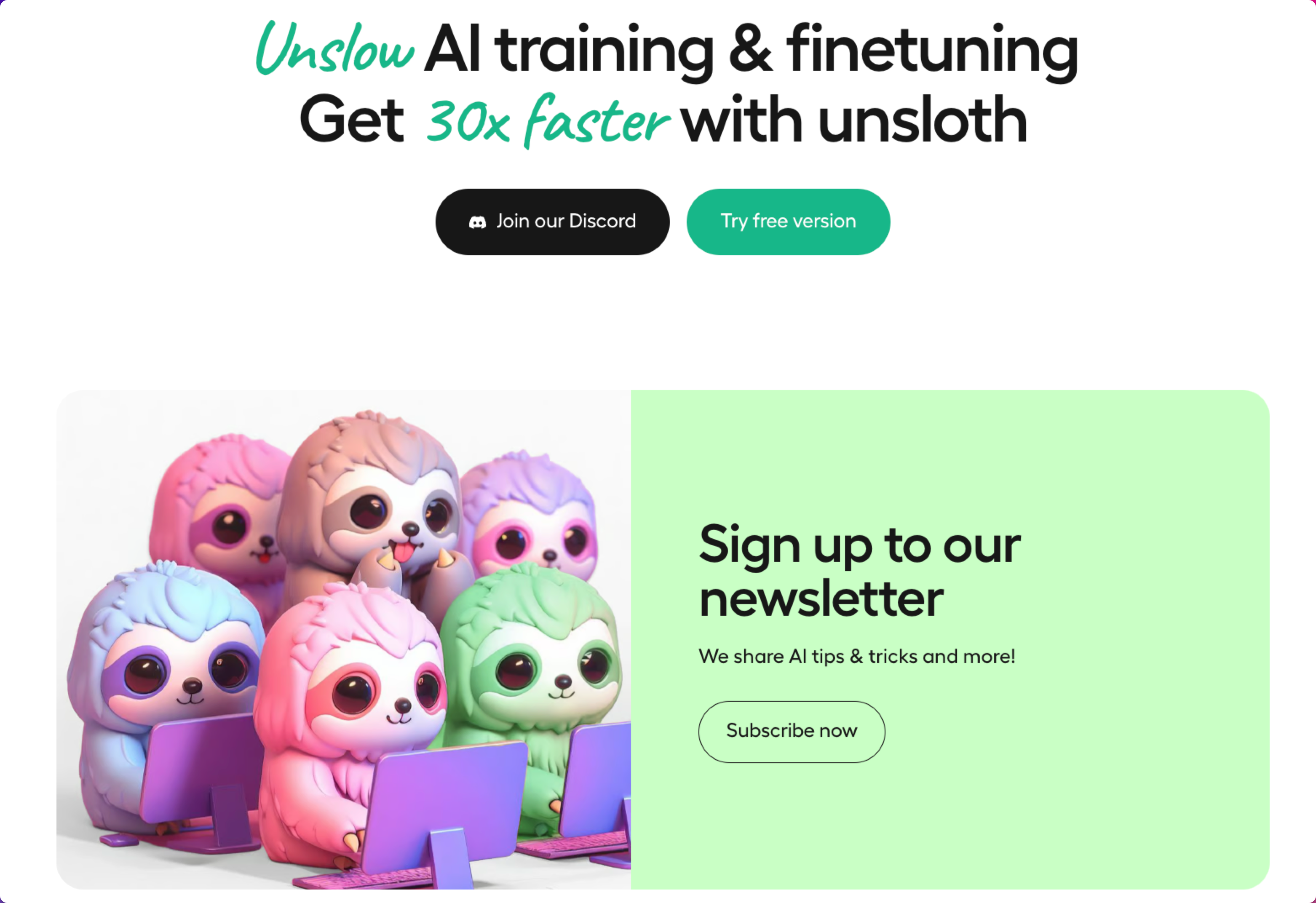

10、Unsloth

地址:https://github.com/unslothai/unsloth

训练大语言模型往往会消耗大量算力和时间,Unsloth开源的这个项目可以加快训练速度和效率。

支持 Llama 7b、13b、70b、CodeLlama 34b、Mistral 7b、TinyLlama 以及所有 Llama 架构!

Llama 7b Colab T4 实例在 1 T4 上比原来快 2 倍,使用的 VRAM 减少了 43%(8.4GB)LAION 数据集。Alpaca T4 实例在 1 T4 上也是快了 2 倍,使用了 6.4GB VRAM。

Mistral 7b Colab A100 实例在 1 A100 上快了 2.2 倍,使用的 VRAM 减少了 62%(12.4GB)。Colab T4 实例

CodeLlama 34b Colab 实例不会出现 OOM,速度提升了 1.9 倍,使用的 VRAM 减少了 32%(27GB)。

Kaggle 上使用 2 Tesla T4 的 Alpaca 训练速度提高了 5.28 倍。Kaggle 实例

所有内核均使用 OpenAI 的 Triton 语言编写。

准确率无损失 - 没有使用近似方法 - 全部精确。

无需更换硬件。支持自 2018 年以来的 NVIDIA GPU。最低 CUDA 计算能力 7.0(V100、T4、Titan V、RTX 20、30、40x、A100、H100、L40 等)检查您的 GPU

在 Linux 和 Windows 通过 WSL 上运行。

实验性支持 DPO(直接偏好优化)!

支持通过 bitsandbytes 进行 4bit 和 16bit QLoRA / LoRA 微调。

开源版本的训练速度提高了 5 倍,或者您可以查看 Unsloth Pro 和 Max 代码路径,以获得高达 30 倍的训练速度提升!

11、最后推荐三个AI工具

PIA:照片转动漫风格工具,可线上试用

地址:https://huggingface.co/spaces/Leoxing/PIA

带web界面的声音克隆工具

地址:https://github.com/jianchang512/clone-voice

cloudflare-ai-web

地址:https://github.com/Jazee6/cloudflare-ai-web文章来源:https://www.toymoban.com/news/detail-781417.html

支持GeminiPro Vision / Cloudflare Workers AI / ChatGPT的融合Web平台文章来源地址https://www.toymoban.com/news/detail-781417.html

到了这里,关于机器学习周刊 第4期:动手实战人工智能、计算机科学热门论文、免费的基于ChatGPT API的安卓端语音助手、每日数学、检索增强 (RAG) 生成技术综述的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!