记录一下我使用服务器期间遇到的问题以及解决方法(主要使用tensorflow)

先介绍一下我本次遇到的问题:

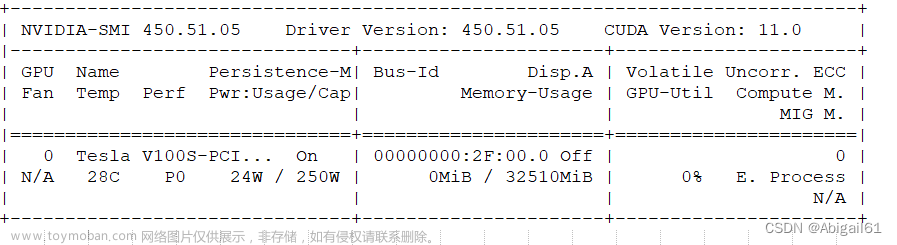

我在服务器上拥有一个独立的账号,我发现我的tensorflow无法调用GPU,先排查可能存在的问题

终端输入

nvcc -V

结果如下:

显示已经安装了11.8版本的CUDA

但是在python文件中调用

import tensorflow as tf

print(tf.test.is_gpu_available())结果显示为false

在终端输入

echo $LD_LIBRARY_PATH结果为空,猜测是没有安装cudnn,以下是解决过程

首先进入官网下载一个适配的cudnn版本,官网链接

因为我的CUDA版本是11.8,我选择v8.9.0 for CUDA 11.x的版本

下载后是一个.tar.xz的文件,直接上传到服务器中你的文件夹下,然后使用下面两条指令进行解压

xz -d cudnn-linux-x86_64-8.9.0.131_cuda11-archive.tar.xz

tar -xvf cudnn-linux-x86_64-8.9.0.131_cuda11-archive.tar解压得到一个文件夹,进入后包含下面三个

然后我们进入你个人账户下的.bashrc文件,在其中添加这样一行内容(根据你自己的路径进行更改):

export LD_LIBRARY_PATH="/home/Users/qjw/cudnn-linux-x86_64-8.9.0.131_cuda11-archive/lib:$LD_LIBRARY_PATH"之后保存.bashrc文件,然后在终端输入下面这个指令(我是在.bashrc文件这一层输入的,注意终端路径)

source ./.bashrc然后再次运行python代码:

import tensorflow as tf

print(tf.test.is_gpu_available())结果如下:

输出True,问题解决文章来源:https://www.toymoban.com/news/detail-781891.html

希望可以帮到你文章来源地址https://www.toymoban.com/news/detail-781891.html

到了这里,关于服务器已经存在CUDA但无法使用GPU的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![HTTP状态 404 - 未找到 类型 状态报告 消息 请求的资源[]不可用 描述 源服务器未能找到目标资源的表示或者是不愿公开一个已经存在的资源表示。 Apache Tomcat/8.5.70](https://imgs.yssmx.com/Uploads/2024/02/511446-1.png)