AIGC(AI generated content),新型内容生产方式。AIGC是利用人工智能技术来生成内容,也就是,它可以用输入数据生成相同或不同类型的内容,比如输入文字、生成文字,输入文字、生成图像等。

GPT-3是生成型的预训练变换模型,是一个自回归语言模型,神经网络包括1750亿个参数,在2020年5月发布论文。最新的GPT-3.5是GPT-3微调出来的版本。ChatGPT建立在GPT-3.5基础上,使用人类反馈强化学习去训练,所以能根据对话调整,带来更为复杂的互动效果,达到更逼近真人的效果。

而ChatGPT就是AIGC技术展示的成果。实际上ChatGPT就是一个大型的预训练语言生成模型,它使用了Transformer神经网络架构,也是GPT-3.5架构。

ChatGPT学习的四阶段:

1.学习文字接龙

2.人类老师引导文字接龙的方向

3.模仿人类老师的喜好(特征)

4.用增强式学习向模拟老师学习

1.让不完整的句子通过现有的数据预测下面的文字,从而达到文字接龙。

2.人工筛选哪些是好的、对的、应该被期望的答案,打高分。(训练一个打分模型)(人工标注的数据集:问题、答案、人类打的分)(第一个打分的数据集是基线。后面每次再做其他人工标注的数据集)

3.人类希望获得的答案就会被赋予更高分数。(引导GPT输出(说)人类要它说的)。(让打分模型根据排序进行打分)

4.每次将GPT得到的答案再丢给人类判断,是人类希望的回答就给高分,不是就给低分,这种模式称为增强式学习中的Reward模块。(每次让基线模型和打分模型就行对抗,不断优化)

ChatGPT并不完美,只要问些没人问过的问题(冷门问题不涵盖在数据集中),它就会给出错误的答案。另外,找文献的时候有概率是瞎编的。

GPT-3的社会负面影响:它可能被拿来生成假新闻、垃圾邮件,以及论文造假。由于GPT-3 的训练数据来自网络,其中包含了一些性别、宗教、种族歧视的信息,导致GPT-3 的生成文本也有同样的问题。

在某一个特定的任务上,某些利用带标号的文本数据的算法表现可能会超过GPT-3。但GPT-3的强大之处在于它的泛化能力。不需要微调,只需要在输入序列里用自然语言表述任务要求,就可以让网络执行不同的子任务,这是GPT-3令人惊艳的地方。

一、GPT系列发展介绍:

1.GPT-1(已开源)

首个GPT系列模型GPT-1诞生于2018年,也就是我们常说的NLP预训练模型元年。性能方面,GPT-1有着一定的泛化能力,能够用于和监督任务无关的NLP任务中。其常用任务包括:

自然语言推理:判断两个句子的关系(包含、矛盾、中立)

问答与常识推理:输入文章及若干答案,输出答案的准确率

语义相似度识别:判断两个句子语义是否相关

分类:判断输入文本是指定的哪个类别

虽然GPT-1在未经调试的任务上有一些效果,但其泛化能力远低于经过微调的有监督任务,因此GPT-1只能算得上一个还算不错的语言理解工具而非对话式AI。

2.GPT-2(已开源)

于2019年如期而至。相比于GPT-1,GPT-2并没有对原有的网络进行过多的结构创新与设计,只使用了更多的网络参数与更大的数据集:最大模型共计48层,参数量达15亿,学习目标则使用无监督预训练模型做有监督任务。

在性能方面,OpenAI的大力似乎真的带来了一些奇迹。除了理解能力外,GPT-2在生成方面第一次表现出了强大的天赋:阅读摘要、聊天、续写、编故事,甚至生成假新闻、钓鱼邮件或在网上扮演他人通通不在话下。在“变得更大”之后,GPT-2的确展现出了一些列普适而强大的能力,并在多个特定的语言建模任务上实现了彼时的最佳性能。

3.GPT-3(未开源)

自GPT-2取得成功以来,OpenAI对“大力神教”的信仰愈发坚定,2020年放出的GPT-3继续沿用微创新、猛扩大的发展思路。除了GPT-3中的Transformer应用了Sparse结构外,GPT-3与GPT-2的结构几乎没有区别。而在“大力”方面,GPT-3的模型上到了96层,训练参数则是达到了1750亿个(GPT-2的10倍以上)。

而GPT-3也再次证明了OpenAI的眼光,由于GPT-3更强的性能和明显更多的参数,它包含了更多的主题文本,显然优于前代的GPT-2。作为目前最大的密集型神经网络,GPT-3能够将网页描述转换为相应代码、模仿人类叙事、创作定制诗歌、生成游戏剧本,甚至模仿已故的各位哲学家——预测生命的真谛。且GPT-3不需要微调,在处理语法难题方面,它只需要一些输出类型的样本(少量学习)。可以说GPT-3似乎已经满足了我们对于语言专家的一切想象。

4.GPT-3.5(未开源)

GPT-3的微调版本,比如ChatGPT就用了这个。

5.GPT-4预测(OpenAI已经在训练GPT-4,并计划于12月-2月间发布)

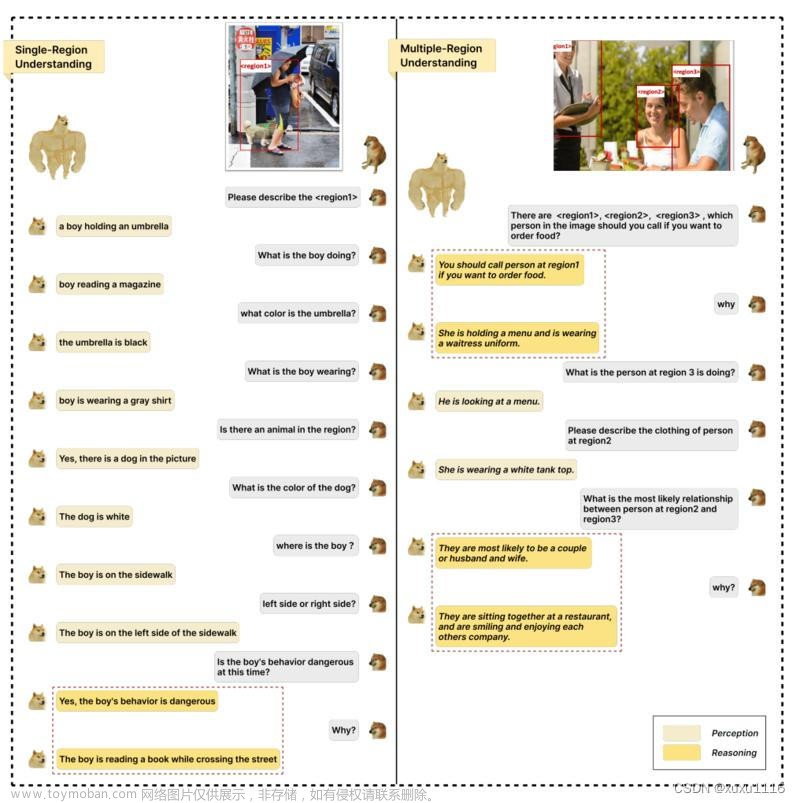

GPT-4将很有可能不仅只是一个语言模型。OpenAI首席科学家Ilya Sutskever曾在其撰写的多模态相关文章中暗示过这一点——“文字本身即可表达关于这个世界的大量信息,但毕竟是不完整的,因为我们也生活在视觉世界之中。”因此,业界部分专家认为GPT-4将会是多模态的,可以接受音频、文本、图像甚至是视频输入,并预测OpenAI的Whisper的音频数据集将用于创建GPT-4所需的文本数据。这也意味着GPT-4对于外界信息的接收与处理将不会再有任何局限性。

工业界关注GPT-4的原因,则很有可能是由于GPT-4的实际商用门槛将比传统GPT-3更低。此前由于巨额费用和基础设施原因而未能使用相关技术的企业也将有望使用GPT-4。目前GPT-4已进入上市的最后阶段,将于今年12月至明年2月期间发布。剑桥AI研究公司分析师Alberto Garcia通发表了博客并预测:“GPT-4将更专注于优化数据处理,因此GPT-4的学习成本预计将低于GPT-3。GPT-4的每集学习成本将可能由GPT-3的数百万美元将至100万美元左右”。

二、GPT-1模型结构介绍:

1.GPT介绍

GPT是OpenAI公司提出的一种语言预训练模型.

正是因为训练方法上的区别, 使得GPT更擅长处理自然语言生成任务(NLG), 而BERT更擅长处理自然语言理解任务(NLU).

2.GPT的架构

GPT采用了Transformer架构中的解码器模块.

将传统的3层Decoder Block变成了2层Block, 删除了encoder-decoder attention子层, 只保留Masked Multi-Head Attention子层和Feed Forward子层.

由12个改造后的Decoder Block组成的.

3.GPT训练过程

GPT的训练也是典型的两阶段过程:

第一阶段: 无监督的预训练语言模型. 只利用单词前面的信息来预测当前单词.

第二阶段: 有监督的下游任务fine-tunning.

二、GPT2模型介绍

1.GPT2的架构

GPT2只采用了Transformer架构中的Decoder模块.

GPT2是在GPT基础上发展处的更强大的语言预训练模型.

2.GPT2的工作细节:

GPT2可以处理最长1024个单词的序列.

每个单词都会和它的前序路径一起"流经"所有的解码器模块.

GPT2本质上也是自回归模型.

输入张量要经历词嵌入矩阵和位置编码矩阵的加和后, 才能输入进transformer模块中.

3.GPT2自注意力机制的细节:

首先, GPT2的自注意力是Masked self-attention, 只能看见左侧的序列, 不能看见右侧的信息.

Query, Key, Value这三个张量之间的形象化的例子, 生动的说明了各自的作用和运算方式.文章来源:https://www.toymoban.com/news/detail-783468.html

最后的输出可以采用多个方法, 贪心方案, 概率分布方案, 或者top-k方案等.文章来源地址https://www.toymoban.com/news/detail-783468.html

到了这里,关于AIGC、ChatGPT、GPT系列?我的认识的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!