1. 官网安装Python 3.9

Python Release Python 3.9.0 | Python.org

2. 安装pycharm

https://download.jetbrains.com/python/pycharm-professional-2023.3.2.exe

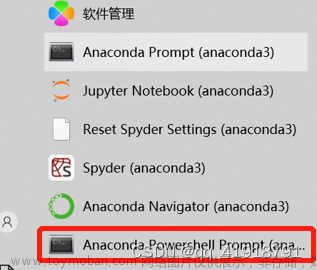

3. 安装miniconda

Miniconda — miniconda documentation

4. 安装完miniconda 创建虚拟环境

conda create -n wave2 python=3.9

conda activate wave2

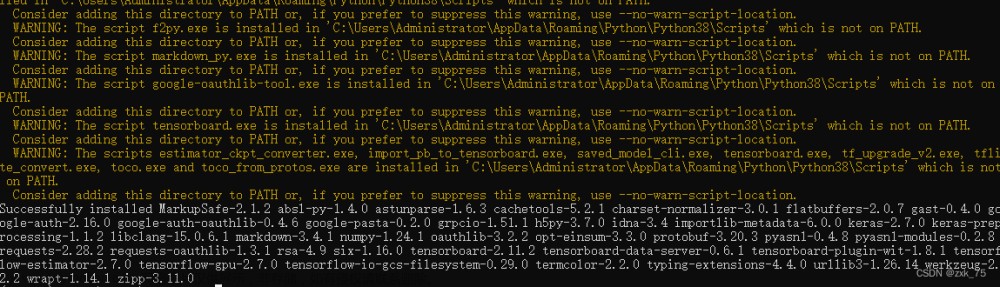

6. 安装依赖包

pip install numpy

pip show numpy

显示c:\users\xx\.conda\envs\wave2\lib\site-packages

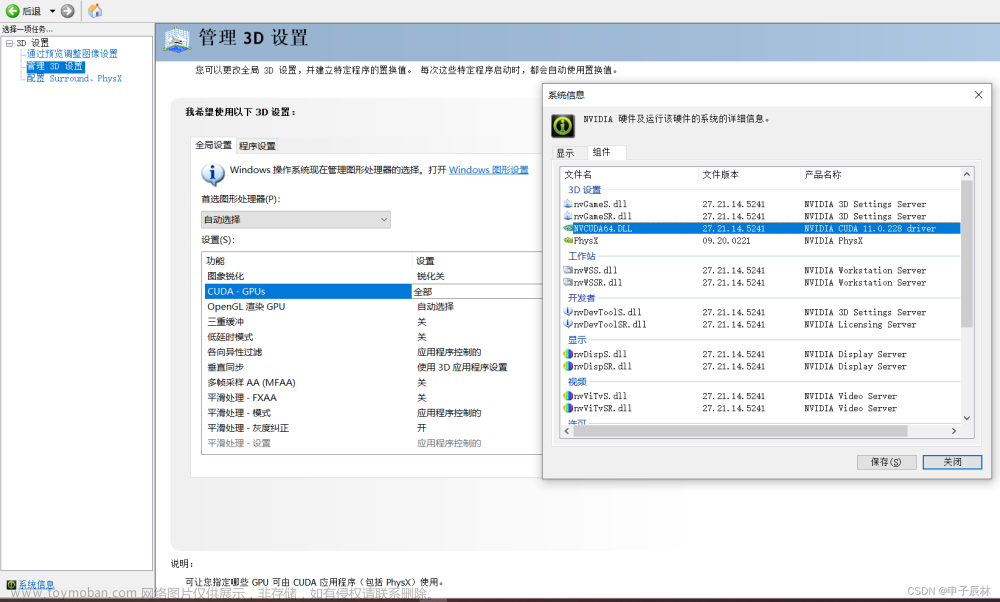

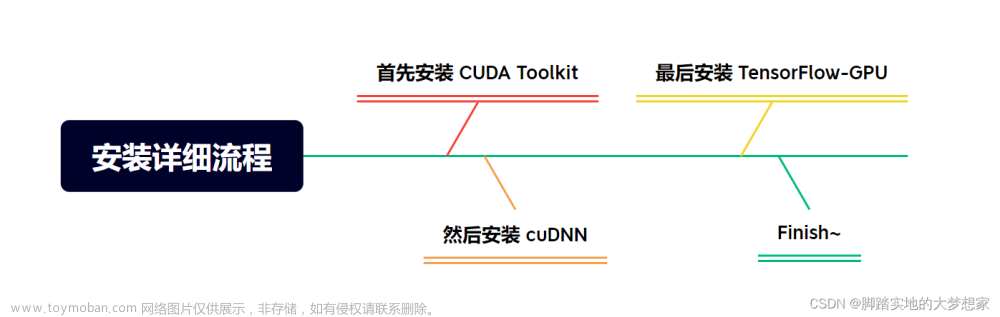

7. Python安装cuda 参考资料

Python+PyCharm+PyTorch+Cuda/GPU 安装步骤_python 中使用pycharam 使安装cuda-CSDN博客

nvidia-smi

有Nvidia显卡,想用GPU跑程序时

先查版本!

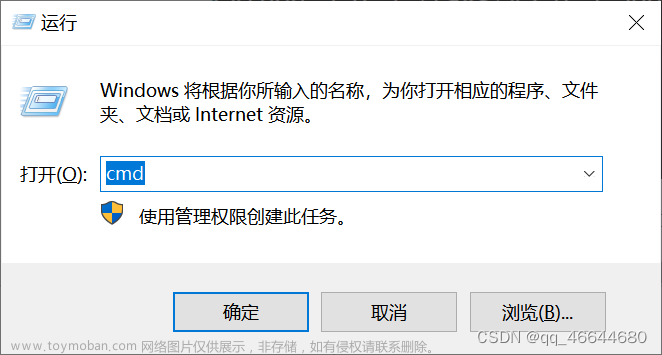

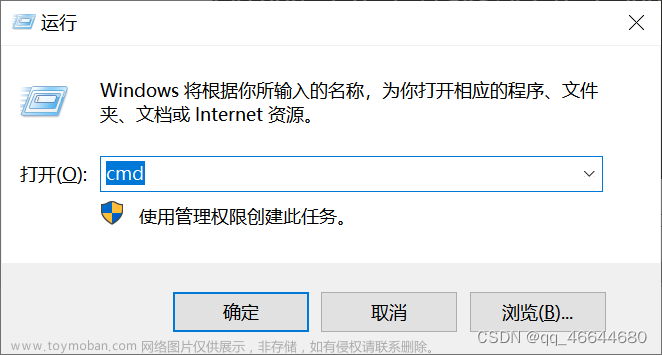

(1) 确定显卡支持的cuda版本

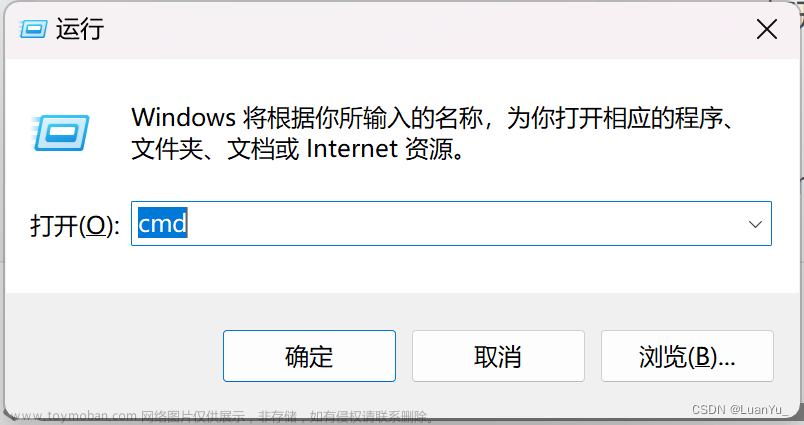

在cmd命令行中输入命令:“nvidia-smi”回车(如提示命令不可用,可先执行命令:cd C:\Program Files\NVIDIA Corporation\NVSMI)

NVIDIA-SMI 546.01

Driver Version: 546.01

CUDA Version: 12.3文章来源:https://www.toymoban.com/news/detail-783493.html

文章来源地址https://www.toymoban.com/news/detail-783493.html

文章来源地址https://www.toymoban.com/news/detail-783493.html

import torch

import time

def simulate_gpu_load_torch(usage_percentage, duration):

# 检查是否有可用的GPU,如果没有,将使用CPU

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 模拟 GPU 计算任务

data = torch.rand((1000, 1000), device=device)

result = torch.matmul(data, data)

# 控制 GPU 使用率

busy_time = duration * (usage_percentage / 100)

idle_time = duration - busy_time

start_time = time.time()

while (time.time() - start_time) < duration:

result = torch.matmul(data, data)

time.sleep(busy_time)

# 空闲时间不进行计算

time.sleep(idle_time)

# 控制 GPU 使用率为50%,持续10秒

simulate_gpu_load_torch(50, 10)from ast import Break

import torch

import torch.nn as nn

import os

torch.backends.cudnn.benchmark = False # 关闭 CuDNN 的 benchmark 模式

torch.backends.cudnn.deterministic = True # 开启 deterministic 模式

torch.cuda.empty_cache() # 清理未使用的 GPU 内存

# 设置设备

device = torch.device('cuda')

global memory_used

# 模型

# model = nn.Sequential(

# nn.Linear(1024, 2048),

# nn.ReLU(),

# nn.Linear(2048, 4096), # 更多神经元

# nn.ReLU(),

# nn.Linear(4096, 8192), # 更多神经元

# nn.ReLU(),

# nn.Linear(8192, 4096), # 更多神经元

# nn.ReLU(),

# nn.Linear(4096, 2048), # 更多神经元

# nn.ReLU(),

# nn.Linear(2048, 1024)

# ).to(device)

model = nn.Sequential(

nn.Linear(1024, 512),

nn.ReLU(),

nn.Linear(512, 1024),

nn.ReLU(),

nn.Linear(1024, 2048), # 更多神经元

nn.ReLU(),

nn.Linear(2048, 4096), # 更多神经元

nn.ReLU(),

nn.Linear(4096, 2048), # 更多神经元

nn.ReLU(),

nn.Linear(2048, 4096), # 更多神经元

nn.ReLU(),

nn.Linear(4096, 2048), # 更多神经元

nn.ReLU(),

nn.Linear(2048, 4096), # 更多神经元

nn.ReLU(),

nn.Linear(4096, 2048), # 更多神经元

nn.ReLU(),

nn.Linear(2048, 1024), # 更多神经元

nn.ReLU(),

nn.Linear(1024, 512),

nn.ReLU(),

nn.Linear(512, 1024)

).to(device)

# 优化器

optimizer = torch.optim.SGD(model.parameters(), lr=0.1)

# 设置最大内存

max_memory = 4 * 1024 * 1024 * 1024

#max_memory = 4096

# 初始参数

batch_size = 1024

# batch_size =512

memory_used = 0

#torch.cuda.empty_cache() # 关闭内存回收

#while memory_used < max_memory:

totalmemory_used =0

while True:

# 生成数据

#count +=1

#inputs = torch.rand(batch_size, 1024).to(device)

inputs = torch.rand(batch_size, 1024).to(device)

# 前向传播

outputs = model(inputs)

# 反向传播和优化

loss = outputs.mean()

loss.backward()

optimizer.step()

device = torch.device('cuda') # 或者 'cuda:0',如果有多个GPU

# 获取当前GPU的显存占用量

memory_used = torch.cuda.memory_allocated(device)

# 将字节转换为兆字节(MB)

memory_used_mb = memory_used / (1024 * 1024)

totalmemory_used += memory_used_mb

print(totalmemory_used)

torch.cuda.empty_cache()

# if count == 10:

# break

# 更新内存和batchsize

#memory_used += 1024 * 1024 * 1024

# if int(torch.cuda.memory_allocated(device)) >= max_memory:

# break

os.system('nvidia-smi')

#if totalmemory_used > 4096:

# break

#batch_size += 1024

到了这里,关于Windows下Python+PyCharm+miniconda+Cuda/GPU 安装步骤的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!