目录

torch.nn子模块Dropout Layers详解

nn.Dropout

用途

用法

使用技巧

注意事项

代码示例

nn.Dropout1d

用途

用法

使用技巧

注意事项

代码示例

nn.Dropout2d

用途

用法

使用技巧

注意事项

代码示例

nn.Dropout3d

用途

用法

使用技巧

注意事项

代码示例

nn.AlphaDropout

用途

用法

使用技巧

注意事项

代码示例

nn.FeatureAlphaDropout

用途

用法

使用技巧

注意事项

代码示例

总结

torch.nn子模块Dropout Layers详解

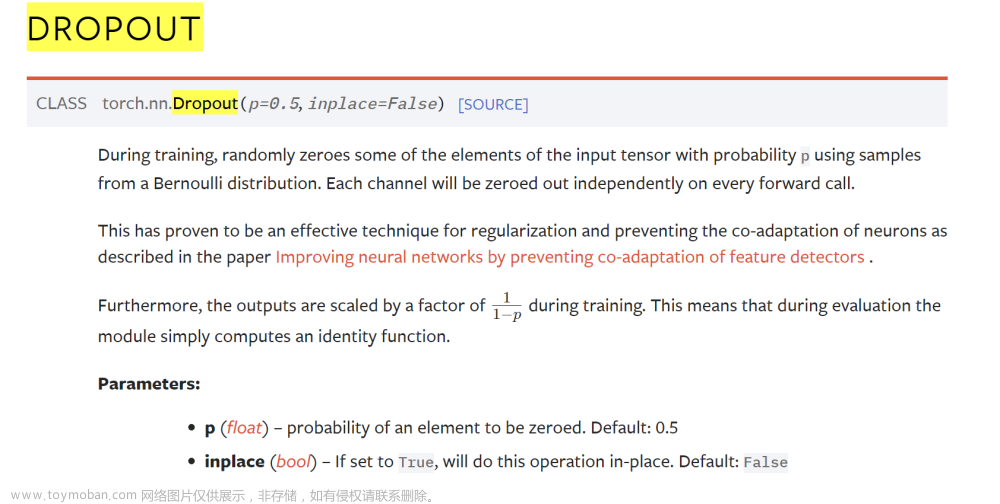

nn.Dropout

torch.nn.Dropout 是 PyTorch 深度学习框架中的一个模块,主要用于在训练神经网络时进行正则化和防止神经元间的共同适应。下面我将详细解释这个模块的用途、用法、使用技巧和注意事项,并提供一个代码示例。

用途

-

正则化:

Dropout通过在每次前向传播时随机将输入张量的某些元素置零,从而减少模型对特定数据的依赖,提高泛化能力。 - 防止共同适应:通过随机关闭神经网络中的某些神经元,迫使网络分散学习特征,防止神经元之间的过度依赖。

用法

-

p参数:表示每个元素被置零的概率。默认值为0.5。 -

inplace参数:如果设置为True,将直接在原始输入上进行操作,以节省内存。默认值为False。

使用技巧

- 通常在全连接层之后使用

Dropout。 - 在训练时使用

Dropout,但在验证和测试时不使用。可以通过模型的.train()和.eval()方法来控制。 -

p的选择取决于具体问题和模型架构,一般介于0.2到0.5。

注意事项

-

Dropout只应在训练阶段使用,不应在评估和测试阶段使用。 - 在使用

inplace=True时,确保它不会影响后续计算。

代码示例

import torch

import torch.nn as nn

# 创建 Dropout 模块,置零概率为 0.2

m = nn.Dropout(p=0.2)

# 随机生成输入数据

input = torch.randn(20, 16)

# 应用 Dropout

output = m(input)

# 输出处理后的数据

print(output)

此示例创建了一个 Dropout 模块,设置置零概率为 0.2。然后,它生成一个随机张量作为输入,并应用 Dropout,打印处理后的输出。注意,在实际应用中,应将此模块嵌入到更大的神经网络架构中,并在训练时激活,在评估和测试时禁用。

nn.Dropout1d

torch.nn.Dropout1d 是 PyTorch 中的一个特定类型的 Dropout 模块,它专门用于处理一维特征图(1D feature maps)。这种类型的 Dropout 在处理一维卷积层(例如来自 nn.Conv1d)的输出时特别有用。下面是对 Dropout1d 的详细解释,包括它的用途、使用方式、技巧和注意事项。

用途

-

通道级正则化:

Dropout1d通过随机将整个通道(1D 特征图)置零来进行正则化,有助于减少过拟合。 -

增强特征图之间的独立性:在一维卷积层的输出上应用

Dropout1d可以促进不同特征图之间的独立性,这在深层网络中尤其重要。

用法

-

参数

p:表示一个通道被置零的概率。例如,p=0.2意味着每个通道有 20% 的概率在每次前向传播时被置零。 -

参数

inplace:如果设置为True,将直接在输入上进行操作,以节省内存。

使用技巧

- 适用于一维卷积层的输出。

- 在训练过程中使用,但在模型评估和测试时应关闭。

- 选择适当的

p值来平衡正则化强度和网络性能。

注意事项

- 仅在训练阶段使用,测试或评估时应禁用。

- 使用

inplace=True时要注意不要影响到后续计算。

代码示例

import torch

import torch.nn as nn

# 创建 Dropout1d 模块

m = nn.Dropout1d(p=0.2)

# 随机生成一维卷积层的输出数据

input = torch.randn(20, 16, 32)

# 应用 Dropout1d

output = m(input)

# 输出处理后的数据

print(output)

在这个示例中,我们创建了一个 Dropout1d 模块,并设置了 20% 的置零概率。然后,我们生成了一个模拟的一维卷积层输出,并应用了 Dropout1d。这种方式有助于在训练复杂网络时提高其泛化能力。

nn.Dropout2d

torch.nn.Dropout2d 是 PyTorch 框架中用于处理二维特征图(2D feature maps)的 Dropout 类型。这种 Dropout 特别适用于二维卷积层(如 nn.Conv2d)的输出。以下是关于 Dropout2d 的详细说明,包括其用途、用法、技巧和注意事项。

用途

-

通道级正则化:

Dropout2d通过随机将整个通道(2D 特征图)置零,从而在训练神经网络时提供正则化,有助于减少过拟合。 -

增强特征图间的独立性:在二维卷积层的输出上使用

Dropout2d可以促进不同特征图之间的独立性,这对于复杂的网络架构尤其重要。

用法

-

参数

p:表示一个通道被置零的概率。例如,p=0.2意味着每个通道有 20% 的概率在每次前向传播时被置零。 -

参数

inplace:如果设置为True,将直接在输入上进行操作,以节省内存。

使用技巧

- 主要用于处理来自二维卷积层的输出。

- 在训练过程中使用,但在模型评估和测试时应关闭。

- 根据具体的应用场景和网络架构选择合适的

p值。

注意事项

- 仅在训练阶段使用,测试或评估时应禁用。

- 使用

inplace=True时要注意不要影响到后续计算。 - 注意

Dropout2d当前不支持没有批次维度的 3D 输入,这可能在未来的版本中改变。

代码示例

import torch

import torch.nn as nn

# 创建 Dropout2d 模块

m = nn.Dropout2d(p=0.2)

# 随机生成二维卷积层的输出数据

input = torch.randn(20, 16, 32, 32)

# 应用 Dropout2d

output = m(input)

# 输出处理后的数据

print(output)

在这个示例中,我们创建了一个 Dropout2d 模块,并设置了 20% 的置零概率。然后,我们生成了一个模拟的二维卷积层输出,并应用了 Dropout2d。这种方法有助于在训练复杂的卷积神经网络时提高其泛化能力。

nn.Dropout3d

torch.nn.Dropout3d 是 PyTorch 框架中的一个 Dropout 变体,专门用于处理三维特征图(3D feature maps)。这种 Dropout 形式主要用于三维卷积层(如 nn.Conv3d)的输出。以下是关于 Dropout3d 的详细解释,包括其用途、用法、技巧和注意事项。

用途

-

通道级正则化:

Dropout3d通过随机将整个通道(3D 特征图)置零来进行正则化,有助于减少过拟合。 -

增强特征图间的独立性:在三维卷积层的输出上使用

Dropout3d可以促进不同特征图之间的独立性,这在处理视频或体积数据时特别重要。

用法

-

参数

p:表示一个通道被置零的概率。例如,p=0.2意味着每个通道有 20% 的概率在每次前向传播时被置零。 -

参数

inplace:如果设置为True,将直接在输入上进行操作,以节省内存。

使用技巧

- 主要用于处理来自三维卷积层(

nn.Conv3d)的输出。 - 在训练过程中使用,但在模型评估和测试时应关闭。

- 根据具体应用场景和网络架构选择合适的

p值。

注意事项

- 仅在训练阶段使用,测试或评估时应禁用。

- 使用

inplace=True时要注意不要影响到后续计算。

代码示例

import torch

import torch.nn as nn

# 创建 Dropout3d 模块

m = nn.Dropout3d(p=0.2)

# 随机生成三维卷积层的输出数据

input = torch.randn(20, 16, 4, 32, 32)

# 应用 Dropout3d

output = m(input)

# 输出处理后的数据

print(output)

在这个示例中,我们创建了一个 Dropout3d 模块,并设置了 20% 的置零概率。然后,我们生成了一个模拟的三维卷积层输出,并应用了 Dropout3d。这种方法有助于在训练涉及视频或体积数据的复杂神经网络时提高其泛化能力。

nn.AlphaDropout

torch.nn.AlphaDropout 是 PyTorch 框架中的一个特殊类型的 Dropout 模块,它与 SELU(Scaled Exponential Linear Unit)激活函数结合使用,以维持自归一化网络的特性。以下是关于 AlphaDropout 的详细解释,包括它的用途、用法、技巧和注意事项。

用途

-

维持自归一化属性:

AlphaDropout用于保持输入数据的均值和标准差不变。这对于使用 SELU 激活函数的网络极为重要,因为 SELU 需要输入数据具有零均值和单位方差。 -

提高泛化能力:与常规 Dropout 类似,

AlphaDropout也有助于减少过拟合,提高模型的泛化能力。

用法

-

参数

p:表示元素被随机屏蔽的概率。默认值为0.5。 -

参数

inplace:如果设置为True,将直接在输入上进行操作,以节省内存。

使用技巧

- 与 SELU 激活函数结合使用:

AlphaDropout设计用于与 SELU 激活函数结合使用,以保持自归一化网络的特性。 - 在训练期间使用,但在评估和测试时关闭。

注意事项

- 主要用于 SELU 激活函数的网络。

- 仅在训练阶段使用,测试或评估时应禁用。

- 使用

inplace=True时要注意不要影响到后续计算。

代码示例

import torch

import torch.nn as nn

# 创建 AlphaDropout 模块

m = nn.AlphaDropout(p=0.2)

# 随机生成输入数据

input = torch.randn(20, 16)

# 应用 AlphaDropout

output = m(input)

# 输出处理后的数据

print(output)

在这个示例中,我们创建了一个 AlphaDropout 模块,并设置了 20% 的屏蔽概率。然后,我们生成了一个随机输入,并应用了 AlphaDropout。由于 AlphaDropout 专门设计用于与 SELU 激活函数一起使用,因此它在维持网络的自归一化属性方面特别有效。

nn.FeatureAlphaDropout

torch.nn.FeatureAlphaDropout 是 PyTorch 中的一种特殊的 Dropout 形式,旨在与 SELU(Scaled Exponential Linear Unit)激活函数结合使用,以维持自归一化网络的性质。下面是关于 FeatureAlphaDropout 的详细解释,包括其用途、用法、技巧和注意事项。

用途

-

维持自归一化特性:与

AlphaDropout类似,FeatureAlphaDropout也是为了维持自归一化网络的特性而设计。它通过在通道级别上随机屏蔽特征图来实现这一点。 - 与 SELU 激活函数结合使用:此 Dropout 形式特别适合与 SELU 激活函数结合使用,因为它不仅将激活值置零,还将它们设置为 SELU 函数的负饱和值。

用法

-

参数

p:表示通道被随机屏蔽的概率。默认值为0.5。 -

参数

inplace:如果设置为True,将直接在输入上进行操作,以节省内存。

使用技巧

- 主要用于处理多维特征图(如图像或视频数据)。

- 在训练过程中使用,但在评估和测试时应关闭。

- 与 SELU 激活函数结合使用,以保持网络的自归一化特性。

注意事项

- 仅在训练阶段使用,测试或评估时应禁用。

- 使用

inplace=True时要注意不要影响到后续计算。

代码示例

import torch

import torch.nn as nn

# 创建 FeatureAlphaDropout 模块

m = nn.FeatureAlphaDropout(p=0.2)

# 随机生成多维特征图的输入数据

input = torch.randn(20, 16, 4, 32, 32)

# 应用 FeatureAlphaDropout

output = m(input)

# 输出处理后的数据

print(output)

在这个示例中,我们创建了一个 FeatureAlphaDropout 模块,并设置了 20% 的屏蔽概率。然后,我们生成了一个模拟的多维特征图输入,并应用了 FeatureAlphaDropout。这种方法有助于在训练复杂神经网络时,尤其是在使用 SELU 激活函数时,保持网络的自归一化特性。文章来源:https://www.toymoban.com/news/detail-784987.html

总结

本篇博客全面详细地解析了 PyTorch 框架中的 Dropout Layers 系列,包括 nn.Dropout, nn.Dropout1d, nn.Dropout2d, nn.Dropout3d, nn.AlphaDropout 和 nn.FeatureAlphaDropout。这些模块是深度学习中重要的工具,用于提高模型的泛化能力并防止过拟合。文章不仅讲解了每种 Dropout 的用途和应用场景,还提供了相关的使用技巧、注意事项和代码示例。文章来源地址https://www.toymoban.com/news/detail-784987.html

到了这里,关于PyTorch简单易懂的解析 Dropout Layers应用,代码示例的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!