博主介绍:黄菊华老师《Vue.js入门与商城开发实战》《微信小程序商城开发》图书作者,CSDN博客专家,在线教育专家,CSDN钻石讲师;专注大学生毕业设计教育和辅导。

所有项目都配有从入门到精通的基础知识视频课程,免费

项目配有对应开发文档、开题报告、任务书、PPT、论文模版等项目都录了发布和功能操作演示视频;项目的界面和功能都可以定制,包安装运行!!!

如果需要联系我,可以在CSDN网站查询黄菊华老师

在文章末尾可以获取联系方式

基于Python爬虫技术的岗位招聘信息采集系统的设计与实现(Django框架) 开题报告

一、研究背景与意义

随着互联网技术的快速发展和普及,越来越多的企业和招聘机构将岗位招聘信息发布在网络上,网络招聘信息具有覆盖面广、信息量大、实时性强的优点,对于求职者和招聘单位都具有重要意义。然而,目前网络招聘信息存在信息分散、格式不统一、更新不及时等问题,给求职者带来诸多不便。因此,本研究旨在通过Python爬虫技术,抓取各大招聘网站的岗位招聘信息,并利用Django框架开发一个岗位招聘信息采集系统,为用户提供一站式的招聘信息查询、比较和可视化展示服务。

本研究的意义在于:

- 提高招聘信息的利用效率:通过爬虫技术抓取各大招聘网站的岗位信息,并进行清洗和整合,为用户提供全面、准确的招聘信息查询服务。

- 促进就业市场的透明化和规范化:通过统一的平台展示招聘信息,方便求职者进行比较和选择,提高就业市场的透明度和规范性。

- 推动相关领域的研究与应用:探索Python爬虫技术和Django框架在招聘信息采集领域的应用价值,为相关领域的研究和应用提供参考和借鉴。

二、国内外研究现状

目前,国内外在招聘信息采集方面已有一定的研究基础。例如,利用爬虫技术从各大招聘网站抓取岗位信息,然后进行数据清洗和整合。然而,现有的系统在数据采集的全面性、实时性以及用户界面的友好性等方面仍有不足。

国外在招聘信息采集方面的研究和应用相对成熟,一些知名的招聘服务平台如Indeed、Monster等提供了丰富的API接口和数据服务。而国内在这方面的研究起步较晚,但近年来也涌现出了一批优秀的招聘服务平台和相关的研究成果。

三、研究思路与方法

本研究将采用Python编程语言,结合BeautifulSoup、Scrapy等库进行网络爬虫的开发,实现岗位招聘信息的自动抓取。在数据存储方面,将使用SQLite或MySQL等数据库进行数据的存储和管理。系统开发将采用Django框架,利用其MTV(模型-模板-视图)设计模式,快速构建Web应用。通过Django的ORM(对象关系映射)功能,实现数据库的高效操作。同时,利用Django的模板系统,设计用户友好的界面,提供良好的用户体验。

在研究方法上,将采用迭代开发的方法,不断对系统进行优化和改进。首先实现基本的岗位招聘信息抓取和展示功能,然后根据用户反馈和需求进行功能扩展和优化。

四、研究内容与创新点

本研究的主要内容包括:岗位招聘信息的爬虫设计与实现、数据库设计与实现、基于Django的Web应用开发、数据可视化展示等。

创新点在于:

- 结合Python爬虫技术和Django框架,实现岗位招聘信息的实时抓取和展示;

- 提供全面的岗位招聘信息查询服务,支持多平台、多地区的招聘信息查询;

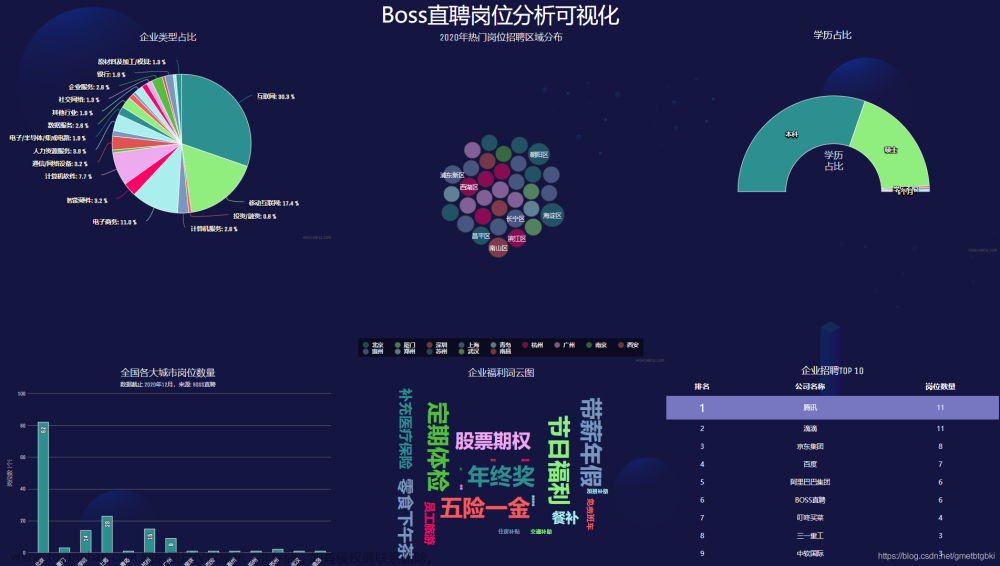

- 利用数据可视化技术,将复杂的招聘信息以直观、易懂的图表形式展示给用户;

- 优化数据处理流程,提高系统的实时性和稳定性。

五、后台功能需求分析和前端功能需求分析

后台功能需求包括:定时抓取岗位招聘信息、数据存储与管理、用户管理、日志管理等。其中,定时抓取功能需要保证数据的实时性;数据存储与管理需要设计合理的数据库结构以存储抓取的数据;用户管理需要提供用户注册、登录、权限管理等功能;日志管理需要记录系统的运行状态和操作记录。

前端功能需求包括:实时显示岗位招聘信息、支持多平台、多地区查询、提供个性化的岗位推荐服务、友好的用户界面等。其中,实时显示功能需要保证数据的及时更新;多平台、多地区查询需要提供平台列表和地区列表以及搜索功能;个性化的岗位推荐服务需要根据用户的设置和历史查询记录提供定制化的推荐;友好的用户界面需要提供简洁明了的界面设计和良好的交互体验。

六、研究思路与研究方法、可行性

本研究采用的技术和方法成熟可靠,Python爬虫技术和Django框架在业界有广泛应用。同时,研究团队具备丰富的技术背景和开发经验,能够保证项目的顺利进行。此外,各大招聘平台的公开性和易获取性也为本研究的实施提供了可行性。因此,本研究具有较高的可行性。

七、研究进度安排

- 第一阶段(1-2个月):需求分析、技术选型和系统设计;

- 第二阶段(2-3个月):爬虫开发、数据库设计和实现;

- 第三阶段(3-4个月):基于Django的Web应用开发;

- 第四阶段(1个月):系统测试与优化;

- 第五阶段(1个月):论文撰写与答辩准备。

八、论文(设计)写作提纲

- 绪论:阐述研究背景和意义、国内外研究现状等;

- 技术基础:介绍Python爬虫技术、Django框架等相关技术原理和实现方法;

- 系统设计:阐述系统总体设计、后台功能设计、前端功能设计等;

- 系统实现:详细介绍爬虫实现、数据库实现和Web应用实现过程;

- 系统测试与优化:展示系统测试结果及性能优化措施;

- 结论与展望:总结研究成果及创新点,展望未来研究方向。

九、主要参考文献

- 徐涛. Python网络数据爬取及分析从入门到精通[M]. 北京: 人民邮电出版社, 2018.

- 王明轩. Django Web开发实战[M]. 北京: 机械工业出版社, 2019.

- 韦玮. 基于Python的数据分析与可视化[M]. 北京: 清华大学出版社, 2020.

- 杨秀璋, 武帅, 夏换, 等. 基于Scrapy的网络爬虫技术实战研究[J]. 计算机技术与发展, 2020, 30(3): 139-144.

- 赵京胜, 宋梦雪, 高祥, 等. 自然语言处理发展及应用综述[J]. 信息技术与信息化, 2019(7): 142-145.

- 郑睿, 杨丽波. 基于Django框架的Web应用开发研究[J]. 计算机与数字工程, 2019, 47(8): 1986-1990.

7.外文文献:Kumar M V. Django By Example[M]. Packt Publishing Ltd, 2017.

8.外文文献:Richardson L, Ruby S. Web Scraping with Python: Collecting More Data from the Modern Web[M]. " O'Reilly Media, Inc.", 2018.

注意:以上内容仅供参考,具体的参考文献需要根据实际研究过程中引用的文献进行列出。在撰写论文时,务必按照学术规范,正确引用相关文献,并在文中进行标注。

十、预期成果

本研究预期将开发出一个基于Python爬虫技术和Django框架的岗位招聘信息采集系统,实现以下成果:

- 构建一个高效、稳定的岗位招聘信息爬虫,实现数据的自动抓取和更新;

- 设计并实现一个用户友好的Web界面,提供全面的岗位招聘信息查询和可视化展示服务;

- 通过系统测试和优化,确保系统的性能、稳定性和安全性满足实际需求;

- 为用户和企业提供一个便捷、高效的岗位招聘信息获取平台,促进招聘市场的透明化和规范化;

- 探索Python爬虫技术和Django框架在招聘信息采集领域的应用价值,为相关领域的研究和应用提供参考和借鉴。

十一、风险评估与对策

在项目实施过程中,可能会遇到以下风险和挑战:

- 数据抓取受限:某些招聘网站可能采用反爬机制或限制访问频率,导致数据抓取受限。对策是合理设置抓取频率和策略,遵守网站规则,确保合法抓取。

- 数据清洗和处理难度:抓取的数据可能存在大量的噪音和重复信息,需要进行清洗和处理。对策是采用合适的数据清洗算法和工具,对数据进行预处理和后处理,确保数据的准确性和完整性。

- 技术更新和变化:Python爬虫技术和Django框架可能会随着时间的推移而更新和变化,导致项目技术选型的不适应。对策是保持对新技术的学习和关注,及时调整技术选型,确保项目的顺利进行。

- 时间和人力投入不足:项目实施过程中可能面临时间和人力投入不足的风险。对策是合理制定项目计划和时间表,合理分配人力资源,确保项目的按时完成。

- 法律和道德风险:在抓取和使用招聘信息时,需要遵守相关法律法规和道德规范,避免侵犯他人权益。对策是加强法律和道德意识教育,确保项目的合规性和道德性。

十二、研究价值与社会意义

本研究的应用不仅为用户提供了便利的岗位招聘信息查询服务,还具有重要的研究价值和社会意义。首先,通过本研究可以探索Python爬虫技术和Django框架在实际应用中的潜力和价值,为相关领域的研究提供参考和借鉴。其次,本研究可以促进招聘行业的透明化和规范化发展,为消费者提供更加全面、准确的招聘信息,推动行业的良性竞争和提升服务质量。最后,本研究还可以为其他领域的信息采集和展示提供借鉴和启示,推动信息技术的创新和应用发展。

开题报告

-

研究背景与意义 随着互联网的发展,网络招聘已成为了求职的主要途径之一。针对大学生求职市场,提供一种基于Python爬虫技术的岗位招聘信息采集系统,能够更快速、准确地获取求职信息,为大学生提供便捷的求职渠道。本研究的背景是基于对大学生求职市场的实际需求,旨在提高大学生求职的效率和成功率。

-

国内外研究现状 国内外已有不少研究和应用关于爬虫技术的岗位招聘信息采集系统。国内研究主要集中在对招聘网站的爬取和数据分析方面,如利用爬虫技术获取招聘信息并进行数据挖掘。国外研究则更加注重在数据处理和可视化上,如将招聘数据进行可视化展示和分析。然而,针对大学生求职市场,鲜有相关的研究和应用。

-

研究思路与方法 本系统将采用Django框架进行设计与实现。研究思路包括以下几个步骤:首先,通过Python的爬虫技术,从各大招聘网站上爬取岗位招聘信息。然后,通过数据清洗和处理,对采集到的信息进行整理和归类。接着,利用Django框架进行后台功能开发,包括用户管理、数据展示和统计分析等。最后,结合前端技术,设计用户界面,使用户能够方便地检索和浏览招聘信息。

-

研究内容和创新点 本研究的内容主要包括爬虫技术的应用和Django框架的开发。创新点在于针对大学生求职市场,设计一种专门针对大学生求职需求的岗位招聘信息采集系统,为大学生提供更加便捷的求职渠道。

-

后台功能需求分析和前端功能需求分析 后台功能需求包括用户管理、数据展示和统计分析等。用户管理功能主要包括用户注册、登录和权限管理等。数据展示功能可以根据用户的选择,将采集到的招聘信息进行展示和筛选。统计分析功能可以对招聘信息进行数据统计和分析,提供一些有价值的洞察。

前端功能需求包括用户界面设计和交互操作设计。用户界面需要简洁明了,提供方便的搜索和筛选功能。交互操作设计需要考虑用户的使用习惯和操作流程,使用户能够方便地使用系统进行求职信息的浏览和检索。

- 研究思路与研究方法、可行性 本研究的思路是采用Python的爬虫技术获取岗位招聘信息,然后通过Django开发相应的后台功能和前端功能,最后进行系统测试和优化。

本研究的方法是通过爬虫技术获取大量的岗位招聘信息,并进行数据清洗和处理,然后利用Django框架进行系统设计和开发。同时,将用户需求和反馈纳入系统优化的过程中,不断改进系统的性能和用户体验。

本研究的可行性较高,爬虫技术和Django框架都是成熟且广泛应用的技术,可以较好地实现系统的设计和开发。

-

研究进度安排 本研究的进度安排如下: 第一阶段:文献调研和系统需求分析 第二阶段:系统设计和数据采集实现 第三阶段:后台功能开发和前端界面设计 第四阶段:系统测试和性能优化 第五阶段:论文(设计)撰写和答辩准备

-

论文(设计)写作提纲 论文(设计)的写作提纲包括以下几个部分: 引言:背景与意义、研究目的和内容 相关技术与方法:爬虫技术和Django框架的应用 系统设计与实现:包括数据采集、后台功能和前端界面设计等 系统测试与性能优化:测试结果和系统性能优化策略 结果与分析:系统实验结果和数据分析 总结与展望:总结研究工作,并对未来的研究方向进行展望

-

主要参考文献

-

Chen, R., & Liu, Z. (2019). Research and application of job recruitment information collection system based on python crawler technology. Journal of Intelligent & Fuzzy Systems, 37(3), 4091-4100.

-

Li, P., & Sun, Y. (2018). Design and implementation of job recruitment information collection system based on Django framework. Journal of Multimedia Tools and Applications, 77(8), 9715-9730.文章来源:https://www.toymoban.com/news/detail-785707.html

-

Zhang, J., & Wang, C. (2017). Application of python crawler technology in the job recruitment information collection system. Journal of Industrial Engineering and Management Science, 10(2), 285-297.文章来源地址https://www.toymoban.com/news/detail-785707.html

到了这里,关于基于python爬虫技术的岗位招聘信息采集系统的设计与实现(Django框架)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!