前言

作为当前先进的深度学习目标检测算法YOLOv7,已经集合了大量的trick,但是还是有提高和改进的空间,针对具体应用场景下的检测难点,可以不同的改进方法。此后的系列文章,将重点对YOLOv7的如何改进进行详细的介绍,目的是为了给那些搞科研的同学需要创新点或者搞工程项目的朋友需要达到更好的效果提供自己的微薄帮助和参考。由于出到YOLOv7,YOLOv5算法2020年至今已经涌现出大量改进论文,这个不论对于搞科研的同学或者已经工作的朋友来说,研究的价值和新颖度都不太够了,为与时俱进,以后改进算法以YOLOv7为基础,此前YOLOv5改进方法在YOLOv7同样适用,所以继续YOLOv5系列改进的序号。另外改进方法在YOLOv5等其他算法同样可以适用进行改进。希望能够对大家有帮助。

具体改进办法请关注后私信留言!关注免费领取深度学习算法学习资料!

一、解决问题

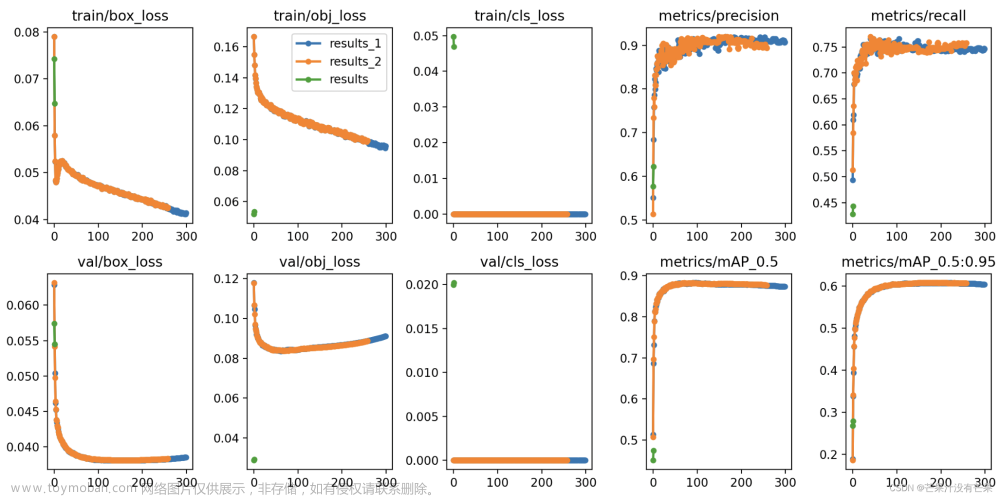

之前改进从改进的部位来分的话从输入端、主干特征提取网络(backbone)、特征融合网络(neck)、检测头等四个方面进行改进,从改进的方法包括添加注意力机制、损失函数改进、改变网络结构、替换主干特征提取网络、改进非极大值抑制、k-means++聚类算法等方面进行改进,本文尝试通过改进更为专用于视觉任务的激活函数来网络进行改进。原激活函数为SiLU激活函数,改进激活函数来提高检测效果。此前💡🎈☁️34. 更换激活函数为FReLU💡🎈☁️46. 改进激活函数为ACON有一定效果。本次改进为GELU。

二、基本原理

原文链接

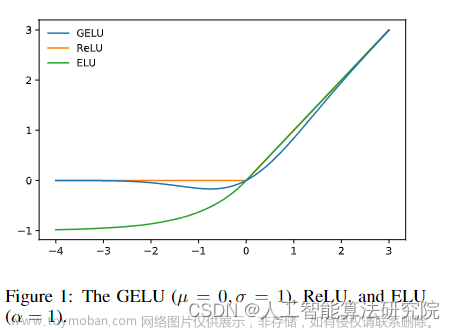

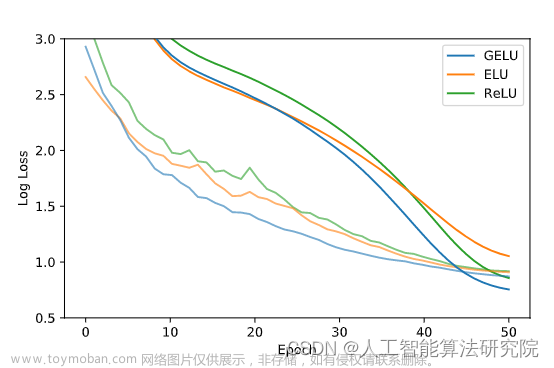

早期的人工神经元使用二进制阈值单位(Hopfield,1982;McCulloch&Pitts,1943)。这些艰难的二元决策通过乙状激活来平滑,使神经元能够进行“枞树率”解释,并通过反向传播进行训练。但随着网络的深入,使用s形激活的训练被证明不如非平滑、概率较小的ReLU(Nair&Hinton,2010)有效,后者根据输入的符号做出艰难的门控决策。尽管ReLU的统计动机较少,但它仍然是一种具有竞争性的工程解决方案,通常比s形激活更快、更好地实现收敛。在ReLU成功的基础上,最近的一种称为ELU的修改(Clevert等人,2016)允许ReLU类非线性输出负值,有时会提高训练速度。总之,激活选择仍然是神经网络的必要架构决策,以免网络成为深度线性分类器。深度非线性分类器可以很好地拟合其数据,以至于网络设计者经常面临选择包括随机正则化器,如向隐藏层添加噪声或应用丢弃(Sri-vastava等人,2014),而这一选择与激活函数分离。一些随机正则化器可以使网络表现得像一个网络集合,一个伪集合(Bach-man等人,2014),并可以导致显著的准确性提高。例如,随机正则化器丢弃通过零乘法随机改变一些激活决策来创建伪系综。因此,非线性和脱落共同决定了神经元的输出,但这两个创新仍然是不同的。更重要的是,两者都不包含另一个,因为流行的随机正则化器的行为与输入无关,而非线性是由这种正则化器辅助的。在这项工作中,我们引入了一种新的非线性,高斯误差线性单元(GELU)。它与随机正则化相关,因为它是对自适应丢弃的修改的预期(Ba&Frey,2013)。这表明神经元的输出具有更高的概率性。我们发现,这种新颖的非线性与ReLU或ELU在计算机视觉、自然语言处理和自动语音识别等任务中的模型相匹配或超过。

三、添加方法

第一步:损失函数定义到YOLOv7或者YOLOv5的utils/activations.py中。

class GELU(nn.Module):

def __init__(self):

super(GELU, self).__init__()

def forward(self, x):

return 0.5 * x * (1 + torch.tanh(np.sqrt(2 / np.pi) * (x + 0.044715 * torch.pow(x, 3))))

第二步:common.py构建模块。重构Conv模块。

#GELU 公众号:人工智能AI算法工程师 微信:Worker123654

from utils.activations import GELU

class Conv(nn.Module):

# Standard convolution

def __init__(self, c1, c2, k=1, s=1, p=None, g=1, act=True): # ch_in, ch_out, kernel, stride, padding, groups

super(Conv, self).__init__()

#.conv = nn.Conv2d(c1, c2, k, s, autopad(k, p),dilation=1, groups=g, bias=False)#空洞卷积

self.conv = nn.Conv2d(c1, c2, k, s, autopad(k, p), groups=g, bias=False)

self.bn = nn.BatchNorm2d(c2)

self.act = GELU() if act is True else (act if isinstance(act, nn.Module) else nn.Identity())

def forward(self, x):

return self.act(self.bn(self.conv(x)))

def forward_fuse(self, x):

return self.act(self.conv(x))

第三步:将train.py中改为本文的yaml文件即可,开始训练,即可将原Conv中的激活函数改为GELU函数。

四、总结

预告一下:下一篇内容将继续分享深度学习算法相关改进方法。有兴趣的朋友可以关注一下我,有问题可以留言或者私聊我哦

PS:该方法不仅仅是适用改进YOLOv5,也可以改进其他的YOLO网络以及目标检测网络,比如YOLOv7、v6、v4、v3,Faster rcnn ,ssd等。

最后,有需要的请关注私信我吧。关注免费领取深度学习算法学习资料!文章来源:https://www.toymoban.com/news/detail-786169.html

YOLO系列算法改进方法 | 目录一览表

💡🎈☁️1. 添加SE注意力机制

💡🎈☁️2.添加CBAM注意力机制

💡🎈☁️3. 添加CoordAtt注意力机制

💡🎈☁️4. 添加ECA通道注意力机制

💡🎈☁️5. 改进特征融合网络PANET为BIFPN

💡🎈☁️6. 增加小目标检测层

💡🎈☁️7. 损失函数改进

💡🎈☁️8. 非极大值抑制NMS算法改进Soft-nms

💡🎈☁️9. 锚框K-Means算法改进K-Means++

💡🎈☁️10. 损失函数改进为SIOU

💡🎈☁️11. 主干网络C3替换为轻量化网络MobileNetV3

💡🎈☁️12. 主干网络C3替换为轻量化网络ShuffleNetV2

💡🎈☁️13. 主干网络C3替换为轻量化网络EfficientNetv2

💡🎈☁️14. 主干网络C3替换为轻量化网络Ghostnet

💡🎈☁️15. 网络轻量化方法深度可分离卷积

💡🎈☁️16. 主干网络C3替换为轻量化网络PP-LCNet

💡🎈☁️17. CNN+Transformer——融合Bottleneck Transformers

💡🎈☁️18. 损失函数改进为Alpha-IoU损失函数

💡🎈☁️19. 非极大值抑制NMS算法改进DIoU NMS

💡🎈☁️20. Involution新神经网络算子引入网络

💡🎈☁️21. CNN+Transformer——主干网络替换为又快又强的轻量化主干EfficientFormer

💡🎈☁️22. 涨点神器——引入递归门控卷积(gnConv)

💡🎈☁️23. 引入SimAM无参数注意力

💡🎈☁️24. 引入量子启发的新型视觉主干模型WaveMLP(可尝试发SCI)

💡🎈☁️25. 引入Swin Transformer

💡🎈☁️26. 改进特征融合网络PANet为ASFF自适应特征融合网络

💡🎈☁️27. 解决小目标问题——校正卷积取代特征提取网络中的常规卷积

💡🎈☁️28. ICLR 2022涨点神器——即插即用的动态卷积ODConv

💡🎈☁️29. 引入Swin Transformer v2.0版本

💡🎈☁️30. 引入10月4号发表最新的Transformer视觉模型MOAT结构

💡🎈☁️31. CrissCrossAttention注意力机制

💡🎈☁️32. 引入SKAttention注意力机制

💡🎈☁️33. 引入GAMAttention注意力机制

💡🎈☁️34. 更换激活函数为FReLU

💡🎈☁️35. 引入S2-MLPv2注意力机制

💡🎈☁️36. 融入NAM注意力机制

💡🎈☁️37. 结合CVPR2022新作ConvNeXt网络

💡🎈☁️38. 引入RepVGG模型结构

💡🎈☁️39. 引入改进遮挡检测的Tri-Layer插件 | BMVC 2022

💡🎈☁️40. 轻量化mobileone主干网络引入

💡🎈☁️41. 引入SPD-Conv处理低分辨率图像和小对象问题

💡🎈☁️42. 引入V7中的ELAN网络

💡🎈☁️43. 结合最新Non-local Networks and Attention结构

💡🎈☁️44. 融入适配GPU的轻量级 G-GhostNet

💡🎈☁️45. 首发最新特征融合技术RepGFPN(DAMO-YOLO)

💡🎈☁️46. 改进激活函数为ACON文章来源地址https://www.toymoban.com/news/detail-786169.html

到了这里,关于【YOLOv7/YOLOv5系列算法改进NO.47】改进激活函数为GELU的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!