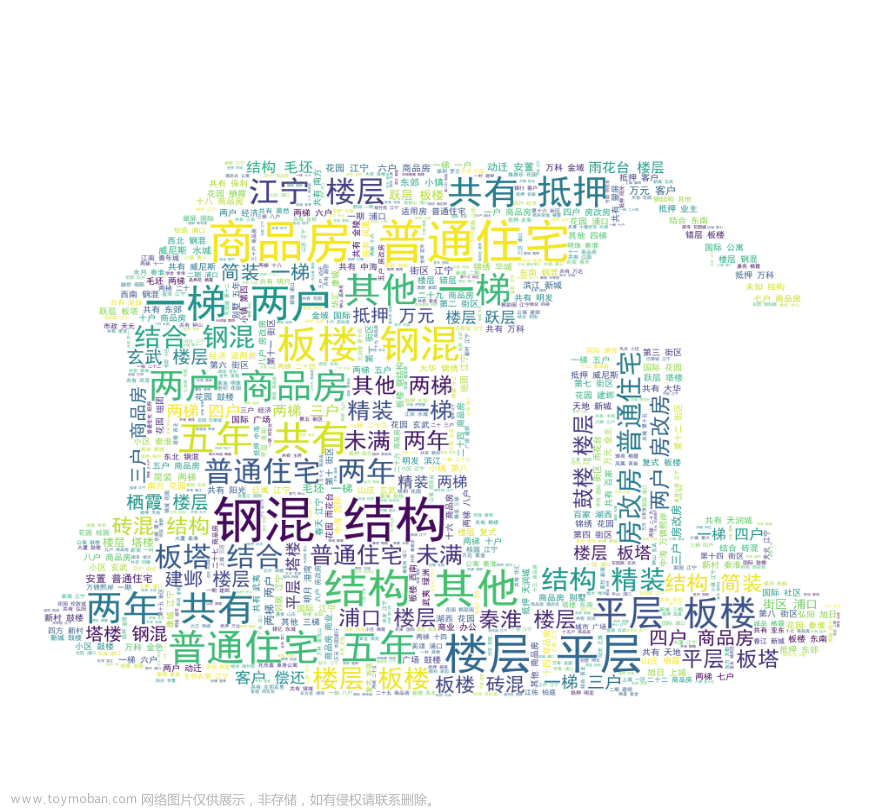

都说现在房市惨淡,导致很多人在观望,那么今天我写一段爬虫,主要是抓取各地新房以及二手房成交状况,然后了解总体楼市是否回暖上升。

以下是Java爬虫程序的代码示例,用于抓取贝壳网新房和二手房数据:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.IOException;

import java.net.URL;

import java.net.URLConnection;

public class Spider {{免费提取IP} jshk.com.cn/mb/reg.asp?kefu=xjy&csdn

private static String proxy_host = "duoip";

private static int proxy_port = 8000;

public static void main(String[] args) {

try {

// 创建URL对象

URL url = new URL("http://www.ke.com");

// 提取免费IP URL

jshk.com.cn/mb/reg.asp?kefu=xjy

// 创建代理服务器连接

URLConnection connection = new URLConnection(url);

connection.setProxy(new Proxy(Proxy.Type.HTTP, new InetSocketAddress(proxy_host, proxy_port)));

// 获取数据

Document document = Jsoup.connect(url)

.userAgent("Mozilla/5.0")

.get();

// 获取标题

String title = document.title();

// 获取所有链接

Elements links = document.select("a[href]");

for (Element link : links) {

System.out.println(link.attr("abs:href"));

}

} catch (IOException e) {

e.printStackTrace();

}

}

}

解释如下:

1、首先,我们导入了必要的库,包括Jsoup用于解析HTML文档,以及其他用于处理URL和IO异常的库。

2、然后,我们定义了代理服务器的主机名和端口号。

3、在main函数中,我们创建了一个URL对象,该对象表示我们要抓取的贝壳网网站的URL。

4、接下来,我们创建了一个URLConnection对象,该对象代表与远程服务器的连接。我们使用setProxy方法设置代理服务器,以便我们可以通过代理访问网站。

5、然后,我们使用Jsoup.connect方法向URL发出GET请求,并设置User-Agent为Mozilla/5.0,这是用于模拟浏览器的头部信息。

6、使用get方法获取网页内容,得到的网页内容将被解析成一个Document对象。

7、我们使用Document对象的title方法获取网页的标题。

8、使用Document对象的select方法选择所有的链接元素。这里我们使用CSS选择器,选择所有以href属性存在的a标签。

9、最后,我们遍历获取到的链接元素,并使用attr方法获取每个链接的绝对路径。

10、如果在抓取过程中发生任何异常,我们将其打印出来。文章来源:https://www.toymoban.com/news/detail-786966.html

以上就是我通过Java爬虫程序的完整代码和解释。这和只是一个基本的示例,实际使用时可能需要根据具体的网页结构和抓取需求进行调整。而且可以更加你项目以及需求加入你需要的代码。如果有更多的问题可以评论区留言讨论。文章来源地址https://www.toymoban.com/news/detail-786966.html

到了这里,关于用Java爬取新房二手房数据看总体大环境的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!