Spark在数据科学中的应用案例分析

在数据科学领域,Apache Spark已经成为一个不可或缺的工具。其强大的分布式计算能力和丰富的数据处理功能使得数据科学家能够高效地处理大规模数据集,并从中提取有价值的信息。本文将通过几个具体的应用案例来分析Spark在数据科学中的应用,并通过示例代码加以说明。

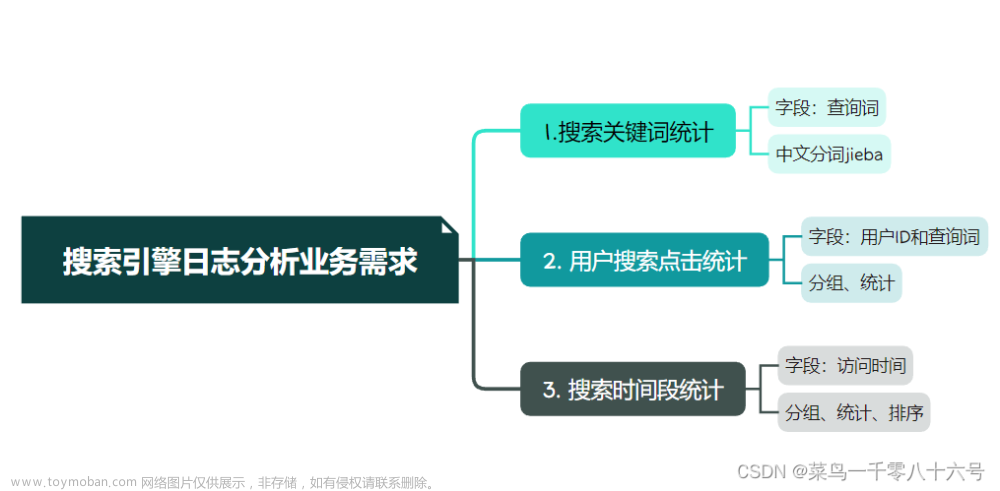

一、日志数据分析

日志数据分析是数据科学中常见的任务之一。通过分析用户行为日志,可以了解用户的行为模式、偏好等,从而为企业提供有针对性的服务和产品推荐。Spark的流式处理功能使得实时日志分析成为可能。

示例代码(使用Spark Streaming进行实时日志分析):

import org.apache.spark._

import org.apache.spark.streaming._

val conf = new SparkConf().setMaster("local[2]").setAppName("LogAnalysis")

val ssc = new StreamingContext(conf, Seconds(10)) // 每10秒一个批次

val lines = ssc.socketTextStream("localhost", 9999) // 从socket端口接收数据

val words = lines.flatMap(_.split(" ")) // 分割每行数据为单词

val pairs = words.map(word => (word, 1)) // 将每个单词映射为(key, value)对

val wordCounts = pairs.reduceByKey(_ + _) // 计算每个单词的出现次数

wordCounts.print() // 打印结果

ssc.start() // 启动流计算

ssc.awaitTermination() // 等待计算终止

在上述代码中,我们创建了一个Spark Streaming上下文对象,通过socket端口接收日志数据,并按单词进行计数统计。每10秒输出一次统计结果。这种实时处理能力使得Spark成为日志数据分析的理想选择。

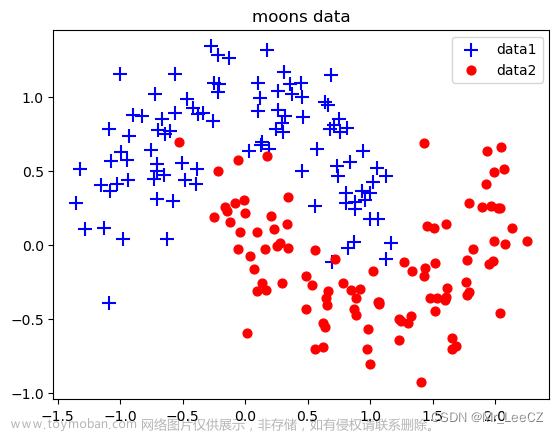

二、机器学习模型训练

机器学习是数据科学领域的热点之一,而Spark提供了强大的机器学习库MLlib,支持各种常见的机器学习算法。通过Spark的并行计算能力,可以高效地训练大规模的机器学习模型。

示例代码(使用Spark MLlib进行逻辑回归模型训练):

import org.apache.spark.ml.classification.LogisticRegression

import org.apache.spark.ml.evaluation.MulticlassClassificationEvaluator

import org.apache.spark.ml.feature.{VectorAssembler, StringIndexer}

import org.apache.spark.sql.{SparkSession, Dataset}

val spark = SparkSession.builder().appName("LogisticRegressionExample").getOrCreate()

import spark.implicits._

// 加载数据集并进行预处理(略)

val trainingData: Dataset[_] = ... // 训练数据集

val testData: Dataset[_] = ... // 测试数据集

// 特征工程(将多个特征组合成特征向量)

val assembler = new VectorAssembler()

.setInputCols(Array("feature1", "feature2", "feature3")) // 假设有三个特征列

.setOutputCol("features")

val transformedTrainingData = assembler.transform(trainingData)

val transformedTestData = assembler.transform(testData)

// 对标签列进行索引编码(如果是分类任务)

val labelIndexer = new StringIndexer()

.setInputCol("label") // 标签列名

.setOutputCol("indexedLabel") // 索引后的标签列名

.fit(transformedTrainingData) // 在训练集上拟合索引器

val labelTransformedTrainingData = labelIndexer.transform(transformedTrainingData) // 对训练集应用索引器

val labelTransformedTestData = labelIndexer.transform(transformedTestData) // 对测试集应用索引器

// 训练逻辑回归模型

val lr = new LogisticRegression()

.setMaxIter(10) // 最大迭代次数

.setRegParam(0.3) // 正则化参数

.setElasticNetParam(0.8) // ElasticNet混合参数(0.0为L2正则化,1.0为L1正则化)

val model = lr.fit(labelTransformedTrainingData) // 训练模型

// 评估模型性能

val predictions = model.transform(labelTransformedTestData) // 对测试集进行预测

val evaluator = new MulticlassClassificationEvaluator() // 多分类评估器

.setLabelCol("indexedLabel") // 设置标签列名(索引后的)

.setPredictionCol("prediction") // 设置预测列名

.setMetricName("accuracy") // 设置评估指标(准确率)

val accuracy = evaluator.evaluate(predictions) // 计算准确率

println(s"Test accuracy = $accuracy") // 打印准确率结果

在上述代码中,我们使用Spark MLlib中的逻辑回归算法进行模型训练,并通过准确率评估了模型的性能。通过调整模型参数和特征工程,可以进一步提高模型的准确性。这种基于Spark的并行化机器学习方法可以处理大规模数据集,提高训练效率。文章来源:https://www.toymoban.com/news/detail-787187.html

三、图数据分析

图数据分析是数据科学中的另一个重要领域,而Spark的图计算框架GraphX提供了强大的图数据处理和分析能力。通过GraphX,可以高效地进行图模式匹配、社区发现、最短路径计算等任务。例如,社交网络分析中的好友推荐、影响力传播等问题可以通过GraphX来解决。由于篇幅限制,这里不再给出具体的示例代码,但可以参考GraphX的API文档和示例来了解其使用方法。GraphX的灵活性和可扩展性使得它在图数据分析领域具有广泛的应用前景。 综上所述,Apache Spark在数据科学中的应用非常广泛。无论是日志数据分析、机器学习模型训练还是图数据分析,Spark都提供了强大的功能和灵活的API来满足各种需求。通过合理地利用Spark的计算能力和优化策略,可以高效地处理大规模数据集,并从中挖掘出有价值的信息,为决策提供支持。因此,学习和掌握Spark对于数据科学家来说是非常重要的。文章来源地址https://www.toymoban.com/news/detail-787187.html

到了这里,关于Spark在数据科学中的应用案例分析的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!