1首先hadoop集群环境,使用jps’查看服务启动情况

1.1使用start-all.sh启动Hadoop集群环境

1..2使用jps查看服务启动情况

1..2使用jps查看服务启动情况

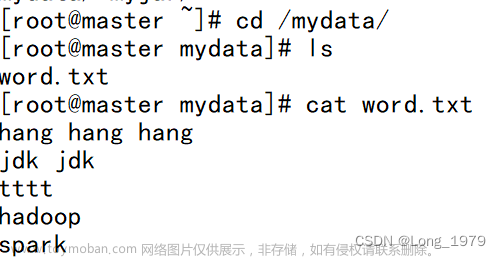

2创建一个需要进行处理的数据文件:word.txt

2.1 为了方便管理,首先创建一个文件夹(我这里创建已经创建了mydata,这个自定义)再在其下创建文件

2.2 进入mydata目录下使用vi word.txt 创建该文件,并在文件中输入如下数据

3 将所需要分析的文件上传到hdfs系统上

3.1 首先在hdfs上创建一个用于保存所上传的文件夹,我这里创建了一个input,使用的命令是hadoop fs -mkdir /input

3.2 使用hadoop fs -ls / 查看hdfs上已经存在的目录

3.3 将所需要分析处理的文件上传到创建的目录下,并进行查看

4 使用hadoop自带的jar包对上传的文件进行分析

4.1 首先找到hadoop自带的mapreduce测试jar包所在位置

4.2 使用其中的hadoop-mapreduce-examples-3.3.0.jar 对上上传的数据进行分析

注意:这里的wordcount 是这个测试jar包中的一个单词统计的主类的引用路径名,实际应用中需要自己导入自己所创建的类引用路径

这里的/output 目录不需要提前创建,它会自动生成,测试是否分析成功可以查看该目录下是否产生相应的part-r-00000文件

5 查看是否成功

注意:可以查看part-r-00000文件看是否出现对应的词频统计结果,即为成功,如下所示

文章来源:https://www.toymoban.com/news/detail-787603.html

文章来源:https://www.toymoban.com/news/detail-787603.html

到这里使用hadoop自带的案例jar包处理词频统计已经大功告成!!!文章来源地址https://www.toymoban.com/news/detail-787603.html

到了这里,关于使用hadoop进行词频统计测试案例的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!