论文基本信息

论文题目:PathoDuet: Foundation Models for Pathological Slide Analysis of H&E and IHC Stains

作者信息:上海交大、上海AI实验室

论文链接:https://arxiv.org/abs/2312.09894

研究动机

背景

- 组织学评估是诊断癌症的金标准

- 病理学家主要根据HE分析,还利用IHC进一步提高诊断结果

- 尽管数据量巨大,但是由于缺乏标注,将深度学习技术整合到诊断流程中的进展相对缓慢

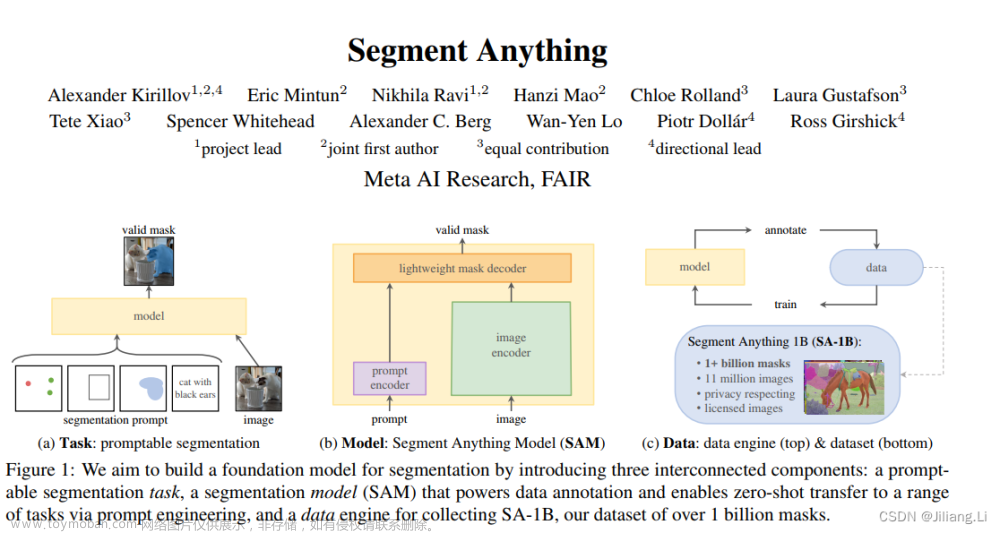

- 为了应对这一挑战,基础模型(foundation model)应运而生,这些模型通常利用未标记数据的潜力,促进向下游任务的迁移,减少对标记数据的依赖

- 现有的基础模型主要依赖于自监督学习(SSL)方法

- 对比学习(CL)是SSL的一个主要分支

- CL侧重利用图像的相似性来辨别和分类与其他图像相关的图像。由于许多病理任务与识别高度相关,因此CL适合用于病理基础模型

提出问题/假说

关键问题/假说A

- CL任务大多数图像具有语义独特性(semantic uniqueness)

- 病理图像大多由WSI切分成patch以满足模型的输入尺寸要求,但是这样会导致相邻patch的语义独特性被限制。

- 独立的patch会导致语义空间的过度碎片化(over-fragmentation),从而影响模型的性能。

- 病理学家习惯在检查过程中不断的放大和缩小观察病理图像。

关键问题/假说B

- 病理学家还经常利用其他切片进行更全面的诊断。

- IHC经常被采用以为癌症的亚型分类提供更宝贵的见解。

- HE切片可作为基本参考,提供重要的信息和结构细节,补充从IHC切片中获得的特定分子信息。

- 理想的IHC染色基础模型能根据标记物表达水平评估IHC图像,并在组织结构方面与HE模型的语义空间保持一致。

解决问题/假说

针对问题/假说A的核心技术

- 为了模拟病理学家观察病理图像的过程。提出了“跨尺度定位”(cross-scale positioning)的前置任务。

- 在CL中常用的不同增强图像试图的两个分支外,还增加了一个分支,从邻近区域学习patch的表示。

针对问题/假说B的核心技术

- 利用训练好的HE模型,引入“跨染色迁移”(cross-stain transferring)的前置任务,加深对不同染色方式病理图像的理解。

技术路线

提出了称为PathoDuet的框架,它为开发基础模型提供了两种不同的策略:

- 利用尺度的切换来发现更广阔的语义空间(从周围区域进一步理解patch)

- 在其他密切相关且已被利用的模式基础上取得进步(从HE模型中学习IHC图像的表示)

整体技术概览

Pretext token empowered SSL framework

- 动机:为了模仿病理学家,需要一个额外的输入来携带来自不同尺度或染色的信息

- 提出了一个pretext token机制,揭示同一个编码器内部的关系,从而加深病理学家对病理图像的理解

- 该机制创建了一个pretext token,与patch的embedding一起送入到ViT中。这个token是输入对之间的关联。

Cross-scale positioning

病理学家喜欢不断缩放观察切片:先从全局视角中找到可疑区域,然后放大查看;然后再缩放到全局视角检查下一个可疑区域。

病理学家在低倍镜下获得全局的粗略的理解,然后在高倍镜下获得局部的仔细的理解。

受此启发,作者提出了“跨尺度定位”任务,应用于自监督学习。

在该任务中,CL框架桥接局部试图和全局试图的patch。

整个框架由三个分支组成:

- Region Network

- Online Patch Network

- Target Patch Network

从局部视角来看:

Online和Target分支构成对比学习,对比两个不同增强的patch

Online和Target在这里遵循MoCov3的结构,获得局部损失

从全局视角来看:

Region和Online分支构成了跨尺度定位任务

相比于其他两个分支的可学习的token,Region分支的token是local patch的embedding

Positioner给每个输入patch embedding分配权重

权重会与Encoder的特征相乘

为了将局部和全局视角联系起来,引入了SimSiam’s two-way loss

其中

Cross-stain transferring

病理学家不止检查HE图像,还需要如IHC切片等,以获得更多的信息

受此启发,作者提出了“跨染色迁移”任务。

考虑到配对数据的稀缺性,该任务旨在作为一种从现有H&E基础模型到IHC基础模型的迁移方法,而不是预训练方法。

在该任务中,CL框架桥接真实的IHC patch和相应的H&E patch迁移的伪IHE patch。

作者参照(adaptive instance normalization, AdaIN)的方法设计了一个迁移器,将H&E染色的特征的均值和方差调整为IHC的均值和方差。

整个框架由两个分支组成:

- IHC Network

- H&E Network

真实IHC特征:

- IHC Network由训练好的H&E模型初始化,输出结果被认为能够表达IHC

伪IHC特征:

- H&E模型被冻结以提供稳定的H&E表达

- H&E Network输入HE图像和IHCpatch,然后将HE的输出特征分布迁移成IHC对应的特征分布:

桥接特征使用对比学习损失:

实验

预训练阶段

- 预训练阶段包括预训练H&E模型和IHC模型迁移两个阶段

- 第一阶段:跨尺度定位

- 第二阶段:跨染色迁移

- 数据集:

- H&E数据集:

- 来源:TCGA

- 尺寸:256×256(最高倍镜)/1024×1024(较高倍镜)

- 放大倍率相差8倍

- 1,623,258个大patch和13,166,437个小patch

- 跨染色数据集:

- 来源:HyReCo(CD8, CD45, and Ki67)、BCI(HER2)

- 来自HyReCo中的2771个配对的H&E和一种IHC图像对和来自BCI中的3896个配对的图像对。并使用剪裁和缩放增加数据量。

- H&E数据集:

- 对比的模型:

- 使用ImageNet的基线:

- ImageSup:全监督ViT

- ImageSSL:自监督ViT

- 病理数据训练的模型:

- SimCLR-ciga:使用SimCLR在病理数据训练的ResNet-18

- RetCCL:预训练的ResNet-50

- CTransPath:CNN和Swin Transformer的混合结构

- 使用ImageNet的基线:

- 设置:

- Backbone:ViT-B/16

- 训练流程

- 首先使用普通的对比学习训练100轮

- 然后开始跨尺度定位任务20,训练20轮,得到H&E模型

- 训练好的H&E模型再用于跨染色迁移任务,训练100轮,得到IHC模型

H&E下游任务

Patch水平的组织分类

- PathoDuet训练好的模型用作特征提取器,后面接一个分类层

- 实验的两个策略:

- 线性验证策略:只有新加的分类层被更新,其他的层都固定住

- 全微调策略:所有层都更新

- 评价指标:Acc和F1分数

- 数据集:NCT-CRC-HE

- 结直肠癌,9种组织类别划分

WSI水平的分类

- 用了多实例学习的方法:

- 使用预训练的冻结参数的H&E模型提取WSI切分patch的特征

- 使用attention-based CLAM框架作为多实例学习流程预测WSI

- 评价指标:Acc和AUC

- 数据集:

- CAMELYON16

- TCGA non-small cell lung cancer (NSCLC)

- TCGA renal cell carcinoma (RCC)

IHC下游任务

IHC表达水平评估

- 评价指标:

- Acc、balanced accuracy (bAcc) 和 weighted F1 (wF1)

- 数据集:

- 内部数据集:PD-L1 标记的 IHC patches

- 自己设定了阈值,将PD-L1分成无表达、轻微表达、一般表达和高表达

- 四五千张patch

Cross-site肿瘤识别

- 评价指标:Acc和F1分数

- 数据集:

- 内部数据集,patch分成正(有肿瘤细胞)和负(没肿瘤细胞)两类

- 数据来自两个医疗机构(site):

- 第一个site:包括ER,KI67和PR,分类两个set

- 第二个site:包括ER,KI67和EGFR

- 四种实验场景

- Set L -> Set S / Set S-> Set T 同一个Site的实验

- Site 1→ Site 2 跨Site的实验

消融实验

文章来源:https://www.toymoban.com/news/detail-787964.html

文章来源:https://www.toymoban.com/news/detail-787964.html

文章来源地址https://www.toymoban.com/news/detail-787964.html

到了这里,关于【论文笔记】用于H&E和IHC染色切片分析的基础模型的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!