AdvFilter: Predictive Perturbation-aware Filtering against Adversarial Attack via Multi-domain Learning

- 来源:ACM MM 2021

- 作者:Yihao Huang1, Qing Guo2†, Felix Juefei-Xu3, Lei Ma4, Weikai Miao1, Yang Liu2,5, Geguang Pu1

- 单位:1East China Normal University, China 2Nanyang Technological University, Singapore

3Alibaba Group, USA 4University of Alberta, Canada 5 Zhejiang Sci-Tech University, China - 邮箱:Yihao Huang’s email: huangyihao22@gmail.com ;Corresponding authors. E-mail: ggpu@sei.ecnu.edu.cn.

- 论文原地址:AdvFilter: Predictive Perturbation-aware Filtering against Adversarial Attack via Multi-domain Learning

背景

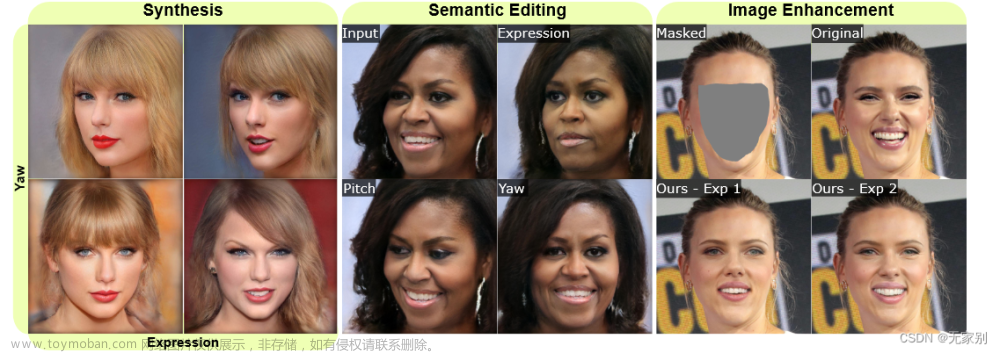

深度学习技术除了会对图像的空频域进行修改生成伪造图像,有些时候也会改变图像的语义信息。基于深度学习的对抗攻击,就是一种会对真实图像的语义信息进行修改的技术。该技术能生成让神经网络判断出错的伪造图像(也称对抗样本),从而引发安全问题。因此本章对如何防御该技术引发的伪造图像语义问题进行了研究。

目前,对抗去噪和神经网络对抗性训练是两个独立的提高卷积神经网络鲁棒性的解决方案。这两种方案分别通过对输入数据进行预处理和再训练模型来防御对抗攻击。

本章从数据精细化的角度,即采用对抗去噪防御来进行图像的语义修复。

研究了两种增强对抗鲁棒性的像素级去噪方法:基于加性的方法和未研究过的基于滤波的方法,分别在图像级和语义级的损失函数下进行实验,【结果表明:基于滤波的像素级去噪方法可以获得更高的图像质量、鲁棒性,有更好的伪图语义修复能力】

但是,基于滤波的去噪方法依赖于用来进行神经网络训练的对抗样本的扰动大小,对不同攻击强度的伪造图像没有较好的通用性。【局限性】

因此,本文提出了基于扰动感知滤波的像素级图像去噪方法——AdvFilter

对抗去噪防御 对抗训练防御

贡献

- 第一个研究比较不同损失函数(例如图像级和语义级)下基于加法的像素去噪和基于过滤的像素去噪的对抗性去噪防御性能。

- 提出了一种基于预测扰动感知滤波的方法,通过多域学习来处理不同攻击强度的对抗性攻击。该方法对cnn进行鲁棒化,同时不影响对干净或微小噪声扰动图像的精度。

- 提出并验证了一个假设,即对抗性去噪和对抗性训练可以在对抗性防御任务中相互受益。

相关工作

对抗性去噪防御

据我们所知,廖等人[23]是目前唯一的对抗性去噪防御方法。对于标准去噪器,图像中的小残余对抗噪声被逐渐放大,导致错误的分类。为了克服这一问题,Liao等[23]提出了高级表示引导去噪(high-level representation guided denoiser, HGD)作为图像分类的防御手段。他们采用目标模型(如ResNet50 [15], VGG19[29])的中间表示(即去噪图像的高级表示)的差值来计算损失。

然而,HGD过于强调高级表示,在处理微噪声扰动图像时表现不佳。HGD直接利用神经网络预测噪声逆映射,并将其加到噪声图像中,得到去噪图像。这种基于加性的去噪方法不如基于滤波的去噪,后者将在3.2节中进行评估。

对抗性训练防御

对抗性训练防御[12,20,24,32]是针对对抗性攻击的最广泛研究的防御之一。

Yan等人[36]将一个基于对抗摄动的正则化器集成到分类目标中,这样得到的模型就能学会抵抗潜在的攻击。Xie等人[34]开发了一种新的网络,其中包含执行特征去噪的块,通过执行特征去噪来增加对抗鲁棒性。Li等[22]提出的特征金字塔解码器(FPD)框架在目标CNN中植入去噪和图像恢复模块,对输入图像进行多级过滤。

对抗性训练可以在防御白盒攻击和黑盒攻击方面取得较好的效果。然而,它需要涉及足够数量和种类的对抗样本,导致大量GPU计算资源的高时间复杂度

其他对抗性防御方法

还有一些其他的对抗性防御方法。Das等[5]使用JPEG压缩对图像进行预处理,以减少对抗性噪声的影响。Guo等[13]使用输入变换对抗对抗性图像。

Efros等[8]使用图像绗缝进行纹理合成和转移以响应对抗性攻击。尽管这些方法看起来很有用,但Athalye等人[2]表明,这些防御方法严重依赖于梯度掩蔽,这导致了对对抗性攻击的鲁棒性的错误感觉

一般图像去噪

有许多通用的图像去噪方法[6,9,25,28]在图像处理和计算机视觉领域得到了深入的研究。他们通常使用过滤器去噪图像。Rudin等[28]提出了一种约束优化类型的数值算法来去除图像中的噪声。如今,Mildenhall等[25]利用核预测网络构建了一种滤波器变体方法,该方法为图像中的每个像素点提供专门的去噪滤波器。

创新

AdvFilter:设计了双重扰动滤波和基于不确定性的感知融合模块,用于在训练和测试过程中自动感知扰动振幅,从而更好地恢复图像语义。

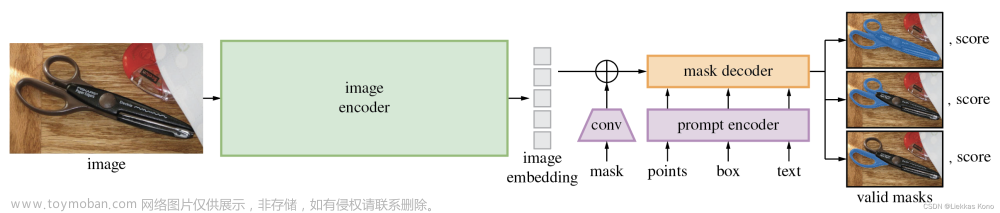

基于加性的像素去噪(即(a)),基于滤波的像素去噪(即(b))以及提出的预测性扰动感知滤波(即©)的架构,用于对抗鲁棒性增强。

公式

给定一个经过标准训练的用于图像分类的CNN(即(·))和一个干净的图像I,我们可以通过对抗性攻击方法生成难以察觉的对抗示例I。一般来说,我们使用以下流程进行非目标攻击

其中𝛿是对抗性扰动,并通过

式中,J(·)为交叉熵损失函数,其中,值域为输入图像的标注。

给定一个对抗示例(例如,I-hat),我们的目标是通过使用预测噪声信息进行去噪操作D(·)来消除对抗扰动,从而增强cnn的鲁棒性。

使用预训练的深度模型变量𝜑(·)直接预测噪声相关信息,并将上述过程表示为

式中~ I表示去噪后的图像。为了训练变量的定义,我们考虑了两种损失函数,即图像级和语义级的净图像和去噪图像之间的差异。[23]

其中,𝑙(·)表示CNN (·)中𝑙th层的输出。

Eq.(4)促使去噪后的图像与干净后的图像具有相同的图像质量,而Eq.(5)使I和~ I的深度特征保持一致,即CNN(·)预测I和~ I上的相同标签。

当设置不同的D(·)时,可以得到基于加性和基于滤波的像素去噪器。

基于加性的像素去噪。通过将Eq.(3)指定为,我们得到基于加性的像素去噪

其中,深度模型(I)预测逆对抗扰动,即Eq.(1)中的−𝛿,并使用加性运算进行去噪。

基于滤波的像素去噪。我们通过指定Eq.(3)为实现基于滤波的像素去噪

其中的’ * 圈星* '是逐像素的过滤,即,每个I的像素都是由一个排他核(其核大小为𝐾)从变量变量的变量变量中估计出来的。专门为𝑝th像素ˆ我,我们通过独家内核过滤的大小𝐾×𝐾×3𝑝th位置的存储𝜑(ˆ我)。我们在图1中展示了它们的架构。

结论:在图像级和语义级损失函数下,基于滤波的去噪方法在对抗鲁棒性增强方面都比现有的基于加性去噪方法有绝对优势;

带有图像级损失函数的基于滤波的去噪器在小攻击强度和大攻击强度上都能达到较高的精度,但在中值攻击强度上效果较差,提示我们需要开发一种扰动感知去噪器。

方法

我们构建了一个包含一个编码器和两个解码器的新颖网络。一个解码器设计用于处理大小对抗性噪声,而另一个解码器用于处理中位数强度。我们将这个网络表示为Y-Net,两个解码器的输出分别表示为𝜑sl(·)和𝜑m(·)。给定一个对抗示例I和去噪操作D(·),Y-Net基于预测噪声信息产生两个输出为

第一行图像是在ResNet50和从NeurIPS2017DEV数据集中选择的相同干净图像上具有不同PGD攻击强度的噪声图像。攻击强度的值(即,自由度)在图像的上方。第二行图像为上述图像对应的不确定度映射。我们可以发现,不同攻击强度的噪声图像会产生不同的不确定性图。

多域学习

- 结构:Y-Net与第3.2节的结构中的U-Net具有相同的编码器和两个相同的解码器。我们用来从不确定性图中生成权重图的卷积网络()包含6个卷积层,后面是一个Sigmoid函数。

- 训练细节:用𝐿1损失函数训练Y-Net。𝜑sl(·)的解码器更新了12种不同的对抗强度,然后我们确定了Y-Net的参数并使用了12种不同的对抗强度,训练不确定性感知融合模块。由于𝜑sl(·)和𝜑m(·)已经被𝐿1损失训练过,为了提高分类性能,我们使用语义级损失训练不确定性感知融合。我们将ResNet50的分类输出与去噪图像和干净图像作为输入来计算交叉熵损失。

通过观察基于滤波和基于加性去噪的预处理对FPD的影响,我们可以初步得出结论,像素去噪方法可以在一定程度上增强最先进的对抗训练模型的鲁棒性。

FD的改进。特征去噪(Feature denoising, FD)[34]也是一种最先进的对抗训练方法。获得对抗性攻击与防御竞赛(CAAD)冠军。

实验

根据实证研究,可以发现:

(1)在图像级和语义级损失函数下,基于滤波的去噪方法在增强对抗鲁棒性方面都比现有的基于加性的去噪方法具有明显的优势。

(2)基于图像级损失函数的滤波去噪在较小攻击扰动和较大攻击扰动强度上都能获得较高的准确率,但在中等攻击强度上防御效果较差。【这说明需要研究一种扰动感知的去噪方式。】文章来源:https://www.toymoban.com/news/detail-789198.html

注:本文仅供学习使用,方便和大家讨论交流。文章来源地址https://www.toymoban.com/news/detail-789198.html

到了这里,关于论文阅读笔记—— AdvFilter: Predictive Perturbation-aware Filtering against Adversarial Attack via Multi-d L的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读笔记18] DiffusionDet论文笔记与代码解读](https://imgs.yssmx.com/Uploads/2024/01/401181-1.png)