使用Spring Boot集成中间件:Kafka的具体使用案例讲解

导言

在实际应用中,Kafka作为一种强大的分布式消息系统,广泛应用于实时数据处理和消息传递。本文将通过一个全面的使用案例,详细介绍如何使用Spring Boot集成Kafka,并展示其在实际场景中的应用。

1. 准备工作

在开始之前,我们需要确保已经完成以下准备工作:

- 安装并启动Kafka集群

- 创建Kafka主题(Topic)用于消息的发布与订阅

2. 生产者示例

首先,我们来创建一个简单的生产者,将消息发送到Kafka主题。

@RestController

public class KafkaProducerController {

@Autowired

private KafkaTemplate<String, String> kafkaTemplate;

@PostMapping("/produce/{message}")

public ResponseEntity<String> produceMessage(@PathVariable String message) {

kafkaTemplate.send("my-topic", message);

return ResponseEntity.ok("Message sent to Kafka: " + message);

}

}

在上述代码中,我们使用了Spring Boot提供的KafkaTemplate,通过调用send方法将消息发送到名为my-topic的Kafka主题。

3. 消费者示例

接下来,我们创建一个简单的消费者,订阅并处理来自Kafka主题的消息。

@Service

public class KafkaConsumerService {

@KafkaListener(topics = "my-topic", groupId = "my-group")

public void consumeMessage(String message) {

System.out.println("Received message from Kafka: " + message);

// 进行消息处理逻辑

}

}

通过@KafkaListener注解,我们指定了要监听的主题为my-topic,同时指定了消费者组的ID为my-group。当有新消息到达时,consumeMessage方法将被触发,进行消息处理逻辑。

4. 配置文件

在application.properties或application.yml中配置Kafka相关属性。

spring.kafka.bootstrap-servers=localhost:9092

spring.kafka.consumer.group-id=my-group

这里我们配置了Kafka的地址和消费者组的ID。

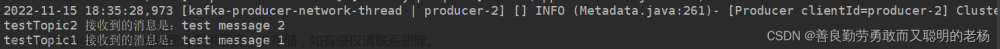

5. 运行和测试

启动Spring Boot应用程序,通过POST请求发送消息:

curl -X POST http://localhost:8080/produce/HelloKafka

在控制台或日志中,可以看到消费者输出了接收到的消息。

##############################################################################################################

一些其他的使用场景

使用Spring Boot集成中间件:Kafka高级使用案例

在这个高级使用案例中,我们将深入展示Spring Boot集成Kafka的一些高级功能,包括多分区、事务、自定义分区策略以及消息过滤。这将使我们更好地适应复杂的业务场景。

1. 配置多分区和自定义分区策略

首先,我们在Kafka配置中设置多分区以提高并发处理能力,并实现自定义分区策略。

@Configuration

public class KafkaConfig {

@Bean

public NewTopic myTopic() {

return TopicBuilder.name("my-topic")

.partitions(5) // 设置为5个分区

.replicas(1)

.build();

}

@Bean

public KafkaTemplate<String, String> kafkaTemplate(ProducerFactory<String, String> producerFactory) {

KafkaTemplate<String, String> template = new KafkaTemplate<>(producerFactory);

template.setDefaultTopic("my-topic");

return template;

}

@Bean

public ProducerListener<String, String> producerListener() {

return new MyProducerListener();

}

}

在上述配置中,我们将主题my-topic配置为5个分区,并设置了生产者的默认主题。同时,我们实现了一个自定义的生产者监听器MyProducerListener,可以在消息发送前后执行额外的逻辑。

2. 事务支持和幂等性配置

接下来,我们配置生产者启用事务,并设置消费者为幂等性消费。

@Configuration

public class KafkaConfig {

// ... 上述配置 ...

@Bean

public KafkaTransactionManager<String, String> kafkaTransactionManager(ProducerFactory<String, String> producerFactory) {

return new KafkaTransactionManager<>(producerFactory);

}

@Bean

public ConsumerFactory<String, String> consumerFactory() {

Map<String, Object> props = new HashMap<>();

// ... 其他配置 ...

props.put(ConsumerConfig.ISOLATION_LEVEL_CONFIG, "read_committed");

props.put(ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG, false);

return new DefaultKafkaConsumerFactory<>(props);

}

@Bean

public ConcurrentKafkaListenerContainerFactory<String, String> kafkaListenerContainerFactory(

ConsumerFactory<String, String> consumerFactory,

ConcurrentKafkaListenerContainerFactoryConfigurer configurer) {

ConcurrentKafkaListenerContainerFactory<String, String> factory = new ConcurrentKafkaListenerContainerFactory<>();

configurer.configure(factory, consumerFactory);

factory.setBatchListener(true);

return factory;

}

}

在上述配置中,我们使用了KafkaTransactionManager配置事务管理器,同时设置了消费者的隔离级别为read_committed,启用了批量监听。

3. 自定义分区策略

为了更灵活地控制消息的分布,我们可以实现自定义的分区策略。

public class CustomPartitioner implements Partitioner {

@Override

public int partition(String topic, Object key, byte[] keyBytes, Object value, byte[] valueBytes, Cluster cluster) {

List<PartitionInfo> partitions = cluster.availablePartitionsForTopic(topic);

int numPartitions = partitions.size();

if (key == null || !(key instanceof String)) {

throw new InvalidRecordException("Invalid key");

}

String keyValue = (String) key;

int hashCode = keyValue.hashCode();

return Math.abs(hashCode % numPartitions);

}

@Override

public void close() {

// 关闭资源逻辑

}

@Override

public void configure(Map<String, ?> configs) {

// 配置初始化逻辑

}

}

在上述分区器中,我们使用了消息的字符串形式的key进行哈希计算,然后取绝对值得到分区数。这使得具有相同key的消息始终被分发到同一个分区。

4. 运行和测试

通过上述配置,我们可以启动Spring Boot应用程序,观察多分区、事务支持和自定义分区策略在消息生产和消费中的效果。

curl -X POST http://localhost:8080/produce/HelloKafka

在Kafka消费者日志中,可以看到消息被正确地分配到了指定的分区,并且事务操作生效,确保消息的一致性。

Kafka获取文件流的具体案例讲解

在许多实际应用场景中,我们需要处理文件数据,并将文件流传输到Kafka中进行进一步的处理。下面将通过一个具体的案例来演示如何使用Spring Boot和Kafka实现文件流的生产和消费。

1. 文件流生产者

首先,我们创建一个文件流生产者,读取本地文件并将文件内容发送到Kafka主题。

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.stereotype.Service;

import java.io.IOException;

import java.nio.file.Files;

import java.nio.file.Path;

@Service

public class FileProducerService {

private final KafkaTemplate<String, byte[]> kafkaTemplate;

@Autowired

public FileProducerService(KafkaTemplate<String, byte[]> kafkaTemplate) {

this.kafkaTemplate = kafkaTemplate;

}

public void produceFile(String topic, String filePath) {

try {

byte[] fileBytes = Files.readAllBytes(Path.of(filePath));

kafkaTemplate.send(topic, fileBytes);

} catch (IOException e) {

// 处理文件读取异常

e.printStackTrace();

}

}

}

在上述代码中,我们注入了KafkaTemplate,通过Files.readAllBytes读取文件内容并通过kafkaTemplate.send发送到指定的Kafka主题。

2. 文件流消费者

接下来,我们创建一个文件流消费者,监听Kafka主题并将接收到的文件流保存到本地。

import org.springframework.kafka.annotation.KafkaListener;

import org.springframework.stereotype.Service;

import java.io.FileOutputStream;

import java.io.IOException;

@Service

public class FileConsumerService {

@KafkaListener(topics = "file-topic")

public void consumeFile(byte[] fileBytes) {

try {

// 保存文件到本地

String fileName = "received-file.txt";

FileOutputStream outputStream = new FileOutputStream(fileName);

outputStream.write(fileBytes);

outputStream.close();

} catch (IOException e) {

// 处理文件保存异常

e.printStackTrace();

}

}

}

通过@KafkaListener注解,我们监听名为file-topic的Kafka主题,接收文件流并保存到本地文件。

3. 配置文件

在application.properties或application.yml中配置Kafka相关属性。

spring.kafka.bootstrap-servers=localhost:9092

4. 运行和测试

在Spring Boot应用程序中运行文件流生产者和消费者,通过调用生产者的方法,将文件内容发送到Kafka主题:

fileProducerService.produceFile("file-topic", "path/to/your/file.txt");

消费者将接收到文件流,并将其保存到本地文件。你可以通过查看消费者的日志或检查保存的文件来验证流程是否正常运行。文章来源:https://www.toymoban.com/news/detail-789429.html

结语

通过对kafka的一些常用使用案例代码分析,希望这个能够帮助大家更深入地理解和使用Spring Boot集成Kafka的高级功能。感谢阅读!文章来源地址https://www.toymoban.com/news/detail-789429.html

到了这里,关于使用Spring Boot集成中间件:Kafka的高级使用案例讲解的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!