来自清华大学交叉信息研究院的研究者提出了「ViLa」(全称 Robotic Vision-Language Planning)算法,其能在非常复杂的环境中控制机器人,为机器人提供任务规划。

GPT-4V 已经能帮我们设计网站代码,控制浏览器,这些应用集中在虚拟数字世界中。假如我们把 GPT-4V 带入现实世界,让它作为控制机器人的大脑,会有什么有趣的结果呢?

最近,来自清华大学交叉信息研究院的研究者提出「ViLa」算法,实现了让 GPT-4V 走进物理世界中,为机器人操作日常生活物品提供任务规划。

ViLa 全称是 Robotic Vision-Language Planning,它利用 GPT-4V 在视觉和语言两个模态上做联合推理的能力,把抽象的语言指令分解为一系列可执行的步骤。ViLa 最让人惊喜的是它展现出对物理世界中常识的理解,而这是很多之前基于大语言模型(LLM)的机器人任务规划算法所欠缺的。

比如在下面这个视频中,研究人员让机器人拿出搁板上的漫威模型(钢铁侠)。ViLa 能理解这个场景中物体的复杂空间位置关系,即纸杯和可乐罐挡住了钢铁侠,要拿出钢铁侠,则必须先拿走纸杯和可乐罐。

又比如在下面这个视频中,研究人员让机器人为上美术课的孩子们整理出一个桌面区域。ViLa 能根据这个场景中的剪纸,推断出现在上课所需的工具是剪刀,把其它危险物品,比如螺丝刀和水果刀放入收纳盒中。

可以看出,ViLa 具有像人类一样的常识,能在非常复杂的环境中控制机器人,为机器人提供任务规划。

- 论文地址:https://arxiv.org/pdf/2311.17842.pdf

- 论文主页:https://robot-vila.github.io/

- 论文视频:https://www.youtube.com/watch?v=t8pPZ46xtuc

接下来,该研究详细介绍了 ViLa 这项研究成果。

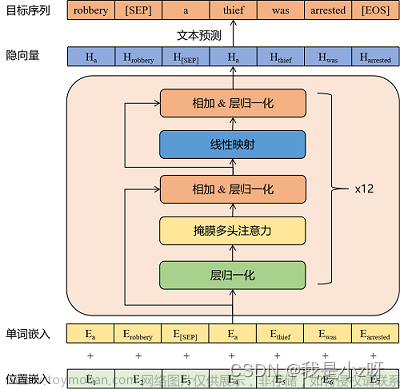

方法介绍

ViLa 使用了视觉语言大模型 (VLM) 来做机器人的任务规划。如今的 VLM 在图像和语言两个模态上都展现出前所未有的理解和推理能力。将 VLM 应用到机器人任务中,它能基于当前环境的视觉观测,结合自己丰富的世界知识进行推理。作者团队提出了 ViLa 算法,主张直接使用视觉语言大模型(如 GPT-4V),将高级抽象指令分解为一系列低级可执行技能。

给定一条语言指令和当前的视觉观测图像,ViLa 利用 GPT-4V 通过链式思维推理来理解环境场景,随后生成多步的计划。接着,这个计划的第一步由一个基本策略来执行。最后,已经执行的步骤被添加到已完成的计划中,使得在动态环境中实现闭环规划方法。

GPT-4V 由于经过大规模互联网数据的训练,展现出了卓越的多样性和极强的泛化能力。这些特性使得它特别擅长处理论文中提出的开放世界场景。此外,作者团队发现,即使是在零样本(Zero-Shot)学习模式下运行,由 GPT-4V 驱动的 ViLa 也能够解决多种具有挑战性的规划问题。这显著减少了之前方法中所需的提示工程。

实验

ViLa 在现实世界和模拟环境中都展示了以零样本方式解决各种日常操作任务的能力,有效处理各种开放集指令和物体对象。作者团队通过大量实验证明了 ViLa 的优势:1. ViLa 能深刻理解视觉世界中的常识,2. ViLa 支持灵活的多模态目标指定方法,3. ViLa 自然地支持视觉反馈和闭环控制。

A. ViLa 能深刻理解视觉世界中的常识

语言和图像作为不同的信号类型,各具独特性质:语言由人类生成,富含语义,但在表达全面信息方面有限;相比之下,图像作为自然信号,包含细致的低层次特征,一张图像便能够捕捉场景的全部信息。在难以用语言简单概括的复杂场景下,这种差异尤为突出。通过将视觉图片直接结合到推理过程中,ViLa 可以理解视觉世界的常识知识,擅长处理需要全面了解空间布局或物体属性的复杂任务。

空间布局

用简单的语言描述复杂的空间布局,尤其是物体定位、位置关系和环境限制,是非常困难的。通过直接将视觉融入推理过程,ViLa 可以精确地识别物体在场景中的位置,以及它们之间的关系。

在 “拿可乐罐” 任务中,ViLa 发现可乐罐不在视线中,于是聪明地打开了冰箱并找到了它。而基线方法则会在可乐罐不在视线中的情况下给出” 拿起可乐罐 “的错误指令。

在 “拿空盘子” 任务中,ViLa 知道在拿起蓝色盘子之前,需要先把它上面的苹果和香蕉移走。而基线方法则忽视了盘子上的物体,直接给出” 拿起蓝色盘子 “的错误指令。

物体属性

物体的定义涵盖多个属性,包括形状、颜色、材质、功能等。然而,自然语言的表达能力有限,因此在全面传达这些属性方面显得笨拙。此外,物体的属性与特定任务密切相关。以上原因使得过去的算法难以处理需要深入理解复杂物体属性的场景。然而,得益于对视觉和语言的联合推理,ViLa 对于物体在特定场景中的属性有深入的理解。

在 “准备美术课” 任务中,ViLa 认为螺丝刀和水果刀是危险物品,于是移走了它们;考虑到桌上的剪纸,ViLa 认为剪刀对美术课是必要的物品,于是留下了它。而基线方法则忽视了桌上的剪纸和美术课这一特定场景,认为剪刀也是危险物品,选择将其移走。

在 “挑选新鲜水果” 任务中,ViLa 可以精确地挑选出新鲜且完整的水果。而基线方法认为剥了一半的橘子和腐烂的香蕉都是完整且新鲜的水果。

作者团队在 8 个相关任务上进行了充分的定量实验。如表一所示,ViLa 在理解空间布局和物体属性任务上显著超过了基线方法。

B. 多模态目标指定

ViLa 支持灵活的多模态目标指定方法。ViLa 不仅能够利用语言指令,还能够利用多种形式的图像作为目标,甚至利用语言和图像的混合形式来定义目标。

视频中的四个任务分别表明:

- ViLa 可以将真实图片作为目标。

- ViLa 可以将抽象图片(如小孩的画,草稿等)作为目标。

- ViLa 可以将语言和图像的混合形式作为目标。

- ViLa 可以发现图片中手指指着的位置,并将其作为实际任务中的目标位置。

作者团队在这四个任务上进行了定量实验。如表二所示,ViLa 在所有任务中均表现出了强大的识别多模态目标的能力。

C. 视觉反馈

ViLa 以直观、自然的方式有效利用视觉反馈,在动态环境中实现鲁棒的闭环规划。

- 在 “堆木块” 任务中,ViLa 检测出了执行基本技能时的失败,于是重新执行了一遍基本技能。

- 在 “放薯片” 任务中,ViLa 意识到了执行过程中人的干扰。

- 在 “找猫粮” 任务中,ViLa 可以不断地打开抽屉 / 柜子来寻找猫粮,直到找到。

- 此外,ViLa 可以完成需要人机交互的任务,等待人握住可乐罐之后才松开夹爪。

作者团队在这四个任务上进行了定量实验。如表三中所示,通过自然地结合视觉反馈,闭环控制的 ViLa 的表现显著强于开环控制。

D. 模拟环境实验

在模拟环境中,ViLa 可以按照高级语言指令的指示,将桌子上的物体重新组织成特定的排列。

如表四中所示,ViLa 在模拟环境中的表现也显著超过了基线方法。

文章来源:https://www.toymoban.com/news/detail-789564.html

文章来源:https://www.toymoban.com/news/detail-789564.html

文章来源地址https://www.toymoban.com/news/detail-789564.html

到了这里,关于当GPT-4V充当机器人大脑,可能你都没AI会规划的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!