基于深度学习的信道估计

论文信息:

Soltani M, Pourahmadi V, Mirzaei A, et al. Deep learning-based channel estimation[J]. IEEE Communications Letters, 2019, 23(4): 652-655.

创新点:

- 信道时频响应建模为图像,将OFDM的时频特性视做一种2D图像信息。

- 将导频位置的通道响应视为LR图像,并将估计的通道响应视为HR图像。

- 利用基于深度学习的图像超分辨率和图像去噪技术估计信道。

Abstract

本文提出了一种用于通信系统信道估计的深度学习算法,将快速衰落通信信道的时频响应视为二维图像。目的是利用导频位置的一些已知值来找到信道响应的未知值。

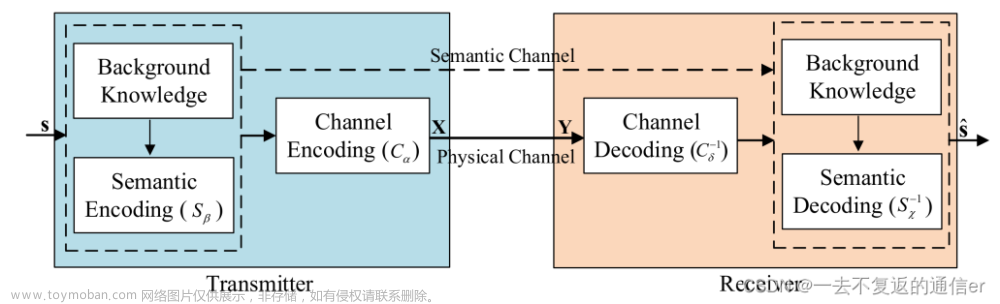

文中提出了一种利用深度图像处理技术、图像超分辨率(SR)和图像恢复(IR)的通用pipeline,该方案将导频值视为低分辨率图像,并使用SR网络与去噪IR网络级联来估计信道。

结果表明,该方法可以有效地用于信道估计。估计误差表明该算法可与充分了解信道统计信息的最小均方误差(MMSE)相媲美,并且优于近似线性MMSE。

INTRODUCTION & BACKGROUND

本文是对一些关键点做记录,详细信息请参考原文

1、导频结构

OFDM3种基本的导频结构:梳状comb-type,块状comb-type,格状lattice-type(scattered-type)

图中一列为一个ODFM符号

-

comb-type:

每个OFDM符号的子载波上周期性地放置导频信号。导频是周期性地插入导频符号的所有子载波中,所以块状导频的排列适用于频率选择性信道。对于快衰落信道,如果缩短导频符号的周期来跟踪信道变化导频开销会过高。导频符号的周期需小于等于信道的相干时间。 -

block-type:

在每个OFDM符号的子载波上周期性地放置导频信号,然后利用这些导频信号进行频域插值,沿频率轴进行信道估计。为了跟踪频率选择性信道的特性,导频在频率上的周期小于等于相干宽带。 -

lattice-type(scattered-type):

时间轴和频率轴两个方向插入导频。导频分散在时间和频率轴上,使信道估计在时域和频域上插值更为便利。为了跟踪信道的时变和频率选择特性,导频符号的排列需满足:1、导频符号在时间上的周期小于多普勒扩展的倒数;2、导频符号在频率上的周期小于最大时延扩展的倒数。

2、信道估计Channel Estimation

OFDM系统中,在 kth 个时隙和 ith个子载波时,输入输出对应的响应公式为:

Y

i

,

k

=

H

i

,

k

X

i

,

k

+

Z

i

,

k

Y_{i,k} = H_{i,k}X_{i,k} + Z_{i,k}

Yi,k=Hi,kXi,k+Zi,k

Y

i

,

k

,

H

i

,

k

,

Z

i

,

k

Y_{i,k},H_{i,k} ,Z_{i,k}

Yi,k,Hi,k,Zi,k分别是接收信号、发送 OFDM 符号和高斯白噪声。

H

i

,

k

=

h

[

1

]

,

h

[

2

]

,

.

.

.

,

h

[

N

]

H_{i,k} = { h[1], h[2],...,h[N] }

Hi,k=h[1],h[2],...,h[N]其中

h

[

k

]

h[k]

h[k]为

k

t

h

k_{th}

kth时隙下的信道频率响应

信道估计的目的就是通过一定的方法去收发情况推算出信道信息

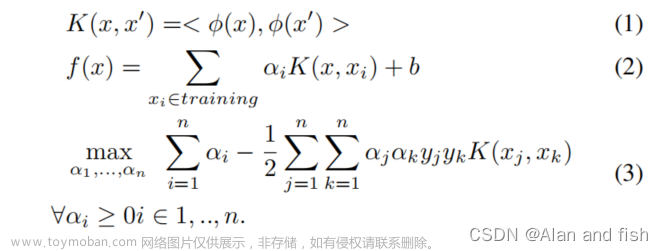

3、传统的基于导频的估计方法

- 最小二乘 Least Square (LS)

- 最小均方误差 Minimum Mean Square Error (MMSE)

- 近似线性最小均方误差 (ALMMSE)

以上算法的参考资料:信道估计—LS、MMSE、LMMSE准则

4、超分图像重建Super-Resolution and Image Restoration

论文中提出了一种两阶段方法来估计信道估计网络。首先,使用图像超分辨率SR算法来增强 LR 输入的分辨率。然后,利用图像恢复IR方法来消除噪声影响。SRCNN网络实现SR,DnCNN网络实现IR。

图像的超分辨率重建技术指的是将给定的低分辨率图像通过特定的算法恢复成相应的高分辨率图像。(示意图与本文无关仅作超分重建示例)

CHANNEL & NET

Channel Image

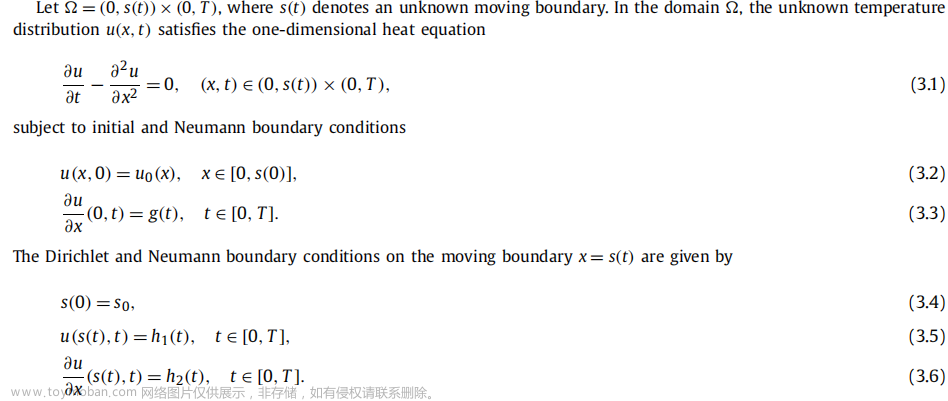

LTE标准考虑SISO连接的通信系统下,将信道的时频响应的复数值的实部虚部视作两个2D图像。

Network Structure

文中提出的神经网络目标是使用传输的导频来估计信道的整个时频,导频传输采用格型导频排列。网络包括SR与IR两个部分。

1. 导频位置处的信道估计值(可能有噪声)被视为信道图像的 LR 和噪声版本。

2. 分两次将实部虚部对应的LR图像输入到SR网络中,通过SR网络输出包含估计信息的信道响应H。

3. IR网络的作用是消除SR图像中的噪声干扰。

文章因篇幅原因没有展示两个网络的结构图,但也通过文字的形式说明了网络的结构和相关信息。

- SRCNN

第一层使用 64 个大小为 9 × 9 的Filter(卷积核),ReLu 激活。

第二层使用 32 个大小为 1 × 1 的卷积核,ReLu 激活。

第三层使用一个大小为 5 × 5 的卷积核来重建图像。 - DnCNN

一个基于残差学习的网络,由 20 个卷积层组成。

第一层使用 64 个大小为 3 × 3 × 1 的卷积核,后跟 ReLU。

随后的 18 个卷积层中的每一个都使用 64 个大小为3 × 3 × 64 的卷积核,然后进行批量归一化和ReLU。

最后一层使用一个3 × 3 × 64 滤波器来重建输出。

SR Network – SRCNN

SRCNN的网络结构仅包含三个卷积层(SRCNN示意图)

- 图像特征提取层(Patch extraction and representation):通过CNN将图像的特征提取出来存到向量中,这个向量里包含了多张feature map,即一张图所含的一些特征。

- 非线性映射层:将上一层的feature map进一步做非线性映射处理,使得网络深度加大,更有利于学到东西。

- 网络重建层:重建用于将feature map进行还原成高分辨率图像,通过误差反向传递来学习整个模型的参数。

IR Network – DnCNN

DnCNN结构示意图

DnCNN在VGG的基础上进行修改,网络结构是(卷积、BN、ReLU)级联的结构,模型内部并不像ResNet一样存在跳远连接,而是在网络的输出使用残差学习。模型的主要任务是,根据带噪声图像y,估计干净图像x ,但是,模型的直接输出并不是x ,而是噪声图像v ,最终干净图的获取过程用公式表达就是

x

=

y

−

f

(

y

)

=

y

−

v

x=y-f(y)=y-v

x=y−f(y)=y−v 。DnCNN作者把这种方式称作残差学习(Residual Learning),并通过实验证实了残差学习对于提高训练稳定性和去噪效果的好处。

训练过程

两个网络级联下损失函数应该视作一个整体,即损失函数是直接输出和输入的去定义的,本文为简化训练,将损失函数分为了两个部分SR的损失函数C1与IR的损失函数C2。同时对应信道估计来说,SNR是影响网络的重要指标,但不可能针对连续SNR值对网络进行训练,因此文中选择了个别SNR值训练网络。

SIMULATION RESULTS

实验条件设置

- 考虑SISO系统,对于信道建模和导频传输,使用了维也纳大学开发的广泛使用的LTE模拟器Vienna LTE-A模拟器。

- Keras 和 Tensorflow 用于实现我们提出的方案。对于 SR 和 IR 网络,训练率设置为 0.001,批量大小为 128,最多 500 次迭代。训练集、测试集和验证集分别由 32000、4000 和 4000 个通道组成。

- 实验中,OFDM设计与LTE标准一致每个帧由 14 个时隙和 72 个子载波组成。对于Vehicle-A(VehA)和SUI5(长时延扩展模型)的无线信道模型,考虑载波频率为2.1 GHz、带宽为1.6 MHz、UE(用户设备)速度为50 km/h。

实验1:VehA 信道模型(车载信道)

在12dB的SNR值下训练的所提出的ChannelNet具有与理想MMSE相当的性能,并且比理想的ALMMSE和估计的 MMSE。

在22dB的SNR值(表示为HIGH-SNR)下训练的网络的性能将优于LOW- SNR。

实验2:SUI5 信道模型(最大路径衰落信道)

SUI5比VehA的信道复杂度增加,网络性能有所下降。

实验3:导频数量–VehA信道模型

在20dB SNR 水平下不同数量导频的仿真结果。在该特定 SNR 值下训练的 ChannelNet,优于估计 MMSE 和理想 ALMMSE 方法并且与理想 MMSE 相当。

CONCLUSION

论文将衰落信道的时频响应视为二维图像,并应用SR和IR算法根据导频值找到整个信道的状态。结果表明,ChannelNet的性能与MMSE算法具有很强的竞争力。介绍了两步网络训练过程,并讨论了如何使用多个ChannelNets来最好地估计信道。文章来源:https://www.toymoban.com/news/detail-791126.html

本文参考资料

1.Soltani M, Pourahmadi V, Mirzaei A, et al. Deep learning-based channel estimation[J]. IEEE Communications Letters, 2019, 23(4): 652-655

2.信道估计中的导频结构

3.信道估计—LS、MMSE、LMMSE准则文章来源地址https://www.toymoban.com/news/detail-791126.html

到了这里,关于论文阅读--Deep Learning-Based Channel Estimation的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!