LAURAGPT:使用 GPT 聆听、注意、理解和重新生成音频

该论文于2023年10月11日发表在预印本arxiv https://arxiv.org/abs/2310.04673

1.论文的研究任务?

- LauraGPT,是一个用于音频识别、理解和生成的统一 GPT 模型。 LauraGPT 是一种多功能语言模型,可以处理音频和文本输入并以任一模式生成输出。它可以执行与内容、语义、副语言学和音频信号分析相关的广泛任务。

- 任务包括自动语音识别、语音到文本翻译、文本到语音合成、机器翻译、语音增强、自动音频字幕、语音情感识别和口语理解。

2.目前的方法?

- 一类现有方法采用编码器-解码器架构,将连续语音特征转换为离散文本标记。这些模型可以使用单个模型执行多语言自动语音识别(ASR)和语音到文本翻译(S2TT),利用大规模语音文本配对数据。然而,这些模型无法从文本标记生成语音输出,这限制了它们在文本到语音合成(TTS)等语音生成任务中的应用。

- 另一类现有方法在将连续音频转换为离散标记,并将文本和音频标记合并为共享词汇表后采用仅解码器框架。这些模型可以使用单个模型执行 ASR、TTS、S2TT、机器翻译 (MT) 和语音到语音翻译 (S2ST) 任务,从而实现文本和音频之间更自然、更灵活的交互。然而,它们可能会遭受因将语音信号量化为离散标记而导致的信息丢失,这导致使用连续语音特征的模型的性能显着下降。此外,虽然能够支持面向内容/语义的语音任务,但它们无法处理语音信号处理相关的任务,例如语音增强 (SE) 或一般音频任务,例如自动音频字幕 (AAC)。

3.相关工作

音频文本建模

- (1)通用音频编码器的自监督学习,例如 wav2vec 2.0 (Baevski et al., 2020)、HuBERT (Hsu et al., 2021) 和 WavLM (Chen et al., 2022),可以利用未标记的语音数据进行预训练,但它们需要额外的特定于任务的模型来执行下游音频任务。

- (2)具有特定于模态的前网络和后网络的编码器-解码器模型,例如 SpeechT5 (Ao et al., 2022) 和 SpeechNet (Chen et al., 2021b),可以使用单个模型执行各种语音任务,但它们需要采用特定于模态的前网络和后网络。网络来处理不同的输入/输出模式。

- (3)将音频特征转换为文本的模型,如Whisper (Radford et al., 2022)、USM (Zhang et al., 2022)、USM (Zhang et al.),专注于将连续语音特征转换为文本,但无法支持音频生成任务。

- (4) 具有离散音频标记的仅解码器模型。例如 VioLA (Wang et al., 2023b)、AudioPaLM (Rubenstein et al., 2023)、SpeechGPT (Zhang et al., 2023a) 和 SpeechGen (Wu et al., 2023),仅使用解码器Transformers 将离散音频标记和文本标记建模为共享词汇表,但它们可能会因音频信号量化为离散标记而导致信息丢失。

根据文本提示生成音频

- (1)在第一类中,连续表示,例如话语级嵌入(Elizalde et al., 2022; Liu et al., 2023; Huang et al., 2023a)和梅尔频谱图(Nachmani et al., 2023) ) 被用作目标。然而,连续表示对单一语言模型中的文本和音频的统一建模提出了挑战。

- (2) 在第二类中,离散编解码器标记被用作音频表示,并由扩散模型(Yang et al., 2023)或自回归语言模型(Kreuk et al., 2023; Borsos et al., 2023; Copet et al., 2023)生成等人,2023;Wang 等人,2023a)。其中,在AudioGen (Kreuk et al., 2023)、AudioLM (Borsos et al., 2023)、MusicGen (Copet et al., 2023)等模型中,在语言模型之后使用多个输出头来预测同步或延迟的编解码器令牌组。然而,这种方法仅适用于音频生成,可能不适用于各种音频文本任务。

- (3)在VALL-E(Wang et al., 2023a)中,语言模型预测第一个量化器的输出标记,而其余量化器的标记由非自回归模型逐一预测。该机制需要大量的预测程序才能达到可接受的质量。

- 作者在 LauraGPT 中提出了一种单步编解码器声码器,其中基于transformer的预测器经过训练,通过最小化重建损失来估计所有编解码器标记组,而不是多组索引的总和。作者的方法将音频生成过程简化为单个前馈计算,并克服了多模态分布性质带来的预测挑战。

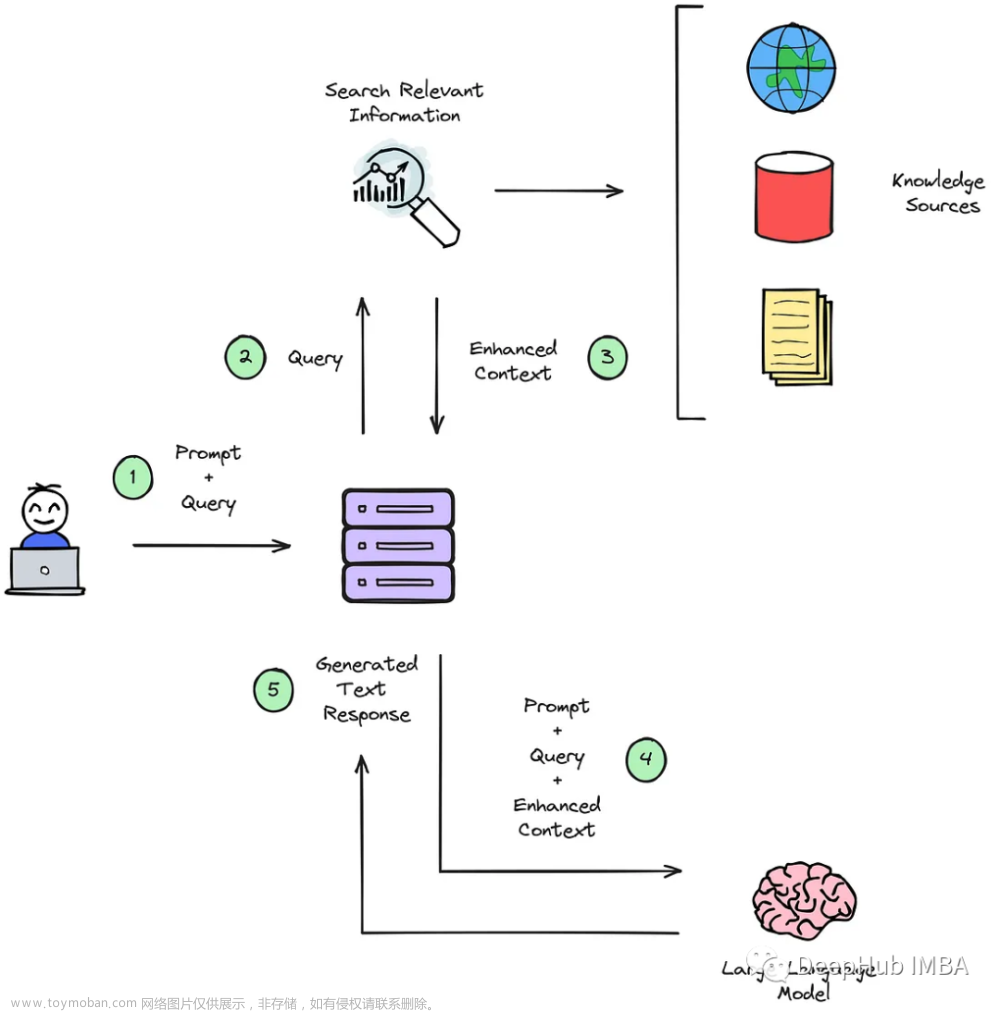

4.作者的方法

-

模型采用仅解码器的 Transformer 框架

-

LauraGPT 包含三个组件:GPT backbone, an audio encoder, and a codec vocoder。对于音频输入,我们提取对数压缩的梅尔频谱图特征,并将其馈送到audio encoder,而音频输出则通过audio tokenizer离散为token。 -

对于文本数据,输入和输出都是由text tokenizer处理

预训练的GPT BACKBONE AND TEXT TOKENIZER

利用开源语言模型 Qwen(Bai 等人,2023)作为骨干文章来源:https://www.toymoban.com/news/detail-791212.html

AUDIO TOKENIZER

- 作者的codec model由卷积循环编码器/解码器网络 (Tagliasacchi et al., 2020) 和残差矢量量化器 (RVQ) (Vasuki & Vanathi, 2006) 组成。

- 通过以下修改增强了原始 Encodec 模型。首先,在幅度谱域添加重构损失,以提高中频和高频音频的质量。

- 其次,为了解决长序列长度的挑战,我们堆叠了五个跨步卷积块,步幅为 [8, 5, 4, 2, 2],导致每组的令牌率为 25 Hz。

- 第三,RVQ模块包括32个具有结构化丢失的量化器,每个量化器的词汇量为1024。这种修改通过更多量化器提高了语音质量,同时保留了浅量化器中的最多信息。

MODIFIED LANGUAGE MODEL FOR UNIFYING AUDIO-TEXT MODELING

- 在纯文本 GPT 中,标记化文本首先通过嵌入矩阵,该矩阵将离散标记转换为密集嵌入。

- 然而,实验表明,使用单个分词器来表示不同的音频信号会严重损害所有音频任务的性能

- 因此,为了在均匀性和性能之间取得平衡,使用基于 Conformer 的编码器将音频输入转换为连续表示,而标记化文本输入继续进行嵌入矩阵变换以生成密集向量。

总结

阿里发布的语音大模型,已经开源https://github.com/alibaba-damo-academy/FunCodec/tree/master/egs/LibriTTS/text2speech_laura

感兴趣的可以研究一下文章来源地址https://www.toymoban.com/news/detail-791212.html

到了这里,关于LAURAGPT:使用 GPT 聆听、注意、理解和重新生成音频的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!