机器视觉企业实战

机器视觉企业实战, 又名:机器视觉之从调包侠到底层开发(第5天)

这个专栏是偏实战的系列,由浅入深学习机器视觉。最后可以收获:从悬赏一万的项目最后可以做到企业级的视觉应用

目录

- 目标检测数据标注

- 1.1 数据收集与数据标注

- 1.2 数据标注的通用规则

- 1.3 案例实现

- 1.4 视频与图像数据标注的差异

- 1.5 案例实现

- 1.6 企业是如何标注数据的

- 1.7 举例子

- 1.8 个人或者中小公司该怎么做

- 理解图像是由像素组成

- 2.1 理解SVM和将矩阵转化为向量的SVM

- 2.2 预处理操作和归一化

- 2.3 使用PyQt进行可视化处理

- 2.4 识别手写数字的代码

- 行人检测基础

- 3.1 HOG+SVM

- 3.2 检测流程

- 1.1 数据收集与数据标注

- 1.2 数据标注的通用规则

- 1.3 案例实现

- 1.4 视频与图像数据标注的差异

- 1.5 案例实现

- 1.6 企业是如何标注数据的

- 1.7 举例子

- 1.8 个人或者中小公司该怎么做

1. 目标检测数据标注

1.1 数据收集与数据标注

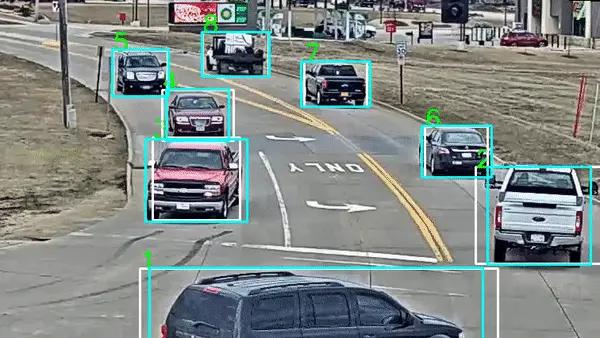

数据标注是目标检测任务的基础。它包括从不同来源收集图像或视频,并对这些数据进行标注,以确定目标的位置和类别。数据标注可能涉及手动绘制边界框或多边形,同时标记目标的类别。数据的质量和准确性对于训练高性能目标检测模型至关重要。

1.2 数据标注的通用规则

在进行目标检测数据标注时,需要遵循一些通用规则,以确保标注的一致性和可用性。这些规则包括:

- 边界框应精确地包围目标,不过多也不过少。

- 标签应与目标的类别一致,确保模型能够正确识别不同类别的目标。

- 多个标注者之间应进行验证和一致性检查,以减少标注误差。

- 对于遮挡或部分可见的目标,应进行适当的标注,以提高模型的鲁棒性。

1.3 案例实现

以下是一个简单的Python示例代码,用于读取图像并在图像上绘制边界框,模拟目标检测数据标注的过程:

import cv2

# 读取图像

image = cv2.imread('image.jpg')

# 定义边界框坐标和类别

bbox = [100, 100, 200, 200] # [x_min, y_min, x_max, y_max]

class_name = 'person'

# 绘制边界框

cv2.rectangle(image, (bbox[0], bbox[1]), (bbox[2], bbox[3]), (0, 255, 0), 2)

# 在边界框上标记类别

cv2.putText(image, class_name, (bbox[0], bbox[1] - 10), cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 255, 0), 2)

# 显示带有边界框的图像

cv2.imshow('Annotated Image', image)

cv2.waitKey(0)

cv2.destroyAllWindows()

1.4 视频与图像数据标注的差异

视频目标跟踪数据标注与图像数据标注略有不同,因为它涉及到跟踪目标在连续帧中的位置。通常,视频数据标注需要更多的时间和精力,因为标注者需要在多个帧上追踪目标。标注者需要使用专业工具来准确标注目标在连续帧中的位置。

1.5 案例实现

以下是一个简化的示例代码,用于模拟视频目标跟踪数据标注的过程:

import cv2

# 打开视频文件

cap = cv2.VideoCapture('video.mp4')

# 创建一个窗口显示视频

cv2.namedWindow('Video Tracking', cv2.WINDOW_NORMAL)

while True:

ret, frame = cap.read()

if not ret:

break

# 在帧上绘制目标位置(这里只是模拟,实际中需要手动标注)

x, y, w, h = 100, 100, 50, 50

cv2.rectangle(frame, (x, y), (x + w, y + h), (0, 255, 0), 2)

# 显示带有目标框的帧

cv2.imshow('Video Tracking', frame)

# 按ESC键退出循环

if cv2.waitKey(30) & 0xFF == 27:

break

# 释放资源

cap.release()

cv2.destroyAllWindows()

这个示例演示了如何在视频中绘制简单的目标框。在实际应用中,标注者需要使用专业工具来准确标注目标在连续帧中的位置,以支持视频目标跟踪任务。

1.6 企业是如何标注数据的

在企业中,数据标注是一个关键的任务,特别是在进行机器学习和深度学习模型的训练时。以下是企业中数据标注的一般流程和方法:

- 数据收集:首先,企业需要收集大量的原始数据,这些数据通常是未标注的,可以是图像、视频、文本、音频等不同类型的数据。数据可以来自各种来源,如互联网、传感器、用户上传等。

- 数据预处理:在进行数据标注之前,通常需要对原始数据进行预处理。这可能包括去除噪声、图像尺寸调整、数据清洗、文本分词等操作,以确保数据的质量和一致性。

- 标注策略:企业需要制定标注策略,明确定义目标标注的任务和标准。这包括确定目标类别、标注的粒度(如边界框、像素级标注等)、标注样本的数量和多样性等。

- 标注工具:企业通常会使用专业的数据标注工具或平台,以提高标注的效率和准确性。这些工具可以支持图像标注、文本标注、语音标注等不同任务。

- 标注团队:在标注过程中,企业可能需要组建标注团队,由专业标注员进行标注工作。标注员需要接受培训,以确保标注的一致性和准确性。

- 质量控制:企业需要建立质量控制流程,以检查和验证标注的质量。这可以包括双重标注、标注一致性检查、抽样检查等。

- 标注数据管理:标注的数据需要进行有效的管理和存储,以确保数据的安全性和可访问性。这可以使用数据管理系统或云存储解决方案来实现。

- 迭代和改进:标注是一个迭代过程,企业通常会不断改进标注策略和质量控制流程,以提高数据标注的效率和质量。

- 成本管理:数据标注可能会涉及高成本,企业需要有效管理标注成本,考虑外包标注、自动化标注等方法来降低成本。

- 安全和隐私:在进行数据标注时,企业需要确保敏感信息的保护和隐私合规性,特别是涉及用户数据的情况。

不同企业和项目可能有不同的数据标注需求和流程,但上述步骤通常构成了企业中数据标注的一般流程。数据标注的质量对于训练高性能的机器学习和深度学习模型至关重要,因此它在企业中具有重要地位。

1.7 举例子

以下是一个例子,说明了企业中如何标注图像数据以进行对象识别:

场景: 一家电子商务公司希望改进其产品搜索引擎,以提供更准确的搜索结果。他们计划使用计算机视觉技术,让用户能够通过拍摄或上传商品图像来搜索相关产品。

数据收集: 公司开始收集包含各种商品的图像,这些图像来自供应商、用户上传以及公司自己的摄影团队。这些图像包括鞋子、衣物、家电等各种商品。

数据预处理: 在进行标注之前,图像可能需要进行预处理,以确保它们的质量和一致性。这可能包括图像尺寸调整、去除背景噪声、调整光照等。

标注策略: 公司需要明确定义标注任务。在这种情况下,他们决定进行对象识别标注,即识别图像中的商品以及它们的位置。

标注工具: 公司选择了一款专业的图像标注工具,使标注员能够在图像中框出商品并添加类别标签。这些标注工具通常提供可视化界面,使标注员的工作更加高效。

标注团队: 公司组建了一个标注团队,由经过培训的标注员组成。标注员根据标注策略,对图像中的商品进行标注。

质量控制: 公司建立了质量控制流程,包括双重标注和一致性检查,以确保标注的准确性和一致性。

数据管理: 标注后的数据需要进行管理和存储,以备将来用于模型训练。公司可能会使用数据库或云存储来存储标注数据。

迭代和改进: 公司会不断迭代其标注策略和流程,以提高标注效率和数据质量。

成本管理: 企业需要考虑标注成本,可能会选择外包标注,或者尝试自动化标注方法以降低成本。

安全和隐私: 当涉及用户上传的图像时,公司需要确保用户隐私的合规性,并采取措施保护敏感信息。

通过这个例子,你可以看到在企业中如何进行图像数据标注,以满足计算机视觉项目的需求,从而改进产品和服务。数据标注是许多企业在机器学习和深度学习项目中的常见实践,有助于提高模型性能和用户体验。

1.8 个人或者中小公司该怎么做

个人或中小型公司在进行数据标注时,可以考虑以下一些常见的数据标注工具和平台:

- Labelbox: Labelbox是一款强大的在线数据标注平台,提供图像、文本、音频和视频等多种类型的标注支持。它具有用户友好的界面、自定义标签、协作功能以及数据管理和质量控制工具。适用于个人和小型团队。

- Supervisely: Supervisely是一个开源的数据标注平台,可以用于图像和视频的标注。它提供了许多预定义的标注工具,还支持自定义标签和自动标注功能。适用于中小型团队。

- VGG Image Annotator (VIA): VIA是一个免费的图像标注工具,适用于个人或小型团队。它支持多种标注任务,包括边界框、多边形、点和线等。VIA是一个开源项目,用户可以自定义扩展其功能。

- RectLabel: RectLabel是一款适用于macOS的图像标注工具,专注于对象检测任务。它具有简单直观的用户界面,适合个人和小型团队。

- CVAT (Computer Vision Annotation Tool): CVAT是一个开源的计算机视觉标注工具,支持图像和视频标注。它具有强大的协作功能,适用于中小型团队或项目。

- Amazon SageMaker Ground Truth: 如果你使用亚马逊云服务,Amazon SageMaker Ground Truth是一个集成的数据标注服务,可用于图像和文本标注。它提供了高度可扩展的标注工具和自动化标注功能。

- Scale AI: Scale AI是一个专业的数据标注服务提供商,适用于各种标注任务,包括计算机视觉、自然语言处理等。虽然它不是软件,但它可以帮助个人或中小型公司外包标注工作。

选择适合你需求的工具取决于你的项目规模、预算和标注类型。许多工具提供免费试用版或基本免费计划,以便你可以评估其适用性。在选择工具时,还要考虑数据安全、质量控制和工作流程集成等因素。

2.1 理解图像是由像素组成

手写数字图像是由像素组成的二维矩阵,每个像素代表图像的一部分。通常,这些图像以灰度值表示,其中0表示黑色,255表示白色。我们将首先加载手写数字图像数据集,然后将每个图像的像素值展平成一维向量。

from sklearn.datasets import load_digits

# 加载手写数字数据集

digits = load_digits()

# 获取图像数据和标签

X = digits.data

y = digits.target

2.2 理解SVM和将矩阵转化为向量的SVM

支持向量机(Support Vector Machine,SVM)是一种用于分类和回归的机器学习算法。对于手写数字识别,我们将使用SVM进行分类。首先,我们需要将图像矩阵转换为向量。这可以通过将图像的每一行连接起来来实现。

# 将图像矩阵转化为向量

X = X.reshape(X.shape[0], -1)

接下来,我们将数据集分成训练集和测试集,以便评估模型的性能。

from sklearn.model_selection import train_test_split

# 分割数据集为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

然后,我们可以使用Scikit-Learn的SVM分类器进行训练和预测。

from sklearn.svm import SVC

# 创建SVM分类器

svm_classifier = SVC(kernel='linear')

# 训练分类器

svm_classifier.fit(X_train, y_train)

# 预测测试集

y_pred = svm_classifier.predict(X_test)

2.3 预处理操作和归一化

在进行SVM分类之前,通常需要对数据进行一些预处理操作。其中一个重要的操作是归一化,以确保特征具有相似的尺度。

from sklearn.preprocessing import StandardScaler

# 创建归一化器

scaler = StandardScaler()

# 在训练集上拟合并进行归一化

X_train = scaler.fit_transform(X_train)

# 在测试集上应用相同的归一化

X_test = scaler.transform(X_test)

2.4 使用PyQt进行可视化处理

最后,我们可以使用PyQt创建一个简单的可视化界面,允许用户手写数字并使用我们训练的SVM模型进行识别。

from PyQt5.QtWidgets import QApplication, QMainWindow, QWidget, QVBoxLayout, QPushButton, QLabel, QCanvas

class DigitRecognitionApp(QMainWindow):

def __init__(self):

super().__init__()

self.initUI()

def initUI(self):

self.setGeometry(100, 100, 400, 400)

self.setWindowTitle("Digit Recognition App")

self.central_widget = QWidget()

self.setCentralWidget(self.central_widget)

layout = QVBoxLayout()

self.canvas = QCanvas()

layout.addWidget(self.canvas)

self.label = QLabel("Predicted Digit: ")

layout.addWidget(self.label)

self.recognize_button = QPushButton("Recognize")

self.recognize_button.clicked.connect(self.recognize_digit)

layout.addWidget(self.recognize_button)

self.central_widget.setLayout(layout)

def recognize_digit(self):

# 在这里添加识别手写数字的代码

pass

if __name__ == '__main__':

app = QApplication([])

window = DigitRecognitionApp()

window.show()

app.exec_()

这是一个用于创建一个具有可视化界面的手写数字识别应用程序。您可以在recognize_digit函数中添加用于识别手写数字的代码,该代码将使用我们训练的SVM模型。

2.5 识别手写数字的代码

下面是一个Python示例,使用了一个经典的深度学习框架TensorFlow和Keras库来构建一个手写数字识别模型:

# 导入必要的库

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers

# 加载MNIST数据集,这是一个包含手写数字图像的标准数据集

mnist = keras.datasets.mnist

(train_images, train_labels), (test_images, test_labels) = mnist.load_data()

# 对图像数据进行预处理

train_images = train_images / 255.0

test_images = test_images / 255.0

# 构建一个简单的深度学习模型

model = keras.Sequential([

layers.Flatten(input_shape=(28, 28)), # 将28x28的图像展平成一维向量

layers.Dense(128, activation='relu'), # 隐藏层1,使用ReLU激活函数

layers.Dense(64, activation='relu'), # 隐藏层2,使用ReLU激活函数

layers.Dense(10, activation='softmax') # 输出层,使用softmax激活函数,有10个输出节点,对应0-9的数字

])

# 编译模型

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

model.fit(train_images, train_labels, epochs=5)

# 评估模型性能

test_loss, test_accuracy = model.evaluate(test_images, test_labels)

print(f"Test accuracy: {test_accuracy}")

# 使用模型进行手写数字识别

import numpy as np

# 从测试集中随机选择一个图像

index = np.random.randint(0, len(test_images))

test_image = test_images[index]

# 使用模型进行预测

predictions = model.predict(np.array([test_image]))

# 打印预测结果

predicted_label = np.argmax(predictions)

print(f"Predicted label: {predicted_label}")

3.0 行人检测基础

3.1 HOG+SVM

行人检测的经典方法之一是使用HOG(Histogram of Oriented Gradients)特征结合SVM(Support Vector Machine)分类器。HOG特征可以有效地描述图像中的纹理和形状信息,而SVM则用于分类行人和非行人区域。

3.2 检测流程

行人检测的一般流程包括以下步骤:

- 图像预处理:对输入图像进行预处理,如尺寸调整和颜色空间转换。

- 特征提取:使用HOG等特征提取方法从图像中提取特征向量。

- 滑动窗口:在图像上使用滑动窗口进行检测,将提取的特征向量输入到SVM分类器中。

- 非极大值抑制:对于重叠的检测框,使用非极大值抑制(NMS)来去除冗余的检测结果。

- 案例实现:将上述流程实现为代码,以进行行人检测。

3.3 滑动窗口

滑动窗口是一种在图像上移动的矩形窗口,用于检测对象。在行人检测中,不同大小和位置的滑动窗口将在图像上滑动,并提取相应的特征进行分类。

3.4 非极大值抑制

非极大值抑制是一种用于消除重叠检测结果的技术。它会保留具有最高置信度得分的检测框,并删除其他高度重叠的框,以避免冗余检测。

3.5 案例实现

让我们来看一个简单的Python示例,演示如何使用HOG特征和SVM进行行人检测:

import cv2

import numpy as np

# 加载HOG+SVM模型

hog = cv2.HOGDescriptor()

hog.setSVMDetector(cv2.HOGDescriptor_getDefaultPeopleDetector())

# 加载图像

image = cv2.imread('pedestrian.jpg')

# 检测行人

rectangles, weights = hog.detectMultiScale(image)

# 绘制检测结果

for (x, y, w, h) in rectangles:

cv2.rectangle(image, (x, y), (x + w, y + h), (0, 255, 0), 2)

# 显示结果图像

cv2.imshow('Pedestrian Detection', image)

cv2.waitKey(0)

cv2.destroyAllWindows()

这个示例使用OpenCV库中的HOG特征提取器和默认的SVM模型来检测行人,并在图像上绘制检测结果。

行人检测是计算机视觉中的重要任务,可以在安防、自动驾驶等领域中发挥关键作用。

3.6 深入思考

滑动窗口(Sliding Window)

滑动窗口是一种技术,用于在图像上以不同的位置和尺寸滑动一个固定大小的窗口,然后对每个窗口内的图像区域进行检测。这个过程类似于将一个窗口移动到图像的不同位置,以寻找可能包含行人的区域。滑动窗口方法通常包括以下步骤:

- 定义滑动窗口的大小和步幅(stride)。

- 从图像的左上角开始,以设定的步幅在图像上滑动窗口。

- 对每个窗口内的图像区域应用行人检测算法,例如HOG+SVM,以判断是否包含行人。

- 如果窗口内检测到行人,则记录其位置和得分。

通过滑动窗口技术,可以在图像中检测出多个可能包含行人的区域,但这也可能导致重叠的检测框。

非极大值抑制(Non-Maximum Suppression,NMS)

非极大值抑制是一种用于删除多余检测框的技术,以确保每个行人只被标记一次。在滑动窗口检测过程中,可能会出现多个框重叠的情况,NMS 的目标是选择具有最高置信度的框,并删除其他重叠框。NMS 的主要步骤如下:文章来源:https://www.toymoban.com/news/detail-792467.html

- 对所有检测框按照其置信度得分进行排序,通常得分高的排在前面。

- 从得分最高的框开始,计算其与后面所有框的重合程度(IoU)。

- 如果某个框的IoU与当前框大于一个阈值(通常为0.5或更高),则删除该框,否则保留它。

- 继续对剩余的框执行相同的操作,直到所有框都被考虑。

这样,通过NMS,最终只保留了具有最高置信度的检测框,删除了重叠的框,从而优化了行人检测结果。文章来源地址https://www.toymoban.com/news/detail-792467.html

到了这里,关于机器视觉企业实战的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!