K8S集群中Pod与Pod之间网络故障排查思路

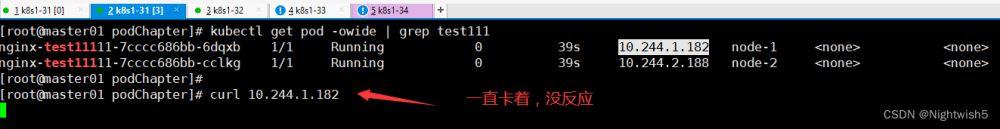

1.Pod与Pod之间通信故障

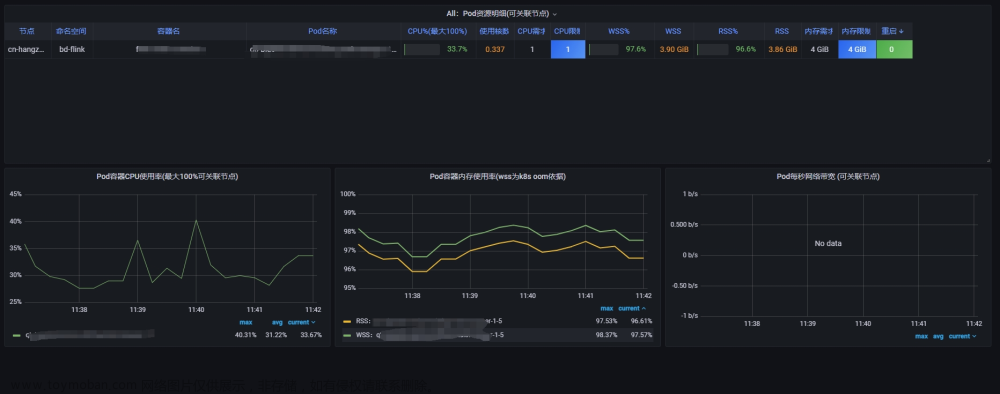

在K8S集群中,可能会出现Pod与Pod之间无法通信的现象,也就是说Pod无法跨Node主机进行通信,Pod与Pod之间网络不通讯会导致无法请求Pod中的服务,Apiserver也可能会无法获取Pod的运行状态,产生一系列问题。

Pod与Pod之间网络不通讯,很有可能是网络组件产生了异常导致的。

排查Pod网络通信故障的通用思路:

- 首先排查网络组件Calico的运行状态,即使处于Running状态,也要查一查Calico的运行日志,从日志中可以获取关键信息。

- 排查Kube-proxy组件的运行状态,当Kube-proxy异常时,Calico也会产生问题。

- 排查容器的运行日志,观察Docker服务的状态。

2.Pod与Pod之间网络通信故障排查思路

问题:由于Pod网络与物理机网段重合,导致Pod与Pod之间的网络不通讯。文章来源:https://www.toymoban.com/news/detail-792677.html

1)首先排查Cali文章来源地址https://www.toymoban.com/news/detail-792677.html

到了这里,关于K8S集群中Pod与Pod之间网络故障排查思路的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!