一、NLP简述

按模态分,AI的主流研究领域可以分为:

- NLP(文本)

- CV(图像)

- 语音

- 多模态

- …

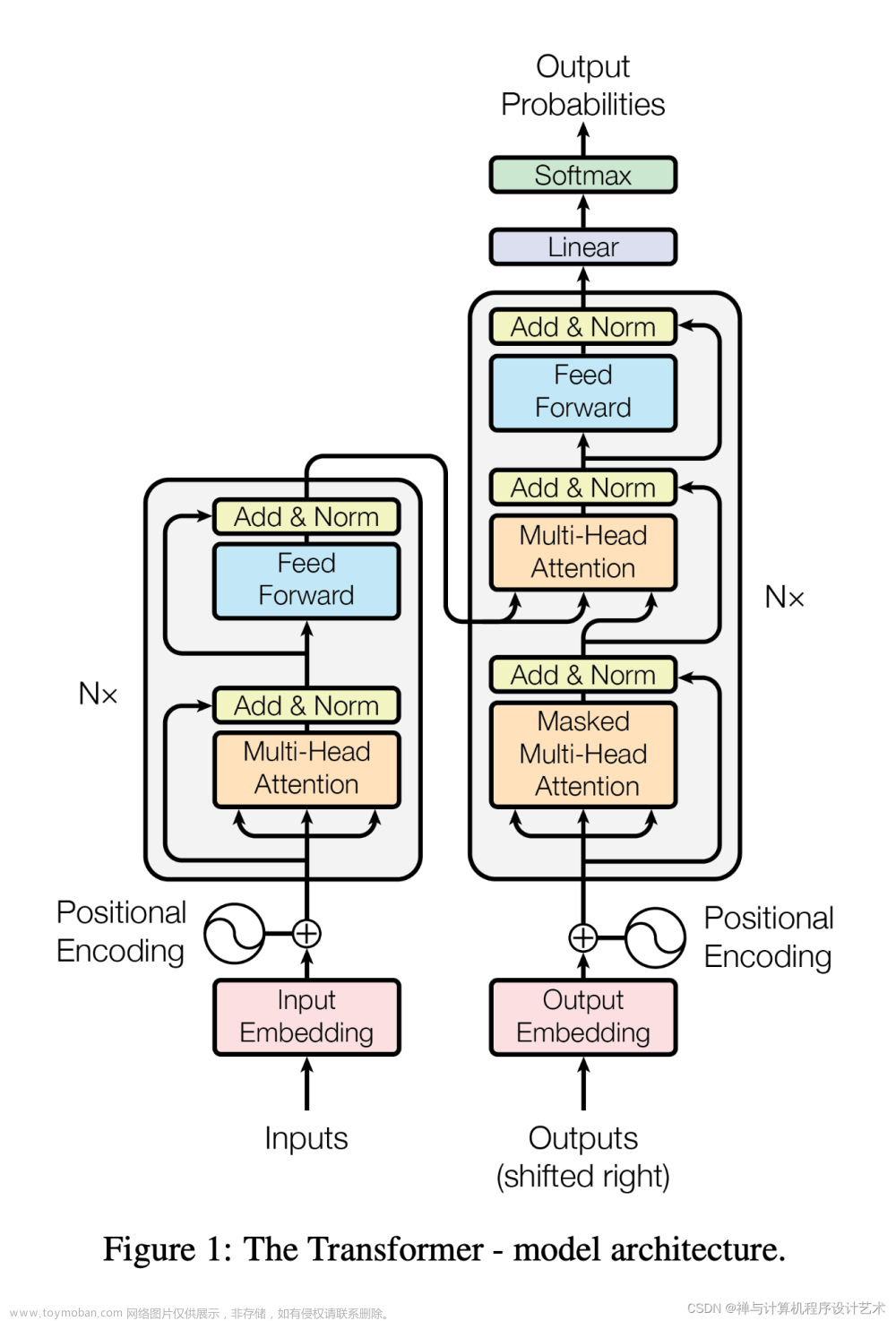

自Transformer发布以来,NLP迎来爆发式增长,成为AI目前发展最快的领域,大语言模型正式基于此背景产生的。

NLP 有2个核心的任务:

- 自然语言理解(NLU)

- 自然语言生成(NLG)

传统机器学习的 NLP 流程

-

获取文本数据,创建语料库

-

语料预处理:

- 清洗文本数据,去除不需要的信息,如标点符号、特殊字符。

- 分词:将文本划分为单词或标记,这是分析文本的基础。

- 词干化(Stemming)和词形还原(Lemmatization):将单词转换为其基本形式,减少词汇的变化形式。

- 停用词去除:去除常见但无实际含义的词语,如“and”、“the”等。

-

特征工程:将分词表示为计算机能够识别的类型,一般为向量

-

特征选择

-

建模

二、大语言模型发展史

研究人员发现,扩展预训练模型(Pre-training Language Model,PLM),例如扩展模型大小或数据大小,通常会提高下游任务的模型性能,模型大小从几十亿(1 B = 10亿)逐步扩展至千亿级别,后续研究者们将大型的PLM称之为LLM(Large Language Model)

从下图中可以看出大语言模型的发展阶段

从下图中可以看出近年来主流的大语言模型

OpenAI发展史

三、大模型的技术路线

从上图中可以看出,目前LLM的技术路线都是基于Transfomer架构的,主要分为Decoder only、Encoder only、Encoder-Decoder三种:文章来源:https://www.toymoban.com/news/detail-794100.html

| 技术路线 | 预训练架构 | 模型 | 描述 |

|---|---|---|---|

| Decoder only | Causal LM/Left-to-right LM | GPT-1,GPT-2,GPT-3,LLaMA等 | 具有自回归特性,只能看到历史输入序列,预测下一个token仅依赖于当前和历史输入,而不能参考后续输入信息,既能处理自然语言生成式任务(NLG),又能处理自然语言理解式任务(NLU)。 |

| Encoder only | Masked LM | BERT,RoBERTa等 | 不具有自回归特性,更适合于自然语言理解式任务(NLU),包括文本分类、情感分析,命名实体识别。 |

| Encoder-Decoder | Transformer LM | T5, BART等 | 擅长处理输入和输出序列之间存在复杂映射关系的任务,比如翻译和文本总结。 |

| Encoder-Decoder | Prefix LM | UniLM、GLM等 | 可以看到输入序列的前几个token作为条件上下文,在预测下一个token时同时参考前后信息,模型轻于Transformer LM,生成类任务的效果相差不大,语言理解类任务则存在明显差距。 |

文章来源地址https://www.toymoban.com/news/detail-794100.html

文章来源地址https://www.toymoban.com/news/detail-794100.html

四、必读论文

| 类别 | 流程/算法 | 论文、年份 | Google学术引用次数 |

|---|---|---|---|

| Transormer | 《Attention is all you need》,2017 | 104596 | |

| Decoder only | |||

| GPT-1 | 《Improving language understanding by generative pre-training》,2018 | 7365 | |

| GPT-2 | 《Language models are unsupervised multitask learners》,2019 | 7780 | |

| GPT-3 | 《Language models are few-shot learners》,2020 | 17941 | |

| GPT-3.5(ChatGPT) | 《Training language models to follow instructions with human feedback》,2022 | 3535 | |

| Llama | 《Llama: Open and efficient foundation language models》,2023 | 2974 | |

| Llama 2 | 《Llama 2: Open Foundation and Fine-Tuned Chat Models》,2023 | 1345 | |

| Encoder only | |||

| BERT | 《Bert: Pre-training of deep bidirectional transformers for language understanding》,2018 | 85950 | |

| RoBERTa | 《Roberta: A robustly optimized bert pretraining approach》,2019 | 10439 | |

| Encoder-Decoder | |||

| T5 | 《Exploring the limits of transfer learning with a unified text-to-text transformer》,2020 | 12381 | |

| BART | 《Bart: Denoising sequence-to-sequence pre-training for natural language generation, translation, and comprehension》,2019 | 7495 | |

到了这里,关于大语言模型系列-总述的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!