根据这篇文章:

大模型下载使我痛苦

得知 Huggingface 镜像站 https://hf-mirror.com

命令下载

网站首页会介绍下载方法

更多用法(多线程加速等)详见这篇文章。简介:

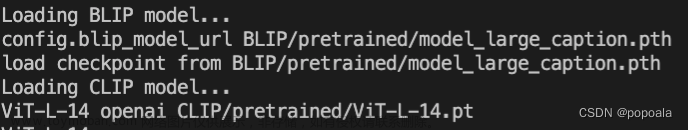

方法一:使用huggingface 官方提供的 huggingface-cli 命令行工具。

(1) 安装依赖

pip install -U huggingface_hubCopy

(2) 基本命令示例:

export HF_ENDPOINT=https://hf-mirror.comCopy

huggingface-cli download --resume-download --local-dir-use-symlinks False bigscience/bloom-560m \

--local-dir bloom-560mCopy

- 这里模型名称为

bigscience/bloom-560m

保存的文件夹为bloom-560mCopy

(3) 下载需要登录的模型(Gated Model)

请添加 --token hf_*** 参数,其中 hf_*** 是 access token,请在 huggingface官网这里获取。示例:

huggingface-cli download --token hf_*** \

--resume-download --local-dir-use-symlinks False meta-llama/Llama-2-7b-hf \

--local-dir Llama-2-7b-hfCopy

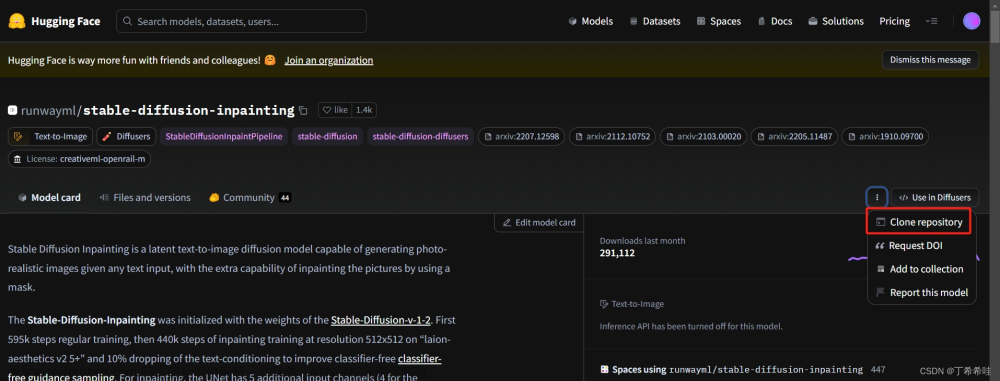

方法二:使用url直接下载时,将 huggingface.co 直接替换为本站域名hf-mirror.com。

使用浏览器或者 wget -c、curl -L、aria2c 等命令行方式即可。

下载需登录的模型需命令行添加 --header hf_*** 参数,token 获取具体参见上文。

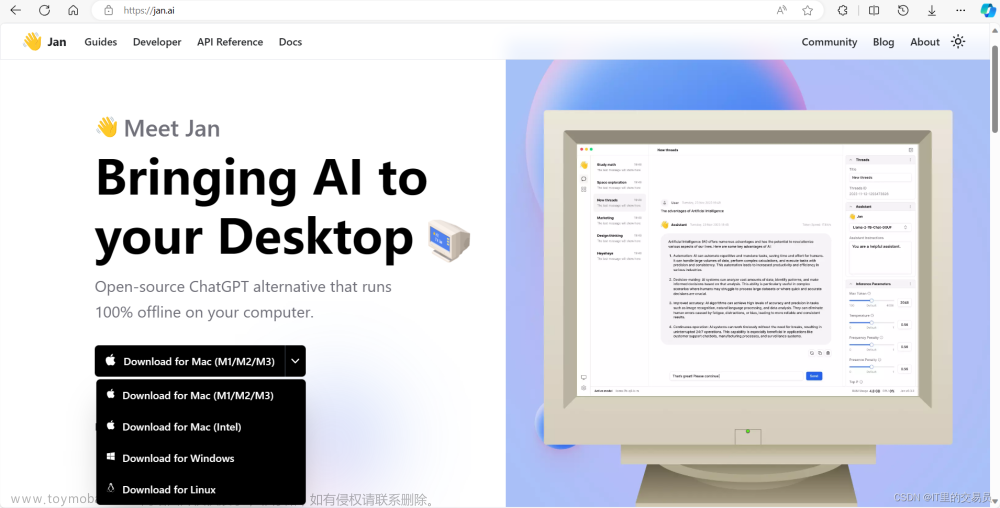

方法三:(非侵入式,能解决大部分情况)huggingface 提供的包会获取系统变量,所以可以使用通过设置变量来解决。

HF_ENDPOINT=https://hf-mirror.com python your_script.pyCopy

不过有些数据集有内置的下载脚本,那就需要手动改一下脚本内的地址来实现了

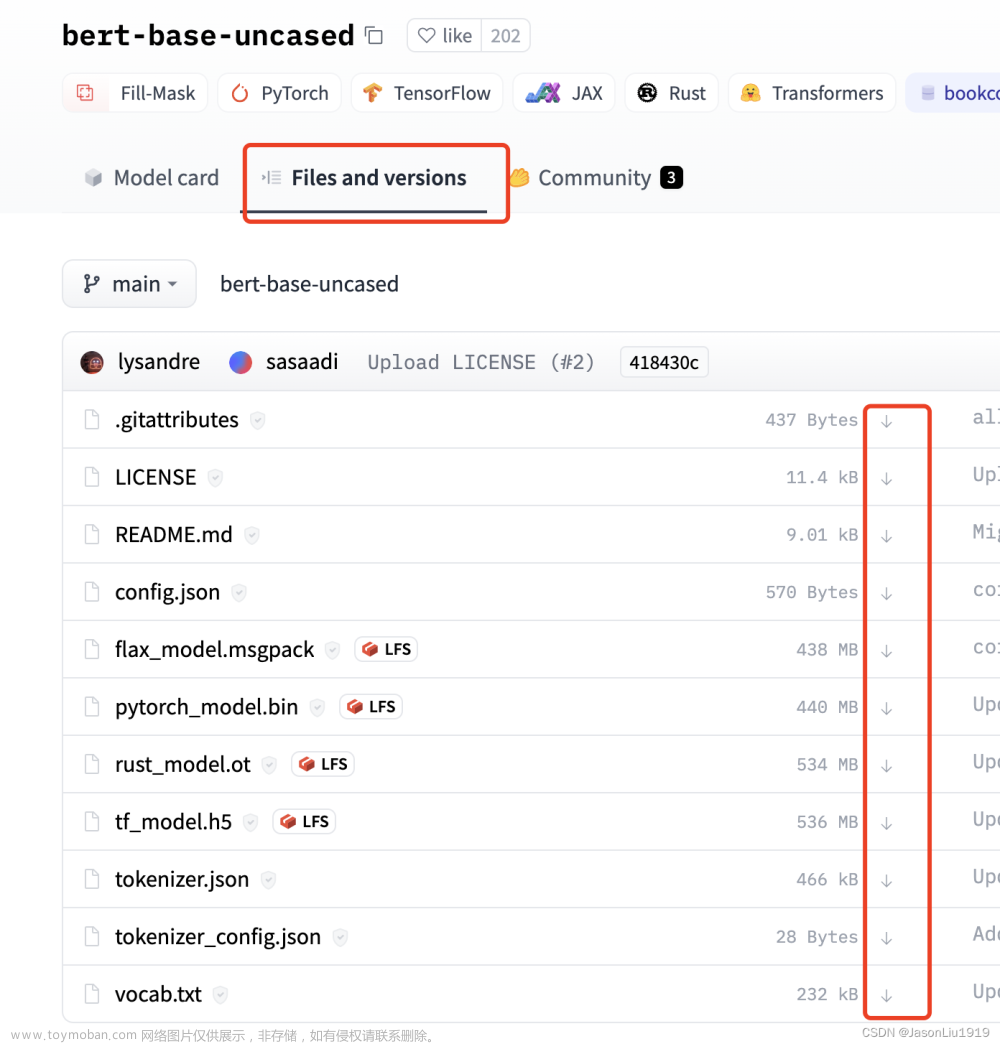

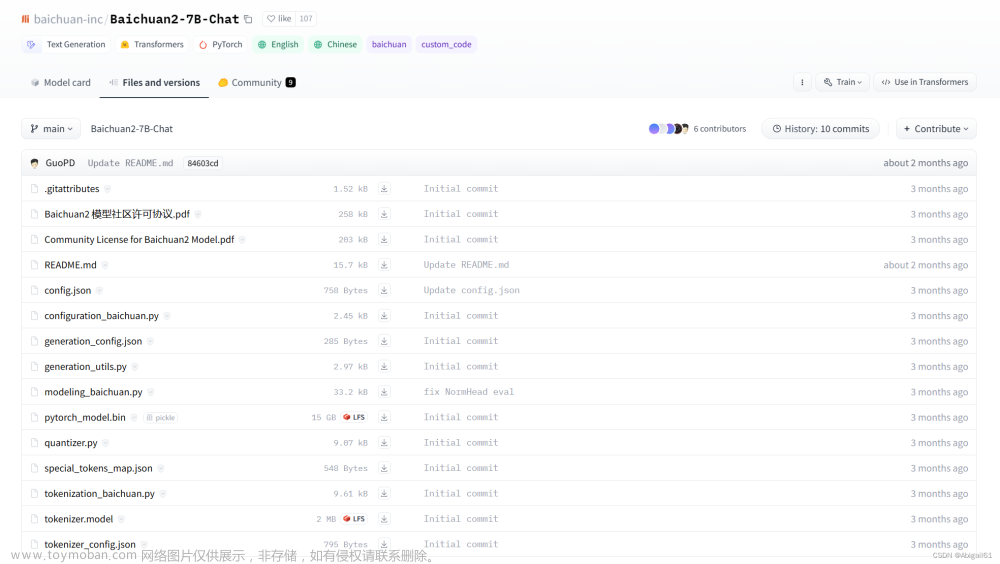

搜索下载

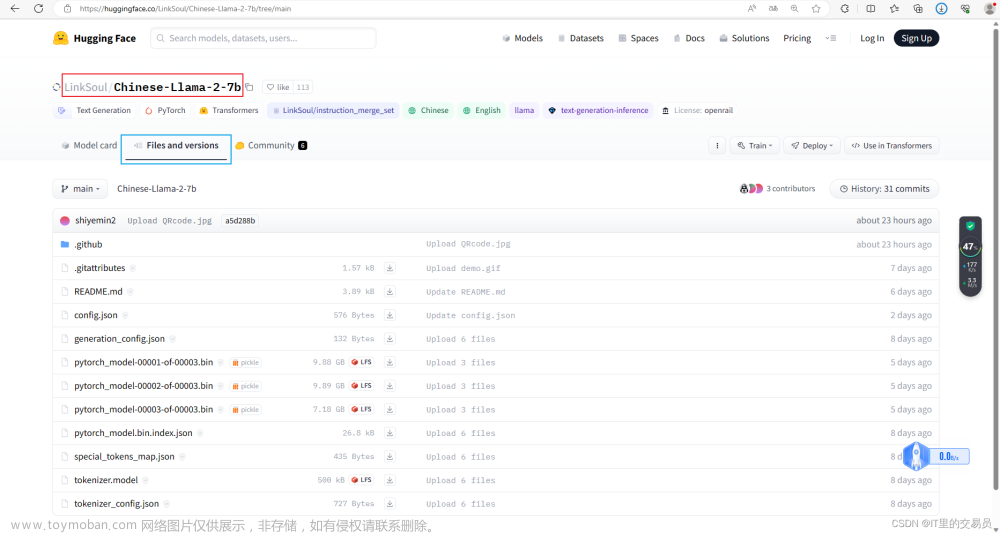

你也可以通过搜索,下载 需要的模型,比如

https://hf-mirror.com/NousResearch/Llama-2-13b-hf

gated model

如果已授权,需要在 huggingface 登陆后,拿到 token,然后用命令行从 hf-mirror 下载文章来源:https://www.toymoban.com/news/detail-794787.html

HF 获取token:https://huggingface.co/settings/tokens文章来源地址https://www.toymoban.com/news/detail-794787.html

到了这里,关于hf-mirror 使用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!