一、单机本地部署

1)官网地址:http://spark.apache.org/

2)文档查看地址:https://spark.apache.org/docs/3.1.3/

3)下载地址:

https://spark.apache.org/downloads.html

https://archive.apache.org/dist/spark/

- 上传文件、解压缩、修改文件名

- 启动Spark

- spark-shell使用

- 入门案例:

注意:sc是SparkCore程序的入口;spark是SparkSQL程序入口;master = local[*]表示本地模式运行。

说明:本地模式下,默认的调度器为FIFO。

二、Standalone模式

Standalone模式是Spark自带的资源调度引擎,构建一个由Master + Worker构成的Spark集群,Spark运行在集群中。

这个要和Hadoop中的Standalone区别开来。这里的Standalone是指只用Spark来搭建一个集群,不需要借助Hadoop的Yarn和Mesos等其他框架。

- 集群规划

- 解压缩、修改文件名

- 进入Spark的配置目录/opt/module/spark-standalone/conf,修改slave文件,添加work节点,分发文件:

4. 启动spark集群

4. 启动spark集群

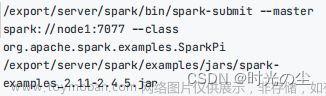

5. 测试

三、yarn模式

Spark客户端直接连接Yarn,不需要额外构建Spark集群。文章来源:https://www.toymoban.com/news/detail-795011.html

- 上传文件、解压缩、修改文件名

- 修改hadoop配置文件/opt/module/hadoop-3.1.3/etc/hadoop/yarn-site.xml,添加下面内容,并分发文件

注意:生产环境视情况而定

3. 修改/opt/module/spark-yarn/conf/spark-env.sh,添加YARN_CONF_DIR配置,保证后续运行任务的路径都变成集群路径

4. 启动HDFS以及YARN集群

先启动zk,启动yarn,启动hdfs

5. 测试 文章来源地址https://www.toymoban.com/news/detail-795011.html

文章来源地址https://www.toymoban.com/news/detail-795011.html

到了这里,关于物理机本地和集群部署Spark的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!