缓解大语言模型(LLM)幻觉的可行方法探究

转载请标明出处,🈲抄袭

摘要:2022年11月OpenAI推出能够进行多场景对话的大语言模型ChatGPT,ChatGPT凭借大规模的训练参数、海量的训练数据及强化学习人类反馈在语义理解、语言生成、机器翻译、知识科普、程序编辑等多个方面获得了巨大成功,引发了新的技术浪潮。但由于模型训练数据缺乏时效性、领域知识不足,以及训练架构存在缺陷、复杂推理能力不足等问题导致大语言模型回复生成存在“幻觉”,经常产生事实不一致的回复或进行事实捏造。上述问题致使大语言模型在对于准确性要求较高的垂直领域应用困难,如农业、医疗等。随着对大规模语言模型的深入研究和探讨,如何缓解大语言模型“幻觉”问题逐渐成为众多研究者的热议课题。从大语言模型幻觉产生原因出发,目前缓解其生成“幻觉”、提高回复准确性的可行方法主要有高质量数据集构建、思维链推理、检索增强、知识约束、模型编辑、解码优化等。本文首先概述了大语言模型的训练过程、“幻觉”产生原因,进而对现有的缓解大语言模型幻觉的可行方法进行总结和分析,最后提出了自己对缓解大语言模型幻觉可行方法的思考。

关键词:大语言模型幻觉;思维链;检索增强;知识约束

1.引言

1.1 ChatGPT训练架构及训练过程概述

ChatGPT[1]为基于GPT(Generative Pre-trained Transformer,GPT)[2]架构的的通用型对话语言模型,GPT是一个基于Transformer[3]解码器结构的深度学习模型,由多个相同的Transformer块组成,其中每个Transformer块包括多头自注意力层和前馈神经网络层。通过自注意力机制,模型能够在生成每个单词时关注输入文本的不同部分,这有助于捕捉长距离依赖关系。同时每个Transformer块之间都有残差连接和层归一化,用于保持信息流的顺畅和避免梯度消失。GPT的提出动机为利用自然语言大量未标记的文本语料及少量的任务标注数据训练一个在特定任务表现良好的语言模型,因此GPT主要包括在大规模语料下的无监督预训练和基于下游任务标注数据的有监督微调两部分。在微调期间GPT能够利用任务感知的输入转换实现有效迁移,只需对模型体系结构进行少量更改就可实现快速任务自适应。

ChatGPT与GPT1、GPT2、GPT3的本质区别在于在有监督微调过程中使用了强化学习人类反馈(Reinforment Learning from Human Feedback,RLHF)[4],如图1所示。具体地,ChatGPT通过人工标注对回复进行评分,利用评分结果训练奖励模型(Reward Model),并基于奖励模型使用强化学习算法PPO(Proximal Policy Optimization,PPO)[5]微调模型,使其回复生成与人类对其,以此提高回复的帮助性、忠实性,降低其有害性。

图1 InstructGPT有监督微调过程

ChatGPT的成功引发了自然语言处理领域新的技术浪潮,但其模型参数、训练数据规模较大、代码架构不开源,复现困难,因而许多研究者基于Transformer架构及上述微调过程开发了较小规模的大语言模型(Large Language Model,LLM),如Bloomz[6]、LLaMa[7]、BaiChuan[8]、ChatGLM[9]等。

1.2 ChatGPT“幻觉”产生原因

ChatGPT虽然在语义理解、语言生成方面展现了惊人的能力,但仍存在一本正经胡说八道的情况,即“幻觉”。图2展示了大语言模型“幻觉”的示例,用户询问ChatGPT的训练架构及训练过程,ChatGPT在回复过程中提出其使用Transformer解码器结构(实际为Transformer解码器结构)。

图2 大语言模型“幻觉”示例

Huang等[10]根据大语言模型的回复场景将幻觉分类“事实性幻觉”与“忠实性幻觉”两类。前者指模型生成的内容与可验证的现实世界事实不一致,具体可以分为事实不一致(与现实世界信息相矛盾)和事实捏造(压根没有,无法根据现实信息验证)。后者指模型生成的内容与用户的指令或上下文不一致,包括指令不一致(输出偏离用户指令)、上下文不一致(输出与上下文信息不符)、逻辑不一致三类(推理步骤以及与最终答案之间的不一致)。

大语言模型之所以存在“幻觉”问题,与其训练过程有很大关系。Huang等[10]将其归结为三类:

(1)训练数据。大语言模型的训练依赖海量数据,但数据中很容易包含错误信息和偏见,且数据往往存在滞后性,导致部分大语言模型回复偏差、时效性不强。同时大语言模型本身存在知识边界,即对事实性知识利用率低下,其在训练过程中可能会过度依赖训练数据中的一些模式,如位置接近性、共现统计数据和相关文档计数,从而导致幻觉。

(2)架构及策略缺陷、信念错位。语言生成模型会基于之前的token对下一个token进行预测,这种单向建模不仅阻碍了模型捕获复杂的上下文关系的能力还可能造成级联错误,同时自注意力模块存随着token长度增加,不同位置的注意力被稀释。此外,ChatGPT利用RLHF进行微调,在输出符合人类偏好回复的同时可能会牺牲信息的真实性,如图3所示。

(3)推理。从笔者角度来看大语言模型的推理缺陷包括一部分,一部分是不完美的编码策略,大语言模型在预测下一个token时一般采用贪心策略(即输出概率值最大的token),使模型表达能力受限;另一部分是大语言模型缺乏复杂推理的能力,在数值分析、多步推理(如医疗领域的对话诊断)等方面缺少连贯性、合理性。

图3 由于“迎合”人类造成的幻觉

从大语言模型“幻觉”产生的各个原因出发,不同研究者展开了相应的工作以提高LLM回复生成的精读和准确性,加快其在各个领域的落地应用,本文将对部分缓解LLM“幻觉”的工作进行介绍和分析。

2.构建高质量对话数据集

专业的、高质量、时效性的训练数据集能够在一定程度上提高LLM在不同领域的表现,具体表现为:

(1)更好的泛化能力。使用高质量的训练数据可以使LLM学到更准确、更广泛的语言模式,从而提高其在各种任务上的泛化能力。

(2)更准确的语义理解。专业的数据集通常包含更多领域专业性的语言,使模型更好地理解特定领域的语义。这对于特定领域的任务(例如医学、法律等)非常重要,如香港中文大学利用2600万条医疗领域对话数据集微调BaiChuan,提出医疗健康问答LLM,在医疗问题表现上超过ChatGPT[11]。

(3)提高模型对多样性的理解。时效性的数据集有助于模型跟踪社会和技术变化,从而更好地理解和处理新的语言表达方式、新的词汇和短期趋势。

(4)减少偏见。使用高质量数据集可以减少模型学到的偏见,因为这样的数据集更倾向于提供更全面和平衡的信息。这对于构建公平和可靠的模型非常重要。

(5)更好的上下文理解。专业数据集通常包含更多上下文信息,有助于模型更好地理解和生成连贯的语言。

图4 HuatuoGPT

高质量的训练数据集一般需要领域专家标注,成本高昂。因此为了降低成本的同时提高模型能力,West等[12],Li等[13]分别使用符号知识蒸馏(Symbolic Knowledge Distill)将大语言模型的能力迁移到开源的、可微调的小规模LLM上,即通过大规模LLM利用提示工程(Prompt Learning)构造数据集,并基于该数据集微调小规模LLM。

图5 大语言模型知识蒸馏

除此之外,很多学者认为ChatGPT之所以能获得如此惊人的表现力很大原因归根于RLHF的使用,但由于硬件资源、人力资源的限制,很难在短时间内实现模型训练,因而Yuan等[14]提出了RRHF(Rank Responses to align Human Feedback),利用专家或者性能优秀的大语言模型(如ChatGPT)对模型生成的回复进行评估,并基于Rank Loss实现模型参数更新,如图6所示。相似的,Lee等[15]提出RLAIF(Reinforment Learning from Artificial Intelligence Feedback),通过AI模型监督其他AI模型,即在SFT阶段,从初始模型中采样,然后生成自我批评和修正,并根据修正后的反应微调原始模型。在RL阶段,从微调模型中采样,使用一个模型来评估生成的样本,并从这个AI偏好数据集训练一个偏好模型,如图7所示。

图6 RRHF

图7 RLAIF

分析与思考:如果说之前的人工智能是“有多少人工就有多少智能”,那现在的人工智能就是“有多少数据就有多少智能”。虽然高质量的、专业的数据标注能够使LLM从一个通用的语言模型转变为专业领域对话模型,但由于模型架构、编码策略以及对知识的运用等缺陷,致使其仍然存在幻觉问题。此外,符号知识蒸馏、RRHF、RLAIF虽然降低了模型训练成本,但也伴随着一个致命的问题——训练得到的模型以ChatGPT为上限且很难超越ChatGPT。

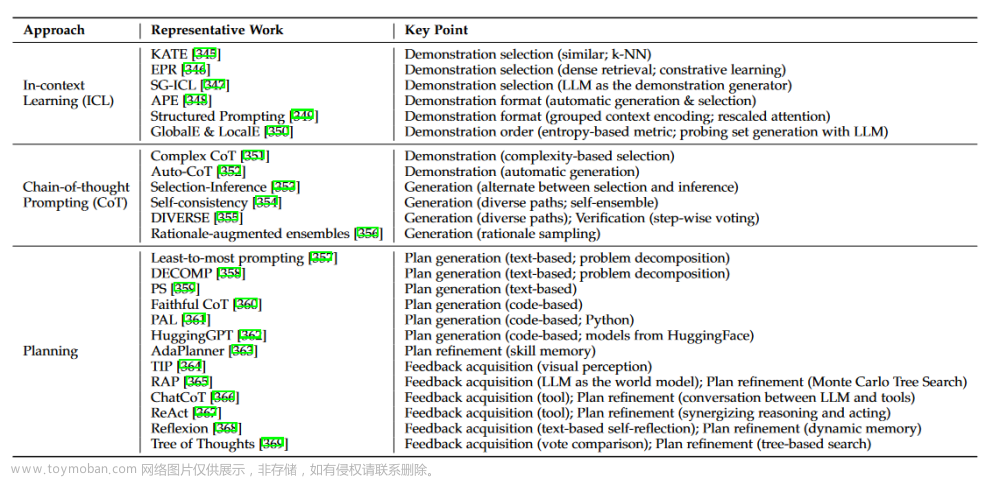

3.利用思维链提高大语言模型复杂推理能力

基于思维链(Chain of Thought,COT)的推理被视为大语言模型涌现能力的重要标志[16],其本质是将复杂问题分解为小问题,可以通过提供少样本[17]或零样本[18]思维链示例来鼓励模型执行推理,激励模型“Think Step by Step”,给出从问题到答案的一步步思考步骤,如图8所示。思维链通过显示给出问题的推理过程能够清晰明了的验证答案的正确性并在答案出现错误时进行纠错,而且利用“Think Step by Step”不仅可以激发LLM对于其参数中隐含知识的应用,而且能够促使LLM将复杂的问题分解为待解决的小问题,并使其在一步步解决小问题的过程中完成复杂问题的总体推理。

COT通过提示工程可以使模型给出问题解决步骤,更新了直接由问题答案的生成范式,能在一定程度上约束和检测LLM的生成幻觉。

图8 Few-Shot COT & Zero-Shot COT

COT在复杂推理任务上表现的优越性能吸引了一大批研究者,目前思维链的发展主要经过了COT、Self-Consistency COT[19]、TOT(Tree of Thought)[20]、GOT(Graph of Thought)[21]。COT为简单的<问题,推理步骤及回复>的链式推理结构;Self-Consistency COT为多条<问题,推理步骤及回复>的链式推理结构并通过最终的投票机制选择最合理的推理步骤;TOT为树状推理结构,其模拟了人类认知的规划和决策模式(一种快速、自动、无意识的模式和一种缓慢、深思熟虑的意识模式;第二种可以探索更多的选择,且能对当前状态进行评估,同时主动展望未来/回溯以得到更加全局的决策,TOT为后者),ToT积极地维护一个思想树,其中每个思想节点都是一个连贯的语言序列,作为解决问题的中间步骤,通过对思维树的遍历寻找最终的解决方案;GOT为图形推理结构,允许对问题进行分解和合并。无论是链式、树状还是图形推理结构均能够通过对问题的规划和决策找到合理的解决方案,并对不合理的方案进行排除,因而能够提升回复的准确性、减少幻觉。

图9 COT系列

图10 MindMap

分析与思考:大模型幻觉的生成很大程度上来源于对内在知识理解和运用的不足,而COT恰恰可以将问题分解为规模较小的子问题,通过一步步解决子问题提高LLM对知识的理解和运用(需要注意的是COT仅仅通过Prompt激发模型内在潜能,并没有引入新的数据或对模型进行微调)。但上述COT仍停留在数值任务规划和决策方面,难以直接迁移到现实应用中,且在解决问题过程中缺乏对中间过程的“自解释”,若能过在回复过程中给出每个步骤的解释将大大提升LLM应用的置信度,如在对话问诊过程中给出每一步询问症状的原因以及最终诊断结果的原因。虽然有上述问题,但COT的规划和决策给LLM解决现实问题提供了一条可行的现时途径,目前已有初步研究,如MindMap[22]。

4.基于检索增强的大语言模型

检索增强(Retrieval-Augmented Generation,RAG)[23]是一种结合生成模型和检索模型的方法,在这种方法中,生成模型与一个检索模型协同工作,检索模型负责从大量的候选文本中选择相关信息,而生成模型则负责生成输出。因而基于检索增强的大语言模型包括两个阶段:检索阶段及生成阶段。检索阶段使用检索模型从候选文本库中检索与问题相关的信息。可以基于文档相似度、关键词匹配等方法选择与任务相关的文本片段。生成阶段将检索到的证据与生成模型结合,生成最终的输出。

检索增强在缓解大模型幻觉任务中发挥着至关重要的作用。通过检索增强不仅能够提高信息准确性、解决生成模型偏向性问题,还能提高多模态任务性能、更好地处理稀缺任务,进而提高系统的可控性,具体如下:

(1)提高信息准确性。通过引入检索模型,生成模型可以更容易地访问和利用大量的外部信息,这种信息不仅包含事实性证据还包含时效性信息,从而提高生成的文本的信息准确性和时效性。

(2)解决生成模型偏向性问题。生成模型在生成文本时可能受到预训练数据的偏向性影响,而通过检索阶段引入的外部信息可以有助于缓解这种偏向性问题。

(3)提高多模态任务性能。对于一些需要同时处理文本和其他模态数据(如图像、知识库等)的任务,检索增强可以使生成模型更好地结合多模态信息。

(4)更好地处理稀缺任务。在一些特定领域或任务中,训练数据可能相对较少。检索增强可以帮助模型利用外部信息,弥补数据不足的问题。

检索增强允许在生成阶段引入外部信息,使得系统更容易受控制,可以满足特定的任务要求或限制,能够在各种自然语言处理任务中提高模型的性能和鲁棒性。基于检索增强的大语言模型可以从不同角度进行分类,根据检索的内容来源可以将检索增强的大语言模型分为基于知识库的检索增强与基于网页的检索增强(如WebCPM[24]、WebGLM[25]),但其本质都是通过对知识的检索,得到进行回复生成的相关证据;根据检索的形式可以将检索增强的大语言模型分为一次检索、迭代检索和事后检索[10]。

图11 检索增强不同形式

如图11所示,一次检索为根据问题去知识库中检索一次证据后给出生成回复;迭代检索为进行多步检索后给出最终回复,适用于多步问答或将问题分解,每次对一个问题进行检索,如IRCOT[26];事后检索为LLM生成回复后对知识库进行检索,根据检索证据对回复进行验证以作出修改或输出。

图12 WebGLM & WebCPM

一般来说,传统的RAG遵循共同的范式:query+context→LLM,query表示用户的输入,context表示检索获得的补充信息,两者共同输入到LLM中实现回复生成,该范式可认为是一种检索前置的被动的增强方式。上述传统的检索增强虽然能够为LLM提供回复生成的证据,提高回复的准确性和有效性,但是传统的基于检索增强的LLM并没有判断当前问题是否需要检索(如用户提问“你可以做一首春天的诗吗?”,这种种情况下是不需要检索的)且没有对于检索到的结果进行筛选,检索到的证据可能存在一定的错误或者与当前问题相关性不强。因而Asai等[27]推动了RAG向Self-RAG的转变,Self-RAG与RAG相比会对当前情况是否需要检索进行判断,并对检索到的证据进行评估,选择最合理的检索信息辅助回复生成,如图13所示。Self-RAG的主要步骤如下:

(1)判断是否需要额外检索事实性信息(retrieve on demand),仅当有需要时才召回;

(2)平行处理每个片段:生产prompt+一个片段的生成结果;

(3)使用反思字段,检查输出是否相关,选择最符合需要的片段;

(4)重复检索;

(5)生成结果会引用相关片段,以及输出结果是否符合该片段,便于查证事实。

图13 Self-RAG

Self-RAG的关键在于按需检索和自反思,其与RAG的不同在于前者相较于后者更加主动和智能。除此之外,在RAG的基础上,目前还有一些工作会对LLM的回复进行引文标注[28],即对检索到的证据在生成的回复中进行标明,如图14所示。引文标注一方面可以提高证据检索的利用,避免无用的证据检索,另一方面也提升了回复生成的置信度,可以在一定程度上通过检索证据约束缓解LLM的“幻觉”。

图14 引文标注

分析与思考:无论是RAG、Self-RAG还是引文标注无一不是利用外部知识增加对LLM回复生成的证据支持,能够通过prompt的方式增加回复中的事实性证据,缓解回复中的“幻觉”。但在利用检索增强的过程中也存在一定的问题:(1)计算成本高,在进行检索时需要讲证据与问题进行相似度计算,在知识库庞杂时计算过程是十分昂贵的,因而对检索的必要性进行判断及优化检索算法是十分必要的;(2)信息准确性,基于RAG的LLM回复生成的准确性十分依赖证据的有效性,如果证据质量低下将使生成效果大打折扣,同时对于检索到的结果不能全部利用,因而如何检索有力证据提高证据利用是十分关键的。

5.基于知识约束的大语言模型

无论是构建高质量的数据集,还是COT提升复杂推理能力,以及检索增强无一不是利用可行技术提高LLM对于其内在隐含知识或外部显示知识的利用。知识对于不同领域而言都是应用的基础,使用知识约束可以提高模型的可控性和准确性,增加模型的可解释性和领域适应性。本文小节2-4虽然都涉及了知识的应用,但大多是以“知识外挂”的形式实现的,并没有将知识注入到模型的训练过程中,本节将对使用知识控制LLM训练过程的部分方法进行介绍。

图15 利用Focus Learning增加知识权重

在自然语言处理任务中使用广泛的知识类型包括两大类:文本知识和知识图谱(Knowledge Graph,KG)。图15展示了一个基于知识的对话系统的模型架构,与其他使用知识约束保持回复生成和知识之间的协调一致方法不同,Deng等[29]提出使用Focus Learning(FocusL),通过直接缩放相应的目标损失来调整每个token对优化方向的贡献。其关注重点主要有两个:(1)如何定位所需的学习重点,即如何定位与知识相关的tokens;(2)给定所需的学习焦点,如何纠正原来的学习焦点,即定位到与知识相关的token位置后,如何增加其对模型学习训练的影响。针对以上挑战,Deng等首先提出了一种定位方法,利用知识和每个响应token之间的相关性分布来定位knowledge-aware tokens。而后设计了一个relevance-to-weight transformation修改LLM生成的token概率,以提供动态的token级权重,用于调整交叉熵损失。最后,利用加权损失来鼓励该模型特别关注知识的利用。

图16 基于知识图谱约束的回复生成

与基于文本知识的约束不同,使用知识图谱约束的回复生成由于结构化知识图谱与文本回复的知识结构不同,如何进行知识融合一直是该方向的重点。Agarwal等[30]通过将检索的知识图谱路径转化为文本实现知识融合,虽然在一定程度上可以提升模型的表现,但在融合过程中损失了KG蕴含的结构信息。此外Hu等[31]、GreaseLM[32]通过图神经网络将KG进行嵌入,并将嵌入向量与文本向量进行拼接实现知识融合。而且Hu等在选择节点和路径时采用重启随机游走(Random Walk with Restart,RWR)计算节点对于问题中核心词的权重,相当于利用KG的拓扑结构信息对KG中不重要的信息进行了筛选,更关注KG中与当前问题相关的表示。除此之外也有一些较为传统的KG知识增强的研究,如KagNet[33]、QA-GNN[34],前者会计算KG节点与问题的相似度,后者会对KG中的路径进行打分以寻找对于问题关键的信息。

无论是使用文本知识还是知识图谱实现对LLM的知识增强,其本质都是利用知识约束LLM的输出,减少幻觉和危害,提高回复的质量和有效性,是一个十分有益且前景光明的研究。

图17 KagNet & QA-GNN & GreaseLM

分析与思考:笔者认为知识是学习和思考的基础,因而为缓解LLM的“幻觉”引入知识是十分必要且不可或缺的,但就知识的利用角度而言,目前所采用的方法还较为基础,尤其是对于知识图谱的利用仍有很大的空白。知识图谱由于其结构化,天然具有一定的推理性,而且节点之间的结构关系也在一定程度上定义了节点的“远近亲疏”,可以同FocusL一样用于生成tokens的权重修改。

6.总结与展望

大语言模型一经推出便凭借其惊人的语义理解和语言生成能力收获了大批用户,经过近一年多的发展更是展现出了蓬勃的生命力,然而由于训练数据的“过时”、训练架构和解码策略的缺陷、推理能力的欠缺,大语言模型在回复生成中仍存在“幻觉”。为了缓解大语言模型的幻觉问题,推进其在不同领域的落地应用,众多学者从“幻觉”产生原因出发,站在不同角度提出了缓解大语言模型“幻觉”的可行之法,包括但不限于构建高质量数据集、通过思维链提示激发大语言模型的隐含知识、构建知识库进行检索增强、显式利用知识进行生成约束、知识编辑、解码策略优化等。本文主要对上述前四个方面进行了概述和分析,从方法本质角度而言,以上方法无一不是利用知识增加对模型生成的约束,但从知识利用角度来看,当前的方法还有很大改进空间。如第5节提到的知识约束其实大多都是通过知识融合实现的,并没有真正利用知识约束模型解码、token概率选择,此外结构化的知识利用明显不足,如基于知识图谱的推理等。“不积跬步无以至千里”,希望未来更多研究者从不同角度汲取经验,提出更多可行的解决方案。文章来源:https://www.toymoban.com/news/detail-795249.html

参考文献

[1]Ouyang L, Wu J, Jiang X, et al. Training language models to follow instructions with human feedback[J]. Advances in Neural Information Processing Systems, 2022, 35: 27730-27744.

[2]Radford A, Wu J, Child R, et al. Language models are unsupervised multitask learners[J]. OpenAI blog, 2019, 1(8): 9.

[3]Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[J]. Advances in neural information processing systems, 2017, 30.

[4]Ouyang L, Wu J, Jiang X, et al. Training language models to follow instructions with human feedback[J]. Advances in Neural Information Processing Systems, 2022, 35: 27730-27744.

[5]Schulman J, Wolski F, Dhariwal P, et al. Proximal policy optimization algorithms[J]. arXiv preprint arXiv:1707.06347, 2017.

[6]Muennighoff N, Wang T, Sutawika L, et al. Crosslingual generalization through multitask finetuning[J]. arXiv preprint arXiv:2211.01786, 2022.

[7]Touvron H, Lavril T, Izacard G, et al. Llama: Open and efficient foundation language models[J]. arXiv preprint arXiv:2302.13971, 2023.

[8]Yang A, Xiao B, Wang B, et al. Baichuan 2: Open large-scale language models[J]. arXiv preprint arXiv:2309.10305, 2023.

[9]Du Z, Qian Y, Liu X, et al. Glm: General language model pretraining with autoregressive blank infilling[J]. arXiv preprint arXiv:2103.10360, 2021.

[10]Huang L, Yu W, Ma W, et al. A survey on hallucination in large language models: Principles, taxonomy, challenges, and open questions[J]. arXiv preprint arXiv:2311.05232, 2023.

[11]Zhang H, Chen J, Jiang F, et al. HuatuoGPT, towards Taming Language Model to Be a Doctor[J]. arXiv preprint arXiv:2305.15075, 2023.

[12]West P, Bhagavatula C, Hessel J, et al. Symbolic knowledge distillation: from general language models to commonsense models[J]. arXiv preprint arXiv:2110.07178, 2021.

[13]Li L H, Hessel J, Yu Y, et al. Symbolic Chain-of-Thought Distillation: Small Models Can Also" Think" Step-by-Step[J]. arXiv preprint arXiv:2306.14050, 2023.

[14]Yuan Z, Yuan H, Tan C, et al. Rrhf: Rank responses to align language models with human feedback without tears[J]. arXiv preprint arXiv:2304.05302, 2023.

[15]Lee H, Phatale S, Mansoor H, et al. Rlaif: Scaling reinforcement learning from human feedback with ai feedback[J]. arXiv preprint arXiv:2309.00267, 2023.

[16]Huang J, Gu S S, Hou L, et al. Large language models can self-improve[J]. arXiv preprint arXiv:2210.11610, 2022.

[17]Wei J, Wang X, Schuurmans D, et al. Chain-of-thought prompting elicits reasoning in large language models[J]. Advances in Neural Information Processing Systems, 2022, 35: 24824-24837.

[18]Kojima T, Gu S S, Reid M, et al. Large language models are zero-shot reasoners[J]. Advances in neural information processing systems, 2022, 35: 22199-22213.

[19]Wang X, Wei J, Schuurmans D, et al. Self-consistency improves chain of thought reasoning in language models[J]. arXiv preprint arXiv:2203.11171, 2022.

[20]Yao S, Yu D, Zhao J, et al. Tree of thoughts: Deliberate problem solving with large language models[J]. arXiv preprint arXiv:2305.10601, 2023.

[21]Besta M, Blach N, Kubicek A, et al. Graph of thoughts: Solving elaborate problems with large language models[J]. arXiv preprint arXiv:2308.09687, 2023.

[22]Wen Y, Wang Z, Sun J. Mindmap: Knowledge graph prompting sparks graph of thoughts in large language models[J]. arXiv preprint arXiv:2308.09729, 2023.

[23]Lewis P, Perez E, Piktus A, et al. Retrieval-augmented generation for knowledge-intensive nlp tasks[J]. Advances in Neural Information Processing Systems, 2020, 33: 9459-9474.

[24]Qin Y, Cai Z, Jin D, et al. WebCPM: Interactive Web Search for Chinese Long-form Question Answering[J]. arXiv preprint arXiv:2305.06849, 2023.

[25]Liu X, Lai H, Yu H, et al. WebGLM: Towards An Efficient Web-Enhanced Question Answering System with Human Preferences[J]. arXiv preprint arXiv:2306.07906, 2023.

[26]Trivedi H, Balasubramanian N, Khot T, et al. Interleaving retrieval with chain-of-thought reasoning for knowledge-intensive multi-step questions[J]. arXiv preprint arXiv:2212.10509, 2022.

[27]Asai A, Wu Z, Wang Y, et al. Self-RAG: Learning to Retrieve, Generate, and Critique through Self-Reflection[J]. arXiv preprint arXiv:2310.11511, 2023.

[28]Gao T, Yen H, Yu J, et al. Enabling Large Language Models to Generate Text with Citations[J]. arXiv preprint arXiv:2305.14627, 2023.

[29]Deng Y, Zhang X, Huang H Y, et al. Towards faithful dialogues via focus learning[C]//Proceedings of the 61st Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). 2023: 4554-4566.

[30]Agarwal O, Ge H, Shakeri S, et al. Knowledge graph based synthetic corpus generation for knowledge-enhanced language model pre-training[J]. arXiv preprint arXiv:2010.12688, 2020.

[31]Hu Z, Xu Y, Yu W, et al. Empowering language models with knowledge graph reasoning for open-domain question answering[C]//Proceedings of the 2022 Conference on Empirical Methods in Natural Language Processing. 2022: 9562-9581.

[32]Lin B Y, Chen X, Chen J, et al. Kagnet: Knowledge-aware graph networks for commonsense reasoning[J]. arXiv preprint arXiv:1909.02151, 2019.

[33]Yasunaga M, Ren H, Bosselut A, et al. QA-GNN: Reasoning with language models and knowledge graphs for question answering[J]. arXiv preprint arXiv:2104.06378, 2021.

[34]Zhang X, Bosselut A, Yasunaga M, et al. Greaselm: Graph reasoning enhanced language models for question answering[J]. arXiv preprint arXiv:2201.08860, 2022.文章来源地址https://www.toymoban.com/news/detail-795249.html

到了这里,关于缓解大语言模型(LLM)幻觉的可行方法探究(课程综述)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!