摘要

图像-文本检索旨在弥合模态鸿沟,根据语义相似性检索跨模态内容。之前的工作通常侧重于成对关系(即一个数据样本是否与另一个样本匹配),但忽略了高阶邻接关系(即多个数据样本之间的匹配结构)。重新排序是一种流行的后处理方法,它揭示了在单模态检索任务中捕捉邻接关系的优越性。然而,将现有的重新排序算法直接扩展到图像文本检索中效果并不理想。本文从泛化性、灵活性、稀疏性和不对称性四个角度分析了原因,并提出了一种新颖的基于可学习支柱的重新排序范式。具体来说,我们首先选择排名靠前的模内和模间邻居作为支柱,然后利用数据样本与支柱之间的邻居关系重建数据样本。这样,每个样本只需利用相似性就能映射到多模态支柱空间,从而确保泛化。之后,我们设计了一个邻域感知图推理模块,以灵活利用这些关系,挖掘邻域内的稀疏正项。我们还提出了一种结构对齐约束,以促进跨模态协作并对齐非对称模态。在各种基础骨架之上,我们在两个基准数据集(即 Flickr30K 和 MS-COCO)上进行了广泛的实验,证明了我们提出的重新排序范式的有效性、优越性、通用性和可移植性。

简介

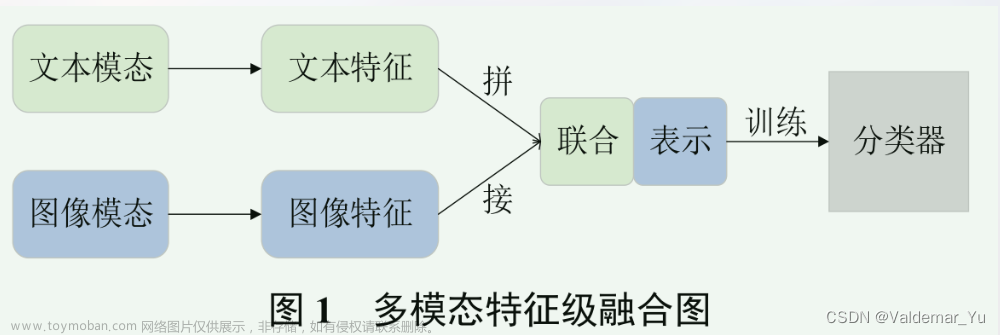

双流和单流框架都只考虑图像和文本之间的配对匹配关系,如图1(a)所示。它们完全忽略了图1(b)中所示的多个图像和文本之间的高阶邻居关系,因此检索性能不佳。作为探索邻居关系的后处理技术,重新排序在传统的单模态检索任务中显示出显著的有效性。

图 1:(a) 成对关系、(b) 邻接关系和( c) 支柱空间结构的图示。与配对关系相比,高阶邻接关系是一种匹配结构,包括查询-邻接(如 q↔ 𝑥)和邻接-邻接(如 𝑧 ↔ 𝑤)关系。在一个邻域中,排名靠前的邻居被选为支柱,以构建支柱空间来表示数据样本。数字表示由基本骨干计算出的相似度。

现有的重新排序方法可分为三大类:查询扩展(QE)[8,35]、扩散[16]和基于邻居的方法[48]。然而,由于以下挑战,它们不适合跨模态ITR:泛化性、灵活性、稀疏性和不对称性。

为了应对上述挑战,我们提出了一种可学习的基于支柱的重排序(LeaPRR)框架。

-

首先,为了很好地适应单塔和双塔框架,我们放弃了任何中间内容特征,只将任何框架都能计算出的最终相似度作为重排模型的输入。为了使实体(即查询和条目)的表示更具信息性,我们将排名靠前的多模态相邻实体定义为支柱,然后根据支柱与这些实体之间的相似性重建实体,如图 1© 所示。这样,每个实体都可以映射到支柱空间中。与传统的独立于模态的内容空间不同,支柱空间是用多模态支柱来构建的,以缓解不对称问题。

-

此外,针对灵活性和稀疏性的挑战,我们提出了基于以给定查询为中心的邻域的邻域感知图推理模块,以灵活探索复杂的邻域关系,包括查询-邻域和邻域-邻域关系。

-

为了进一步处理正向项目的高稀疏性问题,我们施加了局部和全局排序约束,以加强精炼支柱特征的判别能力,它可以自适应地吸收有价值的信息,抵御来自邻居的噪音。

-

最后,我们提出了一种结构对齐约束,将上下文结构从一种模式转换到另一种模式,进一步解决了不对称问题。

总之,我们的主要贡献如下:

- 我们讨论了 ITR 任务中现有重新排序方法的局限性,并提出了四个挑战,即泛化、灵活性、稀疏性和不对称性。

- 为了应对这四个挑战,我们重新定义了多模态领域的重新排序,并首次提出了一种可学习的基于支柱的重新排序范式,这种范式即插即用,适用于所有现有的 ITR 主干网。

- 在 Flickr30K [42] 和 MS-COCO [20] 两个数据集上基于不同基础 ITR主干网的广泛实验验证了我们模型的有效性和优越性。

相关工作

大多数现有研究都侧重于在联合嵌入空间中表示数据样本或深入挖掘细粒度的跨模态排列,但却忽略了高效实用的后处理程序,即重新排序(re-ranking)。

方法

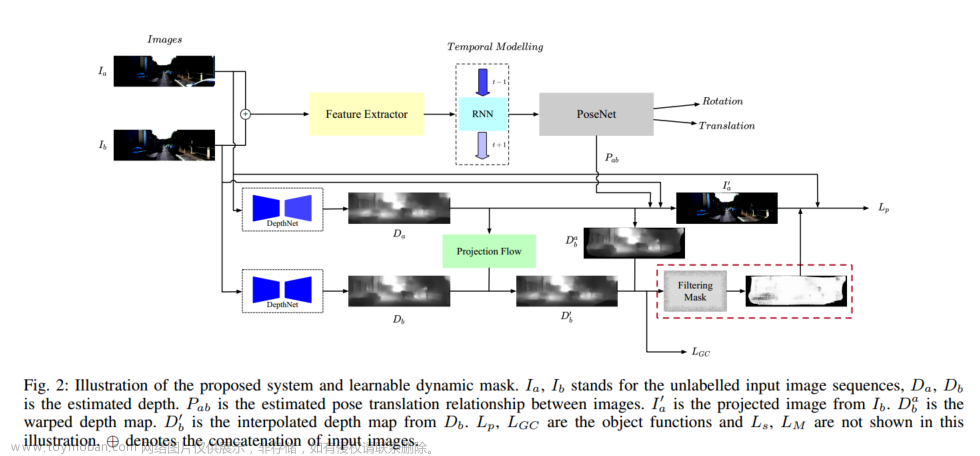

我们提出的 LeaPRR 的整体框架如图 3 所示。下面,我们将首先介绍跨模态 ITR 重排序的问题定义,然后详细阐述基于支柱的表示法和邻居感知图推理。最后,我们将介绍支柱空间中的学习策略。

问题定义

给定一个查询(图像或文本)和另一种模式的数据库,即 D = {𝑑1, . , 𝐶𝑑 },我们首先通过一个基础 ITR 主干网 𝜙 计算查询与 D 中每个项 𝑑𝑖 之间的初始相似度 𝜙 (stood,𝑑𝑖) 。它可以通过单流或双流网络实现。前者[19]通常将𝜙视为从两个分支中提取的嵌入之间的余弦相似度,而后者则将𝜙视为综合的模态间交互模块,如交叉注意[6, 39]。之后,我们可以通过降序排序相似度来获得初始排名列表 R(q,D)。

ITR 重新排序的目标是完善初始排序列表,使那些与查询语义匹配度高的项目在完善后的排序列表中排名靠前,反之亦然,排序列表用 R∗ (q, D)表示。在这项工作中,我们将重点放在对 R (q,D) 中排名靠前的项目进行重新排序上,因为在实际场景中,用户总是更关注排名靠前的检索结果。

我们考虑了两种检索设置: 图像到文本 (I2T),即 ∆ = 𝐼 ,D := D𝑇 ,和文本到图像 (T2I),即 ∆ := 𝑇 ,D := D𝐼 。考虑到除检索方向外的高度一致性,我们将在不失一般性的前提下阐述 I2T 设置下的方法。此外,我们将使用项目来表示给定图像(或文本)查询的所有检索文本(或图像),使用邻域来表示排名靠前的项目,使用实体来表示任何查询或项目。

图 3:提出的 LeaPRR 模型示意图(图像到文本方向)。给定图像查询和数据库后,通过基础检索器获得初始排名列表。然后选择排名靠前的多模态邻域作为支柱,构建多模态支柱空间。在这个空间中,对每个数据样本进行基于支柱的表示。然后,通过基于邻居和基于学习的亲缘关系构建图,并进行邻居感知图推理。最后,该模型通过三个约束条件学习邻接关系以重新排序。

基于支柱的表示法

对于双流 I2T 框架,我们可以轻松访问每种模式的中间特征,并利用它们来丰富查询或项目表示法,以便重新排序[13, 35]。然而,由于跨模态交互模块的存在,单塔 I2T 框架无法做到这一点。有鉴于此,使用中间表征来优化双塔和单塔框架的排序结果是不现实的。因此,我们采用跨模态相似性对图像-文本检索进行重新排序。然而,如何表示图像或文本,并仅根据相似性对它们进行比较,成为一个亟待解决的问题。

俗话说 “物以类聚”。我们可以用固有的外貌特征来描述一个人,如身高、体重、肤色、脸型、发型等。同时,我们还可以通过他与其他人的关系来描绘这个人。例如,如果两个人有共同的家庭成员,那么就有理由认为他们在外貌上相似;如果有共同的偶像和/或朋友,那么就有理由认为他们在兴趣爱好上相似。这启发我们,我们不仅可以用实体的内部内容/属性来表示实体,还可以用实体与其他实体之间的外部关系来表示实体。

虽然可以利用他人作为参照物来表示一个项目,但这并不意味着任何人都可以承担责任。举例来说,一个人不熟悉的人就不能作为参照来歧视他。因此,项目与所选参照物之间的关系不应非常稀疏。我们将在下文中详细介绍如何选择此类参照物,并利用它们作为表示项目的参照物。

多模态支柱选择:给定 I2T 检索的初始排序列表 R (𝐼, D𝑇 ) = {𝑇1, …,𝑇𝑁 },我们选取前𝐿(𝐿 < 𝑁 )文本作为上述参考文献。在我们的工作中,这些选定的参考文献被定义为支柱。为简单起见,我们将 R (𝐼, D𝑇 ) 改为 R𝐼→𝑇 ,并使用 R𝐼→𝑇 1:𝐿 = {𝑇1, …, 𝑇𝐿 } 来表示查询的模式间支柱 𝐼 。为了进一步提高表示能力,我们建议从模内数据库 D𝐼 中挖掘模内支柱。具体来说,我们应用图像编码器𝜓𝐼 提取特征,然后计算它们之间的成对相似度。之后,基于模内排序列表 R (𝐼, D𝐼 ) = {𝐼1, …, 𝐼𝑀 }, 简称 R𝐼→𝐼 ,我们收集一组查询 𝐼 的模内支柱1,如 R𝐼→𝐼 1:𝐿 = {𝐼1, …, 𝐼𝐿 }。

基于支柱的编码:在支柱的基础上,我们对查询图像 𝐼 及其顶层相邻文本 {𝑇1, … ,𝑇𝑇 } 如下: v = [⊕𝐿𝑖=1𝜙 (𝐼, 𝑇𝑖 ), ⊕𝐿 𝑗=1𝜋 (𝐼, 𝐼 𝑗 )], t𝑘 = [⊕𝐿𝑖=1𝜋 (𝑇𝑘, 𝑇𝑖 ), ⊕𝐿 𝑗=1𝜙 (𝐼 𝑗 , 𝑇𝑘 )], (1) 其中,⊕ 表示连接运算符、 v ∈ R2𝐿 和 t𝑘∈ R2𝐿 分别表示查询𝐼 及其第𝑘 个相邻𝑇𝑘 的基于支柱的表示,𝜙 可以是计算图像-文本相似性的任何基础骨干,𝜋 是模内相似性计算模型。具体来说,𝜋 (𝐼, 𝐼𝑗 ) = cos(𝜓𝐼 (𝐼 ),𝜓𝐼 (𝐼 𝑗 )), 𝜋 (𝑇𝑘,𝑇𝑖 ) = cos(𝜓𝑇 (𝑇𝑘 ),𝜓𝑇 (𝑇𝑖 )), 其中 𝜓𝐼 和 𝜓𝑇 分别是图像编码器和文本编码器。

邻居感知图推理

重新排序的关键之一是对包括查询及其邻居在内的邻居中的高阶邻居关系进行建模。在这个问题上,我们定制了一个基于图的邻居传播,以自适应地捕获查询邻居和邻居-邻居关系。在完成支柱编码之后,我们能够在支柱空间中表示查询及其邻居。在这个空间中,我们将每个项目(即查询或邻居)视为一个节点,然后根据它们的亲和性得分将它们连接起来。

从支柱空间学习

在图像和文本之间的成对监督下,我们的模型在以下三个约束下进行了优化。

全球对比度损失。我们采用对比度损失[14]来强制查询尽可能接近正面,远离负面。

局部Triplet损失。与本质上迫使所有正对相似的对比损失不同,基于铰链的三元组损失[37]关注局部相对接近性,并在一定程度上允许正之间的差异,使其不那么贪婪。在本文中,考虑顶部的负样本-𝐾邻居已经很难了,我们没有进行最难的负向挖掘,而是转向最难的正向挖掘,这使得它与对比损失互补。

相互模态对齐。到目前为止,我们已经说明了I2T子模型的机制。类似地,我们可以通过将查询和数据库分别分配为文本来导出T2I子模型𝑇和D𝐼.要集成这两个子模型,一种简单的方法是直接平均两个相似之处,就像大多数先前的基本骨架[17,21,34]所做的那样。然而,通过这种方式,两个子模型是独立训练的,不能相互促进。受相互学习[40,45]的启发,我们设计了一种相互模态对齐方案,以激励两个子模型一起教学和促进对方。以I2T为例,我们首先对查询进行跨模态正采样𝐼和每个邻居𝑇𝑖inD𝑇, 获得𝑇′=𝛿(𝐼)和𝐼′𝑖=𝛿(𝑇𝑖), 哪里𝛿(·)是采样函数。具体地说,对于给定的实体,我们首先通过成对的地面实况信息在其他模态中找到它的正匹配,然后在存在多个正匹配的情况下对一个实体进行一致采样。在ward之后,我们分别计算了以为中心的两个相似性分布𝐼和𝑇′。

实验

表 1:基于 VSE∞ 和 DIME∗ 的 Flickr30K 和 MS-COCO (5K) 数据集上,提出的 LeaPRR 与几种基准的性能比较。每个基准的最佳性能以粗体标出,次佳结果以下划线标出。提出方法的结果用灰色背景标出。

实施细节

在我们的工作中,使用64个模态内柱和64个模态间柱来构建128维的柱空间,即。,𝐿=64.I2T和T2I设置中的前32名和前8名项目分别被考虑重新排序。换句话说,𝐾=32用于I2T和𝐾=8用于T2I。此外,通过FC层映射的中间嵌入空间的维度被设置为768。(4) 设置为0.8。对于邻居传播,GCN层的数量设置为2。保证金𝛼局部三重态损耗与温度因子𝜏分别设置为0.2和1.0。此外,我们使用了动量为0.9、批大小为512的SGD优化器。我们的模型被训练了30个时期,学习率为0.01。选择验证集中rSum最高的检查点进行测试。在本文中,我们直接应用开源社区2中发布的预先训练的双塔模型CAMERA[33]的视觉和文本分支2来计算模态内相似性和收集的模态内支柱,即R𝐼→𝐼1:𝐿和R𝑇→𝑇1:𝐿。

表4:Flickr30K和MS-COCO(5K)数据集上基于五个基本ITR架构伪造评估的定量结果。与基础骨干相比,提出的LeadRR实现的性能改进以绿色标记。

为了验证LeadRR是否能在不同的基础ITR架构中表现良好,我们将其插入五个具有代表性的架构:两个单塔(SCAN和DIME)和三个双塔(VSRN*、CAMERA*和VSE∞)架构,并将其与KRNN[38]进行比较。Flickr30K和MS-COCO(5K)的结果如表4所示。在两个数据集上的卓越性能,特别是R@1性能,验证了我们的方法强大的泛化能力,以及与当前最先进的KRNN相比的优势,而不考虑基础主干。

结论和未来工作

在本文中,我们提出了在重新排序范式中对图像文本检索的高阶邻居关系进行建模。为此,我们首先深入研究了先前重新排序方法在多模态背景下的局限性,并提出了图像文本检索重新排序的四个挑战。为了解决这四个问题,我们重新制定了多模式重新排序,构建了一个具有顶级邻居的新支柱空间,并提出了一种基于学习的框架,该框架可以适应单塔和双塔框架,并灵活地探索实体之间复杂的邻居关系。综合实验证明了该方法的有效性、优越性、推广性和可移植性。文章来源:https://www.toymoban.com/news/detail-795406.html

未来,为了进一步提高重新排序性能,我们计划引入丰富的多模式外部知识来建模高阶邻居关系。此外,在所提出的重新排序范式的启发下,我们计划从更广泛的角度探索不同下游检索任务之间的可转移性。文章来源地址https://www.toymoban.com/news/detail-795406.html

到了这里,关于跨模态检索论文阅读:Learnable Pillar-based Re-ranking for Image-Text Retrieval(LeadRR)基于可学习支柱的图像文本检索重排的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读]MVX-Net——基于3D目标检测的多模态VoxelNet](https://imgs.yssmx.com/Uploads/2024/02/728981-1.png)