行话说得好,“爬虫学得好,牢饭吃到饱!”哈哈博主是因这句话入的坑,不为别的就为邀大家一起铁窗泪(bushi),本人虽小牛一只,但是喜爱捣鼓技术,有兴趣的小伙伴们可以共同探讨,也欢迎各位大佬们的指点,愿共同进步!

从Selenium自动化测试到Mysql数据库

这次计划是翻墙爬取外网某网站https://metrics.torproject.org/rs.html#details/0E300A0942899B995AE08CEF58062BCFEB51EEDF页面的内容,页面中除了正常的文本数据外,还包含了数张js加载的历史数据统计图,将爬取的文本数据直接以字符形式插入表中,图片数据需要处理为二进制后存入。素材使用的工具是Pycharm+python3.7(个人相当推荐Pycharm,不用考虑python版本于库版本是否匹配的问题,设置黑色的界面风格很有让人写代码的冲动,而且3月4号刚上线chatgpt插件),武器库呢采用的是反爬利器selenium web自动化测试,使用版本是3.141.0。从python连接数据库使用的是Pymysql1.0.2。数据库选用的是Mariadb,没找到免费Mysql,民间还是开源的Mariadb呼声更高。

Selenium自动化测试

selenium的好处在于对于一般网页的反爬虫手段有着很好的反制策略,例如常见的有请求头反爬虫,这个也是最简单的,如果不给定请求头,对方服务器就不会理你,需要设置的参数有User-Agent、Referer和Cookie。还包括有的网站会使用js接口传递数据。甚至有时你会发现自己的请求语句完全正确但是就是定位到页面元素,那就可能是使用了iframe框架,可以理解为网页嵌套。能够做到这些手段的网站不多,对于数据十分金贵的知网算的上一个,这里挖个小坑后面实战项目会有的。对于selenium还不熟悉的小伙伴,博主推荐Selenium with Python中文翻译文档https://selenium-python-zh.readthedocs.io/en/latest/

- 库文件

from selenium import webdriver

import pymysql as sql

import time

import random

- Webdriver初始化

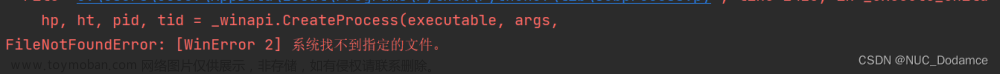

webdriver要和自己的chrome浏览器版本相对应(使用火狐浏览器也是可以的),不知道下载哪个版本来这里http://chromedriver.storage.googleapis.com/index.html

self.url="https://metrics.torproject.org/rs.html#details/0E300A0942899B995AE08CEF58062BCFEB51EEDF"

self.driver_path=r"D:\python\chromedriver.exe"

#获取数据

self.lable=[]

self.tip=[]

self.content=[]

self.image_f=[]

self.image_s=[]

self.time=[]

- 访问页面

headless赋值为True是开启无头模式测试,初次使用webdriver自动化测试的小伙伴可以去掉这行体验一下

option=webdriver.ChromeOptions()

option.headless=True

option.binary_location=r'D:\Google\Chrome\Application\chrome.exe'

self.driver = webdriver.Chrome(executable_path=self.driver_path,options=option)

self.driver.get(self.url)

time.sleep(10)#这里也可以使用self.driver.implicitly_wait(10)

implicitly_wait(10) 隐性等待的好处是在设定的时间内只要加载完毕就执行下一步,不用像time.sleep那样强行等待10秒钟

- 获取文本数据

# 获取lable

wash=self.driver.find_elements_by_tag_name('h3')

metri.wash_data(wash,0)#wash_data()调用函数对获取到的数据进行清洗

#获取tip

wash=self.driver.find_elements_by_class_name('tip')

wash.pop(0)

metri.wash_data(wash,2)

#获取content

wash=self.driver.find_elements_by_tag_name('dd')

metri.wash_data(wash,1)

metri是使用类class的名称:metri=metrics(),由于网页设计的原因有时开发人员的无规律设计可能导致我们获取的数据与期望存在偏差,小问题清洗一下就好了

- 获取折线图

对于这类难获取,获取后难以可视化的情形(如下图),博主非常推荐使用selenium中screenshoot_as_png按元素定位拍照的方法

一筹莫展的时候正好发现了screenshoot的功能,可谓是柳暗花明又一村

self.image_f.append(self.driver.find_element_by_xpath('//*[@id="bw_month"]').screenshot_as_png)

self.image_s.append(self.driver.find_element_by_xpath('//*[@id="weights_month"]').screenshot_as_png)

self.time.append(self.driver.find_element_by_id('history-1m-tab').text)

Mysql数据库

Mariadb和Oracle甲骨文旗下的Mysql之间的渊源,感兴趣的小伙伴可以去了解一下,Mariadb由于是开源的软件所以更新迭代的次数要比Mysql多,但是两者的语法和大体功能上是相同的

- 初始化信息

在开始运行前一定要安装配置好mysql,我这里使用的是mariadb附上下载链接https://mariadb.com/downloads/,登录界面长这样 文章来源:https://www.toymoban.com/news/detail-796149.html

文章来源:https://www.toymoban.com/news/detail-796149.html

mysql登录信息文章来源地址https://www.toymoban.com/news/detail-796149.html

def __init__(self):

# mysql登录信息

self.host='127.0.0.1'

self.user='root'

self.password='123456'

self.chartset='utf8'#编码格式注意这里不是utf-8,数据库这里的参数配置没有'-'

self.database='metrics_db'#数据库名称

- 建立数据库

def set_sqldb(self,sql):

db = sql.connect(

host=self.host,

user=self.user,

password=self.password,

charset=self.chartset,

)

cursor=db.cursor()

try:

cursor.execute("create database metrics_db character set utf8;")

except:

pass

cursor.close()

db.close()

- 建立数据表

#建立mysql数据表

def set_sqlist(self,sql,list_lable):

db=sql.connect(

host=self.host,

user=self.user,

password=self.password,

charset=self.chartset,

database=self.database

)

cursor=db.cursor()

sql="""drop table if exists `%s`"""%((list_lable))

cursor.execute(sql)

if list_lable=='History':

sql = """

create table if not exists `%s`(id int auto_increment primary key comment'序列号',

time VARCHAR(255) not null comment '月份',

graph1 longblob comment '图片',

graph2 longblob comment '图片');""" % (list_lable)

else:

sql=到了这里,关于爬虫实战(一)Python+selenium自动化获取数据存储到Mysql中的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!