1、SFT是监督微调(Supervised Fine-Tun-ing)的缩写。这是一种常见的深度学习策略,通常在预训练的大语言模型上使用。

参考该文

2、强化学习(Reinforcement Learning)

1)强化学习是智能体(Agent)以“试错”的方式进行学习,通过与环境(Environment)进行交互获得的奖赏(Reward)驱动行为(Action),目标是使智能体获得最大的奖赏。

2)强化学习与监督学习有很大的不同,强化学习不需要依靠标签好的数据信息,甚至可以不需要大量的数据,强化学习通过自身学习去产生数据集,并且利用产生的数据集继续进行学习优化,找到最优的方式。

3、RLHF(Reinforcement Learning fromHuman Feedback,人类反馈强化学习)起到的作用是,通过将人类的反馈纳入训练过程,为机器提供了一种自然的、人性化的互动学习过程。这就像人类从另一个专业人士身上学习专业知识的方式一样。通过和人类之间架起一座桥梁,RLHF让AI快速掌握了人类经验。在RLHF中,强化学习与人类反馈相结合,人类的偏好被用作奖励信号,以指导模型的训练,从而增强模型对人类意图的理解和满足程度。在生成模型中,RLHF还可以让生成的图像与文本提示得到充分对齐。

监督微调需要调整参数,强化学习不需要调整参数。

4、迁移学习,参考该文

迁移学习(Transfer Learning)是一种机器学习方法,就是把为任务 A 开发的模型作为初始点,重新使用在为任务 B 开发模型的过程中。迁移学习是通过从已学习的相关任务中转移知识来改进学习的新任务,虽然大多数机器学习算法都是为了解决单个任务而设计的,但是促进迁移学习的算法的开发是机器学习社区持续关注的话题。 迁移学习对人类来说很常见,例如,我们可能会发现学习识别苹果可能有助于识别梨,或者学习弹奏电子琴可能有助于学习钢琴。

. 为什么需要迁移学习?

大数据与少标注的矛盾:虽然有大量的数据,但往往都是没有标注的,无法训练机器学习模型。人工进行数据标定太耗时。

大数据与弱计算的矛盾:普通人无法拥有庞大的数据量与计算资源。因此需要借助于模型的迁移。

普适化模型与个性化需求的矛盾:即使是在同一个任务上,一个模型也往往难以满足每个人的个性化需求,比如特定的隐私设置。这就需要在不同人之间做模型的适配。

特定应用(如冷启动)的需求。

5、有监督学习、无监督学习,参考该文

有监督学习的训练数据集是有标注的,相当于告诉模型正确答案了,会用测试集(训练集的子集)来进行预测。无监督学习,模型使用未标记的数据集进行训练。

6、注意力机制,参考该文

始注意力模型!

(1)卷积神经网络中的最大汇聚:查看一块空间区域内的特征,并选择只保留一个特征。这是一种“全有或全无”的注意力形式,即保留最重要的特征,舍弃其他特征。

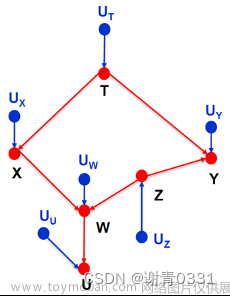

(2)TF-IDF规范化:根据每个词元可能携带的信息量,确定词元的重要性分数。重要的词元会受到重视,而不相关的词元则会被忽视。这是一种连续的注意力形式。有各种不同形式的注意力,但它们首先都要对一组特征计算重要性分数。特征相关性越大,分数越高;特征相关性越小,分数越低,如图11-5所示。如何计算和处理这个分数,则因方法而异。文章来源:https://www.toymoban.com/news/detail-796438.html

文章来源地址https://www.toymoban.com/news/detail-796438.html

文章来源地址https://www.toymoban.com/news/detail-796438.html

到了这里,关于人工智能的技术概念解释的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!