在我之前的博文中已经做过关于人体姿势识别人体姿态检测的博文,都是比较早期的技术模型了,随机技术的迭代更新,很多更加出色的模型陆续出现,这里基于一些比较好用的轻量级模型开发的姿态检测模型。

原始博文如下:

《人体行为姿势识别数据集WISDM实践》

文章来源地址https://www.toymoban.com/news/detail-796765.html

《yolov4-tiny目标检测模型实战——学生姿势行为检测》

感兴趣的话可以自行移步前去阅读。

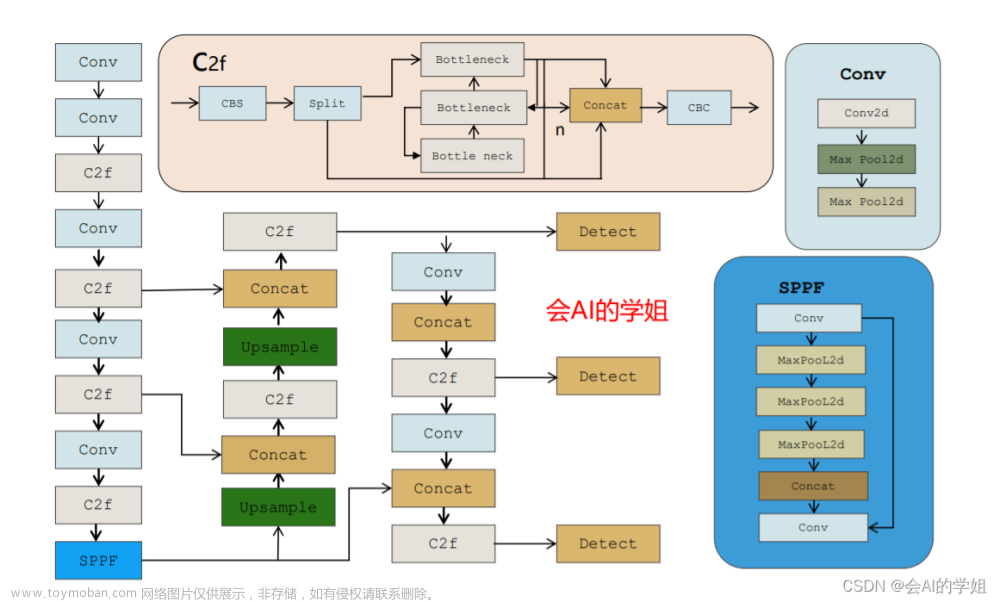

本文的主要工作室基于轻量级的yolov5s模型来开发学生上课姿势检测模型。首先看下效果:

基于yolov5的轻量级学生上课姿势检测分析系统

图像数据如下:

YOLO格式的标注文件如下所示:

模型配置文件如下所示:

# YOLOv5 🚀 by Ultralytics, GPL-3.0 license

# Parameters

nc: 4 # number of classes

depth_multiple: 0.33 # model depth multiple

width_multiple: 0.50 # layer channel multiple

anchors:

- [10,13, 16,30, 33,23] # P3/8

- [30,61, 62,45, 59,119] # P4/16

- [116,90, 156,198, 373,326] # P5/32

# YOLOv5 v6.0 backbone

backbone:

# [from, number, module, args]

[[-1, 1, Conv, [64, 6, 2, 2]], # 0-P1/2

[-1, 1, Conv, [128, 3, 2]], # 1-P2/4

[-1, 3, C3, [128]],

[-1, 1, Conv, [256, 3, 2]], # 3-P3/8

[-1, 6, C3, [256]],

[-1, 1, Conv, [512, 3, 2]], # 5-P4/16

[-1, 9, C3, [512]],

[-1, 1, Conv, [1024, 3, 2]], # 7-P5/32

[-1, 3, C3, [1024]],

[-1, 1, SPPF, [1024, 5]], # 9

]

# YOLOv5 v6.0 head

head:

[[-1, 1, Conv, [512, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 6], 1, Concat, [1]], # cat backbone P4

[-1, 3, C3, [512, False]], # 13

[-1, 1, Conv, [256, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 4], 1, Concat, [1]], # cat backbone P3

[-1, 3, C3, [256, False]], # 17 (P3/8-small)

[-1, 1, Conv, [256, 3, 2]],

[[-1, 14], 1, Concat, [1]], # cat head P4

[-1, 3, C3, [512, False]], # 20 (P4/16-medium)

[-1, 1, Conv, [512, 3, 2]],

[[-1, 10], 1, Concat, [1]], # cat head P5

[-1, 3, C3, [1024, False]], # 23 (P5/32-large)

[[17, 20, 23], 1, Detect, [nc, anchors]], # Detect(P3, P4, P5)

]

训练完成结果目录截图如下所示:

训练过程监控指标如下:

混淆矩阵:

F1值曲线和PR曲线如下:

标签可视化如下所示:

batch检测样例可视化如下所示:

启动检测系统如下:

点击上传图像即可选择想要检测识别的图像,如下所示:

点击目标检测识别即可启动离线推理计算,如下所示:

文章来源:https://www.toymoban.com/news/detail-796765.html

文章来源:https://www.toymoban.com/news/detail-796765.html

到了这里,关于基于yolov5轻量级的学生上课姿势检测识别分析系统的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!