High-Resolution Image Synthesis with Latent Diffusion Models论文阅读

Abstract & Introduction

Diffusion model相比GAN可以取得更好的图片生成效果,然而该模型是一种自回归模型,需要反复迭代计算,因此训练和推理代价都很高。论文提出一种在潜在表示空间(latent space)上进行diffusion过程的方法,从而能够大大减少计算复杂度,同时也能达到十分不错的图片生成效果。

图像符号:

- 在RGB空间:

- 编码器encoder:,将x压缩成低维表示

- 解码器decoder: D,将低维表示z还原成原始图像空间。

- 用于生成控制的条件去噪自编码器:

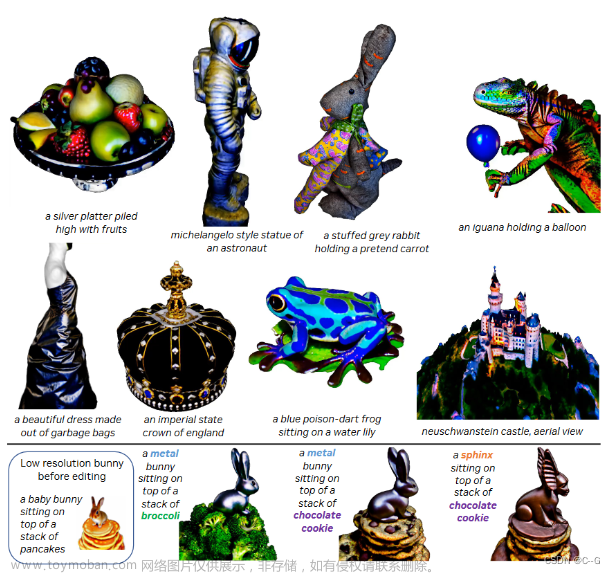

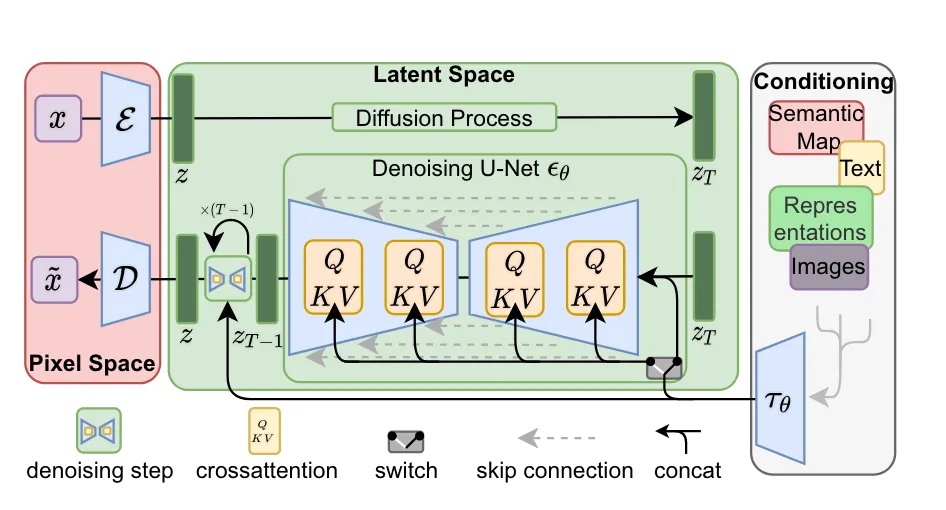

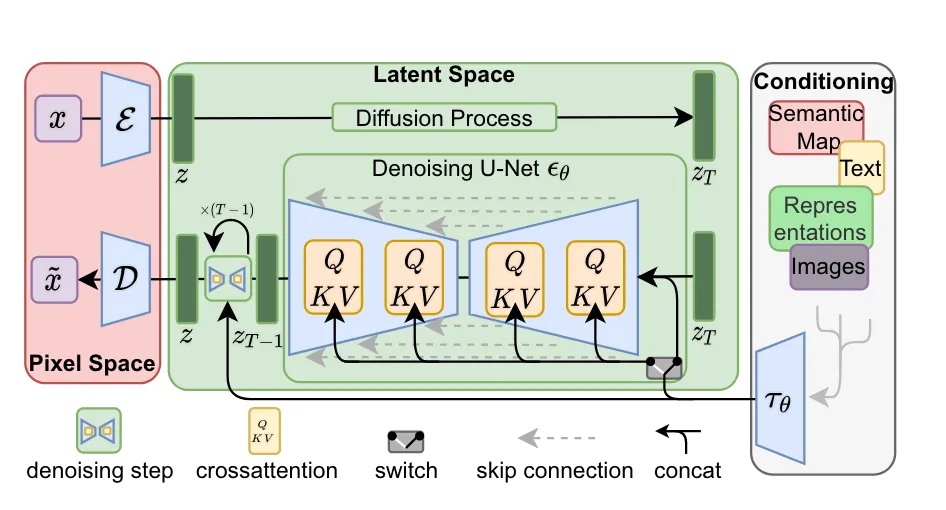

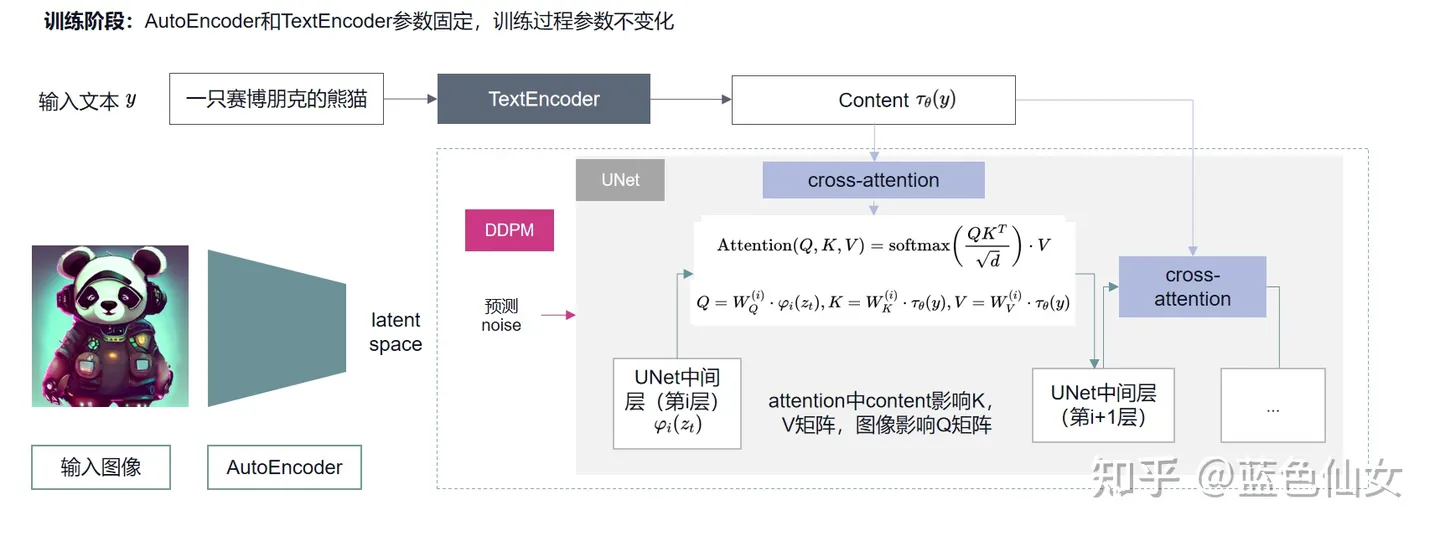

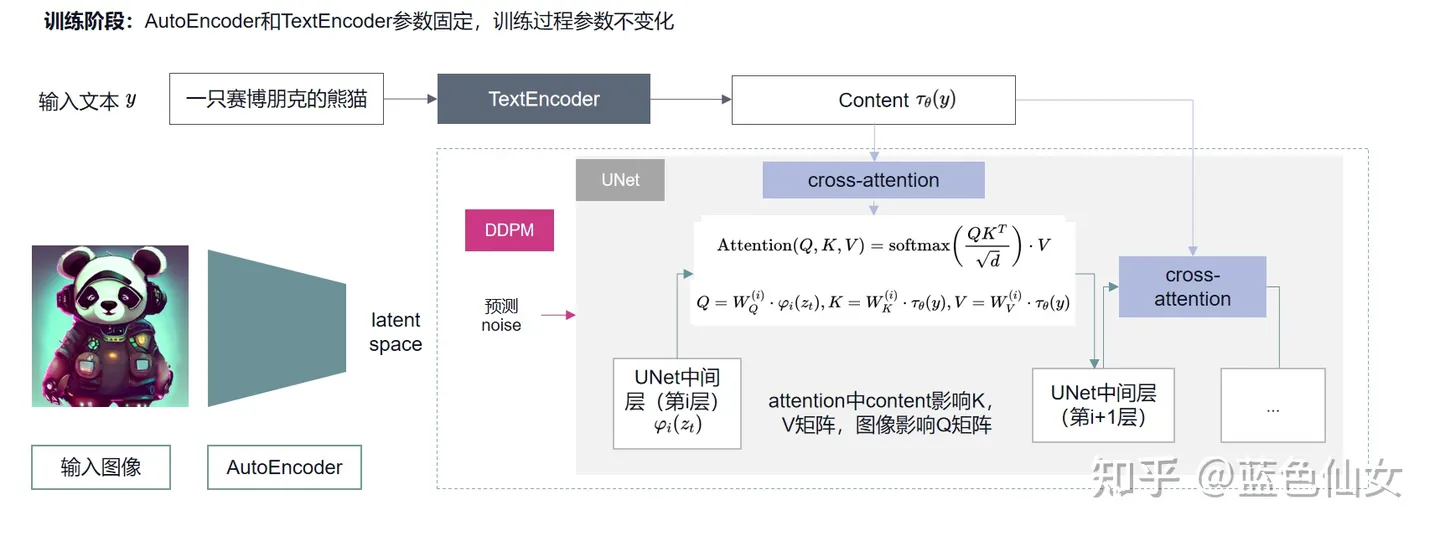

LDMs相比DDPM最大的两点改进如下:

-

加入Autoencoder(上图中左侧红色部分),使得扩散过程在latent space下,提高图像生成的效率;

-

加入条件机制,能够使用其他模态的数据控制图像的生成(上图中右侧灰色部分),其中条件生成控制通过Attention(上图中间部分QKV)机制实现。

Introduction

高分辨率图像合成与潜在扩散模型

高分辨率图像合成的潜在扩散模型(Latent Diffusion Model, LDM)属于基于似然性的模型,它倾向于使用过多的容量来建模细节。训练这样的模型需要大量的计算资源,同时评估已经训练的模型在时间和内存上也相当昂贵。因为相同的模型架构必须连续运行大量步数。在不影响DM性能的前提下,减少其计算需求是增强其可访问性的关键。

潜在空间(Latent Space)

论文从分析像素空间中已经训练的扩散模型开始。如图2所示,训练模型显示了速率失真权衡。学习过程可以大致分为两个阶段:

- 感知压缩阶段:去除了高频细节,但仍然学习到很少的语义变化。

- 语义压缩阶段:学习数据的语义和概念组成,实际生成模型在此阶段学习。

因此,论文的目标是找到一个等价但计算量更小的空间,在此空间中训练扩散模型。

图2: 说明感知和语义压缩:数字图像的大部分对应于难以察觉的细节。

生成高清图像的挑战

尽管diffusion模型在学习时会主要关注结构并忽略图像细节,但在计算loss时还是需要逐像素地进行计算。这导致了相当大的计算需求,其中很多像素进行了很多不必要的推理和梯度计算。

训练方法

将训练分为两个不同阶段:

- 感知压缩阶段:在第一阶段,模型学习对输入进行感知上的压缩。

- 语义压缩阶段:在第二阶段,模型开始理解和生成图像的有意义内容。

两阶段训练方法:

- 自编码器训练:首先训练一个自编码器,提供一个较低维度的表示空间,该空间在感知上等同于数据空间。

- 扩散模型(DM)训练:在学习到的潜空间中训练DM,该空间具有更好的尺度属性并减少了复杂性。

论文贡献

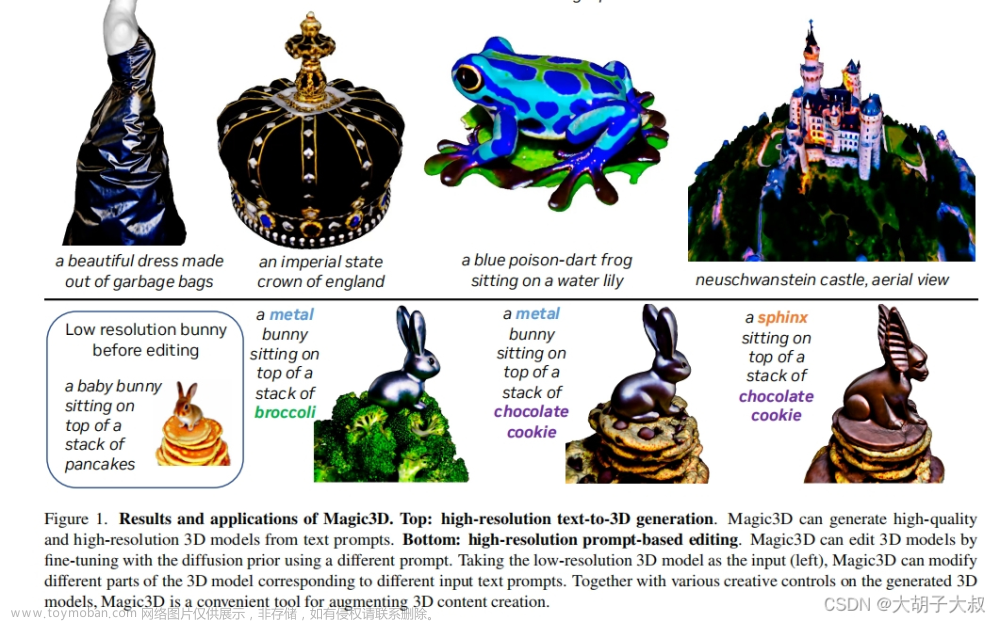

- 相比纯粹基于Transformer的方法,论文的方法对更高维度的数据进行了缩放,提供了更可靠和详细的重建,并且可以有效地应用于百万像素图像的高分辨率合成。

- 实现了在多个任务和数据集上具有竞争力的性能,同时显著降低了计算成本。

- 不需要对重构和生成能力进行精确加权,这确保了可靠的重建,并且几乎不需要潜在空间的正则化。

- 设计了一种基于交叉注意力的通用条件调节机制,实现了多模态训练。

好处

- 通过转向低维空间,提高了DM的计算效率。

- 利用了UNet架构的归纳偏差,减少了激进压缩的需要,保持了数据质量。

- 通用的压缩模型可用于多种下游应用,提高了模型的实用性和灵活性。

Method

降低训练扩散模型对高分辨率图像合成的计算需求:扩散模型需要在像素空间中进行函数评估,这导致了计算时间和能量资源的巨大需求。论文通过引入压缩学习阶段与生成学习阶段的显式分离来解决。使用了一个自编码模型,学习一个在感知上与图像空间等效的空间,但显著降低了计算复杂性。

优点:(i)通过离开高维图像空间,获得了计算效率更高的DM,因为采样是在低维空间上执行的。(ii)利用了从UNet架构中继承的DM的归纳偏置,对具有空间结构的数据特别有效。(iii)获得了通用压缩模型,其潜在空间可用于训练多个生成模型,也可用于其他下游应用,如单图像CLIP引导合成。

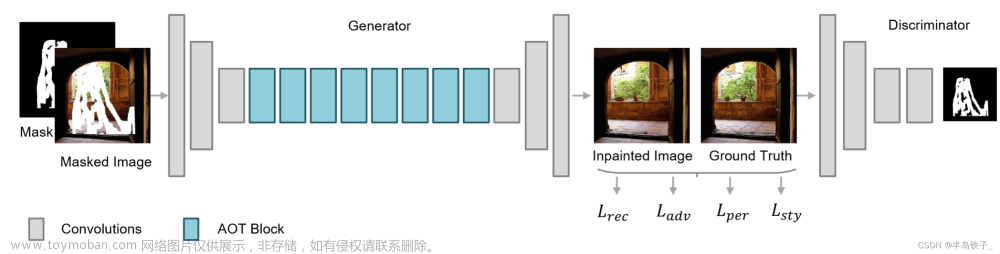

3.1. Perceptual Image Compression 感知图像压缩

这里的感知压缩模型(也就是对细节的压缩)是基于前人工作的,包含了一个自编码器,自编码器是基于感知loss和一个基于patch的对抗loss训练的。这一方面确保了图像压缩空间依然在图像所在的流行曲面范围内,另一个方面也能确保还原回的图片局部的真实性,避免了仅依赖像素空间损失而引入的模糊(比如只用 L2 或 L1 目标就会让生成的图片模糊)。

-

基于先前工作:该模型建立在先前的研究基础上。

-

自编码器

:模型包括一个自编码器,由两部分组成:

- 编码器(Encoder):将输入图像编码成潜在表示。

- 解码器(Decoder):从潜在表示重建图像。

-

训练方法

- 感知损失和对抗性目标:模型的训练结合了感知损失和基于补丁的对抗性目标。

- 避免模糊:这种组合确保重建的图像保持在图像流形上,并通过强调局部真实性来避免仅依赖像素空间损失(如L2或L1损失)引入的模糊。

-

图像处理细节

-

RGB空间的图像:给定RGB空间中的图像

,编码器 将 x 编码为潜像表示

,编码器 将 x 编码为潜像表示 ,解码器D从潜像重构图像,给出

,解码器D从潜像重构图像,给出

-

降采样因子:编码器将图像降采样一个因子f*=H/h=W/w,并探索不同的降采样因子 f*=2^m,其中 m 是自然数。编码器通过因子

对图像进行下采样。

对图像进行下采样。

-

RGB空间的图像:给定RGB空间中的图像

-

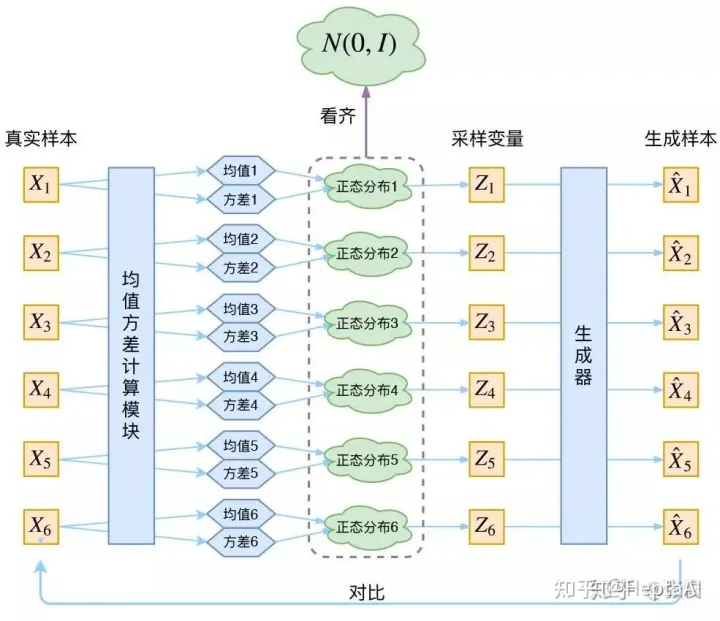

正则化方法

- 两种正则化:为了避免潜在空间具有过高的方差,模型实验了两种不同的正则化方法:

- KL正则化:对学习到的潜在空间施加类似于变分自编码器(VAE)的标准正态分布的轻微KL惩罚。类似于VAE【就是让潜空间数据的均值往0靠,方差往1靠】

- VQ正则化:在解码器内使用向量量化层。用了解码器里的一个向量量化层。这个模型可以被看成一个量化层被解码器吸收了的VQGAN.

- 两种正则化:为了避免潜在空间具有过高的方差,模型实验了两种不同的正则化方法:

3.2. Latent Diffusion Models

扩散模型简介

扩散模型是一类概率模型,设计用于通过逐渐去噪正态分布变量来学习数据分布 p ( x ) p(x) p(x),这相当于学习固定马尔可夫链长度 T T T的逆过程。对于图像合成,最成功的模型依赖于p(x)的变分下界的重新加权变体,这反映了去噪分数匹配。这些模型可以被解释为一个等权重序列的去噪自编码器 θ ( x t , t ) ; t = 1 … T \theta(x_t, t); t = 1 \ldots T θ(xt,t);t=1…T,它们被训练用于预测它们输入 x t x_t xt的去噪版本,其中 x t x_t xt是输入 x x x的噪声版本。相应的目标可以简化为 L D M = E x , ϵ ∼ N ( 0 , 1 ) , t [ ∥ ϵ − θ ( x t , t ) ∥ 2 2 ] LDM = \mathbb{E}_{x,\epsilon\sim N(0,1),t} [\|\epsilon - \theta(x_t, t)\|^2_2] LDM=Ex,ϵ∼N(0,1),t[∥ϵ−θ(xt,t)∥22],其中 t t t从 1 , … , T {1, \ldots , T} 1,…,T中均匀采样。

低维潜在空间中的生成建模

有了我们训练好的感知压缩模型,包括编码器 E E E和解码器 D D D,我们现在可以访问一个有效的低维潜在空间,在这个空间中,高频、不可感知的细节被抽象掉了。与高维像素空间相比,这个空间更适合基于概率的生成模型,因为它们现在可以(i)专注于数据的重要语义部分和(ii)在一个低维度、计算上更有效的空间中训练。与之前依赖于在高度压缩的离散潜在空间中的自回归、基于注意力的变换器模型的工作不同,我们可以利用模型提供的特定于图像的归纳偏差。这包括使用重新加权的界限,构建主要由2D卷积层组成的底层UNet,并进一步专注于感知上最相关的部分,这现在读作 L L D M : = E E ( x ) , ϵ ∼ N ( 0 , 1 ) , t [ ∥ ϵ − θ ( z t , t ) ∥ 2 2 ] LLDM := \mathbb{E}_{E(x),\epsilon\sim N(0,1),t} [\|\epsilon - \theta(z_t, t)\|^2_2] LLDM:=EE(x),ϵ∼N(0,1),t[∥ϵ−θ(zt,t)∥22]。

我们模型的神经骨架 θ ( ⋅ , t ) \theta(\cdot, t) θ(⋅,t)是实现为一个时间条件的UNet。由于前向过程是固定的, z t z_t zt可以在训练期间有效地从 E E E获得,并且可以通过单次通过 D D D将来自 p ( z ) p(z) p(z)的样本解码到图像空间。

-

感知压缩模型:经过训练的感知压缩模型由编码器 E 和解码器 D 组成,提供了一个高效的、低维潜在空间。利用在训练时就可以利用编码器得到 Zt,从而让模型在潜在表示空间中学习

-

去除高频细节:在这个空间中,高频、不可感知的细节被抽象化。

训练过程分两步:第一步,训练一个VAE(下图中横的虚线框),得到x到 Zt的编码器 Encoder 和还原回 x′ 的解码器 Decoder;第二步,训练一个扩散模型LDM,学习一个噪声到 Zt的生成过程。其中LDM的架构是个Unet。

3.3. Conditioning Mechanisms调节机制

DDPM的UNet可以根据当前采样的t预测noise,但没有引入其他额外条件。但是LDM实现了“以文生图”,“以图生图”等任务,就是因为LDM在预测noise的过程中加入了条件机制,即通过一个编码器(encoder)将条件和Unet连接起来。

- y为控制生成的条件,Stable Diffusion中代表文本

- z为根据条件生成的向量

扩散模型的条件分布

与其他类型的生成模型类似,扩散模型原则上能够建模形式为 p ( z ∣ y ) p(z|y) p(z∣y)的条件分布。这可以通过一个条件去噪自编码器 θ ( z t , t , y ) \theta(z_t, t, y) θ(zt,t,y)实现,为通过输入 y y y(如文本、语义地图或其他图像到图像的翻译任务)控制合成过程铺平了道路。然而,在图像合成的背景下,将DM的生成能力与类标签或输入图像的模糊变体之外的其他类型的条件结合起来,是一个尚未充分探索的研究领域。

扩展条件生成能力

我们通过增强DM底层的UNet骨干网络与交叉注意力机制,将DM转变为更灵活的条件图像生成器。这种机制有效于学习各种输入模态的基于注意力的模型。为了预处理来自不同模态的 y y y(如语言提示),我们引入了一个特定领域的编码器 τ θ \tau_\theta τθ,它将 y y y投影到中间表示 τ θ ( y ) ∈ R M × d τ \tau_\theta(y) \in \mathbb{R}^{M \times d_\tau} τθ(y)∈RM×dτ,然后通过实现了交叉注意力层的UNet的中间层映射,实现了 A t t e n t i o n ( Q , K , V ) = s o f t m a x ( Q K T d ) ⋅ V Attention(Q, K, V) = softmax(\frac{QK^T}{\sqrt{d}}) \cdot V Attention(Q,K,V)=softmax(dQKT)⋅V,其中 Q = W Q ( i ) ⋅ ϕ i ( z t ) , K = W K ( i ) ⋅ τ θ ( y ) , V = W V ( i ) ⋅ τ θ ( y ) Q = W^{(i)}_Q \cdot \phi_i(z_t), K = W^{(i)}_K \cdot \tau_\theta(y), V = W^{(i)}_V \cdot \tau_\theta(y) Q=WQ(i)⋅ϕi(zt),K=WK(i)⋅τθ(y),V=WV(i)⋅τθ(y)。这里 ϕ i ( z t ) ∈ R N × d i \phi_i(z_t) \in \mathbb{R}^{N \times d_i} ϕi(zt)∈RN×di表示UNet实现 θ \theta θ的(平展的)中间表示,而 W V ( i ) ∈ R d × d i , W Q ( i ) ∈ R d × d τ W^{(i)}_V \in \mathbb{R}^{d \times d_i}, W^{(i)}_Q \in \mathbb{R}^{d \times d_\tau} WV(i)∈Rd×di,WQ(i)∈Rd×dτ和 W K ( i ) ∈ R d × d τ W^{(i)}_K \in \mathbb{R}^{d \times d_\tau} WK(i)∈Rd×dτ是可学习的投影矩阵。

学习条件LDM

基于图像-条件对,我们通过 L L D M : = E E ( x ) , y , ϵ ∼ N ( 0 , 1 ) , t [ ∥ ϵ − θ ( z t , t , τ θ ( y ) ) ∥ 2 2 ] LLDM := \mathbb{E}_{E(x),y,\epsilon \sim \mathcal{N}(0,1),t} [\|\epsilon - \theta(z_t, t, \tau_\theta(y))\|^2_2] LLDM:=EE(x),y,ϵ∼N(0,1),t[∥ϵ−θ(zt,t,τθ(y))∥22]学习条件LDM,其中 τ θ \tau_\theta τθ和 θ \theta θ通过等式3共同优化。这种调节机制具有灵活性,因为 τ θ \tau_\theta τθ可以使用特定领域的专家进行参数化。

交叉注意力计算的公式:

Attention ( Q , K , V ) = softmax ( Q K T d ) ⋅ V , \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d}}\right) \cdot V, Attention(Q,K,V)=softmax(dQKT)⋅V,

这里的loss函数是:

文章来源:https://www.toymoban.com/news/detail-797014.html

文章来源:https://www.toymoban.com/news/detail-797014.html

函数是:

[外链图片转存中…(img-A4HI45aM-1703943186340)]

参考:https://blog.csdn.net/weixin_57974242/article/details/134180461

https://zhuanlan.zhihu.com/p/582693939文章来源地址https://www.toymoban.com/news/detail-797014.html

到了这里,关于论文阅读--High-Resolution Image Synthesis with Latent Diffusion Models的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!