设计一个用强化学习来生成单元测试代码的系统需要考虑以下几个方面:

-

Agent:强化学习算法中的智能体,它需要接收当前环境状态,根据策略选择相应的动作并执行。

-

State:描述当前环境状态的特征。在这个问题中,状态可以包括待测试函数的输入和输出,以及已经生成的测试用例和它们对应的覆盖率等信息。

-

Action:智能体可以采取的行为,比如在待测试函数输入上添加新的测试用例或修改已有的测试用例。

-

Environment:整个系统的环境,包括待测试函数、测试框架、测试用例库等。系统需要将当前状态传递给智能体,让它进行决策,并根据执行结果更新状态。

-

Reward:强化学习算法中的奖励信号,用来指导智能体的决策。在这个问题中,奖励可以是代码覆盖率的提升量,也可以是测试用例数量的增加量。

具体地,可以将状态表示成一个向量,其中包括待测试函数的输入和输出,以及已生成的测试用例和它们对应的覆盖率等信息。智能体每次决策时会基于当前状态 选择一个动作 ,比如在输入上添加新的测试用例或者修改已有的测试用例。

执行完动作后,系统会返回一个新的状态 和相应的奖励 。奖励可以根据覆盖率的提升量进行设计,比如引入一个目标覆盖率,奖励为当前覆盖率与目标覆盖率之间的差异。同时,还可以设置一些惩罚项,比如每次修改测试用例都会降低一定的分数。

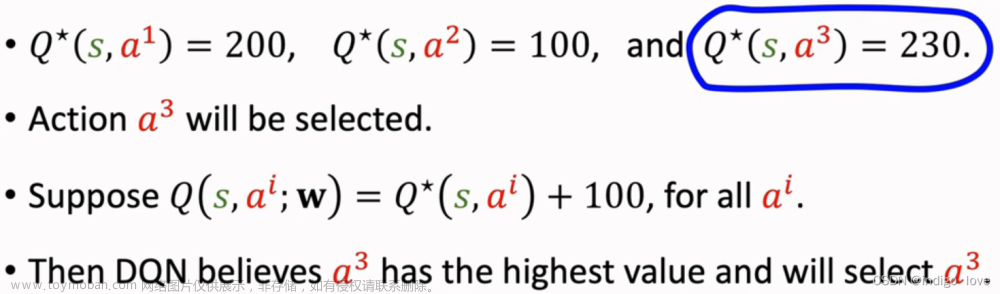

最后,可以使用基于模型的强化学习算法(如DQN)来训练智能体,优化其策略,不断改进生成单元测试代码的能力。

下面是一个简单的案例代码,用强化学习的方法来生成加法函数的单元测试代码。

首先,我们定义待测试的加法函数和测试框架。假设加法函数需要接受两个整数作为输入,并返回它们的和。测试框架可以是任何测试框架,这里我们选择Python自带的unittest框架。

def add(x, y):

return x + y

import unittest

class TestAdd(unittest.TestCase):

def test_add(self):

self.assertEqual(add(1, 2), 3)

接下来,我们可以定义智能体的状态、动作和奖励。

状态 可以包含以下信息:

- 待测试函数的输入:由两个整数 组成。

- 已有的测试用例及其覆盖率:包括当前唯一的测试用例 (1,2) 和它的覆盖率(假设已经执行过该测试用例并计算出了它的覆盖率)。

动作 可以有以下两种:

- 增加新的测试用例:在输入空间中随机选择一个点 ,添加新的测试用例 并计算它的覆盖率。

- 修改现有的测试用例:对于已有的测试用例 ,在输入空间中随机选择一个点 ,将之前的测试用例 替换成新的测试用例 并计算它的覆盖率。

奖励 可以基于测试用例的覆盖率构建,具体地,可以设置目标覆盖率,然后奖励可以设计成:

其中是更新状态后得到的新的覆盖率, 是上一次的覆盖率。如果新的覆盖率比旧的要高,则给予奖励 10 分;反之则惩罚 -10 分。

最后,我们可以使用 DQN 算法来训练智能体,优化其策略,不断改进生成单元测试代码的能力。具体来说,我们可以使用 Keras 的深度神经网络模型来近似 Q 函数,使用均方误差损失函数进行训练。同时,也需要设置合适的超参数,例如贪心策略的初始值、学习率等等。

完整的代码如下所示:

import random

import numpy as np

from keras.models import Sequential

from keras.layers.core import Dense

from keras.optimizers import Adam

# 加法函数

def add(x, y):

return x + y

# 测试框架

import unittest

class TestAdd(unittest.TestCase):

def test_add(self):

self.assertEqual(add(1, 2), 3)

# 定义智能体的状态、动作和奖励

class RLAgent:

def __init__(self):

self.state_dim = 3 # 输入空间维度(x, y, coverage)

self.action_dim = 2 # 动作空间维度(add or modify)

self.memory = [] # 记忆库(用于存储状态序列、动作序列、奖励序列、下一状态序列)

self.gamma = 0.95 # 折扣因子

self.epsilon = 1.0 # 初始 epsilon 值

self.epsilon_min = 0.01 # 最小 epsilon 值

self.epsilon_decay = 0.999 # epsilon 衰减因子

self.learning_rate = 0.001 # 学习率

# 创建神经网络模型

self.model = Sequential()

self.model.add(Dense(24, input_dim=self.state_dim, activation='relu'))

self.model.add(Dense(24, activation='relu'))

self.model.add(Dense(self.action_dim, activation='linear'))

self.model.compile(loss='mse', optimizer=Adam(lr=self.learning_rate))

# 根据当前状态选取动作(epsilon-greedy 策略)

def act(self, state):

if np.random.rand() <= self.epsilon:

return random.randrange(self.action_dim)

else:

q_values = self.model.predict(state)

return np.argmax(q_values[0])

# 记忆当前状态、动作、奖励和下一状态

def remember(self, state, action, reward, next_state):

self.memory.append((state, action, reward, next_state))

# 更新 Q 函数

def replay(self, batch_size):

if len(self.memory) < batch_size:

return

minibatch = random.sample(self.memory, batch_size)

for state, action, reward, next_state in minibatch:

target = reward + self.gamma * np.amax(self.model.predict(next_state)[0])

target_f = self.model.predict(state)

target_f[0][action] = target

self.model.fit(state, target_f, epochs=1, verbose=0)

if self.epsilon > self.epsilon_min:

self.epsilon *= self.epsilon_decay

if __name__ == "__main__":

env = TestAdd() # 环境

agent = RLAgent() # 智能体

state = np.array([[1, 2, 0.0]]) # 初始状态

batch_size = 32 # 批大小

for e in range(100): # 训练轮数

action = agent.act(state) # 获取动作

if action == 0: # 增加新的测试用例

x_prime, y_prime = random.randint(0, 100), random.randint(0, 100)

new_test_case = (x_prime, y_prime)

coverage = 1.0 - abs(add(x_prime, y_prime) - add(1, 2)) / add(1, 2)

reward = 10.0 if coverage > state[0][-1] else -10.0

next_state = np.array([[x_prime, y_prime, coverage]])

agent.remember(state, action, reward, next_state)

state = next_state

elif action == 1: # 修改现有的测试用例

x_prime, y_prime = random.randint(0, 100), random.randint(0, 100)

modified_test_case = (x_prime, y_prime)

coverage = 1.0 - abs(add(x_prime, y_prime) - add(1, 2)) / add(1, 2)

reward = 10.0 if coverage > state[0][-1] else -10.0

next_state = np.array([[x_prime, y_prime, coverage]])

agent.remember(state, action, reward, next_state)

state = next_state

agent.replay(batch_size) # 更新 Q 函数

在训练过程中,我们将初始状态设置为 (1,2,0),即输入为 (1,2),覆盖率为 0。

每次执行增加或修改操作后,会根据新的测试用例计算出相应的覆盖率,并基于覆盖率的提升量给予奖励或惩罚。

在训练结束后,我们可以使用新生成的测试用例来验证加法函数的正确性。 需要注意的是,这只是一个简单的案例代码,实际情况下需要仔细设计Agent的状态、动作和奖励,并针对具体问题进行调参和优化。同时,需要注意训练数据的质量和数量,以及如何划分训练集和测试集,以确保模型具有良好的泛化能力。

实际工程中使用时,针对参数的生成逻辑可能需要AST静态分析的能力支撑才会有比较好的效果,另外在模型训练过程中,单测代码的实时执行+覆盖率反馈也需要工程能力支撑。文章来源:https://www.toymoban.com/news/detail-798620.html

另外因为在实际项目的单测代码中,因为很多依赖服务、db、中间件等需要mock,结合精准化测试工程可以准确定位到需要mock的代码行,mock的数据也可以作为state的特征之一。文章来源地址https://www.toymoban.com/news/detail-798620.html

到了这里,关于如何用深度强化学习做单元测试代码生成的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!