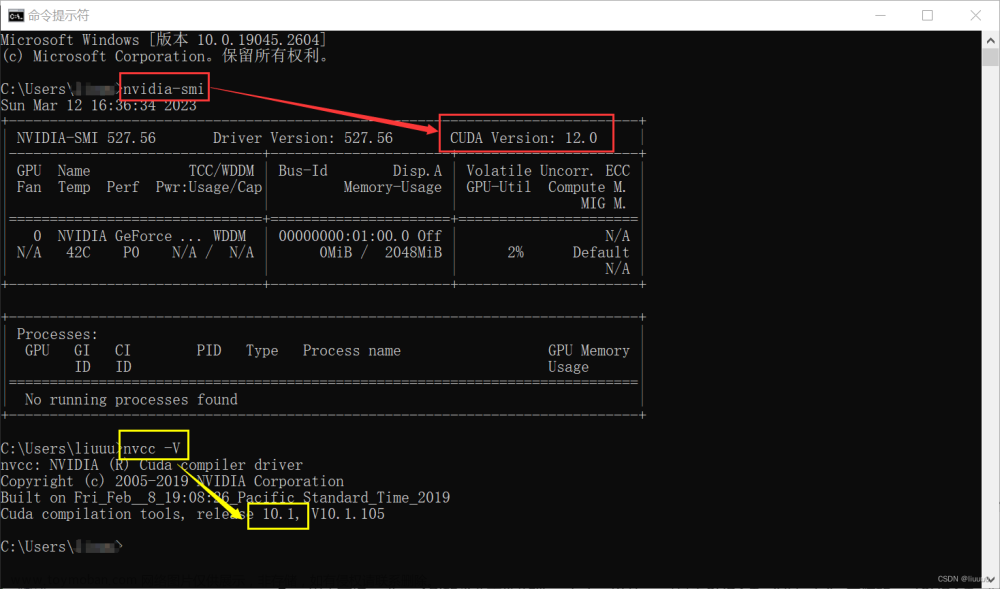

如何在Python环境下配置RTX 2060与CUDA 10

RTX 2060虽然是一款较早的显卡型号,但仍然广泛使用。对于Python开发者来说,配置CUDA 10是非常关键的,尤其是在深度学习和GPU加速计算任务中。本文将为你提供一个详细的配置指南。

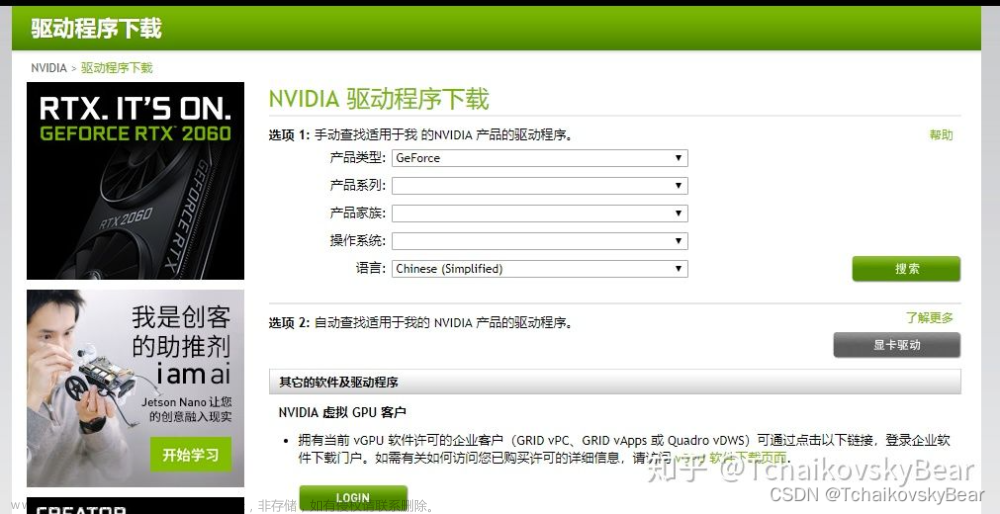

1. 安装最新的NVIDIA显卡驱动

首先,确保你已经安装了最新版本的NVIDIA显卡驱动。你可以通过访问NVIDIA官方网站来下载和安装。

2. 使用conda安装CUDA Toolkit

CUDA Toolkit是NVIDIA提供的用于GPU加速的核心工具集。使用conda可以方便地安装特定版本的CUDA Toolkit。

conda install cudatoolkit=10.2 -c pytorch

请注意,此处我们安装的是CUDA 10.2版本,你可以根据实际需求选择其他版本。

3. 验证onnxruntime与CUDA版本

在继续之前,确保你了解onnxruntime与CUDA版本之间的兼容性。你可以通过onnxruntime官方文档来查看详细信息。

4. 验证ONNX需求版本

除了CUDA版本,还需要确保你的ONNX库与其他依赖项兼容。了解更多详情,请参考这篇文章。

5. 安装ONNX与onnxruntime

接下来,安装必要的Python库。你可以使用以下命令来安装ONNX和onnxruntime。文章来源:https://www.toymoban.com/news/detail-799279.html

pip install onnxruntime==1.6

6. 编写ONNX推理代码

现在,你已经完成了所有的配置和安装步骤,可以开始编写ONNX推理代码了。以下是一个简单的示例:文章来源地址https://www.toymoban.com/news/detail-799279.html

import onnxruntime

import numpy as np

# 加载ONNX模型

onnx_model_path = 'path_to_your_model.onnx'

session = onnxruntime.InferenceSession(onnx_model_path, providers=['CUDAExecutionProvider'])

# 创建一个随机的输入数据作为示例

input_data = np.random.rand(1, 3, 224, 224).astype(np.float32)

# 使用GPU进行推理

input_name = session.get_inputs()[0].name

output_name = session.get_outputs()[0].name

result = session.run([output_name], {input_name: input_data})

# 打印推理结果

print(result)

到了这里,关于【深度学习】RTX2060 2080如何安装CUDA,如何使用onnx runtime的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!