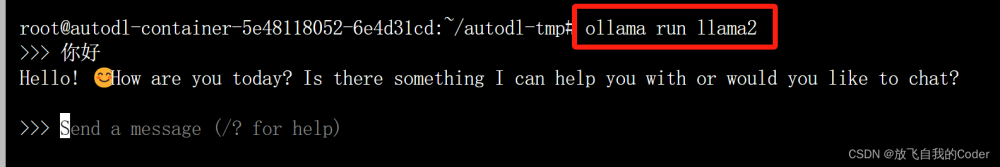

大家好,像LLaMA 2这样的新开源模型已经变得相当先进,并且可以免费使用。可以在商业上使用它们,也可以根据自己的数据进行微调,以开发专业版本。凭借其易用性,现在可以在自己的设备上本地运行它们。

本文将介绍如何下载所需的文件和LLaMA 2模型,以运行CLI程序并与AI助手进行交互。设置非常简单,即使是非技术用户或学生也可以按照这几个基本步骤进行操作。

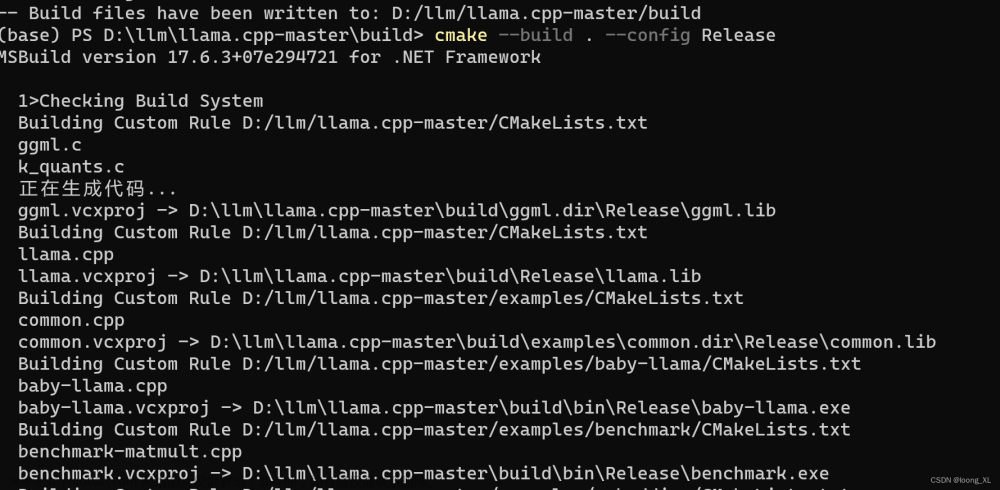

1.下载Llama.cpp用于GPU机器

要在本地安装llama.cpp,最简单的方法是从llama.cpp releases中下载预编译的可执行文件。

要在配备有NVIDIA GPU的Windows 11上安装它,我们首先需要下载llama-master-eb542d3-bin-win-cublas-[version]-x64.zip文件。下载完成后,将其解压缩到你选择的目录中。建议创建一个新文件夹并将所有文件提取到其中。

接下来,我们将下载cuBLAS驱动程序cudart-llama-bin-win-[version]-x64.zip,并将其解压缩到主目录中。要使用GPU加速,你有两个选项:NVIDIA GPU的cuBLAS和AMD GPU的clBLAS。

注意:[version]是指本地系统上安装的CUDA版本。可以通过在终端中运行

nvcc --version来检查它。

2.下载模型

首先,在主目录中创建一个名为“Models”的文件夹。在Models文件夹中,创建一个名为“llama2_7b”的新文件夹。接下来,从Hugging Face hub下载LLaMA 2模型文件。大家可以选择任何喜欢的版本,本指南将下载llama-2-7b-chat.Q5_K_M.gguf文件。下载完成后,将文件移动到刚刚创建的“llama2_7b”文件夹中。

注意:为了避免出现任何错误,请确保在运行模型之前只下载

.gguf模型文件。

3.启动AI助手CLI程序

现在可以在主目录中打开终端。通过右键单击并选择“Open in Terminal”选项,也可以打开PowerShell并使用“cd”来更改目录。

复制并粘贴下面的命令,然后按“Enter”键,正在执行带有模型目录位置、gpu、颜色和系统提示参数的main.exe文件。

./main.exe -m .\Models\llama2_7b\llama-2-7b-chat.Q5_K_M.gguf -i --n-gpu-layers 32 -ins --color -p "<<SYS>> As an AI assistant, your core values include being supportive, considerate, and truthful, ensuring that every interaction is guided by clarity and helpfulness. <</SYS>>"

llama.ccp CLI程序已成功初始化并附带了系统提示,这是一个有用的AI助手,并显示了各种可用的命令。

4.在PowerShell中本地使用LLaMA 2

通过提供提示在PowerShell中测试LLaMA 2,提出了一个关于地球年龄的简单问题。

答案非常准确,接着问一个关于地球的后续问题。

正如所看到的,该模型提供了有关我们星球的多个有趣事实。

可以要求AI助手在终端中生成代码和解释,然后可以很轻松地复制并在集成开发环境(IDE)中使用。

在本地运行LLaMA 2提供了一个功能强大且易于使用的定制化聊天机器人体验。通过按照这个简单的指南操作,可以快速学习如何建立、设置自己的私人聊天机器人,而不需要依赖付费服务。

在本地运行LLaMA 2的主要优势是对数据和对话的完全控制,以及没有使用限制,可以与机器人进行无限次数的聊天,甚至可以对其进行微调以改善回答。文章来源:https://www.toymoban.com/news/detail-799312.html

虽然与即时可用的云AI API相比时不太方便,但本地设置可以保护数据隐私,数据将完全存储在自己的设备上,无需担心泄露。文章来源地址https://www.toymoban.com/news/detail-799312.html

到了这里,关于本地运行LlaMA 2的简易指南的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!