互联网的飞快发展,尤其是手机终端业务的发展,让越来越多的事情都能通过手机来完成,电脑大部分的功能也都能通过手机实现,今天我就用C语言写一个手机APP类爬虫教程,方便后期拓展APP爬虫业务。而且这个模板是通用的适合各种APP爬虫,下面跟着我看下具体的代码吧。

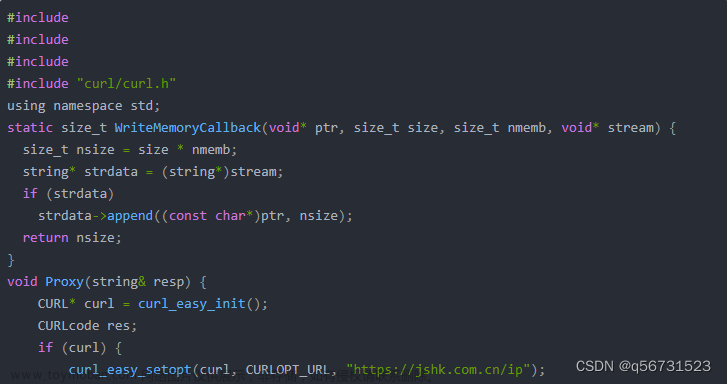

下面就是我给大家提供一个基本的C语言爬虫程序的框架,您可以根据实际情况进行修改。

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <curl/curl.h>

#define MAX_URL_LEN 256

#define MAX_FILE_LEN 1024

typedef struct {

char url[MAX_URL_LEN];

char file[MAX_FILE_LEN];

} URL_FILE;

int main(int argc, char *argv[]) {

CURL *curl;

CURLcode res;

URL_FILE urlfile;

if (argc != 3) {

printf("Usage: %s <url> <file>\n", argv[0]);

return 1;

}

curl_global_init(CURL_GLOBAL_DEFAULT);

curl = curl_easy_init();

if(curl) {

urlfile.url = argv[1];

urlfile.file = argv[2];

curl_easy_setopt(curl, CURLOPT_URL, urlfile.url);

curl_easy_setopt(curl, CURLOPT_FOLLOWLOCATION, 1L);

curl_easy_setopt(curl, CURLOPT_WRITEFUNCTION, write_data);

curl_easy_setopt(curl, CURLOPT_WRITEDATA, &urlfile.file);

res = curl_easy_perform(curl);

if(res != CURLE_OK)

fprintf(stderr, "curl_easy_perform() failed: %s\n",

curl_easy_strerror(res));

curl_easy_cleanup(curl);

}

curl_global_cleanup();

return 0;

}

size_t write_data(void *ptr, size_t size, size_t nmemb, FILE *stream) {

size_t total = size * nmemb;

int written;

written = fwrite(ptr, size, nmemb, stream);

if (written != total)

fprintf(stderr, "Error writing to file\n");

return total;

}

这个程序的基本步骤如下:

1、初始化CURL库。

2、使用curl_easy_init()创建一个CURL会话。

3、使用curl_easy_setopt()设置URL和文件名,并设置其他选项,如是否跟踪重定向和写入数据的函数。

4、使用curl_easy_perform()发送HTTP请求,并将响应写入文件。

5、使用curl_easy_cleanup()关闭CURL会话。

6、使用curl_global_cleanup()清理CURL库。

需要注意的是,这只是一个基本的爬虫程序框架,实际的爬虫程序需要考虑更多的细节,如错误处理、请求头、超时时间等。另外,爬虫程序可能会违反某些网站的使用条款,因此在使用爬虫程序时需要遵守相关的法律法规。文章来源:https://www.toymoban.com/news/detail-801313.html

其实我在编写爬虫的时候很顺利,基本没有遇到任何难点,主要得益于我的爬虫知识储备,如果后期根据项目要求可以随机增加减少代码,使用是非常的方便。如果有更多的问题可以评论区留言讨论。文章来源地址https://www.toymoban.com/news/detail-801313.html

到了这里,关于C语言爬虫程序编写的爬取APP通用模板的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!