本文深入研究了ANN的基本概念、发展背景、应用场景以及与人脑神经网络的关系。

关注TechLead,分享AI全维度知识。作者拥有10+年互联网服务架构、AI产品研发经验、团队管理经验,同济本复旦硕,复旦机器人智能实验室成员,阿里云认证的资深架构师,项目管理专业人士,上亿营收AI产品研发负责人文章来源地址https://www.toymoban.com/news/detail-801672.html

一、引言

ANN简介

人工神经网络(Artificial Neural Networks, ANN)是模仿生物神经网络(如大脑)的结构和功能的数学模型或计算模型,用于估计或逼近那些无法用传统算法精确表示的复杂函数关系。ANN是由大量互联互通的人工神经元组成,通过学习过程调整神经元间的连接权重,以实现特定的信号处理或行为模式。

研究背景与应用领域

发展背景

ANN的研究始于20世纪40年代,最初旨在通过机器模拟人脑的思考和认知过程。1950年代,首个简单的神经网络模型(感知机)被提出,但由于技术和理论限制,其发展一度陷入停滞。随着计算能力的提升和学习算法的进步,尤其是1980年代反向传播算法的提出,ANN开始快速发展,并逐渐成为深度学习和人工智能研究的核心。

应用场景

ANN在多个领域展现出强大的应用潜力和实际效果。其主要应用场景包括:

- 图像处理与计算机视觉:如图像识别、物体检测、图像分割等。

- 自然语言处理:包括语言翻译、情感分析、文本生成等。

- 语音识别与生成:例如智能助手中的语音交互系统。

- 金融领域:如股市预测、风险评估、算法交易等。

- 医疗诊断:辅助诊断、病理图像分析、基因数据分析等。

- 游戏和娱乐:游戏AI的开发、内容生成等。

- 自动驾驶技术:车辆环境感知、决策制定等。

ANN的广泛应用归功于其强大的学习能力和适应性,能够处理和分析大量复杂的数据,从而在上述领域发挥重要作用。

二、ANN背后的人脑神经网络

人脑神经网络的专业描述

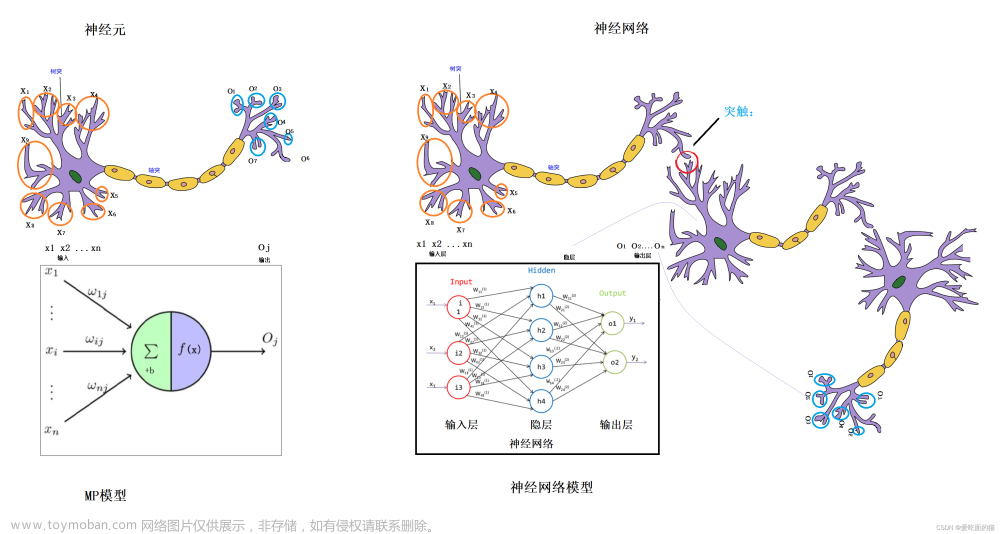

人脑神经网络是由大约860亿个神经元组成的复杂网络。每个神经元通过突触与其他神经元相连,形成了一张巨大的、高度动态的网络。神经元通过电化学信号进行交流,这些信号在神经网络中传递和处理信息。关键在于,神经元之间的连接强度(突触权重)是可变的,这种可塑性是学习和记忆的生物学基础。

神经元的结构

- 细胞体:包含核心的生物化学机制。

- 树突:接收来自其他神经元的信号。

- 轴突:将信号传输到其他神经元。

- 突触:神经元间的连接点,通过神经递质实现信号传递。

信号处理

- 激活:当一个神经元接收到足够的激励信号时,会触发动作电位,向其他神经元传递信息。

- 抑制:某些信号会减弱神经元的活动,降低其发放动作电位的概率。

思考和认知过程

人类的思考和认知过程是极度复杂的,涉及到记忆、注意力、感知、语言等多个方面。大脑通过高效的信息处理机制,能够快速响应外部刺激、做出决策并学习新知识。这一过程在很大程度上依赖于神经元间连接的可塑性和网络结构的动态调整。

认知功能的实现

- 学习与记忆:通过改变突触的强度(突触可塑性)实现。

- 决策制定:大脑在处理信息时会评估不同行动的潜在后果。

- 感知与处理:对外部信息(如视觉、听觉信号)进行编码和解析。

对机器学习算法的启示

人脑神经网络对ANN的设计和发展有深远的影响。机器学习算法,尤其是深度学习,从人脑中汲取灵感,尝试模拟以下几个方面:

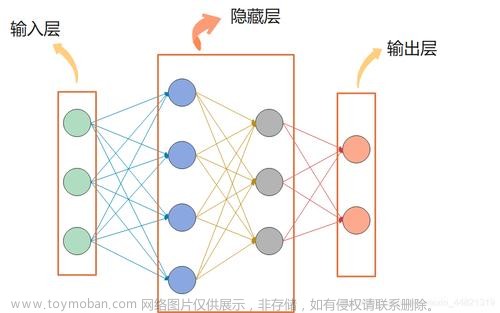

- 分层处理:大脑通过不同层级处理不同复杂度的信息,ANN中的多层架构正是此思想的体现。

- 权重调整:与神经元突触的可塑性相似,ANN在学习过程中通过调整权重来提升性能。

- 并行处理:大脑能同时处理大量信息,类似地,ANN也采用并行计算来提高效率。

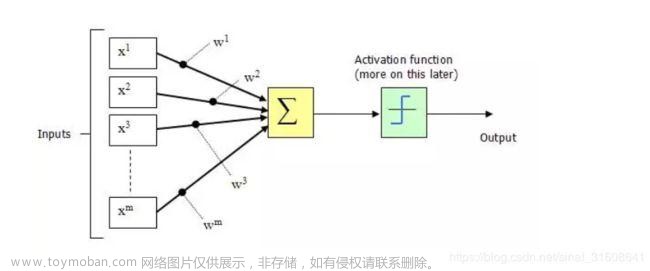

- 非线性激活:神经元的激活函数在ANN中以非线性激活函数的形式体现,增强模型的表达能力。

三、ANN的研究进展

人工神经网络(ANN)的发展历程可以划分为几个重要阶段,每个阶段都有其里程碑式的技术和理论贡献。以下是这些阶段的详细描述及其典型的技术代表。

初始阶段:感知机与早期神经网络

发展背景

- 时间线:1940年代末至1960年代。

- 关键贡献:这一时期的研究聚焦于模拟神经元的简单模型,试图理解大脑如何处理信息。

技术代表

- 感知机(Perceptron):由Frank Rosenblatt在1957年提出,是最早的神经网络模型之一,能够执行简单的分类任务。

发展阶段:反向传播与多层网络

发展背景

- 时间线:1980年代。

- 关键贡献:引入多层结构和反向传播算法,大大提升了神经网络的学习能力和复杂性。

技术代表

- 反向传播算法(Backpropagation):这一算法能够有效地训练多层前馈神经网络,由Rumelhart, Hinton和Williams于1986年提出。

扩展阶段:卷积神经网络与循环神经网络

发展背景

- 时间线:1990年代至2000年代。

- 关键贡献:引入了专门针对特定任务(如图像和序列数据处理)的网络架构。

技术代表

- 卷积神经网络(CNN):由Yann LeCun等人在1990年代发展,特别适用于图像处理任务。

- 循环神经网络(RNN):适用于处理序列数据,如时间序列分析和自然语言处理。

革新阶段:深度学习与大数据

发展背景

- 时间线:21世纪初至今。

- 关键贡献:利用大规模数据和强大的计算能力,深度学习模型在多个领域取得了显著成就。

技术代表

- 深度学习框架:如TensorFlow, PyTorch等,使得构建复杂的神经网络模型变得更加容易。

- 长短期记忆网络(LSTM):一种特殊的RNN架构,有效解决了传统RNN中的梯度消失问题。

- 生成对抗网络(GAN):由Ian Goodfellow于2014年提出,用于生成逼真的图像等数据。

当前与未来趋势

发展背景

- 时间线:当前至未来。

- 关键贡献:更加注重网络的可解释性、效率以及在复杂任务中的应用。

技术代表

- 注意力机制与Transformer模型:在自然语言处理领域尤其有效,如BERT和GPT系列。

- 自监督学习:减少对标记数据的依赖,通过学习数据中的内在结构来提高学习效率。

四、脑科学是否是人工智能的未来钥匙?

在探索人工智能(AI)的未来发展路径时,脑科学作为一个重要的参考领域,提供了对智能本质的深刻洞见。

脑科学与人工智能的交叉

相似性与启示

- 信息处理机制:人脑通过神经元网络高效处理信息,这为ANN的结构提供了启示。

- 学习与适应:大脑展现出的学习和适应能力激发了深度学习算法的发展。

- 决策与问题解决:人类决策过程中的复杂性和灵活性为AI系统设计提供了参考。

差异与挑战

- 复杂性与规模:人脑的复杂性远超当前任何AI系统。

- 意识与自主性:AI缺乏类似人类的意识和自主性,这是目前AI无法触及的领域。

- 情感与社会交互:人类的情感和社会交互能力是AI难以完全复制的部分。

脑科学对AI的具体贡献

算法与架构创新

- 脑科学的研究可以启发新的算法,例如模拟大脑的信息编码和处理方式。

- 神经可塑性的原理可以用于改进神经网络的学习机制。

解释性与可靠性

- 通过研究人脑处理信息的方式,可以提高AI的解释性。

- 模拟人类的决策过程有助于提高AI系统的可靠性和鲁棒性。

人机交互

- 理解人类的认知和感知过程有助于改进人机交互。

最新的研究

脑科学与人工智能(AI)之间的关系日益显现为研究的重要领域,它为理解和发展AI技术提供了深刻的见解和潜在的突破。最近的研究强调了这种关系的几个关键方面,突出了脑科学作为推动AI发展的关键因素的潜力。

-

AI与人脑中的记忆形成机制:一个重要的研究领域是AI与人脑记忆形成机制之间的惊人相似性。这种相似性不仅是表面的,它延伸到了记忆巩固中的非线性这一关键方面,这对于人类般的记忆处理在AI系统中至关重要。人类认知机制与AI设计之间的这种融合不仅对创造高效和高性能的AI系统充满希望,而且还通过AI模型为大脑的运作提供了宝贵的窗口。

-

AI在神经科学研究中的应用:AI正在成为神经科学研究中不可或缺的工具。它帮助神经科学家测试假设并分析复杂的神经影像数据。用于执行智能任务的AI模型正在引领对大脑如何管理类似过程的新概念和理解。这种互利关系表明了一种相互促进的关系,其中一个领域的进步推动了另一个领域的发展。

-

脑启发的AI构建:将脑启发的非线性纳入AI构建标志着模拟人类记忆过程的重要进步。目前这一领域的研究重点是如何将人类认知机制启发和塑造AI设计。目标不仅是复制,还要基于人脑复杂工作的理解和创新。

-

未来方向:展望未来,AI与脑科学的交汇拥有巨大的潜力。它可以改变我们对大脑健康的理解,对抗疾病,并开发受人类智能的多样性和深度启发的AI技术。神经科学原理与AI研究的持续融合可能会导致更复杂、适应性更强、效率更高的AI系统。文章来源:https://www.toymoban.com/news/detail-801672.html

关注TechLead,分享AI全维度知识。作者拥有10+年互联网服务架构、AI产品研发经验、团队管理经验,同济本复旦硕,复旦机器人智能实验室成员,阿里云认证的资深架构师,项目管理专业人士,上亿营收AI产品研发负责人

到了这里,关于脑科学与人工神经网络ANN的发展历程与最新研究的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!