目录

何为AI视频?

一、技术发展概况

二、代表模型及应用

三、仍存在许多技术难点

何为AI视频?

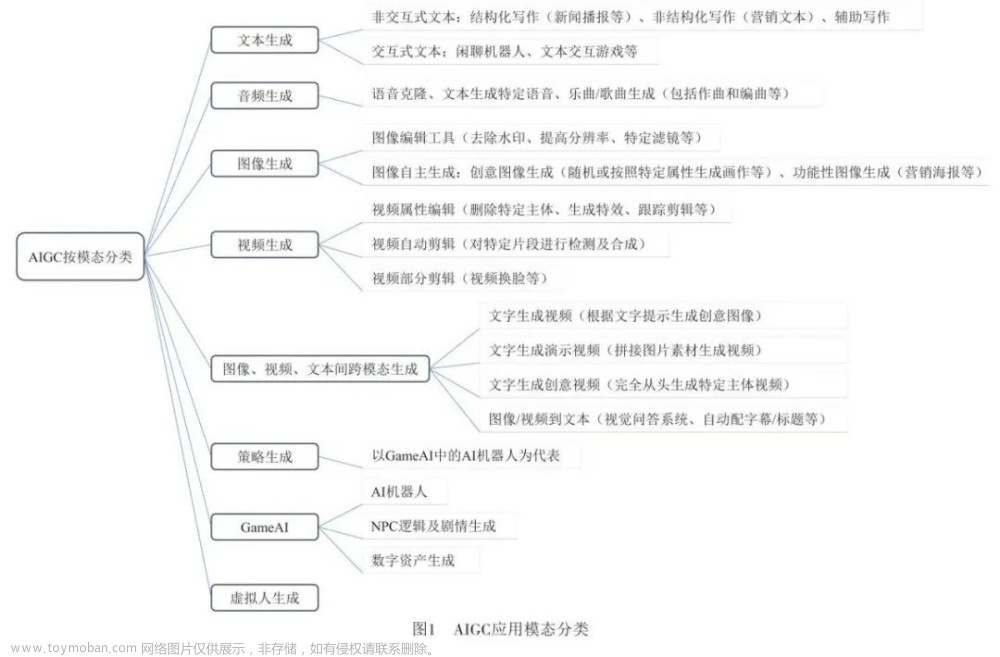

「AI视频」通常指的是由人工智能(AI)技术生成或处理的视频。这可能包括使用深度学习、计算机视觉和其他相关技术来改善视频的质量、内容或生成全新的视频内容。一般可以分为三个关键技术:视频生成、视频编辑和视频理解。

一、技术发展概况

1.1 视频生成技术

「视频生成」是指通过对人工智能的训练,使其能够根据给定的文本、图像、视频等单模态或多模态数据,自动生成符合描述的、高保真的视频内容。从生成方式进行划分,当前AI视频生成可分为文生视频、图生视频、视频生视频。

主要包含以下技术内容:

-

文生视频、图生视频:(Runway、Pika labs、SD + Deforum、Stable Video Diffusion、MagicAnimate、DemoFusion等)

-

视频生视频:又分逐帧生成(SD + Mov2Mov)、关键帧+补帧(SD + Ebsynth、Rerender A Video)、动态捕捉(Deep motion、Move AI、Wonder Dynamics)、视频修复(Topaz Video AI)

-

AI Avatar+语音生成:Synthesia、HeyGen AI、D-ID

-

长视频生短视频:Opus Clip

-

脚本生成+视频匹配:Invideo AI

-

剧情生成:Showrunner AI

1.2 生成技术路径:从GAN到Diffusion

图片生成和视频生成的底层技术框架较为相似,主要包括GAN、自回归模型和扩散模型三大路径,其中扩散模型(Diffusion model)为当前主流生成模型。

1.2.1 生成式对抗网络(GAN, Generative Adversarial Networks)

GAN是扩散模型前的主流图像生成模型,通过生成器和判别器进行对抗训练来提升模型的图像生成能力和图像鉴别能力,使得生成式网络的数据趋近真实数据,从而图像趋近真实图像。

GAN常见的模型结构:

-

单级生成网络:代表有DF-GAN等。只使用一个生成器、一个鉴别器、一个预训练过的文本编码器,使用一系列包含仿射变换的UPBlock块学习文本与图像之间的映射关系,由文本生成图像特征。

-

堆叠结构:多阶段生成网络,代表有stackGAN++、GoGAN等。GAN 对于高分辨率图像生成一直存在许多问题,层级结构的GAN 通过逐层次,分阶段生成,一步步提升图像的分辨率。在每个分支上,生成器捕获该尺度的图像分布,鉴别器分辨来自该尺度样本的真假,生成器G1接收上一阶段的生成图像不断对图像进行细化并提升分辨率,并且以交替方式对生成器和鉴别器进行训练。多阶段GAN相比二阶段表现出更稳定的训练行为。(一般来说,GAN的训练是不稳定的,会发生模式倒塌的现象mode collapse,即生成器结果为真但多样性不足)

GAN的特点:相较于其他模型,GAN的模型参数量小,较轻便,所以更加擅长对单个或多个对象类进行建模。但由于其训练过程的不稳定性,针对复杂数据集则极具挑战性,稳定性较差、生成图像缺乏多样性。这也导致其终被自回归模型和扩散模型所替代。

1.2.2 自回归模型(Auto-regressiveModel)

采用Transformer进行自回归图像生成。Transformer整体框架主要分为Encoder和Decoder两大部分,能够模拟像素和高级属性(纹理、语义和比例)之间的空间关系,利用多头自注意力机制进行编码和解码。

与GANs相比,自回归模型具有明确的密度建模和稳定的训练优势,自回归模型可以通过帧与帧之间的联系,生成更为连贯且自然视频。但是自回归模型受制于计算资源、训练所需的数据、时间,模型本身参数数量通常比扩散模型大,对于计算资源要求及数据集的要求往往高于其他模型。

随着扩散模型的火热,自回归模型的热潮逐渐降低,AI绘画和视频生成的热潮渐起。

自回归模型的技术演进过程:

1.2.3 扩散模型 (Diffusion Model)

通过定义一个扩散步骤的马尔可夫链,通过连续向数据添加随机噪声,直到得到一个纯高斯噪声数据,然后再学习逆扩散的过程,经过反向降噪推断来生成图像,通过系统地扰动数据中的分布,再恢复数据分布,逐步优化过程。

现阶段,扩散模型已成为AI 视频生成领域的主流技术路径,由于扩散模型在图像生成方面的成功,其启发了基于扩散模型的视频生成的模型。Video Diffusion Model的提出标志着扩散模型在视频生成领域的应用。

经典扩散模型在视频生成领域应用梳理

二、代表模型及应用

2.1 视频生成领域代表工作

2.1.1 清华CogVideo

首个开源的中文文本生成视频模型,基于自回归模型。

模型创新:

-

多帧率分层训练策略:能够更好地对齐文本和视频剪辑,显著地提高视频生成的准确性,这种训练策略赋予了CogVideo在复杂语义运动的生成过程中控制变化强度的能力。

-

基于预训练的文本生成图像模型:通过微调预训练的文本生成图像模型,节省了从头开始预训练的花费,提高了生成的效率。

2.1.2 谷歌Phenaki

Phenaki由Google Research开发制作,该模型是第一个能够从开放域时间变量提示中生成视频的模型,能够根据一系列开放域文本提示生成可变长度的视频。通过将视频压缩为离散令牌的小型表示形式,词例化程序使用时间上的因果注意力,允许处理可变长度的视频。

特色功能:

-

交互视频:通过选择上下文词组合来创建有关主题的视频。

-

图像+文本描述生成视频(a still image + a prompt):输入第一帧和文本描述,Phenaki即能输出视频

-

长视频:Phenaki是第一个可以通过一长串的文本描述(a long sequences of prompts)、并且描述可以随着时间的推移而变化以生成长达2分钟连贯视频的模型。

-

C-ViViT:是ViViT的变体,通过视频生成的额外架构更改,它可以在时间和空间维度上压缩视频,同时在时间上保持自动回归,此功能允许自动回归生成任意长度的视频。

2.1.3 字节MagicVideo

MagicVideo是字节跳动提出的一种基于潜在扩散模型的高效文本到视频生成框架,MagicVideo可以生成与给定文本描述一致的平滑视频剪辑。MagicVideo的核心在于关键帧生成,通过扩散模型来近似低维潜在空间中16个关键帧的分布,结合具有高效的视频分配适配器和定向时间注意力模块的3D U-Net解码器,用于视频生成。

模型创新:

-

视频训练加速:使在图像任务上训练的U-Net降噪器适应视频数据:用于图像到视频分布调整的帧轻量级适配器和用于捕获跨帧时间依赖性的定向时间注意力模块,因此可以利用文本到图像模型中卷积运算符的信息权重来加速视频训练。

-

像素抖动改进:为了改善生成的视频中的像素抖动,提出了一种新颖的VideoVAE自动编码器,以实现更好的RGB重建。

生成步骤:

1、使用预先训练的VAE将视频片段映射到低维潜在空间,对视频片段在低维潜在空间中的分布进行建模;

2、在推理阶段,首先在潜在空间中生成关键帧,然后插入关键帧以暂时平滑帧序列;

3、将潜在序列映射回RGB空间,并将获得的视频上采样到高分辨率空间,以获得更好的视觉质量。

2.2 视频生成模型商业化应用

2.2.1 Runway Gen-1 & Gen-2:商用视频生成的明星应用

Runway是基于生成式AI的图像和视频编辑软件供应商,是目前面向C端客户商业化的公司。公司坚持在AIGC领域,细分领域从原来的图片转换到视频的编辑与生成。Runway可以支持用户进行图像处理、文本生成图像、更改视频风格、文生视频等多项服务。

商业化情况:

-

Runway的技术被广泛应用于电影、电视与广告等领域,奥斯卡获奖电影《瞬息全宇宙》背后的视觉效果团队使用了Runway的技术来帮助创建某些场景,比如用AI工具去除背景、放慢视频、制作无限延伸的图片等。

-

6月,Runway推出首批商业化的文本转视频的模型Gen-2,该模型能够根据文本和图像生成视频,目前可以免费体验。

-

Runway为用户提供免费试用额度(125点/约26个视频),在付费订阅方面,通过销售月度“点数”(credits)供用户使用Gen-1、Gen-2等产品及增值服务,分别有标准版($12/月-625点)和高级版($28/月-2250点)。

2.2.2 Pika1.0版本发布,电影级的视频特效

Pika1.0正式发布,能够生成和编辑3D动画、动漫、卡通和电影,输入几行文本或上传图像,就可以通过Al创建简短、高质量的视频。例如输入[elon muskina space suit,3d animation],一段马斯克邀游太空的视频便生成了,不仅如此,Pika1.0还有如下扩展功能:

-

不同风格视频转换:将现有视频转换为不同的风格,包括不同的角色和对象,同时保持视频的结构;

-

扩展视频的画布或宽高比:将视频从TikTok 9:16格式更改为宽屏16:9格式,AI模型将预测超出原始视频边界的内容;

-

使用AI编辑视频内容比如更换衣服、添加另一个角色、更改环境或添加道具;

-

使用AI扩展现有视频剪辑的长度。

2.2.2 Synthesia:海外领先的AI视频应用,已开启商业化

Synthesia是一个人工智能视频创作平台。该平台素材丰富,支持120多种语言,提供140+个AI化身;制作时间短,不需要视频剪辑技巧,可以在几分钟内创建带有AI化身和声音的视频。目前,Synthesia的服务的企业客户超过5万家,35%的财富100强企业是其忠实客户。Synthesia已自动生成了超过1200万个视频,用户增长率超过400%。

产品更新:更新速度快,更新内容丰富度高。Synthesia的产品更新速度较快,日常更新主要为丰富素材库。更新的内容包括改进、新功能发布、AI形象、STUDIO、API、提醒、声音、模板等方向,并将不同方向设置成标签,标注在每次产品更新之后,帮助快速检索相关更新情况。

商业模式:以订阅费和定制费用为主。Synthesia的产品分为个人版与企业版两个版本,个人版本收取固定订阅费用,价格为22.5美元/月,全年订阅享受25%折扣;企业版本根据座位数的不同费用不同。两种版本均可体验基础的视频制作功能,但在素材丰富度、特殊功能以及优先级上存在较大差距。

2.2.3 Lumen5:可将文本转化为视频,自动生成对应的场景和角色

Lumen5是一款视频创建软件,可以帮助营销人员、发布商和品牌创建视频内容,可以将博客文章(blogposts)转换为视频、头部说话内容(TalkingHeadVideo),超过一百万家公司使用Lumen5来讲述他们的故事。

商业模式:

-

分别有基础版、初学者版、专业版以及企业版,在不同的层次提供不同的级别的功能,用户也可以加入社群(community),免费使用部分功能;

-

能够提供1080p的视频分辨率、无水印的视频、500M的图像及视频库存,企业版能提供定制化的品牌模板和设计团队。

2.3 视频生成最新技术梳理

AI视频生成自进入到11月,可以说迎来了一个小爆发,各大巨头纷纷入局,真可谓是神仙打架!!那么,我们就来梳理下最新的前沿视频生成技术工作!

2.3.1 阿里Animate Anyone

只需一张人物照片,再配合骨骼动画引导,就能生成动画视频。

方法概述:

-

姿势序列最初使用 Pose Guider 进行编码,并与多帧噪声融合,然后由 Denoising UNet 进行视频生成的去噪过程。

-

Denoising UNet 的计算模块由 Spatial-Attention、Cross-Attention 和 Temporal-Attention 组成,如右侧虚线框所示。

-

首先,通过ReferenceNet提取详细特征并用于空间注意力;

-

其次,通过CLIP图像编码器提取语义特征进行交叉注意力,时间注意力在时间维度上运作;

-

最后,VAE解码器将结果解码为视频剪辑。

2.3.2 Meta发布Emu Video

一种基于扩散模型的文本到视频生成方法,可以分解步骤生成高质量的视频。

将生成过程分解为两个步骤:首先根据文本生成图像,然后在文本和生成的图像的条件下生成视频。

研究者确定了一些关键的设计决策,包括调整扩散的噪声计划和多阶段训练,这使我们能够直接生成高质量和高分辨率的视频,而不需要像之前的工作那样使用深层级的模型级联。

2.3.3 字节MagicAnimate

一种基于扩散的框架,旨在增强时间一致性、忠实地保留参考图像并提升动画保真度。为了实现这一目标,首先开发了一个视频扩散模型来编码时间信息。其次,为了在帧之间保持外观一致性,引入了一种新颖的外观编码器,以保留参考图像的复杂细节。借助这两项创新,进一步采用了一种简单的视频融合技术,以促进长视频动画的平滑过渡。

2.3.4 清华DemoFusion

本文旨在通过推动高分辨率生成的前沿,同时保持对广泛受众的可访问性,使高分辨率GenAI更加民主化。

DemoFusion技术亮点:

-

民主化高分辨率AI图像生成,完全开源;

-

在低分辨率图像上添加更多细节特征,可将SDXL生成的1024x1024分辨率图像,提升至4倍、16倍,甚至更高;

-

开箱即用:DemoFusion设计得既高效又易于使用,不需要大量的内存资源或复杂的调整过程。

2.3.5 李飞飞团队W.A.L.T

一种基于 Transformer 的方法,通过扩散模型生成逼真的视频。在图像和视频生成基准上性能表现SOTA!能够以每秒8帧的速度生成512×896分辨率的视频!!!

W.A.L.T技术要点:

-

李飞飞团队携手谷歌联袂推出视频生成模型W.A.L.T,可比肩Pika,且在图像和视频生成领域取得可媲美Gen-2的效果;

-

一种基于Transformer的方法,通过扩散建模实现照片逼真的视频生成技术,采用因果编码器,将图像和视频压缩到共享潜在空间,实现跨模态的联合训练和生成,为自然语言提示生成逼真且时间一致的视频。

-

为文本到视频生成任务训练了三个级联模型,包括基础潜在视频扩散模型和两个视频超分辨率扩散模型,以生成每秒8帧、分辨率为512 x 896的视频。

-

虽然生成模型领域在图像方面取得了巨大的进展,但在视频生成方面的进展相对滞后。而这一创新性的研究缩小了两者之间的差距。

2.3.6 StabilityAI发布Stable Video Diffusion

一种用于高分辨率、最先进的文本到视频和图像到视频生成的潜在视频扩散模型。

Stability AI这项研究进一步定义出训练视频LDM的三个阶段,分别是文本到图像的预训练、视频预训练,最后则是高品质视频的微调。

研究人员强调,经过良好整理的预训练数据集,对于产生高品质视频非常重要,甚至还提出一套包括标题制作和过滤策略的系统性整理流程。

2.3.7 腾讯AnimateZero

腾讯发布的视频生成模型,通过改进预训练的视频扩散模型(Video Diffusion Models),将视频生成当作一种零样本的图像动画问题,能够更精确地控制视频的外观和运动。

通过零样本修改,还能将T2V模型转换为I2V模型,使其成为零样本图像动画生成器。

在应用方面,AnimateZero展示了在多个T2I模型上生成的个性化视频,并介绍了通过文本控制动作、视频编辑、帧插值、循环视频生成和真实图像动画等多种应用场景。

AnimateZero能够更好地兼容现有的SD生态,并采用了社区SD模型进行演示。

2.3.8 阿里又一力作——DreaMoving

该论文介绍了一种基于扩散的可控视频生成框架,名为DreaMoving。

该框架能够根据给定的目标身份和姿势序列生成目标身份在任何地方移动或跳舞的高质量定制人类视频。

为实现这一目标,作者提出了一个用于运动控制的Video ControlNet和一个用于身份保持的Content Guider。该模型易于使用,并可适应大多数风格化扩散模型,以生成多样化的结果。

2.4 视频生成应用工具推荐

前面说了这么多,大家可能都想亲自上手体验下!猫先生推荐一些AI视频应用的工具,方便大家快速体验AIGC在视频生成领域的魅力!!!

视频作为最重要的传播媒介之一,在互联网上崭露头角,成为了一个强大的力量。与纯文本和静态图像相比,视频提供了大量的动态信息,为用户提供更全面和沉浸式的视觉体验。AI视频生成制作工具是一种利用AI算法从文本、图像、音频或其他模态数据自动生成视频的软件,可谓是提高效率,节省时间成本的利器。只需一句话,只要有创意,便可快速生成一段视频。

2.4.1 Runway

强大的AI视频制作工具,绿幕抠像、视频合成等!在Runway上,用户可以创建并发布预先训练好的机器学习模型,用于生成通真的图像或视预等用。用户还可以训练自己的模型,并直接从GitHub导入新的模型。在3月23日,Runway发布了Gen-2模型 ,允许用户从文本、图像和视频片段中生成视频内容。

体验地址:

https://app.runwayml.com/video-tools/teams/994722188/dashboard

2.4.2 Pika

近期热门的人工智能初创司Pika labs推出的AI视频生成和编辑工具,该工具可以将任何创意转化为视频,用户只需输入文字或图像,即可快速生成3D动画、动漫、卡通、电影等风格的视频。

Discord体验地址:https://discord.com/invite/pika

2.4.3 Gencraft

一个强大的人工智能艺术生成器,可以将文字转换为独特的图像和视频。只需输入文本提示,从其提供的不同风格中选择,便可以创建和生成视频、高分辨率图像,或共享你的创意设计。遗憾的是只免费开放了图片生成功能,视频生成需充值解锁!!

体验地址:https://gencraft.com/

2.4.4 腾讯智影

腾讯出品的一款云端智能视频创作工具,无需下载安装,只需通过PC浏览器访问,就可以进行在线视频剪辑和制作。集素材搜集、视频剪辑、后期包装、渲染导出和发布于一体,提供从端到端的一站式视频创作服务。腾讯智影不仅拥有常用的基础功能,如视频剪辑、转场、滤镜、字幕、音乐等,还有基于腾讯AI人工智能技术打造的智影数字人播报能力,以及联合更多腾讯AI能力推出的素材管理、AI文本配音、自动字幕识别、文章转视频、去水印、视频解说、横转竖等功能,帮助用户更好地进行视频化的表达。

体验地址:https://zenvideo.qq.com/

2.5.5 Pictory

一个基于人工智能的在线视频制作编辑器工具,可以帮助用户快速、简单、高效地制作各种类型的视频。基于强大的AI技术和丰富的素材库,无需下载任何软件或具备任何技术技能,就可以轻松创建专业品质的视频,并分享到各个社交媒体平台上。

体验地址:https://pictory.ai/

三、仍存在许多技术难点

生成式学习框架有有四个关键要素:高质量样本、样本多样和模式覆盖、低廉的计算成本和快速的计算能力。

遗憾的是,目前还没有一个模型能够充分满足这四个要素,AI生成技术,尤其视频生成技术仍存在着许多的技术难点,生成效果有待进一步提升。

-

缺小大规模、高质量的数据集

在文生图像应用中,收集高质量文本-图像对是较容易的,但是高质量的文本-视频对或图片-视频对却是稀缺的,许多数据库中的视频很少和文本强相关,并且许多只描述了场景而缺少时间信息。

-

高维度视频数据集建模的复杂性

视频生成不仅仅需要考虑空间信息,还需要考虑时间信息,高质量视频的生成需要更高强度的计算及复杂的推理能力。在考量视频质量时,视频长度、逼真度、连贯性目前还无法完全达到。

-

用户Prompt表达的不确定性文章来源:https://www.toymoban.com/news/detail-802370.html

用户在进行文字描述(prompt)时,通常有个性化的用语和表达方式,模型对于文字描述的理解(prompt)会较大的影响生成。文章来源地址https://www.toymoban.com/news/detail-802370.html

到了这里,关于AIGC内容分享(二十):「AI视频生成」技术核心基础知识和模型应用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!