1.4bit的量化版本最好不要在Windows系统中运行,大概原因报错原因是bitsandbytes不支持window,bitsandbytes-windows目前仅支持8bit量化。

2.

报错原因是机器没有足够的内存和显存,offload_folder设置一个文件夹来保存那些离线加载到硬盘的权重。

ag:需要再cli_demo.py的文件中增加

offload_folder="offload" model.float() 文章来源:https://www.toymoban.com/news/detail-802445.html

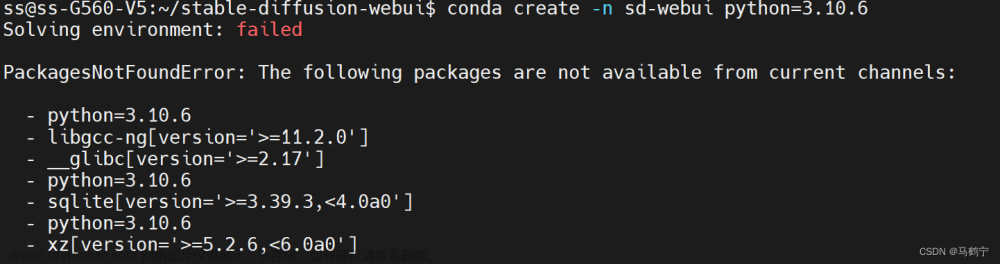

3.安装对应的cuda版本 Python版本 pytorch版本

读者有bug可以在评论区留言,我会尽可能回复解答文章来源地址https://www.toymoban.com/news/detail-802445.html

到了这里,关于Baichuan2百川模型部署的bug汇总的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!